Limites de taxa e cotas soam parecidos, então muitas pessoas os tratam como a mesma coisa. Um rate limit é a velocidade com que você pode chamar uma API (requisições por segundo ou por minuto). Uma quota é quanto você pode usar em um período mais longo (por dia, por mês ou por ciclo de cobrança). Ambos são normais, mas parecem aleatórios quando as regras não são visíveis.

A reclamação clássica é: “funcionou ontem”. O uso raramente é estável. Um pico curto pode empurrar alguém além do limite mesmo que o total diário pareça ok. Imagine um cliente que roda um relatório uma vez por dia, mas hoje o job retrya após um timeout e faz 10× mais chamadas em 2 minutos. A API bloqueia, e tudo o que ele vê é uma falha repentina.

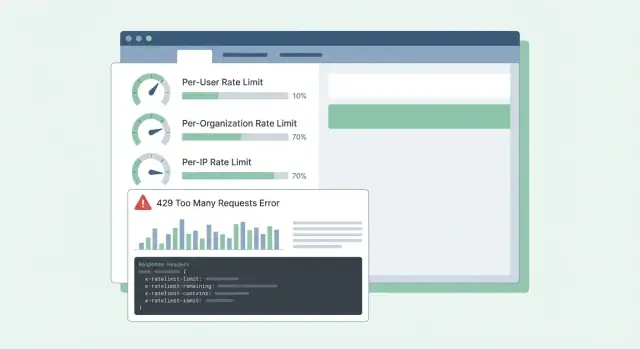

A confusão piora quando os erros são vagos. Se a API retorna 500 ou uma mensagem genérica, os clientes assumem que o serviço caiu, não que bateram em um limite. Eles abrem tickets urgentes, montam soluções alternativas ou trocam de provedor. Mesmo 429 Too Many Requests pode ser frustrante se não disser o que fazer a seguir.

A maioria das APIs SaaS limita tráfego por duas razões diferentes:

- Evitar abuso: proteger o sistema contra scraping, brute force ou scripts descontrolados.

- Modelar uso normal: manter desempenho estável para todos, especialmente em horários de pico.

Misturar esses objetivos leva a designs ruins. Controles de abuso costumam ser por IP ou por token e podem ser rígidos. Modelagem de uso normal geralmente é por usuário ou por organização e deve vir com orientação clara: qual limite foi atingido, quando resetará e como evitar bater nele novamente.

Quando os clientes conseguem prever limites, eles planejam. Quando não conseguem, todo pico parece uma API quebrada.

Decida o que você está protegendo

Limites de taxa não são só um acelerador. São um sistema de segurança. Antes de escolher números, seja claro sobre o que você está tentando proteger, porque cada objetivo leva a limites e expectativas diferentes.

Disponibilidade costuma ser prioridade. Se alguns clientes conseguem gerar picos e empurrar sua API a timeouts, todo mundo sofre. Limites aqui devem manter os servidores responsivos durante rajadas e falhar rápido em vez de deixar requisições se acumularem.

Custo é o motor silencioso por trás de muitas APIs. Algumas requisições são baratas, outras são caras (chamadas a LLMs, processamento de arquivos, gravações, buscas pagas de terceiros). Por exemplo, numa plataforma como a Koder.ai, um único usuário pode disparar muitas chamadas de modelo via geração de app por chat. Limites que acompanham ações caras evitam contas surpresa.

Abuso aparenta diferente de uso legítimo alto. Credential stuffing, guessing de tokens e scraping costumam aparecer como muitas requisições pequenas vindas de um conjunto restrito de IPs ou contas. Nesses casos você quer limites rígidos e bloqueio rápido.

Justiça importa em sistemas multi-tenant. Um cliente barulhento não deve degradar todo mundo. Na prática, isso costuma significar controles em camadas: um guard de burst para manter a API saudável minuto a minuto, um guard de custo para endpoints caros, um guard de abuso focado em auth e padrões suspeitos, e um guard de justiça para que uma org não ocupe todo o espaço.

Um teste simples ajuda: escolha um endpoint e pergunte, “Se esta requisição aumentar 10×, o que quebra primeiro?” A resposta indica qual objetivo de proteção priorizar e qual dimensão (usuário, org, IP) deve carregar o limite.

Escolha as dimensões de limitação certas

A maioria das equipes começa com um limite e depois descobre que ele prejudica as pessoas erradas. O objetivo é escolher dimensões que casem com o uso real: quem chama, quem paga e o que parece abuso.

Dimensões comuns em SaaS:

- Por usuário: impede que um usuário final pesado desacelere todo mundo na mesma conta.

- Por org/workspace: estabelece um teto claro no uso total de um tenant (muitas vezes o que os planos de cobrança vendem).

- Por IP: detecta bots, credential stuffing e clientes mal configurados que martelam de um endereço.

- Por API key/token: útil para parceiros e integrações onde “usuário” não faz sentido ou é compartilhado.

Limites por usuário tratam de justiça dentro de um tenant. Se uma pessoa roda uma exportação grande, ela deve sentir a desaceleração mais que o resto da equipe.

Limites por org tratam de orçamento e capacidade. Mesmo se dez usuários rodarem jobs ao mesmo tempo, a org não deve subir a um nível que quebre seu serviço ou suas suposições de preço.

Limites por IP devem ser uma rede de segurança, não uma ferramenta de cobrança. IPs podem ser compartilhados (NAT de escritório, operadoras móveis), então mantenha esses limites generosos e use-os principalmente para parar abuso óbvio.

Ao combinar dimensões, decida qual “vence” quando vários limites se aplicam. Uma regra prática: rejeite a requisição se qualquer limite relevante for excedido e retorne a razão mais acionável. Se um workspace excedeu a cota da org, não culpe o usuário ou o IP.

Exemplo: um workspace da Koder.ai num plano Pro pode permitir um fluxo estável de builds por org, enquanto também limita um único usuário de disparar centenas de requisições por minuto. Se uma integração de parceiro usa um token compartilhado, um limite por token pode impedir que ela afogue usuários interativos.

Algoritmos que funcionam em produção

A maioria dos problemas de rate limiting não é sobre matemática. É sobre escolher um comportamento que combine com como os clientes chamam sua API e mantê-lo previsível sob carga.

Token bucket é um padrão comum porque permite curtos bursts enquanto impõe uma média de longo prazo. Um usuário que atualiza um dashboard pode disparar 10 requisições rápidas. Token bucket permite isso se houver tokens acumulados, depois desacelera.

Leaky bucket é mais rígido. Ele suaviza o tráfego em um fluxo constante, o que ajuda quando seu backend não aguenta picos (por exemplo, geração de relatórios caros). A troca é que os clientes sentem o efeito mais cedo, porque rajadas viram enfileiramento ou rejeição.

Contadores por janela são simples, mas os detalhes importam. Janelas fixas criam bordas agudas (um usuário pode estourar em 12:00:59 e de novo em 12:01:00). Janelas deslizantes parecem mais justas e reduzem picos de borda, mas exigem mais estado ou estruturas de dados melhores.

Uma classe separada de limite é concorrência (requisições em voo). Isso protege contra conexões lentas de clientes e endpoints longos. Um cliente pode ficar dentro de 60 requisições/minuto mas ainda sobrecarregar você mantendo 200 requisições abertas ao mesmo tempo.

Em sistemas reais, equipes costumam combinar um pequeno conjunto de controles: um token bucket para taxa geral, um limite de concorrência para endpoints lentos/pesados e orçamentos separados por grupos de endpoint (reads baratos vs exports caros). Se você limita apenas por contagem de requisições, um endpoint caro pode ocupar tudo e fazer a API parecer quebrada aleatoriamente.

Monte um checklist de rollout

Crie um plano de implantação em etapas: report-only, aviso, aplicação e ajuste por nível.

Boas cotas parecem justas e previsíveis. Os clientes não devem descobrir as regras só depois de serem bloqueados.

Mantenha a separação clara:

- Limites de curto prazo (ex.: 10 requisições/segundo) protegem seu serviço de picos.

- Cotas de longo prazo (diárias/mensais) protegem custos e mantêm os níveis de preço comparáveis.

Muitas equipes usam ambos: um limite curto para parar bursts e uma cota mensal ligada ao preço.

Hard vs soft limits é principalmente uma escolha de suporte. Um hard limit bloqueia imediatamente. Um soft limit avisa primeiro e só bloqueia depois. Soft limits reduzem tickets irritados porque as pessoas têm chance de consertar um bug ou fazer upgrade antes da integração quebrar.

Quando alguém ultrapassa, o comportamento deve casar com o que você está protegendo. Bloquear funciona quando o uso excessivo pode prejudicar outros tenants ou explodir custos. Degradar (processamento mais lento ou prioridade menor) funciona quando você prefere manter as coisas andando. “Cobrar depois” pode funcionar quando o uso é previsível e já existe um fluxo de cobrança.

Limites por nível funcionam melhor quando cada nível tem uma “forma de uso esperada” clara. Um tier gratuito pode permitir cotas mensais pequenas e baixo burst, enquanto planos Business e Enterprise ganham cotas e limites de burst maiores para que jobs de background terminem rápido. Isso é semelhante a como os níveis Free, Pro, Business e Enterprise da Koder.ai definem expectativas diferentes.

Overrides customizados valem a pena desde cedo, especialmente para enterprise. Uma abordagem limpa é “padrões por plano, overrides por cliente”. Armazene um override definido pelo admin por org (e às vezes por endpoint) e garanta que sobreviva a mudanças de plano. Decida também quem pode pedir mudanças e quão rápido elas entram em vigor.

Exemplo: um cliente importa 50.000 registros no último dia do mês. Se a cota mensal estiver quase esgotada, um aviso soft em 80–90% dá tempo de pausar. Um limite por segundo curto impede que a importação inunde a API. Um override aprovado por org (temporário ou permanente) mantém o negócio andando.

Passo a passo: implementar limites em uma API SaaS

Comece escrevendo o que você vai contar e a quem pertence. A maioria das equipes termina com três identidades: o usuário autenticado, a org cliente (ou workspace) e o IP do cliente.

Um plano prático:

- Defina regras de identidade: user ID da autenticação, org ID do token ou API key, IP do primeiro hop de proxy confiável (seja explícito sobre qual header você confia).

- Agrupe endpoints por custo: reads, writes, exports pesados, fluxos de auth. Dê a cada grupo limites diferentes para que um endpoint caro não drene todo o orçamento.

- Escolha onde os contadores vivem: memória para uma instância única, Redis para limites compartilhados entre servidores, e banco de dados apenas para cotas lentas e de auditoria. Use TTLs que batam com a janela (ex.: 60 segundos para limites por minuto).

- Aplique consistentemente: faça bloqueio grosso na borda (gateway/CDN) para enchentes por IP, depois checagens mais finas por usuário/org no middleware da aplicação, onde você vê rota e tenant.

- Instrumente tudo: acompanhe taxa de bloqueios (429s), latência adicionada pelo limitador e as chaves mais bloqueadas. Alerta quando blocos sobem ou quando erros no Redis forçam “fail open/closed”.

Quando definir limites, pense em tiers e grupos de endpoint, não num único número global. Um erro comum é confiar em contadores em memória em múltiplos servidores. Contadores discordam e usuários veem 429s “aleatórios”. Um armazenamento compartilhado como Redis mantém limites estáveis entre instâncias, e TTLs mantêm o dado pequeno.

O rollout importa. Comece em modo “somente relatório” (log do que seria bloqueado), depois aplique a um grupo de endpoints e então expanda. Assim você evita acordar com uma enxurrada de tickets de suporte.

Torne os limites compreensíveis com respostas e cabeçalhos

Quando um cliente atinge um limite, o pior é a confusão: “Sua API caiu ou eu errei algo?” Respostas claras e consistentes reduzem tickets e ajudam as pessoas a corrigir o comportamento do cliente.

Use HTTP 429 Too Many Requests quando estiver bloqueando ativamente. Mantenha o corpo da resposta previsível para que SDKs e dashboards possam lê-lo.

Aqui vai um formato JSON simples que funciona bem para escopos por usuário, org e IP:

{

"error": {

"code": "rate_limit_exceeded",

"message": "Rate limit exceeded for org. Try again later.",

"limit_scope": "org",

"reset_at": "2026-01-17T12:34:56Z",

"request_id": "req_01H..."

}

}

Os cabeçalhos devem explicar a janela atual e o que o cliente pode fazer a seguir. Se adicionar apenas alguns, comece por: RateLimit-Limit, RateLimit-Remaining, RateLimit-Reset, Retry-After e X-Request-Id.

Exemplo: o cron de um cliente roda todo minuto e de repente começa a falhar. Com 429 mais RateLimit-Remaining: 0 e Retry-After: 20, ele sabe imediatamente que é um limite, não uma queda, e pode atrasar retries por 20 segundos. Se compartilhar X-Request-Id com o suporte, você encontra o evento rápido.

Mais um detalhe: retorne os mesmos cabeçalhos em respostas bem-sucedidas também. Os clientes podem ver que estão próximos do limite antes de acertarem nele.

Comportamento do cliente: retries, backoff e writes seguros

Planeje limites por custo de endpoint

Use o Modo de Planejamento para mapear limites de burst, cotas e endpoints caros antes de aplicar nada.

Bons clientes fazem os limites parecerem justos. Clientes ruins transformam um limite temporário em um outage ao martelar com mais requisições.

Ao receber 429, trate como um sinal para desacelerar. Se a resposta informa quando tentar de novo (por exemplo, via Retry-After), espere ao menos esse tempo. Se não informar, use backoff exponencial e adicione jitter (aleatoriedade) para que mil clientes não tentem todos ao mesmo tempo.

Mantenha retries limitados: limite o delay entre tentativas (por exemplo, 30–60 segundos) e o tempo total de retry (por exemplo, pare depois de 2 minutos e mostre um erro). Também faça logging com detalhes do limite para que devs possam ajustar depois.

Não reenvie tudo. Muitos erros não vão se resolver sem mudança ou ação do usuário: 400 validação, 401/403 auth, 404 not found e 409 conflitos que refletem regra de negócio.

Retries são arriscados em endpoints de escrita (create, charge, send email). Se um timeout ocorrer e o cliente tentar de novo, você pode criar duplicatas. Use chaves de idempotência: o cliente envia uma chave única por ação lógica, e o servidor retorna o mesmo resultado para repetições com a mesma chave.

SDKs bem feitos podem facilitar isso expondo o que os desenvolvedores realmente precisam: status (429), quanto esperar, se a requisição é segura para retry e uma mensagem como “Rate limit exceeded for org. Retry after 8s or reduce concurrency.”

Erros comuns que geram tickets irritados

A maior parte dos tickets sobre limites não é sobre o limite em si. É sobre surpresas. Se os usuários não conseguem prever o que acontecerá a seguir, eles assumem que a API está quebrada ou é injusta.

Usar apenas limites baseados em IP é erro frequente. Muitas equipes ficam atrás de um IP público (Wi‑Fi do escritório, operadoras, NAT de nuvem). Se você limitar por IP, um cliente ocupado pode bloquear todo mundo na mesma rede. Prefira limites por usuário e por org, e use o IP apenas como rede de segurança.

Outro problema é tratar todos os endpoints como iguais. Um GET barato e um job de exportação pesado não devem compartilhar o mesmo orçamento. Caso contrário, clientes gastam sua cota navegando normalmente e depois são bloqueados ao tentar uma tarefa real. Separe buckets por grupo de endpoint ou pese requisições pelo custo.

O timing de reset também precisa ser explícito. “Reset diário” não basta. Qual fuso horário? Janela rolante ou reset à meia-noite? Se fizer resets por calendário, diga o fuso horário. Se fizer janelas rolantes, diga o comprimento da janela.

Por fim, erros vagos criam caos. Retornar 500 ou JSON genérico faz as pessoas retryar mais. Use 429 e inclua cabeçalhos RateLimit para que clientes desacelarem inteligentemente.

Exemplo: se uma equipe monta uma integração Koder.ai a partir de uma rede corporativa compartilhada, um limite só por IP pode bloquear toda a org e parecer falhas aleatórias. Dimensões claras e respostas 429 claras evitam isso.

Checklist rápido antes de liberar

Elabore sua especificação de limites

Descreva sua API e seus planos, e a Koder.ai ajuda a definir limites, cabeçalhos e regras de reset.

Antes de ativar limites para todos, faça uma passada final focada em previsibilidade:

- Defina limites por nível de preço e por grupo de endpoint (auth, reads, writes, exports). Mantenha uma pequena margem para essenciais como login e refresh de token.

- Faça regras de identidade determinísticas e documentadas. Decida exatamente como você conta (usuário, org, API key, IP) e o que tem precedência.

- Faça respostas 429 autoexplicativas. Inclua Retry-After mais cabeçalhos RateLimit (Limit, Remaining, Reset). No corpo JSON, inclua uma mensagem curta, qual limite foi atingido e quando tentar de novo.

- Monitore picos e falsos positivos. Acompanhe taxa de 429 por grupo de endpoint, maiores callers e quedas súbitas em requisições bem-sucedidas. Alerta quando blocos aumentarem.

- Tenha um plano de exceções: whitelists, aumentos temporários, overrides de emergência e quem pode aprová-los.

Um teste rápido: se seu produto tem níveis Free, Pro, Business e Enterprise (como Koder.ai), você deve ser capaz de explicar em linguagem simples o que um cliente normal pode fazer por minuto e por dia, e quais endpoints são tratados de forma diferente.

Se você não consegue explicar claramente um 429, os clientes vão assumir que a API está quebrada, não protegendo o serviço.

Plano de rollout exemplo e próximos passos

Imagine um SaaS B2B onde as pessoas trabalham dentro de um workspace (org). Alguns power users rodam exports pesados, e muitos funcionários ficam atrás de um IP de escritório compartilhado. Se você limitar só por IP, bloqueia empresas inteiras. Se limitar só por usuário, um script ainda pode prejudicar todo o workspace.

Uma mistura prática é:

- Limite de burst por usuário para rajadas curtas.

- Limite sustentado por org para manter o workspace justo ao longo do tempo.

- Guard de abuso por IP para pegar tokens vazados, bots e redes barulhentas.

Quando alguém bate em um limite, sua mensagem deve dizer o que aconteceu, o que fazer a seguir e quando tentar de novo. O suporte deve poder respaldar um texto como:

“Request rate exceeded for workspace ACME. You can retry after 23 seconds. If you are running an export, reduce concurrency to 2 or schedule it off-peak. If this blocks normal use, reply with your workspace ID and timestamp and we can review your quota.”

Combine essa mensagem com Retry-After e cabeçalhos RateLimit consistentes para que os clientes não precisem adivinhar.

Um rollout que evita surpresas: observe primeiro (report-only), depois avise (cabeçalhos e avisos soft), depois aplique (429s com tempo claro de retry), então ajuste thresholds por nível e revise após grandes lançamentos e onboardings de clientes.

Se você quer uma forma rápida de transformar essas ideias em código funcionando, uma plataforma de vibe-coding como a Koder.ai (koder.ai) pode ajudar a rascunhar uma spec de rate limit e gerar middleware Go que a aplique consistentemente entre serviços.