17 de ago. de 2025·8 min

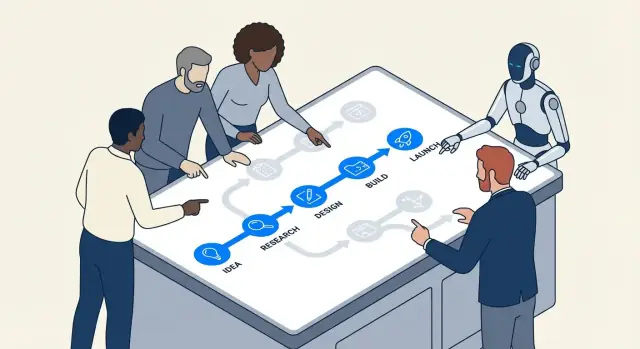

Por que fluxos de trabalho com IA reduzem a abstração prematura

Fluxos de trabalho com IA incentivam passos concretos, feedback rápido e resultados mensuráveis — reduzindo a tentação de super-abstrair e sobreengenhar cedo demais.

O que queremos dizer com abstração prematura e sobreengenharia

Abstração prematura é quando você constrói uma “solução geral” antes de ter visto casos reais suficientes para saber o que deve ser generalizado.

Em vez de escrever o código mais simples que resolve o problema de hoje, você inventa um framework: interfaces extras, sistemas de configuração, pontos de plug-in ou módulos reutilizáveis — porque presume que vai precisar deles depois.

Sobreengenharia é o hábito mais amplo por trás disso. É adicionar complexidade que, no momento, não compensa: camadas extras, padrões, serviços ou opções que não reduzem claramente custo ou risco agora.

Exemplos em termos simples

Se seu produto tem um plano de cobrança e você constrói um mecanismo de precificação multitenant “só por precaução”, isso é abstração prematura.

Se uma funcionalidade poderia ser uma única função direta, mas você a divide em seis classes com fábricas e registries para torná-la “extensível”, isso é sobreengenharia.

Por que isso aparece no começo dos projetos

Esses hábitos são comuns no início porque projetos iniciais estão cheios de incerteza:

- Medo de retrabalho: Times se preocupam que, se construírem algo simples, terão que reescrevê-lo depois.

- Requisitos incertos: Quando ninguém tem certeza do que o produto vai se tornar, é tentador construir um esqueleto flexível que possa “lidar com qualquer coisa”.

- Pressão social: Engenheiros frequentemente querem antecipar e “fazer certo”, mesmo quando o que é “certo” ainda não é conhecível.

O problema é que “flexível” muitas vezes significa “mais difícil de mudar”. Camadas extras podem tornar edições diárias mais lentas, depuração mais difícil e onboarding mais doloroso. Você paga o custo da complexidade imediatamente, enquanto os benefícios podem nunca chegar.

Onde a IA se encaixa (e onde não se encaixa)

Fluxos de trabalho orientados por IA podem incentivar times a manter o trabalho concreto — acelerando a prototipagem, produzindo exemplos rapidamente e facilitando testar suposições. Isso pode reduzir a ansiedade que alimenta designs especulativos.

Mas a IA não substitui o julgamento de engenharia. Ela pode gerar arquiteturas e abstrações inteligentes sob demanda. Seu trabalho continua sendo perguntar: Qual é a coisa mais simples que funciona hoje, e que evidência justificaria adicionar estrutura amanhã?

Ferramentas como a Koder.ai são especialmente eficazes aqui porque facilitam ir de um prompt de chat para uma fatia executável de um app real (web, backend ou mobile) rapidamente — assim, times podem validar o que é necessário antes de “preparar para o futuro” qualquer coisa.

Como fluxos de trabalho com IA empurram times para trabalho concreto

O desenvolvimento assistido por IA tende a começar com algo tangível: um bug específico, uma pequena funcionalidade, uma transformação de dados, uma tela de UI. Esse enquadramento importa. Quando o fluxo começa com “aqui está a coisa exata que precisamos”, times têm menos probabilidade de inventar uma arquitetura generalizada antes de aprenderem qual é realmente o problema.

Prompts concretos criam código concreto

A maioria das ferramentas de IA responde melhor quando você fornece especificidades: entradas, saídas, restrições e um exemplo. Um prompt como “desenhe um sistema de notificações flexível” é vago, então o modelo frequentemente “preenche as lacunas” com camadas extras — interfaces, fábricas, configuração — porque não consegue ver os limites reais.

Mas quando o prompt é fundamentado, a saída também é:

- Entrada: “Dado estes status de pedido…”

- Saída: “Retorne a mensagem para o usuário e o CTA…”

- Restrições: “Deve ser rápido; sem chamada ao banco; precisa de i18n…”

- Exemplos: “Para

PENDING_PAYMENTmostrar …”

Isso naturalmente empurra times a implementar uma fatia estreita que funciona de ponta a ponta. Uma vez que você pode executá-la, revisar e demonstrar, você está operando na realidade em vez da especulação.

“Faça funcionar primeiro” vira o padrão

Pair-programming com IA torna a iteração barata. Se uma primeira versão está um pouco bagunçada, mas correta, o próximo passo geralmente é “refatore isso” em vez de “desenhe um sistema para todos os casos futuros”. Essa sequência — código funcionando primeiro, refinamento depois — reduz o ímpeto de construir abstrações que não ganharam sua complexidade.

Na prática, times acabam com um ritmo:

- Peça uma implementação mínima.

- Teste com exemplos reais.

- Ajuste com base no que quebra ou causa estranhamento.

- Só então extraia um helper, módulo ou padrão.

Especificidade expõe requisitos ausentes cedo

Prompts forçam você a declarar o que realmente quer. Se você não consegue definir entradas/saídas claramente, isso é um sinal de que ainda não está pronto para abstrair — você ainda está descobrindo requisitos. Ferramentas de IA recompensam clareza, então elas treinam times, de modo sutil, a clarificar primeiro e generalizar depois.

Curto ciclo de feedback reduz design especulativo

Feedback rápido muda o que “boa engenharia” significa. Quando você pode testar uma ideia em minutos, arquitetura especulativa deixa de ser um cobertor de segurança e passa a ser um custo que você pode evitar.

O ciclo: rascunho → executar → inspecionar → ajustar

Fluxos de trabalho orientados por IA comprimem o ciclo:

- Rascunho: peça ao assistente uma pequena fatia funcional (um script, um handler, uma query)

- Executar: rode imediatamente contra entradas reais

- Inspecionar: veja saídas, logs, casos de borda e como falha

- Ajustar: refine o código e o requisito ao mesmo tempo

Esse loop recompensa progresso concreto. Em vez de debater “precisaremos de um sistema de plug-in” ou “isso deve suportar 12 fontes de dados”, o time vê o que o problema atual realmente exige.

Por que velocidade reduz arquitetura especulativa

Abstração prematura frequentemente acontece quando times temem mudança: se mudanças forem caras, você tenta prever o futuro e desenhar para ele. Com loops curtos, mudar é barato. Isso inverte o incentivo:

- Você pode adiar a generalização até que trabalho repetido prove que ela é necessária.

- Você descobre restrições reais (performance, formato de dados, comportamento do usuário) cedo.

- Você para de construir “só por precaução” porque pode iterar “na hora certa”.

Exemplo simples: endpoint antes do framework

Suponha que você está adicionando uma funcionalidade interna de “exportar para CSV”. O caminho sobreengenhado começa com o desenho de um framework genérico de exportação, múltiplos formatos, filas de jobs e camadas de configuração.

Um caminho de loop rápido é menor: gere um único endpoint /exports/orders.csv (ou um script pontual), rode-o em dados de staging e inspecione o tamanho do arquivo, tempo de execução e campos faltantes. Se, depois de duas ou três exportações, você observar padrões repetidos — mesma lógica de paginação, filtros compartilhados, cabeçalhos comuns — então uma abstração ganha seu valor porque está ancorada em evidência, não em suposições.

Mudanças incrementais fazem as abstrações merecerem seu lugar

Entrega incremental muda a economia do design. Quando você entrega em fatias pequenas, toda camada “agradável de ter” tem que provar que ajuda agora — não em um futuro imaginado. É aí que fluxos de trabalho com IA reduzem silenciosamente a abstração prematura: a IA é ótima em propor estruturas, mas essas estruturas são mais fáceis de validar quando o escopo é pequeno.

Escopo pequeno torna sugestões de IA testáveis

Se você pede a um assistente para refatorar um único módulo ou adicionar um endpoint novo, você pode checar rapidamente se a abstração realmente melhora clareza, reduz duplicação ou facilita a próxima mudança. Com um diff pequeno, o feedback é imediato: testes passam ou falham, o código fica mais legível ou não, e a feature se comporta corretamente ou não.

Quando o escopo é grande, sugestões de IA podem soar plausíveis sem serem provadamente úteis. Você pode aceitar um framework generalizado simplesmente porque “parece limpo”, só para descobrir depois que complica casos reais de borda.

Componentes pequenos mostram o que manter (e o que deletar)

Trabalhar incrementalmente incentiva construir componentes pequenos e descartáveis primeiro — helpers, adapters, shapes de dados simples. Ao longo de algumas iterações, fica óbvio quais peças são reaproveitadas por múltiplas features (valem a pena manter) e quais foram só para um experimento pontual (seguras para apagar).

As abstrações viram então um registro de reutilização real, não de reutilização prevista.

Entrega incremental reduz risco de refatoração

Quando mudanças são entregues continuamente, refatorar assusta menos. Você não precisa “acertar tudo” desde o início porque pode evoluir o design conforme a evidência se acumula. Se um padrão realmente vale a pena — reduzindo trabalho repetido através de vários incrementos — promovê-lo a uma abstração é um movimento de baixo risco e alta confiança.

Essa mentalidade inverte o padrão: construa a versão mais simples primeiro, depois abstraia apenas quando o próximo passo incremental se beneficiar claramente disso.

Experimentação fácil favorece simplicidade sobre “grande projeto”

Projete para o próximo passo

Crie uma tela React para o caminho feliz e só amplie quando a realidade exigir.

Fluxos de trabalho com IA tornam a experimentação tão barata que “construir um grande sistema” deixa de ser o padrão. Quando um time pode gerar, ajustar e rodar múltiplas abordagens em uma tarde, fica mais fácil aprender o que realmente funciona do que prever o que poderia funcionar.

IA torna variantes pequenas quase gratuitas

Em vez de investir dias desenhando uma arquitetura generalizada, times podem pedir à IA para criar algumas implementações estreitas e concretas:

- uma versão direta que trate bem o happy path

- uma versão otimizada para legibilidade e manutenção

- uma versão que adicione só uma capacidade extra (por exemplo, um segundo formato de entrada)

Como criar essas variantes é rápido, o time pode explorar trade-offs sem se comprometer com um “grande design” desde o início. O objetivo não é entregar todas as variantes — é obter evidência.

Comparar variantes naturalmente recompensa soluções mais simples

Quando você consegue colocar duas ou três opções funcionando lado a lado, a complexidade fica visível. A variante mais simples frequentemente:

- atende aos mesmos requisitos reais

- tem menos partes móveis para depurar

- facilita mudanças futuras porque há menos acoplamento oculto

Enquanto isso, opções sobreengenhadas tendem a se justificar com necessidades hipotéticas. Comparar variantes é um antídoto para isso: se a abstração extra não produzir benefícios claros e de curto prazo, ela parece apenas um custo.

Checklist: o que medir ao comparar opções

Quando você faz experimentos leves, combine um entendimento do que é “melhor”. Um checklist prático:

- Tempo até o primeiro resultado funcional: Quanto tempo até passar cenários básicos?

- Complexidade da implementação: Arquivos/módulos alterados, número de conceitos introduzidos e quantas “regras” um colega precisa lembrar.

- Custo de mudança: Quão difícil é adicionar um novo requisito (o próximo provável, não uma fantasia de longo prazo)?

- Modos de falha: O que quebra, quanto e quão fácil é detectar (erros claros vs saída silenciosamente errada).

- Risco operacional: Novas dependências, superfície de configuração e pontos onde o comportamento em produção pode divergir.

- Testabilidade: Quão fácil é escrever um pequeno conjunto de testes que expliquem o comportamento.

Se uma variante mais abstrata não vence em pelo menos uma ou duas dessas medidas, a abordagem mais simples que funciona normalmente é a aposta certa — por enquanto.

IA ajuda a clarificar requisitos antes de abstrair

Abstração prematura frequentemente começa com uma frase como: “Podemos precisar disso depois.” Isso é diferente de: “Precisamos disso agora.” A primeira é um palpite sobre variabilidade futura; a segunda é uma restrição que você pode verificar hoje.

Fluxos de trabalho orientados por IA tornam essa diferença mais difícil de ignorar porque são ótimos em transformar conversas vagas em afirmações explícitas que você pode inspecionar.

Transforme ambiguidade em um contrato escrito (sem overcommit)

Quando um pedido de feature é vago, times tendem a “preparar para o futuro” construindo um framework geral. Em vez disso, use a IA para produzir rapidamente um resumo de requisitos de uma página que separe o que é real do que é imaginado:

- O que sabemos (restrições atuais): usuários-alvo, plataformas suportadas, expectativas de performance, integrações necessárias.

- O que assumimos: “Usuários terão várias contas”, “vamos suportar 10 locales”, “existirão camadas de preço”.

- O que não sabemos ainda: casos de borda, restrições legais, escala, necessidades de migração.

Essa divisão simples muda a conversa de engenharia. Você para de desenhar para um futuro desconhecido e começa a construir para o presente conhecido — mantendo uma lista visível de incertezas para revisitar.

O Planning Mode da Koder.ai se encaixa bem aqui: você pode transformar um pedido vago em um plano concreto (passos, modelo de dados, endpoints, estados de UI) antes de gerar a implementação — sem se comprometer com uma arquitetura extensa.

Uma abordagem leve “pró-futuro”

Você ainda pode deixar espaço para evoluir sem construir uma camada profunda de abstração. Prefira mecanismos que sejam fáceis de mudar ou remover:

- Feature flags para entregar uma versão estreita e aprender com uso real.

- Configuração para valores que variam (timeouts, thresholds, textos) em vez de sistemas polimórficos.

- Pequenos pontos de extensão (uma interface, um hook, um evento) somente onde a variação já é provável.

Uma boa regra: se você não consegue nomear as próximas duas variações concretas, não construa o framework. Escreva as variações suspeitas como “incertas”, entregue o caminho mais simples funcionando e deixe o feedback real justificar a abstração depois.

Se quiser formalizar esse hábito, registre essas notas no template de PR ou em um documento interno de “assunções” linkado do ticket (por exemplo, /blog/engineering-assumptions-checklist).

Testes e exemplos expõem generalizações desnecessárias

Uma razão comum para sobreengenharia é projetar para cenários imaginados. Testes e exemplos concretos invertem isso: forçam você a descrever entradas reais, saídas reais e modos de falha reais. Quando isso está escrito, abstrações “genéricas” muitas vezes parecem menos úteis — e mais caras — do que uma implementação pequena e clara.

Como a IA evidencia casos de borda (sem inventar arquitetura)

Quando você pede a um assistente de IA para ajudar a escrever testes, ele naturalmente empurra você para a especificidade. Em vez de “torne flexível”, você recebe perguntas como: O que essa função retorna quando a lista está vazia? Qual é o valor máximo permitido? Como representamos um estado inválido?

Esse questionamento é valioso porque encontra casos de borda cedo, enquanto você ainda decide o que a feature realmente precisa. Se esses casos de borda forem raros ou fora do escopo, você pode documentá-los e seguir adiante — sem construir uma abstração “só por precaução”.

Escrever testes primeiro revela se uma abstração é necessária

Abstrações merecem seu lugar quando múltiplos testes compartilham a mesma configuração ou padrões de comportamento. Se sua suíte de testes tem apenas um ou dois cenários concretos, criar um framework ou sistema de plugins é geralmente sinal de otimização para trabalho futuro hipotético.

Uma regra simples: se você não consegue expressar pelo menos três comportamentos distintos que precisem da mesma interface generalizada, sua abstração provavelmente é prematura.

Um mini-template para casos de teste práticos

Use essa estrutura leve antes de recorrer a um design “generalizado”:

- Happy path: entrada típica → saída esperada.

- Boundary: valores mínimos/máximos, coleções vazias, limites (por exemplo, 0, 1, 1000).

- Falha: entrada inválida, dependências ausentes, timeouts, erros de permissão → erro esperado ou comportamento de fallback.

Depois que esses testes estão escritos, o código frequentemente pede para ser direto. Se repetição aparecer em vários testes, esse é o sinal para refatorar — não o ponto de partida.

Custos de manutenção visíveis desencorajam sobreengenharia

Reduza custos enquanto aprende

Compartilhe o que você constrói com o Koder.ai e ganhe créditos por conteúdo ou indicações.

Sobreengenharia muitas vezes se esconde atrás de boas intenções: “Vamos precisar disso depois.” O problema é que abstrações geram custos contínuos que não aparecem no ticket inicial de implementação.

A conta real de uma abstração

Toda nova camada que você introduz geralmente cria trabalho recorrente:

- Superfície de API: mais métodos, parâmetros e casos de borda para suportar (e manter compatibilidade).

- Documentação e exemplos: onboardar outros significa explicar a abstração, não apenas a feature.

- Migrações: quando outro código depende de uma interface generalizada, mudá-la exige adaptadores, deprecações e notas de release.

- Matriz de testes: código “genérico” expande cenários — múltiplas implementações, mais mocks, mais pontos de integração.

Fluxos de trabalho com IA tornam esses custos mais difíceis de ignorar porque podem enumerar rapidamente pelo que você está se comprometendo.

Usando IA para estimar complexidade: conte as partes móveis

Um prompt prático é: “Liste as partes móveis e dependências introduzidas por este design.” Um assistente de IA competente pode decompor o plano em itens concretos, tais como:

- novos módulos/pacotes

- interfaces públicas e expectativas de versionamento

- mudanças no esquema do banco e passos de migração

- chamadas cross-service e modos de falha

- novas flags de configuração, permissões ou filas

Ver essa lista ao lado de uma implementação mais simples transforma argumentos de “arquitetura limpa” em um trade-off mais claro: você quer manter oito novos conceitos para evitar uma duplicação que talvez nunca exista?

Um “orçamento de complexidade” para manter o trabalho honesto

Uma política leve: limite o número de novos conceitos por feature. Por exemplo, permita no máximo:

- 1 nova API pública

- 1 nova abstração compartilhada (interface/classe base)

- 1 novo modelo de dados/tabela

Se a feature exceder o orçamento, exija uma justificativa: qual mudança futura isto está habilitando, e que evidência você tem de que é iminente? Times que usam IA para redigir essa justificativa (e para prever tarefas de manutenção) tendem a escolher passos menores e reversíveis — porque os custos recorrentes ficam visíveis antes do deploy.

Quando a IA pode empurrar você na direção errada (e como evitar)

Fluxos de trabalho orientados por IA frequentemente direcionam times para passos pequenos e testáveis — mas também podem fazer o oposto. Como a IA é ótima em produzir soluções “completas” rapidamente, ela pode tender a padrões familiares, adicionar estrutura extra ou gerar scaffolding que você não pediu. O resultado pode ser mais código do que você precisa, mais cedo do que precisa.

Como a IA acidentalmente encoraja sobreengenharia

Um modelo tende a ser recompensado (pela percepção humana) por soar exaustivo. Isso pode se traduzir em camadas adicionais, mais arquivos e designs generalizados que parecem profissionais mas não resolvem um problema real e atual.

Sinais de alerta comuns incluem:

- Novas abstrações sem caso de uso concreto (por exemplo, “para flexibilidade futura”)

- Camadas extras: service → manager → adapter → factory, quando uma função bastaria

- Interfaces genéricas com apenas uma implementação

- Sistemas de plugin, barramentos de eventos ou setups de dependency-injection introduzidos cedo

- Um “framework dentro do framework” criado para padronizar algo que você ainda não repetiu

Mitigações que mantêm a saída da IA ancorada

Trate a IA como mãos rápidas e eficientes, não como um comitê de arquitetura. Algumas restrições ajudam bastante:

- Constrinja prompts ao presente. Peça a menor mudança que satisfaça a necessidade de hoje, e proíba explicitamente novos padrões a menos que sejam necessários.

- Exija exemplos reais. Antes de aceitar uma abstração, peça 2–3 call sites concretos (ou fluxos de usuário) e verifique se a abstração os simplifica.

- Limite mudanças arquiteturais por iteração. Permita apenas uma mudança estrutural por vez (por exemplo, “introduzir um novo módulo” ou “nenhuma nova camada neste PR”).

- Revise pensando em deletabilidade. Se remover a nova camada mal afetaria o comportamento, provavelmente ela não foi merecida.

Uma regra simples: não deixe a IA generalizar até que a base de código tenha dor repetida.

Um framework prático de decisão: construa primeiro, abstria depois

Obtenha ciclos de feedback rápidos

Faça deploy cedo para que o uso real, não suposições, decida o que merece abstração.

A IA torna barato gerar código, refatorar e tentar alternativas. Isso é um presente — se você o usar para adiar abstração até que ela tenha merecimento.

Passo 1: comece concreto (otimize para aprendizado)

Comece com a versão mais simples que resolve o problema de hoje para um “happy path”. Nomeie as coisas diretamente pelo que fazem (não pelo que podem fazer depois) e mantenha APIs estreitas. Se você está em dúvida sobre um parâmetro, interface ou sistema de plugins, entregue sem ele.

Uma regra útil: prefira duplicação em vez de especulação. Código duplicado é visível e fácil de apagar; generalidade especulativa esconde complexidade em indirection.

Passo 2: extraia depois (otimize para estabilidade)

Uma vez que a feature é usada e muda, refatore com evidência. Com assistência de IA, você pode ser rápido aqui: peça para ela propor uma extração, mas insista em um diff mínimo e nomes legíveis.

Se suas ferramentas suportarem, use redes de segurança que tornem refactors de baixo risco. Por exemplo, snapshots e rollback da Koder.ai tornam mais fácil experimentar refactors com confiança, porque você pode reverter rapidamente se o design “mais limpo” piorar a prática.

Quando a abstração é justificada (checklist rápido)

Uma abstração merece existir quando a maioria destes for verdadeira:

- Lógica repetida: o mesmo comportamento aparece em 2–3 lugares e atualizações já exigiram múltiplas edições.

- Variabilidade comprovada: você viu variações reais em produção ou protótipos validados (não “talvez precisaremos X algum dia”).

- Propriedade clara: uma pessoa/time possui a abstração, sua documentação e mudanças futuras.

- Fronteira estável: a forma de entrada/saída se manteve consistente por algumas iterações.

- Simplificação líquida: a extração reduz o total de código e carga cognitiva, não apenas reorganiza.

Um ritual simples: revisão “uma semana depois”

Adicione um lembrete no calendário uma semana após o deploy de uma feature:

- Reabra o diff e liste o que mudou desde o release.

- Identifique quaisquer edições por copy-paste ou bugs recorrentes.

- Decida entre três resultados: manter concreto, extrair um helper pequeno ou introduzir um módulo compartilhado.

Isso mantém a postura padrão: construa primeiro, generalize só quando a realidade obrigar.

O que medir para manter engenharia enxuta

Engenharia enxuta não é um sentimento — é algo que você pode observar. Fluxos de trabalho com IA facilitam entregar pequenas mudanças rapidamente, mas você ainda precisa de alguns sinais para notar quando o time está voltando à arquitetura especulativa.

Um pequeno conjunto de métricas que detecta sobreengenharia cedo

Monitore alguns indicadores que se correlacionam com abstração desnecessária:

- Tempo de ciclo: tempo desde “início do trabalho” até “merged e deployado”. Quando o tempo de ciclo cresce sem aumento claro de escopo, frequentemente há muita indireção ou preparação para o futuro.

- Tamanho do diff: média de linhas alteradas (ou arquivos tocados) por mudança. Diffs grandes são mais difíceis de revisar e incentivam soluções generalizadas.

- Número de conceitos introduzidos: conte novos módulos/serviços/pacotes, novas interfaces, novos knobs de configuração, novos primitivos tipo “framework”. Conceitos são um imposto que você paga para sempre.

- Taxa de defeitos: bugs em produção ou tickets de suporte por release. Abstrações podem esconder casos de borda; defeitos crescentes após “limpeza” são um sinal.

- Tempo de onboarding: quanto leva para um novo engenheiro entregar sua primeira mudança pequena. Se o onboarding desacelera, o sistema pode estar otimizando elegância em vez de clareza.

Você não precisa de perfeição — linhas de tendência bastam. Revise semanalmente ou por iteração e pergunte: “Adicionamos mais conceitos do que o produto exigia?”

Documentação leve que evita abstrações misteriosas

Exija uma anotação curta de “por que isso existe” sempre que alguém introduzir uma nova abstração (nova interface, camada helper, biblioteca interna etc.). Mantenha em poucas linhas no README ou como comentário próximo ao ponto de entrada:

- Qual problema concreto isso resolveu hoje?

- Quais alternativas foram tentadas?

- O que justificaria deletá-lo?

Plano de ação para começar

Pilote um fluxo de trabalho assistido por IA em um time por 2–4 semanas: decomposição de tickets com IA, checklists de revisão de código assistidos por IA e casos de teste gerados pela IA.

Ao final, compare as métricas acima e faça um retro curto: mantenha o que reduziu tempo de ciclo e fricção de onboarding; reverta o que aumentou “conceitos introduzidos” sem benefício de produto mensurável.

Se você busca um ambiente prático para executar esse experimento de ponta a ponta, uma plataforma vibe-coding como a Koder.ai pode ajudar a transformar fatias concretas em apps deployáveis rapidamente (com exportação de código quando necessário), reforçando o hábito que este artigo defende: entregue algo real, aprenda e só então abstraia.