Por que o C ainda importa

C é uma daquelas tecnologias que a maioria das pessoas nunca toca diretamente, mas de que quase todos dependem. Se usa um telemóvel, um portátil, um router, um carro, um smartwatch ou mesmo uma máquina de café com ecrã, há uma boa hipótese de que C esteja envolvido em algum ponto da pilha — fazendo o dispositivo arrancar, comunicar com hardware ou correr rápido o suficiente para parecer “instantâneo”.

Para quem constrói coisas, C continua a ser uma ferramenta prática porque oferece uma combinação rara de controlo e portabilidade. Pode correr muito perto da máquina (para gerir memória e hardware directamente), mas também pode ser movido entre CPUs e sistemas operativos diferentes com relativamente pouca reescrita. Essa combinação é difícil de substituir.

Os três lugares onde o C ainda domina

A maior expressão do C aparece em três áreas:

- Sistemas operativos: kernels, bibliotecas centrais, drivers e utilitários de baixo nível de que tudo o resto depende.

- Dispositivos embebidos: sistemas pequenos com limites rígidos de memória, energia e armazenamento, onde comportamento previsível é crucial.

- Pontos de desempenho: as partes de um programa maiores onde a velocidade é crítica — caminhos de código em que alguns milissegundos ou alguns watts contam.

Mesmo quando uma aplicação é escrita em linguagens de mais alto nível, partes da sua fundação (ou os seus módulos sensíveis a desempenho) frequentemente voltam a C.

O que vai aprender neste artigo

Este texto liga os pontos entre Dennis Ritchie, os objectivos originais por trás do C, e as razões pelas quais ele ainda aparece em produtos modernos. Vamos cobrir:

- uma fatia breve e legível da história (incluindo a influência do Unix),

- as escolhas de design que tornam o C pequeno mas poderoso,

- onde o C se encaixa hoje — tanto as suas forças como os desafios de segurança.

Nota de escopo

Isto é sobre C especificamente, não “todas as linguagens de baixo nível”. C++ e Rust podem surgir para comparação, mas o foco é no que o C é, porque foi desenhado dessa forma e porque equipas continuam a escolhê‑lo para sistemas reais.

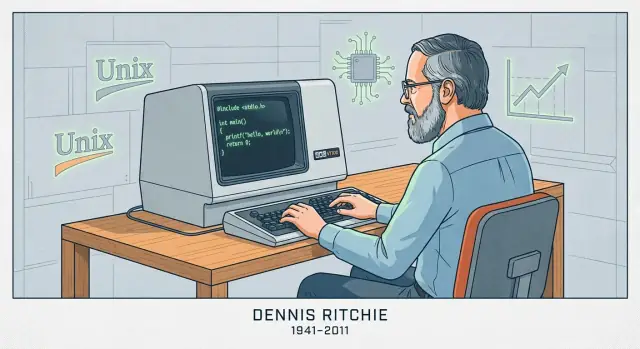

Dennis Ritchie em resumo

Dennis Ritchie (1941–2011) foi um cientista da computação norte‑americano mais conhecido pelo seu trabalho nos Bell Labs da AT&T, uma organização de investigação que teve um papel central na computação e telecomunicações iniciais.

Bell Labs, Unix e um novo tipo de software de sistema

Nos Bell Labs, no final dos anos 1960 e 1970, Ritchie trabalhou com Ken Thompson e outros em investigação de sistemas operativos que levou ao Unix. Thompson criou uma versão inicial do Unix; Ritchie tornou‑se um co‑criador chave à medida que o sistema evoluiu para algo que podia ser mantido, melhorado e partilhado amplamente na academia e na indústria.

Criar o C para construir sistemas reais

Ritchie também criou a linguagem de programação C, apoiando‑se em ideias de linguagens anteriores usadas nos Bell Labs. O C foi desenhado para ser prático na escrita de software de sistema: dá aos programadores controlo directo sobre memória e representação de dados, sendo ainda mais legível e portátil do que escrever tudo em assembly.

Essa combinação importou porque o Unix acabou por ser reescrito em C. Não foi uma reescrita de estilo — tornou o Unix muito mais fácil de mover para novo hardware e de estender com o tempo. O resultado foi um ciclo de feedback poderoso: o Unix ofereceu um caso de uso exigente para o C, e o C tornou o Unix mais fácil de adotar além de uma única máquina.

Por que o par Unix + C se tornou influente

Juntos, Unix e C ajudaram a definir “programação de sistemas” como a conhecemos: construir sistemas operativos, bibliotecas centrais e ferramentas numa linguagem próxima da máquina mas não presa a um processador. A sua influência aparece em sistemas operativos posteriores, ferramentas de desenvolvimento e nas convenções que muitos engenheiros ainda aprendem hoje — menos por mitologia e mais porque a abordagem funcionou em escala.

Como o C foi desenhado: pequeno, portátil, próximo da máquina

Sistemas operativos iniciais eram maioritariamente escritos em assembly. Isso dava aos engenheiros controlo total sobre o hardware, mas também significava que cada alteração era lenta, propensa a erros e estreitamente ligada a um processador específico. Mesmo funcionalidades pequenas podiam exigir páginas de código de baixo nível, e mover o sistema para uma máquina diferente muitas vezes significava reescrever grandes pedaços do zero.

De BCPL a B a C (a versão curta)

Dennis Ritchie não inventou o C num vácuo. Ele cresceu a partir de linguagens de sistemas mais antigas usadas nos Bell Labs.

- BCPL oferecia um estilo compacto para escrever ferramentas e software de sistema.

- B (criado por Ken Thompson) adaptou ideias do BCPL para o trabalho inicial do Unix, mas faltavam‑lhe tipos de dados e estrutura para sistemas maiores e mais exigentes.

- C manteve o espírito de “linguagem pequena”, adicionando características que tornaram o Unix prático de construir e manter em hardware real.

O objectivo de design: uma camada fina acima da máquina

O C foi construído para mapear de forma limpa ao que os computadores realmente fazem: bytes na memória, aritmética em registos e saltos pelo código. Por isso tipos simples, acesso explícito à memória e operadores que combinam com instruções da CPU estão ao centro da linguagem. Pode escrever código alto‑nível o suficiente para gerir uma grande base de código, mas ainda directo o suficiente para controlar layout na memória e desempenho.

O que “portável” significa em termos simples

“Portável” significa que pode mover o mesmo código‑fonte C para um computador diferente e, com mudanças mínimas, compilá‑lo lá e obter o mesmo comportamento. Em vez de reescrever o sistema operativo para cada novo processador, as equipas podiam manter a maior parte do código e só trocar as pequenas partes dependentes do hardware. Essa mistura — código partilhado na maior parte, pequenas arestas dependentes da máquina — foi a descoberta que ajudou o Unix a espalhar‑se.

As ideias centrais que fazem o C ser rápido

A velocidade do C não é magia — resulta largamente de como ele mapeia directamente para o que o computador faz e de quão pouco “trabalho extra” é inserido entre o seu código e a CPU.

O que a compilação produz

C é tipicamente compilado. Isso significa que escreve código‑fonte legível por humanos e depois um compilador o traduz em código de máquina: as instruções brutas que o processador executa.

Na prática, um compilador produz um executável (ou ficheiros objecto mais tarde ligados num só). O ponto chave é que o resultado final não é interpretado linha a linha em runtime — já está na forma que a CPU entende, o que reduz overhead.

Controlo previsível, overhead reduzido

C dá‑lhe blocos de construção simples: funções, laços, inteiros, arrays e ponteiros. Como a linguagem é pequena e explícita, o compilador muitas vezes pode gerar código de máquina direto.

Normalmente não há um runtime obrigatório a fazer trabalho em segundo plano como rastrear cada objecto, inserir verificações ocultas ou gerir metadados complexos. Quando escreve um laço, geralmente obtém um laço. Quando acede a um elemento de array, geralmente obtém um acesso directo à memória. Essa previsibilidade é uma grande razão pela qual o C tem bom desempenho em partes sensíveis do software.

O C usa gestão manual de memória, o que significa que o seu programa solicita memória explicitamente (por exemplo, com malloc) e liberta‑a explicitamente (com free). Isso existe porque o software a nível de sistemas frequentemente precisa de controlo fino sobre quando a memória é alocada, quanto e por quanto tempo — com overhead mínimo escondido.

A troca é direta: mais controlo pode significar mais velocidade e eficiência, mas também implica mais responsabilidade. Se esquecer de libertar memória, libertá‑la duas vezes ou usar memória após ser libertada, os bugs podem ser severos — e por vezes críticos para segurança.

C em sistemas operativos: kernels, drivers e bibliotecas centrais

Sistemas operativos ficam na fronteira entre software e hardware. O kernel tem de gerir memória, escalonar a CPU, tratar interrupções, comunicar com dispositivos e fornecer chamadas de sistema de que tudo o resto depende. Esses trabalhos não são abstractos — tratam‑se de ler e escrever locais de memória específicos, trabalhar com registos da CPU e reagir a eventos que chegam em momentos inconvenientes.

Porque é que kernels e drivers precisam de acesso de baixo nível

Drivers de dispositivo e kernels precisam de uma linguagem que expresse “faça exactamente isto” sem trabalho oculto. Na prática isso significa:

- Controlo preciso sobre o layout da memória (estruturas que casam com formatos definidos pelo hardware)

- Manipulação directa de ponteiros ao mapear memória de dispositivos ou construir tabelas de páginas

- Capacidade de interagir com interrupções e primitivas de concorrência

- Convenções de chamada previsíveis e requisitos mínimos de runtime

O C encaixa bem porque o seu modelo central é próximo da máquina: bytes, endereços e fluxo de controlo simples. Não há um runtime obrigatório, garbage collector ou sistema de objectos que o kernel tenha de hospedar antes de poder arrancar.

C como escolha padrão para kernels e bibliotecas centrais

O trabalho pioneiro do Unix popularizou a abordagem que Dennis Ritchie ajudou a moldar: implementar grandes partes do SO numa linguagem portátil, mas manter a “borda de hardware” fina. Muitos kernels modernos seguem esse padrão. Mesmo quando é necessário assembly (código de arranque, trocas de contexto), o C normalmente carrega a maior parte da implementação.

C também domina bibliotecas de sistema — componentes como as bibliotecas padrão em C, código fundamental de networking e peças de runtime de baixo nível de que linguagens de mais alto nível frequentemente dependem. Se usou Linux, BSD, macOS, Windows ou um RTOS, muito provavelmente já dependeste de código em C, mesmo sem notar.

Por que as equipas continuam a confiar no C aqui

O apelo do C no trabalho de SO é menos sobre nostalgia e mais sobre economia de engenharia:

- Toolchains estáveis: compiladores, linkers, debuggers e profilers maduros e bem compreendidos

- Portabilidade: a mesma base de código em C pode ser trazida para novas CPUs e placas com esforço gerível

- Modelo mental de hardware claro: é mais fácil raciocinar sobre o que o compilador vai gerar e como o código se comportará sob restrições apertadas

Outras linguagens existem — mas o C continua a linha base

Rust, C++ e outras linguagens são usadas em partes de sistemas operativos e podem trazer vantagens reais. Ainda assim, o C continua a ser o denominador comum: a linguagem na qual muitos kernels estão escritos, a que a maioria das interfaces de baixo nível presume, e a base com que outras linguagens de sistemas têm de interoperar.

C em dispositivos embebidos: pouca pegada, controlo previsível

Adicione uma API de controle rápida

Gere um serviço em Go + PostgreSQL que se comunica com seu módulo C via FFI ou HTTP.

“Embebido” costuma significar computadores que não consideramos computadores: microcontroladores dentro de termóstatos, altifalantes inteligentes, routers, carros, dispositivos médicos, sensores industriais e inúmeros aparelhos. Esses sistemas frequentemente executam uma única função durante anos, discretamente, com limites apertados de custo, energia e memória.

Muitos alvos embebidos têm kilobytes (não gigabytes) de RAM e armazenamento flash limitado para código. Alguns funcionam a pilhas e devem dormir a maior parte do tempo. Outros têm prazos em tempo real — se um laço de controlo do motor atrasar por alguns milissegundos, o hardware pode comportar‑se mal.

Essas restrições moldam cada decisão: quão grande é o programa, com que frequência acorda e se o seu timing é previsível.

Porque é que o C encaixa tão bem

O C tende a produzir binários pequenos com overhead de runtime mínimo. Não há uma máquina virtual obrigatória, e muitas vezes se pode evitar alocação dinâmica por completo. Isso importa quando tenta enfiar firmware num tamanho de flash fixo ou garantir que o dispositivo não “pausa” inesperadamente.

Igualmente importante, o C torna directo falar com hardware. Chips embebidos expõem periféricos — pinos GPIO, temporizadores, UART/SPI/I2C — através de registos mapeados em memória. O modelo do C mapeia‑se naturalmente nisto: pode ler e escrever endereços específicos, controlar bits individuais e fazê‑lo com muito pouca abstração no caminho.

Padrões comuns que verá em projectos reais

Muito do C embebido é ou:

- Bare‑metal: sem sistema operativo, apenas código de arranque, um laço principal e tratadores de interrupção.

- Baseado em RTOS: um pequeno sistema operativo de tempo real onde tarefas em C coordenam‑se com filas, semáforos e temporizadores.

De qualquer forma, verá código construído em torno de registos de hardware (frequentemente marcados volatile), buffers de tamanho fixo e temporização cuidadosa. Esse estilo “próximo da máquina” é exactamente a razão pela qual o C permanece a escolha por defeito para firmware que deve ser pequeno, poupador de energia e fiável sob prazos.

C em software crítico de desempenho: onde a velocidade compensa

“Crítico de desempenho” é qualquer situação onde tempo e recursos são parte do produto: milissegundos afectam a experiência do utilizador, ciclos de CPU afectam o custo do servidor e uso de memória determina se um programa cabe ou não. Nesses lugares, o C continua a ser uma opção por defeito porque permite às equipas controlar como os dados são organizados na memória, como o trabalho é agendado e o que o compilador pode otimizar.

Onde o desempenho do C importa no mundo real

Encontrará frequentemente C no núcleo de sistemas onde o trabalho acontece em grande volume ou com orçamentos de latência apertados:

- Bases de dados e motores de armazenamento (indexação, caching, compressão, execução de queries)

- Codecs para áudio/vídeo e processamento de imagem (laços de codificação/decodificação que correm biliões de vezes)

- Networking (processamento de pacotes, proxies, primitivas TLS, loops de eventos)

- Engines de jogo (orçamentos de frame, física, streaming de assets)

- Pedaços de HPC (núcleos numéricos, rotinas vetorizadas, alocadores de memória personalizados)

Esses domínios não são “rápidos” em todo o lado. Normalmente têm laços internos específicos que dominam o tempo de execução.

O “caminho quente”: optimize os 5% que custam 95%

As equipas raramente reescrevem um produto inteiro em C só para o tornar mais rápido. Em vez disso, fazem profiling, encontram o caminho quente (a pequena porção de código onde passa a maior parte do tempo) e optimizam isso.

O C ajuda porque os caminhos quentes muitas vezes são limitados por detalhes de baixo nível: padrões de acesso à memória, comportamento da cache, previsão de ramos e overhead de alocação. Quando pode afinar estruturas de dados, evitar cópias desnecessárias e controlar alocação, os ganhos de velocidade podem ser dramáticos — sem tocar no resto da aplicação.

Produtos modernos são frequentemente “multilinguagem”: Python, Java, JavaScript ou Rust para a maior parte do código, e C para o núcleo crítico.

Abordagens comuns de integração incluem:

- Extensões nativas (por exemplo, extensões C para Python, addons Node‑API)

- FFI (Foreign Function Interface) onde uma linguagem chama funções C compiladas através de um ABI estável

- Bibliotecas C como dependências partilhadas usadas por muitos runtimes (uma implementação rápida, muitos chamadores)

Este modelo mantém o desenvolvimento prático: iteração rápida numa linguagem de alto nível e desempenho previsível onde interessa. A troca é ter cuidado nas fronteiras — conversões de dados, regras de propriedade e tratamento de erros — porque cruzar a linha FFI deve ser eficiente e seguro.

Portabilidade e standards: o que faz o C viajar bem

Construa em torno do seu núcleo em C

Transforme seu sistema em C em um produto com interface web, API ou app móvel.

Uma razão pela qual o C se espalhou tão depressa é que ele viaja: o mesmo núcleo de linguagem pode ser implementado em máquinas muito diferentes, desde microcontroladores minúsculos a supercomputadores. Essa portabilidade não é magia — resulta de standards partilhados e de uma cultura de escrever para eles.

Como os standards tornaram “C” a mesma coisa em todo o lado

As primeiras implementações de C variavam entre fornecedores, o que tornava o código mais difícil de partilhar. A grande mudança veio com ANSI C (frequentemente chamado C89/C90) e depois ISO C (revisões posteriores como C99, C11, C17 e C23). Não precisa de memorizar números de versão; o ponto importante é que um standard é um acordo público sobre o que a linguagem e a biblioteca padrão fazem.

O que um standard de C lhe dá na prática

Um standard fornece:

- Regras consistentes para a linguagem (tipos, operadores, fluxo de controlo)

- Uma biblioteca padrão com comportamento previsível (I/O, strings, matemática, alocação de memória)

- Uma base que autores de compiladores podem implementar e equipas podem confiar

Isto é porque código escrito com o standard em mente pode muitas vezes ser movido entre compiladores e plataformas com surpreendentemente poucas mudanças.

Onde a portabilidade quebra na prática

Problemas de portabilidade surgem normalmente por depender de coisas que o standard não garante, incluindo:

- Comportamento indefinido: código que o compilador pode tratar de qualquer maneira (incluindo “parece bem” até que uma build falhe). Exemplos clássicos incluem ler além dos limites de um array ou usar um valor não inicializado.

- Suposições sobre tamanhos:

int não é garantido como 32 bits e tamanhos de ponteiro variam. Se o programa supõe tamanhos exactos, pode falhar ao mudar de alvo.

- APIs específicas de plataforma: chamar funções específicas do SO pode ser necessário, mas limita onde o código pode correr.

Dica prática: escreva “standard‑first”, depois aperfeiçoe

Um bom default é preferir a biblioteca padrão e manter código não portável atrás de wrappers pequenos e com nomes claros.

Também compile com flags que o empurrem para C portátil e bem definido. Escolhas comuns incluem:

- Seleccionar um modo de standard (por exemplo:

-std=c11)

- Activar avisos (

-Wall -Wextra) e levá‑los a sério

Essa combinação — código orientado ao standard mais builds estritas — faz mais pela portabilidade do que qualquer truque “esperto”.

A parte difícil: ponteiros, memória e classes comuns de bugs

O poder do C é também a sua lâmina afiada: permite trabalhar perto da memória. Isso é uma grande razão para o C ser rápido e flexível — e também porque iniciantes (e peritos cansados) podem cometer erros que outras linguagens previnem.

Imagine a memória do seu programa como uma longa rua de caixas‑do‑correio numeradas. Uma variável é uma caixa que contém algo (como um inteiro). Um ponteiro não é a coisa — é o endereço escrito num papelinho a dizer qual caixa abrir.

Isso é útil: pode passar o endereço em vez de copiar o que está dentro da caixa, e pode apontar para arrays, buffers, structs ou mesmo funções. Mas se o endereço estiver errado, abre a caixa errada.

Riscos comuns de que ouvirá falar

- Buffer overflows: escrever para além do fim de um buffer (como enfiar cartas extras na caixa #10 e derramar para a #11). Isto pode derrubar um programa ou ser explorado.

- Use‑after‑free: libertar um bloco de memória e depois usar um ponteiro que ainda “lembra” o antigo endereço — mesmo que essa caixa tenha sido reassinalada.

- Overflow de inteiros: aritmética que dá a volta (por exemplo, um cálculo de tamanho torna‑se menor do que o pretendido), levando a alocar memória insuficiente e depois transbordar um buffer.

Porque é que estes bugs importam

Esses problemas surgem como crashes, corrupção silenciosa de dados e vulnerabilidades de segurança. Em código de sistema — onde C é frequentemente usado — essas falhas podem afectar tudo o que está por cima.

Uma visão equilibrada

O C não é “inseguro por defeito”. É permissivo: o compilador assume que quisemos o que escrevemos. Isso é óptimo para desempenho e controlo de baixo nível, mas também significa que o C é fácil de usar mal a menos que o combine com hábitos cuidadosos, revisões e boas ferramentas.

Tornar o C mais seguro na prática

O C dá controlo directo, mas raramente perdoa erros. A boa notícia é que “C seguro” é menos sobre truques mágicos e mais sobre hábitos disciplinados, interfaces claras e deixar as ferramentas fazerem as verificações aborrecidas.

Técnicas defensivas que escalam

Comece por desenhar APIs que tornem o uso incorrecto difícil. Prefira funções que recebam tamanhos de buffer juntamente com ponteiros, retornem códigos de estado explícitos e documentem quem é o dono da memória alocada.

A verificação de limites deve ser rotineira, não excepção. Se uma função escreve num buffer, deve validar comprimentos à priori e falhar cedo. Para propriedade de memória, mantenha‑a simples: um alocador, um caminho correspondente de free, e uma regra clara sobre se chamadores ou chamados libertam recursos.

Compiladores modernos podem avisar sobre padrões arriscados — trate avisos como erros no CI. Acrescente verificações em runtime durante o desenvolvimento com sanitizadores (address, undefined behavior, leak) para descobrir escrita fora de limites, use‑after‑free, overflow de inteiros e outros perigos específicos do C.

Análise estática e linters ajudam a encontrar problemas que podem não aparecer em testes. Fuzzing é especialmente eficaz para parsers e handlers de protocolos: gera entradas inesperadas que frequentemente revelam bugs de buffer e máquinas de estado.

Práticas de revisão e teste

A revisão de código deve procurar explicitamente modos de falha comuns em C: indexação off‑by‑one, terminadores NUL em falta, mistura signed/unsigned, valores de retorno por analisar e caminhos de erro que deixam memória por libertar.

Testes importam mais quando a linguagem não o protege. Testes unitários são bons; testes de integração são melhores; e testes de regressão para bugs previamente encontrados são o melhor.

Subconjuntos e directrizes mais seguros

Se o seu projecto tiver necessidades estritas de fiabilidade ou segurança, considere adoptar um “subconjunto” restrito de C e um conjunto escrito de regras (por exemplo, limitar aritmética de ponteiros, banir certas chamadas de biblioteca ou exigir wrappers). O essencial é consistência: escolha directrizes que a equipa possa impor com tooling e revisões, não ideais que ficam só num slide.

C vs outras linguagens: porque as equipas ainda o escolhem

Itere sem medo

Use snapshots e rollback para testar mudanças com segurança enquanto itera.

O C está numa intersecção invulgar: é pequeno o suficiente para se entender de ponta a ponta, e suficientemente próximo do hardware e das fronteiras do SO para ser a “cola” de que tudo o resto depende. Essa combinação é porque as equipas continuam a escolhê‑lo — mesmo quando linguagens mais novas parecem mais simpáticas no papel.

C vs C++: objectivos diferentes, compatibilidade complicada, mistura prática

O C++ foi construído para acrescentar mecanismos de abstração mais fortes (classes, templates, RAII) mantendo alguma compatibilidade de fonte com muito do C. Mas “compatível” não é “idêntico”. O C++ tem regras diferentes para conversões implícitas, resolução de overloads e até o que conta como declaração válida em casos de contorno.

Em produtos reais, é comum misturá‑los:

- Módulos de baixo nível ficam em C para ABIs estáveis e convenções de chamada simples.

- Camadas superiores usam C++ para estrutura e gestão de recursos mais segura.

A ponte é tipicamente uma fronteira de API em C. Código C++ exporta funções com extern "C" para evitar name mangling, e ambos os lados acordam estruturas de dados simples. Isso permite modernizar incrementalmente sem reescrever tudo.

C vs Rust (alto nível): segurança vence, mas há constrangimentos

A grande promessa do Rust é segurança de memória sem garbage collector, sustentada por tooling forte e um ecossistema de pacotes. Para muitos projectos novos, pode reduzir classes inteiras de bugs (use‑after‑free, data races).

Mas adoptar não é grátis. As equipas podem estar limitadas por:

- Bibliotecas C existentes, drivers ou SDKs de fornecedores

- Compiladores e debuggers validados para alvos específicos

- Regimes de certificação onde maturidade de tooling e evidência importam

- Engenheiros que têm de manter o código por década

O Rust pode interoperar com C, mas a fronteira acrescenta complexidade, e nem todo alvo embebido ou ambiente de build é igualmente suportado.

Grande parte do código fundamental do mundo está em C, e reescrevê‑lo é arriscado e caro. O C também se encaixa em ambientes onde precisa de binários previsíveis, suposições mínimas de runtime e ampla disponibilidade de compiladores — desde microcontroladores minúsculos a CPUs mainstream.

Se precisa de alcance máximo, interfaces estáveis e toolchains comprovadas, o C continua a ser uma escolha racional. Se as suas restrições permitem e a segurança é a prioridade máxima, uma linguagem mais nova pode valer a pena. A melhor decisão normalmente começa pelo hardware alvo, tooling e plano de manutenção a longo prazo — não pelo que é popular este ano.

Como será o futuro (e como aprender C hoje)

O C não vai “desaparecer”, mas o seu centro de gravidade está a ficar mais claro. Ele continuará a prosperar onde o controlo directo sobre memória, timing e binários importa — e continuará a perder terreno onde segurança e rapidez de iteração valem mais do que espremer o último microssegundo.

Onde o C permanece forte

O C deverá continuar a ser escolha por defeito para:

- Kernels e trabalho de baixo nível em SO (escalonadores, gestores de memória, sistemas de ficheiros), onde precisa de desempenho previsível e suposições mínimas de runtime.

- Drivers e código voltado para hardware, onde mapeia registos, trata interrupções e trabalha dentro de restrições rígidas.

- Sistemas embebidos com orçamentos apertados de RAM/flash e requisitos de tempo real.

- Bibliotecas e runtimes centrais (compressão, primitivas crypto, VMs de linguagens, codecs multimédia), onde ABIs estáveis e portabilidade ampla têm valor.

Estas áreas evoluem lentamente, têm enormes bases de código legado e recompensam engenheiros capazes de raciocinar sobre bytes, convenções de chamada e modos de falha.

Onde o C pode diminuir (e porquê)

Para desenvolvimento de aplicações novas, muitas equipas preferem linguagens com garantias de segurança mais fortes e ecossistemas ricos. Bugs de segurança de memória (use‑after‑free, buffer overflows) são dispendiosos, e produtos modernos frequentemente priorizam entrega rápida, concorrência e defaults seguros. Mesmo em programação de sistemas, alguns componentes novos estão a mover‑se para linguagens mais seguras — enquanto o C permanece o “leito” com que continuam a interagir.

Nota de fluxo de trabalho moderno: C no produto maior

Mesmo quando o núcleo de baixo nível é em C, as equipas normalmente precisam de software envolvente: um dashboard web, um serviço API, um portal de gestão de dispositivos, ferramentas internas ou uma pequena app móvel para diagnóstico. Essa camada superior é frequentemente onde a velocidade de iteração mais importa.

Se quer mover‑se rápido nessas camadas sem reconstruir toda a pipeline, Koder.ai pode ajudar: é uma plataforma de vibe‑coding onde pode criar aplicações web (React), backends (Go + PostgreSQL) e apps móveis (Flutter) através de chat — útil para prototipar um UI de administração, visualizador de logs ou serviço de gestão de frota que se integre com um sistema baseado em C. O modo de planeamento e exportação do código tornam prático prototipar e depois levar a base de código para onde precisar.

Como aprender C hoje (um percurso prático)

Comece pelos fundamentos, mas aprenda‑os como os profissionais usam o C:

- Sintaxe + modelo de dados: inteiros, arrays, structs, noções básicas de ponteiros e como tudo se mapeia para a memória.

- Ferramentas de construção: compilar e ligar, organização de headers e um Makefile simples (mais tarde, CMake).

- Depuração: passo a passo com gdb/lldb; aprender a ler backtraces.

- Hábitos de segurança: compilar com avisos, usar AddressSanitizer/UBSan e escrever testes pequenos.

Se quiser mais artigos e percursos sobre sistemas, navegue por /blog.