2025年5月14日·1 分钟

Intel、x86 的统治地位,以及为什么平台迁移如此困难

清晰回顾 Intel x86 如何构建起数十年的兼容性、生态为何被锁定,以及为何对整个行业而言平台迁移如此艰难。

清晰回顾 Intel x86 如何构建起数十年的兼容性、生态为何被锁定,以及为何对整个行业而言平台迁移如此艰难。

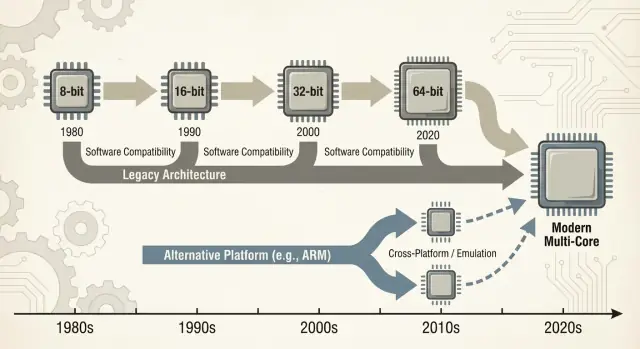

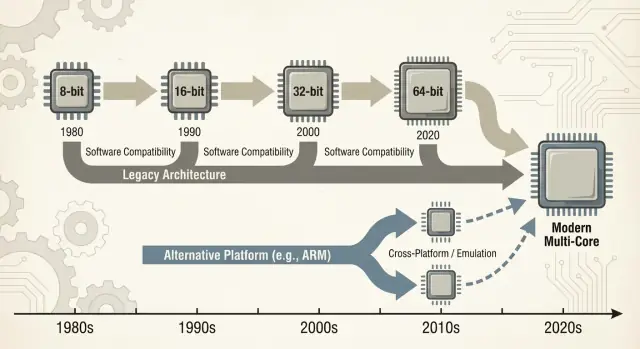

当人们说“x86”时,通常指的是一类始于英特尔 8086 芯片并历经数十年演化的 CPU 指令集。这些指令是处理器能理解的基本动词——加法、比较、数据移动等。这个指令集称为 ISA(指令集架构)。你可以把 ISA 看作软件最终必须使用的“语言”,以便在特定类型的 CPU 上运行。

x86:过去约 40 年在个人电脑上最常见的 ISA,主要由英特尔实现,也由 AMD 等厂商兼容实现。

向后兼容:新计算机在不需要重大重写的情况下继续运行旧软件(有时甚至能运行数十年前的程序)的能力。并非在每个案例都完美,但它是 PC 世界的一项基本承诺:“你的东西应该仍然能用。”

这里的“统治地位”并不仅仅是性能上的自夸。它是跨多个维度的实际、复利式优势:

这些层面彼此强化:更多机器促使更多软件,更多软件又促使更多机器。

放弃主导的 ISA 不是换一个零件那么简单。它会破坏 —— 或至少使复杂化 —— 应用、驱动(打印机、GPU、音频设备、特殊外设)、开发工具链,甚至日常的习惯(镜像流程、IT 脚本、安全代理、部署流水线)。这些依赖中许多在出现问题前都保持隐蔽。

本文主要关注长期以来 x86 占主导的 个人电脑与服务器。我们也会参考近期的变化——尤其是 ARM 的迁移案例——因为它们提供了现代、易于比较的经验教训:哪些改动能顺利进行、哪些不能,以及为什么“只需重编译”通常并非全部答案。

早期 PC 市场并非从宏大的架构计划起步,而是由实际约束推动。企业需要价格可承受、大批量供应且易于维护的机器。这促使厂商倾向于可可靠采购的 CPU 与零件、标准外设,并能用标准组件组装出系统,而无需大量定制工程。

IBM 的原始 PC 设计大量采用现成组件和相对廉价的 Intel 8088 级处理器。这个选择重要,因为它使“PC”更像是一套配方:一个 CPU 家族、一组扩展槽、键盘/显示的方案以及可复制的软件栈,而不是单一产品。

一旦 IBM PC 证明了需求,市场通过克隆得以扩大。像 Compaq 这样的公司表明可以制造兼容机器,运行相同软件,并以不同价格点销售。

同样重要的是二次来源制造:多个供应商可以提供兼容的处理器或组件。对买家而言,这降低了押注单一厂商的风险;对 OEM 而言,它提高了供应与竞争,进而加速了采用。

在这种环境下,兼容性成为用户最能理解和重视的功能。买家不需要知道什么是指令集;他们只需要知道 Lotus 1-2-3(以及后来的 Windows 应用)能否运行。

软件可用性迅速演变为简单的购买启发式:如果能运行与其他 PC 相同的程序,那就是安全选择。

硬件与固件惯例做了大量无形工作。通用总线与扩展方法、BIOS/固件预期与共享系统行为,使硬件制造商和软件开发者更容易以“PC”作为稳定目标。

这种稳定性帮助巩固了 x86 作为不断增长生态下的默认基石。

x86 的胜出并非纯粹因为时钟频率或巧妙的芯片设计。它胜出是因为软件跟随用户,而用户又跟随软件——这是一个随时间复利的“网络效应”。

当一个平台获得早期领先,开发者看到更大的受众与更明确的营收路径。这推动更多应用、更好的支持与更多第三方扩展出现。这些改进又使平台对下一波买家更具吸引力。

重复多年,“默认”平台变得难以取代——即便替代方案在技术上有吸引力。

这就是为什么平台过渡不仅仅是造一个 CPU,而是要重建整个生态:应用、安装程序、更新渠道、外设、IT 流程以及数百万用户的集体经验。

企业往往长期保留关键应用:自定义数据库、内部工具、ERP 插件、行业特定软件与没人愿意碰的工作流宏。稳定的 x86 目标意味着:

即便新平台承诺更低成本或更好性能,破坏营收工作流的风险通常超过潜在收益。

开发者很少在真空中为“最佳”平台做优化。他们会为能最小化支持负担并最大化覆盖的人群做优化。

如果 90% 的客户在 x86 Windows 上,那就是你先测试、先发布和最快修复 bug 的地方。支持第二种架构意味着额外的构建流水线、更多 QA 矩阵、更多“在我机器上能运行”的调试和更多客户支持脚本。

结果是自我强化的差距:领先平台往往能获得更好、更快的软件支持。

想象一家小企业。他们的会计套件仅支持 x86,集成了十年的模板和一个工资插件。他们还依赖某款特定标签打印机和一个对驱动很挑剔的扫描仪。

现在提出平台切换。即便核心应用存在,边缘部分也很重要:打印机驱动、扫描仪工具、PDF 插件、银行导入模块。这些“枯燥”的依赖成为必须项——当它们缺失或不稳定时,整个迁移就会停滞。

这就是飞轮效应:胜出的平台积累了每个人悄悄依赖的长尾兼容性。

向后兼容不仅仅是 x86 的一个副产品——它成为了一种刻意的产品策略。英特尔保持 x86 ISA 足够稳定,使得多年以前写的软件仍能运行,同时在底层做出大量变革。

关键区别在于保持兼容的对象。ISA 定义了程序依赖的机器指令;微架构则是芯片如何执行这些指令。

英特尔可以从简单流水线到乱序执行,引入更大缓存、改进分支预测或采用新的制程——而不要求开发者重写他们的应用。

这种稳定性创造了强烈的期待:新 PC 在第一天就应该能运行旧软件。

x86 通过分层逐步累积新能力。像 MMX、SSE、AVX 等指令集扩展是附加性的:旧二进制仍能工作,新的应用可以在可用时检测并使用新指令。

即便是重大过渡也通过兼容机制得到缓解:

代价是复杂性。支持数十年的行为意味着更多的 CPU 模式、更多的边缘情况和更重的验证负担。每一代新芯片都必须证明它仍然能运行昨日的商业应用、驱动或安装程序。

随着时间推移,“不要破坏现有应用”从指导原则变成战略约束:它保护了已装机基数,但也让彻底的平台变革(新 ISA、新系统设计、新假设)变得难以证明合理性。

“Wintel”不仅仅是对 Windows 与 Intel 芯片的俏皮称呼。它描述了一种自我强化的循环:PC 行业的每一部分都从坚持同一个默认目标(Windows 在 x86 上)中获益。

对大多数消费者与企业软件供应商来说,实际问题不是“哪个架构最好?”,而是“客户在哪里?支持工单会是什么样?”

Windows PC 在家庭、办公室与学校广泛部署,并且主要基于 x86。在该组合上发布最大化覆盖同时最小化意外情况。

一旦关键质量的应用假定 Windows + x86,新买家又有了另一层选择理由:他们的必需程序已经在那里可用。这又使平台对下一波开发者更有吸引力。

PC 制造商(OEM)在能够快速构建多型号、从多供应商采购组件并发货“开箱即用”的机器时更容易成功。通用的 Windows + x86 基线简化了制造过程。

外设厂商追随销量。如果大多数买家使用 Windows PC,那么打印机、扫描仪、音频接口、Wi‑Fi 芯片等会优先支持 Windows 驱动。更好的驱动可用性改善了 Windows PC 体验,帮助 OEM 卖出更多机器,保持高出货量。

企业和政府采购往往青睐可预测性:兼容现有应用、可控的支持成本、厂商保修和成熟的部署工具。

即便替代方案有吸引力,最低风险的选择常胜,因为它减少培训、避免边缘故障并契合既有 IT 流程。

结果不是阴谋,而是一组一致的激励——每个参与者都选择减少摩擦的路径,从而创造了让平台变更异常困难的动量。

“平台迁移”并不是简单替换 CPU,而是打包搬家:CPU ISA、操作系统、构建应用的编译器/工具链以及使硬件工作的驱动栈。改动其中任何一项常常会扰乱其它项。

大多数破坏并非戏剧性的“应用无法启动”。而是千百个小问题累积:

即便核心应用有新版本,周边的“粘合件”可能没有。

打印机、扫描仪、标签机、专用 PCIe/USB 卡、医疗设备、收银设备和 USB 加密狗 的生死取决于驱动。如果厂商已走或不感兴趣,新 OS 或新架构可能没有驱动可用。

在许多企业中,一个 200 美元的设备可能冻结一整批 2000 美元的 PC。

最大的阻碍常常是“小”内部工具:自定义 Access 数据库、Excel 宏工作簿、2009 年编写的 VB 应用、仅被三个人使用的制造专用工具。

这些通常不在任何产品路线图上,但却是关键业务。平台迁移失败的原因是这些长尾工具没有人迁移、测试并负责。

平台迁移不仅仅以基准衡量。它以总账单来评判——金钱、时间、风险与丧失的势头。对大多数个人与组织来说,这张账单比外界看到的要高得多。

对用户而言,切换成本从显而易见的(新硬件、新外设、新保修)开始,迅速延伸到混乱的细节:重训肌肉记忆、重新配置工作流、重新验证日常依赖的工具。

即便某应用“能运行”,细节也可能改变:插件不能加载、打印机驱动缺失、宏行为不同、游戏反作弊误报或某些小众配件停止工作。每一项都微不足道,但合在一起足以抹去升级的价值。

厂商为平台迁移付出的代价体现在膨胀的测试矩阵上。不仅是“能启动吗?”,还包括:

每增加一种组合就意味着更多 QA 时间、更多文档维护和更多支持工单。一次迁移能把可预测的发布节奏变成永久的事故响应周期。

开发者承担移植库、重写对 ISA 做了手工优化的性能关键代码(常常针对此 ISA 调优)与重建自动化测试的成本。最难的是恢复信心:证明新构建在真实负载下是正确、足够快且稳定的。

迁移工作直接与新特性竞争:如果一个团队花两个季度只是让东西“重新能用”,那就是两个季度没有用来改进产品。

许多组织只有在旧平台阻挡了他们,或新平台足够有吸引力以弥补这类成本时才会切换。

当新 CPU 架构到来,用户关心的不是指令集,而是他们的应用能否仍然打开。这就是“桥梁”重要的原因:它们允许新机器在生态赶上之前运行旧软件。

仿真(Emulation) 在软件中模拟整个 CPU,兼容性最好,但通常最慢,因为每条指令都被“演示”而非直接执行。

二进制翻译(通常是动态的)在程序运行时将 x86 代码片段重写为新 CPU 的本机指令。这是许多现代迁移在首日能提供可用体验的方式:安装现有应用,兼容层悄然翻译。

价值很直接:你可以买新硬件,而不必等待每个厂商都重新编译。

兼容层在主流、良性行为的应用上效果最佳,但在边缘处困难:

硬件支持往往是真正的阻挡点。

当你需要整个遗留环境(特定 Windows 版本、旧的 Java 堆栈、关键业务应用)时,虚拟化很有用。它在运维上干净明了——快照、隔离、易于回滚——但效果取决于你虚拟化的对象。

同架构虚拟机可以接近原生;跨架构虚拟机通常退回到仿真并变慢。

桥梁通常能满足办公应用、浏览器与日常生产工具这类“够快即可”的场景。对下列情况风险更大:

在实践中,桥梁买来的是时间——但很少能完全消除迁移工作。

关于 CPU 的争论往往像单一记分牌:“更快的赢”。实际上,平台胜出在于它是否符合设备约束与人们实际运行的工作负载。

x86 成为 PC 默认部分原因是它在墙插电源下提供了强劲的峰值性能,而且行业基于此假设构建了所有其它东西。

桌面与笔记本买家历来看重交互响应:启动应用、编译代码、玩游戏、处理大型表格。这推动厂商追求高提升频率、宽核与激进的涡轮模式——当能耗不是问题时这些都很好。

能效是另一套游戏。如果产品受限于电池、热设计、风扇噪音或纤薄机身,最佳 CPU 是每瓦完成“足够多”工作的那一款,且能持续不降频。

能效不仅关乎省电,还关乎在热限制内保持性能不坍塌。

手机和平板在严格的功耗预算内运行,并且在大规模出货中对成本高度敏感。这种环境奖励围绕能效、集成组件和可预测热行为优化的设计。

它也造就了一个生态,在那里操作系统、应用与硅片共同演进,基于移动优先的假设。

在数据中心,CPU 选择很少是纯基准决策。运维者关心可靠性特性、长期支持窗口、稳定的固件、监控与成熟的驱动、虚拟化与管理工具生态。

即便新架构在每瓦性能上看起来有吸引力,运维意外的风险也可能超过收益。

现代服务器工作负载多样:网页服务青睐高吞吐与高效扩展;数据库偏好内存带宽、延迟一致性与成熟调优;AI 越来越把价值转向加速器与软件栈。

随着结构变化,胜出平台也可能变化——但前提是周边生态能跟上。

一个新 CPU 架构即便技术上出色,若日常工具不能让构建、发布和支持软件变得容易,它也会失败。对大多数团队来说,“平台”不只是指令集,而是整个交付管线。

编译器、调试器、分析器与核心库悄然塑造开发者行为。如果最好的编译器选项、堆栈跟踪、sanitizers 或性能工具来得晚(或行为不同),团队就会犹豫不决。

即便是小缺口也重要:缺少库、调试器插件不稳定或 CI 构建变慢,都会把“我们可以移植”变为“本季度不做”。当 x86 工具链在 IDE、构建系统与 CI 模板中是默认时,阻力会持续把开发者拉回去。

软件通过包装习惯传播:安装器、更新器、仓库、应用商店、容器与签名二进制。平台切换会带来令人不适的问题:

如果分发变得混乱,支持成本飙升,很多厂商就会回避它。

企业购买它们能大规模管理的平台:镜像、设备注册、策略、端点安全、EDR 代理、VPN 客户端与合规报告。如果其中任何工具在新架构上滞后,试点就会停止。

“在我机器上能运行”在 IT 无法部署与保障安全时毫无意义。

开发者与 IT 会集中在一个实际问题上:我们能多快发布并提供支持?工具链与分发往往比基准更具决定性。

一种实际做法是缩短从想法到可测试构建的时间——尤其在需要跨不同环境验证同一应用(x86 vs ARM,不同 OS 镜像或不同部署目标)时。

像 Koder.ai 这类平台能融入此工作流,让团队通过聊天界面生成并迭代真实应用——常见是生成 React 前端、Go 后端与 PostgreSQL 数据库(以及用于移动的 Flutter)。针对平台迁移工作,两项能力尤其相关:

由于 Koder.ai 支持 源代码导出,它还能作为实验与传统工程流水线之间的桥梁——在快速试验的同时,最终产出仍是可维护的代码且掌握在你手中。

ARM 向笔记本与桌面推进,是检验平台迁移难度的有力现实样本。纸面上主张很简单:更好的每瓦性能、更安静的机器、更长的电池续航。

在实践中,成功更多取决于 CPU 核心之外的东西——应用、驱动、分发以及谁有能力协调参与者。

苹果从 Intel 转向 Apple Silicon 的成功,很大程度上源于它掌控了全栈:硬件设计、固件、操作系统、开发工具与主要应用分发渠道。

这种掌控让公司无需等待几十个独立伙伴同步移动,就能做出干净的切换。

它也促成了有序的“桥梁”期:开发者获得清晰目标,用户得到兼容路径,苹果可以对关键厂商施压以发布原生版本。即便部分应用非原生运行,因迁移计划被作为产品来设计(而不是简单处理器更换),用户体验通常保持可接受。

Windows-on-ARM 展示了另一面。微软并不能完全控制硬件生态,而 Windows PC 强依赖 OEM 选择与长尾设备驱动。

这产生了常见的失败点:

ARM 的近期进展强化了一个核心教训:掌控更多栈层能让迁移更快且不那么碎片化。

当依赖合作伙伴时,你需要非同寻常的协调能力、清晰的升级路径,以及让每个参与方(芯片厂商、OEM、开发者与 IT 买家)都有理由同步推进的激励。

平台切换会因枯燥的理由失败:旧平台仍然可用、所有人已为其付费(钱与习惯),而真正的业务都藏在“边缘情况”中。

新平台只有在三件事对齐时才可能胜出:

首先,对普通买家来说好处明显——不仅仅是工程师能理解:更好续航、显著更低成本、新的形态因子,或在常见任务上跨越式的性能提升。

其次,有可信的兼容计划:优秀的仿真/翻译、简单的“通用”构建,以及针对驱动、外设与企业工具的明确路径。

第三,链条上的激励对齐:操作系统厂商、芯片厂商、OEM 与应用开发者都看见收益并有理由优先推动迁移。

成功的迁移不像开关切换,更像受控的重叠。分阶段推出(先做试点组)、双重构建(旧 + 新)与遥测(崩溃率、性能、特性使用)让团队能早发现问题。

同样重要的是:公布旧平台的支持窗口、明确内部截止日期以及为“尚无法迁移”用户准备的计划。

x86 仍有巨大的势头:数十年的兼容性、深入的企业工作流与广泛的硬件选择。

但来自新需求的压力在不断累积——能效、紧密集成、以 AI 为中心的计算与更简单的设备队伍。最难的争夺不是单纯的原始速度,而是让切换感觉安全、可预测且值得付出代价。

x86 是一种 CPU 指令集架构(ISA):软件最终运行的机器语言指令集合。

“统治地位”在本文中指的是 出货量巨大、最丰富的软件目录 与 默认心智占位 的复合优势——不仅仅是基准性能的领先。

ISA 是 CPU 能理解的“语言”。

如果一个应用是为 x86 编译的,它将在 x86 CPU 上原生运行。若改用另一种 ISA(如 ARM),通常需要 原生重编译,或者依赖 翻译/仿真 来运行旧的二进制文件。

向后兼容性让更新的机器在最小改动下继续运行旧软件。

在 PC 世界,这是一个产品预期:升级不应该迫使你重写应用、放弃工作流程或舍弃仍然关键的“老旧工具”。

芯片可以改变执行指令的方式(微架构),同时保持**指令本身(ISA)**的稳定。

这就是为什么你可以在性能、缓存和功耗上看到巨大变化,却不破坏旧的二进制程序。

常见破坏点包括:

往往“主应用”能运行,但周边的粘合件不能。

通常是 缺少驱动 或不受支持的外设阻挡迁移。

兼容层可以翻译应用,但无法为厂商从未提供的利基扫描仪、POS 设备或 USB 安全密钥创造稳定的内核驱动。

已装机量驱动开发者投入。

如果大多数客户使用 Windows x86,厂商会优先在该平台构建、测试并提供支持。支持另一种架构会增加 CI 构建、QA 组合、文档与支持负担,很多团队会等到需求无可忽视时才去做。

并非总是。重编译只是其中一环。你还可能需要:

最难的部分通常是证明新构建在真实环境中正确且可支持。

它们是桥梁,而非万灵药:

它们为生态赶上争取时间,但驱动和底层组件仍然是硬边界。

用清单驱动的试点来评估:

把它当作受控滚动发布并准备回滚,而不是一次性“全部切换”。