10 thg 6, 2025·8 phút

Các lớp cache giảm tải — nhưng lại làm tăng phức tạp ẩn

Các lớp cache giảm độ trễ và tải backend, nhưng đồng thời thêm chế độ lỗi và chi phí vận hành. Tìm hiểu các lớp phổ biến, rủi ro và cách quản lý sự phức tạp.

Các lớp cache giảm độ trễ và tải backend, nhưng đồng thời thêm chế độ lỗi và chi phí vận hành. Tìm hiểu các lớp phổ biến, rủi ro và cách quản lý sự phức tạp.

Cache lưu một bản sao dữ liệu gần nơi cần dùng để trả lời yêu cầu nhanh hơn, với ít lượt tới hệ thống gốc hơn. Lợi ích thường là sự kết hợp của tốc độ (độ trễ thấp hơn), chi phí (ít đọc database hoặc gọi upstream tốn kém), và ổn định (origin chịu được đột biến lưu lượng).

Khi cache có thể trả lời một yêu cầu, “origin” (app server, database, API bên thứ ba) làm ít hơn. Giảm này có thể rất lớn: ít truy vấn hơn, ít CPU hơn, ít lượt mạng hơn, và ít cơ hội xảy ra timeout.

Cache cũng làm mượt các đột biến—giúp hệ thống được dimension cho lưu lượng trung bình xử lý được những lúc cao điểm mà không phải scale ngay lập tức (hoặc sập).

Cache không loại bỏ công việc; nó dời công việc đó vào thiết kế và vận hành. Bạn sẽ phải trả lời các câu hỏi mới:

Mỗi lớp cache thêm cấu hình, giám sát và các trường hợp bờ. Một cache làm 99% yêu cầu nhanh hơn vẫn có thể gây sự cố đau đầu trong 1% còn lại: hết hạn đồng bộ, trải nghiệm người dùng không nhất quán, hoặc đột ngột tràn về origin.

Một cache đơn là một kho (ví dụ cache in-memory bên cạnh app). Một lớp cache là một checkpoint riêng biệt trên đường đi của yêu cầu—CDN, cache trình duyệt, cache ứng dụng, cache database—mỗi cái có quy tắc và chế độ lỗi riêng.

Bài viết này tập trung vào sự phức tạp thực tiễn do nhiều lớp tạo ra: tính đúng, vô hiệu hóa, và vận hành (không đi sâu vào thuật toán cache hay tuning theo vendor).

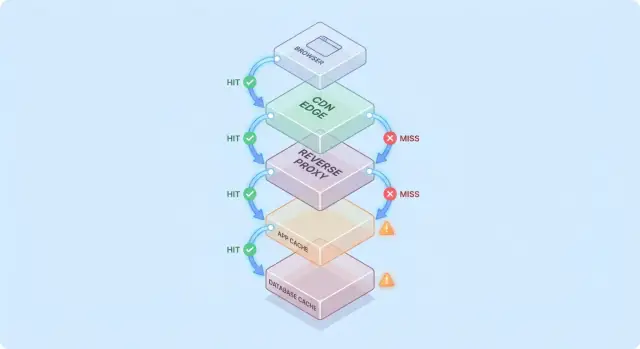

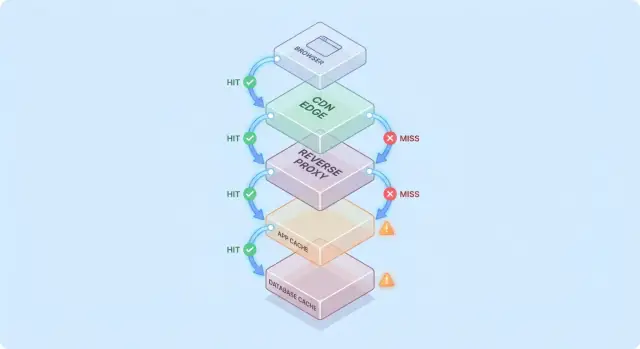

Cache dễ hiểu hơn khi bạn tưởng tượng một yêu cầu đi qua một chồng checkpoint “có rồi thì trả”.

Đường đi phổ biến như sau:

Ở mỗi bước, hệ thống có thể trả phản hồi đã cache (hit) hoặc chuyển tiếp đến lớp tiếp theo (miss). Hit xảy ra càng sớm (ví dụ ở edge) thì bạn càng tránh được tải sâu hơn trong stack.

Hit khiến dashboard đẹp. Miss mới là nơi xuất hiện phức tạp: chúng kích hoạt công việc thật sự (logic app, truy vấn DB) và thêm overhead (tra cứu cache, serialization, ghi cache).

Mô hình tư duy hữu ích: mỗi miss trả hai lần cho cache—bạn vẫn làm công việc gốc, cộng thêm công việc xung quanh cache.

Thêm một lớp cache hiếm khi loại bỏ điểm nghẽn; thường nó dịch chúng đi:

Giả sử trang sản phẩm của bạn cache ở CDN 5 phút, và app cũng cache chi tiết sản phẩm trong Redis 30 phút.

Nếu giá thay đổi, CDN có thể làm mới nhanh trong khi Redis vẫn trả giá cũ. Lúc này “sự thật” phụ thuộc vào lớp nào trả lời—đoạn minh họa vì sao các lớp cache giảm tải nhưng tăng độ phức tạp.

Cache không phải là một tính năng duy nhất—nó là một chồng nơi dữ liệu được lưu và tái dùng. Mỗi lớp giảm tải nhưng có quy tắc khác nhau về độ tươi, vô hiệu và hiển thị.

Trình duyệt cache ảnh, script, CSS, và đôi khi phản hồi API dựa trên header HTTP (như Cache-Control và ETag). Điều này có thể loại bỏ hoàn toàn việc tải lại—tốt cho hiệu năng và giảm lưu lượng CDN/origin.

Vấn đề: khi phản hồi đã được cache phía client, bạn không hoàn toàn kiểm soát thời điểm tái xác thực. Một số người dùng giữ tài nguyên cũ lâu hơn (hoặc xoá cache bất ngờ), nên URL phiên bản hoá (ví dụ app.3f2c.js) là biện pháp an toàn phổ biến.

CDN cache nội dung gần người dùng. Nó rất phù hợp cho file tĩnh, trang công khai, và phản hồi “ít thay đổi” như ảnh sản phẩm, tài liệu, hoặc API giới hạn tần suất.

CDN cũng có thể cache HTML bán tĩnh nếu bạn cẩn thận với biến thể (cookie, headers, vùng địa lý, thiết bị). Quy tắc biến thể bị cấu hình sai thường là nguồn phục vụ nội dung sai cho người dùng.

Reverse proxy (như NGINX hoặc Varnish) nằm trước ứng dụng và có thể cache toàn bộ phản hồi. Điều này hữu ích khi bạn muốn kiểm soát tập trung, chính sách eviction dự đoán được, và bảo vệ origin nhanh khi có đột biến.

Nó thường phân phối kém hơn CDN nhưng dễ tuỳ chỉnh theo route và header của app.

Cache này nhắm tới đối tượng, kết quả tính toán, và các cuộc gọi tốn kém (ví dụ “user profile theo id” hoặc “quy tắc giá theo vùng”). Nó linh hoạt và có thể biết logic nghiệp vụ.

Nhưng nó cũng thêm nhiều quyết định: thiết kế key, TTL, logic vô hiệu, và nhu cầu vận hành như sizing và failover.

Hầu hết DB cache trang, index và kế hoạch truy vấn tự động; một số hỗ trợ cache kết quả. Điều này giúp tăng tốc query lặp mà không đổi code app.

Nên coi đây là lợi ích phụ, không phải đảm bảo: cache DB ít dự đoán được nhất khi patterns truy vấn đa dạng, và nó không loại bỏ chi phí ghi, khoá, hay contention như cache phía trên có thể làm.

Cache có hiệu quả nhất khi biến các thao tác backend lặp lại và tốn kém thành một tra cứu rẻ. Bí quyết là khớp cache với workload mà yêu cầu đủ giống — và đủ ổn định — để tái dùng cao.

Nếu hệ thống bạn đọc nhiều hơn ghi rất nhiều, cache có thể loại bỏ phần lớn công việc DB và app. Trang sản phẩm, profile công khai, bài trợ giúp, và kết quả tìm kiếm/thao tác lọc thường bị yêu cầu lặp nhiều cùng tham số.

Cache cũng giúp với tác vụ “tốn kém” không chỉ gói trong DB: tạo PDF, resize ảnh, render template, hoặc tính toán tổng hợp. Ngay cả cache ngắn hạn (vài giây đến vài phút) cũng có thể gộp nhiều lần tính lặp trong giờ cao điểm.

Cache đặc biệt hiệu quả khi lưu lượng không đều. Nếu email marketing, tin tức, hoặc bài trên mạng xã hội đẩy nhiều người đến cùng vài URL, CDN/edge có thể hấp thụ phần lớn đợt tăng đó.

Điều này giảm tải hơn là chỉ "tốc độ trả lời": nó ngăn autoscaling rung lắc, tránh cạn connection DB, và mua thời gian cho rate limit/backpressure hoạt động.

Nếu backend của bạn ở xa người dùng—về mặt địa lý (cross-region) hoặc logic (dependency chậm)—cache giảm cả tải lẫn cảm nhận chậm. Phục vụ từ cache CDN gần người dùng tránh những lượt đi dài tới origin.

Cache nội bộ cũng hữu ích khi điểm nghẽn là kho lưu trữ độ trễ cao (DB từ xa, API bên thứ ba, hoặc dịch vụ chia sẻ). Giảm số cuộc gọi làm giảm concurrency pressure và cải thiện tail latency.

Cache ít hiệu quả khi phản hồi cá nhân hoá mạnh (dữ liệu per-user, chi tiết tài khoản nhạy cảm) hoặc khi dữ liệu thay đổi liên tục (bảng điều khiển trực tiếp, tồn kho tốc độ cao). Khi đó tỷ lệ hit thấp, chi phí vô hiệu tăng, và lợi ích giảm tải có thể nhỏ.

Quy tắc thực tế: cache có giá trị nhất khi nhiều người hỏi cùng một thứ trong một cửa sổ thời gian mà “cùng một thứ” vẫn hợp lệ. Nếu sự chồng lấp đó không tồn tại, một lớp cache nữa có thể chỉ tăng phức tạp mà không giảm nhiều tải.

Cache dễ khi dữ liệu không bao giờ thay đổi. Khi nó thay đổi, bạn nhận lấy phần khó nhất: quyết định khi nào dữ liệu cache không còn đáng tin và làm sao mọi lớp cache biết là nó đã thay đổi.

Time-to-live (TTL) hấp dẫn vì chỉ một con số và không cần phối hợp. Vấn đề là TTL “đúng” phụ thuộc vào cách dữ liệu được dùng.

Nếu đặt TTL 5 phút cho giá sản phẩm, một số người sẽ thấy giá cũ sau khi giá thay đổi—có thể gây vấn đề pháp lý hoặc hỗ trợ. Nếu đặt 5 giây, bạn có thể hầu như không giảm tải. Tệ hơn, các trường khác nhau trong cùng phản hồi thay đổi với tốc độ khác nhau (tồn kho vs mô tả), nên một TTL đơn buộc phải đánh đổi.

Vô hiệu hóa theo sự kiện nói rằng: khi nguồn sự thật thay đổi, phát một sự kiện và purge/update tất cả cache key bị ảnh hưởng. Điều này có thể cực kỳ chính xác, nhưng tạo công việc mới:

Ánh xạ này là nơi mà “hai cái khó: đặt tên và vô hiệu hóa” trở nên rất thực tiễn. Nếu bạn cache /users/123 và cũng cache danh sách “top contributors”, một thay đổi tên user ảnh hưởng nhiều key. Nếu không theo dõi quan hệ, bạn sẽ phục vụ một thực tế lẫn lộn.

Cache-aside (app đọc/ghi DB, populate cache) phổ biến, nhưng vô hiệu hóa là trách nhiệm của bạn.

Write-through (ghi cache và DB cùng lúc) giảm rủi ro stale, nhưng thêm độ trễ và phức tạp xử lý lỗi.

Write-back (ghi vào cache trước, flush sau) tăng tốc, nhưng khiến đúng đắn và phục hồi khó hơn nhiều.

Stale-while-revalidate trả dữ liệu hơi cũ trong khi làm mới ngầm. Nó làm mượt các đột biến và bảo vệ origin, nhưng cũng là quyết định sản phẩm: bạn chọn “nhanh và hầu như hiện tại” thay vì “luôn mới nhất”.

Cache thay đổi khái niệm “đúng”. Không có cache, người dùng thường thấy dữ liệu mới nhất đã commit (theo hành vi DB bình thường). Có cache, người dùng có thể thấy dữ liệu hơi lạc hậu—hoặc không nhất quán giữa các màn hình—thường không kèm lỗi rõ ràng.

Nhất quán mạnh hướng tới “read-after-write”: nếu người dùng cập nhật địa chỉ giao hàng, tải lại trang tiếp theo nên hiển thị địa chỉ mới ở mọi nơi. Điều này cảm nhận trực quan, nhưng có thể tốn kém nếu mỗi ghi phải purge hoặc làm mới nhiều cache ngay lập tức.

Eventual consistency cho phép tồn tại độ lùi ngắn: cập nhật sẽ xuất hiện sớm, nhưng không ngay lập tức. Người dùng chấp nhận điều này với nội dung ít quan trọng (như số lượt xem), nhưng không chấp nhận với tiền, quyền truy cập, hay những thứ ảnh hưởng hành động tiếp theo.

Bẫy phổ biến: một ghi xảy ra đồng thời với repopulate cache:

Giờ cache giữ dữ liệu cũ trong TTL đầy đủ, dù database đã đúng.

Với nhiều lớp cache, các phần hệ thống có thể không đồng ý:

Người dùng thấy điều này như “hệ thống bị hỏng”, không phải “hệ thống cuối cùng nhất quán”.

Versioning giảm mơ hồ:

user:123:v7) cho phép tiến tới an toàn: ghi tăng version và đọc tự nhiên chuyển sang key mới mà không cần xóa hoàn hảo.Quyết định chính không phải là “dữ liệu cũ có xấu không?” mà là nó xấu ở đâu.

Đặt ngân sách độ cũ rõ ràng theo tính năng (giây/phút/giờ) và phù hợp với kỳ vọng người dùng. Kết quả tìm kiếm có thể chậm 1 phút; số dư tài khoản và quyền truy cập thì không nên.

Cache thường thất bại theo cách trông như “mọi thứ ổn, rồi cùng lúc mọi thứ sập.” Những lỗi này không nghĩa caching xấu—mà là cache cô đặc mẫu lưu lượng, nên thay đổi nhỏ có thể gây hiệu ứng lớn.

Sau deploy, autoscale hoặc flush cache, bạn có thể có cache gần như rỗng. Đợt truy cập tiếp theo buộc nhiều request chạm DB hoặc API upstream trực tiếp.

Điều này đau hơn khi lưu lượng tăng nhanh, vì cache chưa kịp warm với mục phổ biến. Nếu deploy trùng peak, bạn có thể vô tình tạo bài test tải của chính mình.

Stampede xảy ra khi nhiều người cùng yêu cầu một mục đúng lúc nó hết hạn (hoặc chưa được cache). Thay vì một request xây dựng giá trị, hàng trăm hoặc hàng nghìn request làm—quá tải origin.

Các biện pháp giảm:

Nếu yêu cầu độ đúng cho phép, stale-while-revalidate cũng làm mượt đỉnh.

Một số key cực kỳ phổ biến (payload homepage, sản phẩm đang trending, cấu hình toàn cầu). Hot key tạo tải không đều: một node cache hoặc một đường backend bị dồn, trong khi các node khác nhàn.

Giải pháp: tách key lớn thành nhiều key nhỏ, thêm sharding/partitioning, hoặc cache ở lớp khác (ví dụ chuyển nội dung công cộng thật sự gần người dùng bằng CDN).

Sự cố cache có thể tệ hơn không có cache, vì ứng dụng có thể phụ thuộc vào nó. Quyết trước:

Dù chọn gì, rate limits và circuit breakers giúp tránh sự cố cache trở thành sự cố origin.

Cache có thể giảm tải origin, nhưng tăng số dịch vụ bạn vận hành hàng ngày. Ngay cả cache quản lý cũng cần kế hoạch, tuning và đáp ứng sự cố.

Một lớp cache mới thường là một cluster mới (hoặc ít nhất một tier mới) với giới hạn dung lượng riêng. Đội phải quyết sizing bộ nhớ, chính sách eviction, và hành xử dưới áp lực. Nếu cache thiếu kích thước, nó churn: tỷ lệ hit giảm, độ trễ tăng, origin vẫn bị tấn công.

Cache hiếm khi chỉ sống một nơi. Bạn có thể có CDN, cache ứng dụng, và cache DB—tất cả diễn giải quy tắc khác nhau.

Sự khác biệt nhỏ cộng dồn:

Theo thời gian, “tại sao request này được cache?” trở thành một dự án khảo cổ.

Cache tạo công việc định kỳ: warm keys sau deploy, purge hoặc revalidate khi dữ liệu thay đổi, reshard khi thêm/xóa node, và diễn tập khi flush toàn bộ.

Khi người dùng báo dữ liệu cũ hoặc chậm đột ngột, người trực giờ có nhiều nghi ngờ: CDN, cluster cache, client cache của app, và origin. Debug thường cần kiểm tra hit rate, spike eviction và timeout qua các lớp—rồi quyết định bypass, purge, hay scale.

Cache chỉ là thắng lợi nếu nó giảm công việc backend và cải thiện tốc độ cảm nhận của người dùng. Vì requests có thể phục vụ bởi nhiều lớp (edge/CDN, cache app, cache DB), bạn cần observability trả lời:

Tỷ lệ hit cao nghe ổn, nhưng có thể che dấu vấn đề (như đọc cache chậm hoặc churn liên tục). Theo dõi một bộ nhỏ metrics cho từng lớp:

Nếu hit ratio tăng mà tổng độ trễ không cải thiện, cache có thể chậm, quá serialize, hoặc trả payload quá lớn.

Tracing phân tán nên cho biết request được phục vụ ở edge, cache app hay DB. Thêm tag nhất quán như cache.layer=cdn|app|db và cache.result=hit|miss|stale để lọc trace và so sánh timing đường đi hit vs miss.

Log key cache cẩn thận: tránh identifier người dùng thô, email, token hoặc URL đầy query string. Ưu tiên key chuẩn hoá hoặc hash và chỉ log tiền tố ngắn.

Alert khi spike miss-rate bất thường, nhảy vọt độ trễ trên miss, và tín hiệu stampede (nhiều miss đồng thời cho cùng pattern key). Tách dashboard theo edge, app, và database, cộng một bảng end-to-end liên kết chúng.

Cache lặp lại câu trả lời nhanh—nhưng cũng có thể lặp lại câu trả lời sai cho người không nên nhận. Sự cố bảo mật liên quan cache thường âm thầm: mọi thứ trông nhanh và khỏe, trong khi dữ liệu bị lộ.

Lỗi phổ biến là cache nội dung cá nhân hoặc mật (chi tiết tài khoản, hoá đơn, ticket hỗ trợ, trang admin). Việc này có thể xảy ra ở bất kỳ lớp nào—CDN, reverse proxy, hoặc cache ứng dụng—đặc biệt khi có quy tắc “cache mọi thứ” quá rộng.

Rò rỉ tinh tế khác: cache phản hồi có session state (ví dụ Set-Cookie) và phục vụ phản hồi đó cho người khác.

Lỗi kinh điển là cache HTML/JSON trả cho User A rồi sau đó phục vụ cho User B vì cache key không bao gồm ngữ cảnh người dùng. Trong hệ đa tenant, identity tenant phải là một phần của key.

Quy tắc: nếu phản hồi phụ thuộc vào authentication, roles, vùng, pricing tier, feature flags, hoặc tenant, key cache (hoặc logic bypass) phải phản ánh phụ thuộc đó.

Hành vi cache HTTP bị điều khiển mạnh bởi header:

Cache-Control: tránh lưu trữ tai hại bằng private / no-store khi cầnVary: đảm bảo cache phân tách phản hồi theo header liên quan (ví dụ Authorization, Accept-Language)Set-Cookie: thường là dấu hiệu phản hồi nên không cache công cộngNếu compliance hoặc rủi ro cao—PII, y tế/tài chính, tài liệu pháp lý—ưu tiên Cache-Control: no-store và tối ưu server-side thay vì cache. Với trang hỗn hợp, chỉ cache mảnh không nhạy cảm hoặc tài sản tĩnh, và giữ dữ liệu cá nhân ngoài cache chia sẻ.

Lớp cache có thể cắt tải origin, nhưng hiếm khi là “hiệu năng miễn phí”. Xem mỗi cache như một khoản đầu tư: bạn đổi latency thấp và ít công việc backend lấy tiền, thời gian kỹ sư và bề mặt đúng đắn lớn hơn.

Chi phí hạ tầng thêm vs giảm chi phí origin. CDN giảm egress và đọc DB nhưng bạn trả cho request CDN, lưu trữ cache, và đôi khi gọi invalidation. Cache ứng dụng (Redis/Memcached) thêm chi phí cluster, cập nhật và gánh nặng on-call. Tiết kiệm có thể là ít bản sao DB hơn, instance nhỏ hơn, hoặc hoãn scale.

Lợi thế độ trễ vs chi phí tươi. Mỗi cache đặt câu hỏi “độ cũ chấp nhận được?” Độ tươi nghiêm ngặt yêu cầu nhiều plumbing invalidation hơn (và nhiều miss hơn). Chấp nhận độ cũ tiết kiệm compute nhưng có thể mất niềm tin người dùng—nhất là với giá, tồn kho, quyền.

Thời gian kỹ sư: tốc độ feature vs công việc độ tin cậy. Lớp mới thường đồng nghĩa nhiều code path hơn, test hơn, và thêm loại sự cố phải ngăn (stampede, hot keys, invalidation từng phần). Dự toán chi phí bảo trì liên tục, không chỉ triển khai ban đầu.

Trước khi rollout rộng, chạy thử có giới hạn:

Thêm lớp cache chỉ khi:

Cache có lời nhất khi bạn coi nó như một tính năng sản phẩm: cần có chủ sở hữu, quy tắc rõ, và cách an toàn để tắt.

Thêm một lớp cache một lần (ví dụ CDN hoặc cache ứng dụng trước), và giao cho một team/người chịu trách nhiệm trực tiếp.

Xác định ai sở hữu:

Hầu hết lỗi cache thực ra là “lỗi key”. Dùng quy ước có tài liệu bao gồm inputs làm thay đổi phản hồi: tenant/user scope, locale, device class, và feature flags liên quan.

Thêm versioning key rõ ràng (ví dụ product:v3:...) để bạn invalidate an toàn bằng cách tăng version thay vì cố xóa hàng triệu entry.

Cố giữ mọi thứ hoàn toàn mới đẩy phức tạp vào mọi đường ghi.

Thay vào đó, quyết độ cũ “chấp nhận được” cho từng endpoint (giây, phút, hoặc “đến lần làm mới kế tiếp”), rồi mã hoá bằng:

Giả sử cache sẽ chậm, sai, hoặc sập.

Dùng timeouts và circuit breaker để gọi cache không làm gãy đường xử lý yêu cầu. Làm rõ giảm chất lượng: nếu cache lỗi, fallback về origin với rate limit, hoặc trả phản hồi tối thiểu.

Triển khai cache qua canary hoặc rollout theo tỷ lệ, và giữ công tắc bypass (per route hoặc header) để debug nhanh.

Document runbook: cách purge, cách tăng version key, cách tắt cache tạm thời, và chỗ xem metrics. Liên kết chúng trong trang runbook nội bộ để on-call hành động nhanh.

Công việc cache thường chậm vì thay đổi chạm nhiều lớp (header, logic app, model dữ liệu, rollback). Một cách giảm chi phí lặp là prototype toàn bộ đường đi yêu cầu trong môi trường kiểm soát.

Với Koder.ai, đội có thể nhanh chóng dựng một stack app thực tế (React trên web, backend Go với PostgreSQL, thậm chí client mobile Flutter) từ workflow chat-driven, rồi thử các quyết định cache (TTL, thiết kế key, stale-while-revalidate) end-to-end. Tính năng như planning mode giúp ghi lại hành vi cache dự định trước triển khai, và snapshots/rollback làm an toàn khi thử cấu hình hoặc logic invalidation. Khi sẵn sàng, bạn có thể export source code hoặc triển khai/host với domain tuỳ chỉnh—hữu ích cho thử nghiệm performance cần mô phỏng lưu lượng production.

Nếu dùng nền tảng như vậy, coi nó là bổ sung cho observability production: mục tiêu là lặp nhanh thiết kế cache trong khi giữ rõ yêu cầu đúng đắn và quy trình rollback.

Caching giảm tải bằng cách trả lời những yêu cầu lặp lại mà không phải chạm tới origin (app servers, cơ sở dữ liệu, API bên thứ ba). Lợi ích lớn nhất thường đến từ:

Càng sớm trong đường dẫn yêu cầu mà cache trả được (trình duyệt/CDN so với app), bạn càng tránh được nhiều công việc ở origin.

Một cache đơn là một kho lưu trữ duy nhất (ví dụ cache trong bộ nhớ sát ứng dụng). Một "lớp cache" là một điểm kiểm tra trên đường đi của yêu cầu (cache trình duyệt, CDN, reverse proxy, cache ứng dụng, cache DB).

Nhiều lớp giảm tải rộng hơn, nhưng cũng tạo thêm luật, chế độ lỗi và nhiều cách để phục vụ dữ liệu không đồng nhất khi các lớp không khớp nhau.

Miss kích hoạt công việc thực sự cộng với chi phí quanh cache. Khi miss thường bạn trả cho:

Do đó một miss có thể chậm hơn so với “không dùng cache” trừ khi cache được thiết kế tốt và tỷ lệ hit cao trên các endpoint quan trọng.

TTL dễ vì không cần phối hợp, nhưng buộc bạn phải đoán về độ tươi. Nếu TTL quá dài, bạn phục vụ dữ liệu cũ; quá ngắn thì không giảm được tải.

Cách thực tế: đặt TTL theo tính năng dựa trên tác động tới người dùng (ví dụ: vài phút cho trang tài liệu, vài giây hoặc không cache cho số dư/tính giá) và điều chỉnh dựa trên dữ liệu hit/miss và sự cố thực tế.

Dùng vô hiệu hóa theo sự kiện khi độ cũ tốn kém và bạn có thể kết nối đáng tin cậy giữa các ghi và keys bị ảnh hưởng. Nó phù hợp khi:

Nếu không đảm bảo được, ưu tiên độ tươi có giới hạn (TTL + revalidation) hơn là vô hiệu hoàn hảo mà có thể thất bại âm thầm.

Caching đa lớp có thể khiến các phần hệ thống không đồng ý với nhau. Ví dụ: CDN trả về HTML cũ trong khi cache ứng dụng trả JSON mới hơn, khiến UI lẫn lộn.

Để giảm thiểu:

product:v3:...) để đọc chuyển sang phiên bản mới an toànVary/headers phản ánh đúng những gì thay đổi giao diệnStampede (thundering herd) xảy ra khi nhiều request cùng xây dựng lại cùng một key đồng thời (thường ngay sau khi hết hạn), làm origin quá tải.

Các biện pháp phổ biến:

Quyết trước hành vi dự phòng:

Thêm timeouts, circuit breaker và rate limits để sự cố cache không lan sang origin.

Tập trung vào các chỉ số giải thích kết quả, không chỉ tỷ lệ hit:

Trong tracing/logs, gắn thẻ requests bằng cache.layer và cache.result để so sánh đường đi hit vs miss và phát hiện suy giảm nhanh.

Rủi ro phổ biến là cache các phản hồi có tính cá nhân hoặc nhạy cảm trong lớp chia sẻ (CDN/reverse proxy) do key thiếu biến thể hoặc header sai.

Biện pháp:

Cache-Control: private hoặc no-store cho phản hồi nhạy cảmVary đúng (ví dụ Authorization, Accept-Language) khi phản hồi khác nhauSet-Cookie là tín hiệu mạnh nên tránh cache công cộng