17 aug. 2025·8 min

Varför AI-drivna arbetsflöden minskar för tidig abstraktion

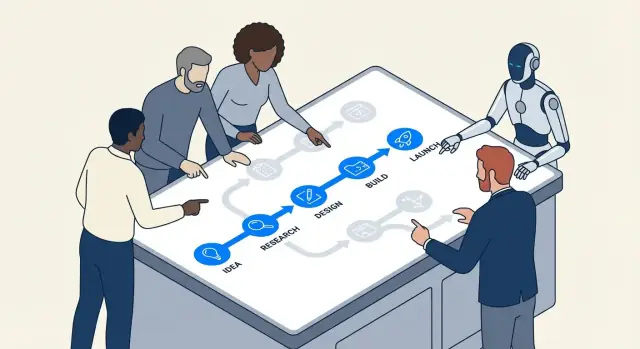

AI-drivna arbetsflöden driver team mot konkreta steg, snabb feedback och mätbara resultat—vilket minskar frestelsen att över-abstrahera och överkonstruera för tidigt.

Vad vi menar med för tidig abstraktion och överkonstruering

För tidig abstraktion är när du bygger en “generaliserad lösning” innan du sett tillräckligt många verkliga fall för att veta vad som faktiskt bör generaliseras.

Istället för att skriva den enklaste koden som löser dagens problem uppfinner du ett ramverk: extra gränssnitt, konfigurationssystem, plug-in-punkter eller återanvändbara moduler—för att du antar att du kommer att behöva dem senare.

Överkonstruering är den bredare vanan bakom det. Det är att lägga till komplexitet som inte för närvarande "betalar sin hyra": extra lager, mönster, tjänster eller alternativ som inte tydligt minskar kostnad eller risk just nu.

Exempel på vanligt språk

Om din produkt har en prisplan och du bygger en multi-tenant-pris-motor “för säkerhets skull”, är det för tidig abstraktion.

Om en funktion skulle kunna vara en enkel funktion men du delar upp den i sex klasser med fabriker och register för att göra den “extensibel”, är det överkonstruering.

Varför det dyker upp tidigt i projekt

Dessa vanor är vanliga i början eftersom tidiga projekt är fulla av osäkerhet:

- Rädsla för omskrivning: Team oroar sig för att om de bygger något enkelt måste de skriva om det senare.

- Oklara krav: När ingen är säker på vad produkten kommer att bli är det frestande att bygga ett flexibelt skelett som kan “hantera allt”.

- Social press: Ingenjörer vill ofta se framåt och “göra rätt”, även när “rätt” ännu inte går att veta.

Problemet är att “flexibelt” ofta betyder “svårare att ändra”. Extra lager kan göra vardagliga ändringar långsammare, felsökning svårare och onboarding mer smärtsam. Du betalar komplexitetskostnaden omedelbart, medan fördelarna kanske aldrig kommer.

Var AI passar in (och var den inte gör det)

AI-drivna arbetsflöden kan uppmuntra team att hålla arbetet konkret—genom att snabba på prototypning, producera exempel snabbt och göra det lättare att testa antaganden. Det kan minska den ångest som driver spekulativ design.

Men AI ersätter inte ingenjörsbedömning. Den kan generera smarta arkitekturer och abstraktioner på begäran. Ditt jobb är fortfarande att fråga: Vad är det enklaste som fungerar idag, och vilka bevis skulle motivera att lägga till struktur i morgon?

Verktyg som Koder.ai är särskilt effektiva här eftersom de gör det enkelt att gå från en chattprompt till en körbar del av en riktig app (webb, backend eller mobil) snabbt—så team kan validera vad som behövs innan de "framtidssäkrar" något.

Hur AI-arbetsflöden skjuter team mot konkret arbete

AI-assisterad utveckling tenderar att börja med något påtagligt: en specifik bugg, en liten funktion, en datatransformation, en UI-skärm. Denna inramning spelar roll. När arbetsflödet börjar med “här är exakt vad vi behöver” är team mindre benägna att uppfinna en generaliserad arkitektur innan de lärt sig vad problemet faktiskt är.

Konkreta prompts skapar konkret kod

De flesta AI-verktyg svarar bäst när du är specifik: inputs, outputs, begränsningar och ett exempel. En prompt som “designa ett flexibelt notifikationssystem” är vag, så modellen fyller ofta i tomrummen med extra lager—gränssnitt, fabriker, konfiguration—eftersom den inte ser de verkliga avgränsningarna.

Men när prompten är grundad blir svaret grundat:

- Input: “Givet dessa orderstatusar…”

- Output: “Returnera användarvänligt meddelande och CTA…”

- Begränsningar: “Måste vara snabbt; ingen databasuppkoppling; behöver i18n…”

- Exempel: “För

PENDING_PAYMENTvisa …”

Detta skjuter naturligt team mot att implementera ett smalt snitt som fungerar end-to-end. När du kan köra det, granska det och visa det, verkar ni i verkligheten snarare än i spekulation.

“Få det att fungera först” blir standarden

AI-parprogrammering gör iteration billig. Om en första version är lite stökig men korrekt är nästa steg oftast “refaktorera detta” snarare än “designa ett system för alla framtida fall.” Den sekvensen—körbar kod först, förbättring efteråt—minskar impulsen att bygga abstraktioner som inte tjänat in sin komplexitet.

I praktiken får team ett rytm:

- Be om en minimal implementation.

- Testa den mot verkliga exempel.

- Justera baserat på vad som går sönder eller känns konstigt.

- Först då extrahera en hjälpare, modul eller mönster.

Specificitet exponerar saknade krav tidigt

Prompts tvingar dig att ange vad du faktiskt menar. Om du inte kan definiera inputs/outputs tydligt är det en signal att du inte är redo att abstrahera—du upptäcker fortfarande krav. AI-verktyg belönar tydlighet, så de tränar subtilt team att klargöra först och generalisera senare.

Korta feedbackloopar minskar spekulativ design

Snabb feedback ändrar vad “bra ingenjörskap” upplevs som. När du kan prova en idé på minuter slutar spekulativ arkitektur att vara en tröstande filt och börjar se ut som en kostnad du kan undvika.

Loopen: utkast → kör → inspektera → justera

AI-drivna arbetsflöden komprimerar cykeln:

- Utkast: be assistenten om ett litet, fungerande snitt (ett skript, en handler, en query)

- Kör: exekvera det direkt mot verkliga inputs

- Inspektera: titta på output, loggar, edge-cases och hur det fallerar

- Justera: finslipa kod och krav samtidigt

Denna loop belönar konkret framsteg. Istället för att debattera “vi behöver ett plug-in-system” eller “detta måste stödja 12 datakällor” ser teamet vad det nuvarande problemet faktiskt kräver.

Varför hastighet minskar spekulativ arkitektur

För tidig abstraktion uppstår ofta när team fruktar förändring: om förändringar är dyra försöker du förutsäga framtiden och designa för den. Med korta loopar är förändring billig. Det vänder incitamenten:

- Du kan skjuta upp generalisering tills upprepat arbete visar att den behövs.

- Du upptäcker verkliga begränsningar (prestanda, datans form, användarbeteende) tidigt.

- Du slutar bygga “för säkerhets skull” eftersom du kan iterera “just-in-time.”

Ett enkelt exempel: endpoint före ramverk

Säg att du lägger till en intern “exportera till CSV”-funktion. Den överkonstruerade vägen börjar med att designa ett generellt exportramverk, flera format, jobbköer och konfigurationslager.

En snabb-loop-väg är mindre: generera en enkel /exports/orders.csv-endpoint (eller ett engångsskript), kör den på staging-data och inspektera filstorlek, körtid och saknade fält. Om du efter två eller tre export ser upprepade mönster—samma pagineringslogik, delade filter, gemensamma headers—då har en abstraktion förtjänat sin plats eftersom den är grundad i bevis, inte gissningar.

Inkrementella förändringar låter abstraktioner tjäna sina kostnader

Inkrementell leverans förändrar designens ekonomi. När du levererar i små skivor måste varje “trevlig att ha”-lager bevisa att det hjälper just nu—not i en föreställd framtid. Det är där AI-drivna arbetsflöden tyst minskar för tidig abstraktion: AI är bra på att föreslå strukturer, men dessa strukturer är lättast att validera när omfattningen är liten.

Liten omfattning gör AI-förslag testbara

Om du ber en assistent refaktorera en modul eller lägga till en endpoint kan du snabbt kontrollera om dess abstraktion faktiskt förbättrar tydlighet, minskar duplicering eller underlättar nästa förändring. Med ett litet diff är återkopplingen omedelbar: tester går igenom eller misslyckas, koden läses bättre eller sämre, och funktionen beter sig korrekt eller inte.

När omfattningen är stor kan AI-förslag kännas rimliga utan att vara prövbart användbara. Du kanske accepterar ett generaliserat ramverk eftersom det “ser snyggt ut”, bara för att senare upptäcka att det komplicerar verkliga kantfall.

Små komponenter visar vad som bör behållas (och vad som kan tas bort)

Att arbeta inkrementellt uppmuntrar att bygga små, borttagbara komponenter först—hjälpare, adaptrar, enkla datatyper. Efter några iterationer blir det uppenbart vilka delar som återanvänds i flera funktioner (värda att behålla) och vilka som bara behövdes för ett engångsexperiment (säkra att radera).

Abstraktioner blir då en rekordbok över faktisk återanvändning, inte förutsagd återanvändning.

Inkrementell leverans minskar risk vid refaktorering

När förändringar släpps kontinuerligt är refaktorering mindre skrämmande. Du behöver inte “få det rätt” från början eftersom du kan utveckla designen när bevisen samlas. Om ett mönster verkligen förtjänar sin plats—minskar upprepat arbete över flera inkrement—är det en låg-risk, hög-förtroende åtgärd att göra det till en abstraktion.

Detta vänder standarden: bygg den enklaste versionen först, och abstrahera endast när nästa inkrement tydligt drar nytta av det.

Enkel experimentering gynnar enkelhet över “större design”

Behåll flexibilitet utan överbyggnad

Börja på Koder.ai och exportera källkod när du vill ha full kontroll.

AI-drivna arbetsflöden gör experimentering så billig att “bygg ett stort grandios system” slutar vara standard. När ett team kan generera, justera och köra flera tillvägagångssätt under en eftermiddag är det lättare att lära sig vad som faktiskt fungerar än att förutspå vad som kan fungera.

AI gör små varianter nästan gratis

Istället för att lägga dagar på att designa en generaliserad arkitektur kan team be AI skapa några snäva, konkreta implementationer:

- en enkel version som hanterar happy path väl

- en version optimerad för läsbarhet och underhåll

- en version som lägger till en enda extra förmåga (t.ex. ett andra inputformat)

Eftersom det är snabbt att skapa dessa varianter kan teamet utforska avvägningar utan att binda sig till en stor design från början. Målet är inte att leverera alla varianter—utan att få bevis.

Att jämföra varianter belönar naturligt enklare lösningar

När du kan ställa två eller tre fungerande alternativ sida vid sida blir komplexiteten synlig. Den enklare varianten uppfyller ofta samma verkliga krav, har färre rörliga delar att felsöka och gör framtida förändringar enklare eftersom det finns mindre dold koppling.

Samtidigt tenderar överkonstruerade alternativ att rättfärdiga sig med hypotetiska behov. Variantsjämförelse är en motgift: om den extra abstraktionen inte ger tydliga, kortsiktiga fördelar framstår den som en kostnad.

Checklista: vad att mäta när du jämför alternativ

När du kör lätta experiment, kom överens om vad “bättre” betyder. En praktisk checklista:

- Tid till första fungerande resultat: Hur lång tid tills det klarar grundscenarion?

- Implementationskomplexitet: Filer/moduler påverkade, antal introducerade begrepp och hur många “regler” en kollega måste komma ihåg.

- Kostnad för ändring: Hur svårt är det att lägga till ett nytt krav (det mest sannolika nästa, inte en avlägsen fantasi)?

- Felmod: Vad går sönder, hur illa och hur lätt upptäcks det (tydliga fel vs tyst felaktig output).

- Operativ risk: Nya beroenden, konfigurationsyta och ställen där produktionsbeteendet kan förändras.

- Testbarhet: Hur lätt går det att skriva ett litet set tester som förklarar beteendet.

Om en mer abstrakt variant inte vinner på minst en eller två av dessa mått är den enklaste fungerande lösningen vanligtvis rätt satsning—for nu.

AI hjälper till att klargöra krav innan du abstraherar

För tidig abstraktion börjar ofta med en mening som: “Vi kanske behöver detta senare.” Det skiljer sig från: “Vi behöver detta nu.” Den första är en gissning om framtida variation; den andra är en begränsning du kan verifiera idag.

AI-drivna arbetsflöden gör den skillnaden svårare att ignorera eftersom de är bra på att omsätta vaga samtal till tydliga uttalanden du kan granska.

Omvandla tvetydighet till ett skriftligt avtal (utan att överengagera)

När en funktionsförfrågan är vag tenderar team att “framtidssäkra” genom att bygga ett generellt ramverk. Använd istället AI för att snabbt producera en enkel kravöversikt på en sida som skiljer vad som är verkligt från vad som är föreställt:

- Vad vi vet (nuvarande begränsningar): målgrupper, stödjade plattformar, prestandaförväntningar, nödvändiga integrationer.

- Vad vi antar: “Användare kommer ha flera konton,” “vi stödjer 10 lokaler,” “prisnivåer kommer finnas.”

- Vad vi inte vet än: kantfall, juridiska begränsningar, skalning, migrationsbehov.

Denna enkla uppdelning förändrar ingenjörsdialogen. Du slutar designa för en okänd framtid och börjar bygga för en känd nutid—samtidigt som du håller en synlig lista över osäkerheter att återkomma till.

Koder.ai:s Planning Mode passar väl här: du kan omvandla en vag förfrågan till en konkret plan (steg, datamodell, endpoints, UI-tillstånd) innan du genererar implementation—utan att binda dig till en svällande arkitektur.

Ett lättviktigt “framtidsvänligt” tillvägagångssätt

Du kan fortfarande lämna utrymme för utveckling utan att bygga ett djupt abstraktionslager. Föredra mekanismer som är lätta att ändra eller ta bort:

- Feature flags för att skicka en smal version och lära från verklig användning.

- Konfiguration för värden som varierar (timeouts, trösklar, text) istället för polymorfa system.

- Små ext-punkter (ett gränssnitt, en hook, ett event) endast där variation redan är sannolik.

En bra regel: om du inte kan namnge de två nästa konkreta variationerna, bygg inte ramverket. Skriv ned de misstänkta variationerna som “osäkerheter,” leverera den enklaste fungerande vägen och låt verklig feedback motivera abstraktionen senare.

Om du vill formalisera vanan, fånga dessa anteckningar i din PR-mall eller i ett internt “antaganden”-dokument som refereras från ärendet (t.ex. /blog/engineering-assumptions-checklist).

Tester och exempel visar onödig generalisering

En vanlig orsak till överkonstruering är att team designar för föreställda scenarier. Tester och konkreta exempel vänder på det: de tvingar dig att beskriva verkliga inputs, verkliga outputs och verkliga felmod. När du väl skrivit ner det blir generiska abstraktioner ofta mindre användbara—och dyrare—än en liten, tydlig implementation.

Hur AI identifierar kantfall (utan att uppfinna arkitektur)

När du ber en AI-assistent hjälpa dig skriva tester driver den dig naturligt mot specificitet. Istället för “gör det flexibelt” får du frågor som: Vad returnerar funktionen när listan är tom? Vad är maxvärdet? Hur representerar vi ett ogiltigt tillstånd?

Denna frågaform är värdefull eftersom den hittar kantfall tidigt, medan du fortfarande bestämmer vad funktionen verkligen behöver. Om dessa kantfall är sällsynta eller utanför scope kan du dokumentera dem och gå vidare—utan att bygga en abstraktion “för säkerhets skull.”

Att skriva tester först visar om en abstraktion behövs

Abstraktioner förtjänar sin plats när flera tester delar samma setup eller beteendemönster. Om din testsuite bara har ett eller två konkreta scenarier är det oftast ett tecken på att skapa ett ramverk eller plugin-system optimerar för hypotetiskt framtida arbete.

En enkel tumregel: om du inte kan uttrycka åtminstone tre olika beteenden som behöver samma generaliserade gränssnitt är din abstraktion antagligen för tidig.

En mini-mall för praktiska testfall

Använd denna lättviktiga struktur innan du når efter “generaliserad” design:

- Happy path: Typisk input → förväntad output.

- Gräns: Min/max-värden, tomma samlingar, begränsningar (t.ex. 0, 1, 1000).

- Fel: Ogiltig input, saknade beroenden, timeouts, behörighetsfel → förväntat fel eller fallback.

När dessa är skrivna vill koden ofta vara rak. Om upprepning dyker upp i flera tester är det din signal att refaktorera—inte din utgångspunkt.

Synliga underhållskostnader avskräcker överkonstruering

Minska kostnad medan du lär

Dela det du bygger med Koder.ai och tjäna krediter för innehåll eller rekommendationer.

Överkonstruering gömmer sig ofta bakom goda intentioner: “Vi kommer behöva detta senare.” Problemet är att abstraktioner har återkommande kostnader som inte syns i det första implementationsärendet.

Den verkliga räkningen för en abstraktion

Varje nytt lager du introducerar skapar vanligtvis återkommande arbete:

- API-ytan: fler metoder, parametrar och kantfall att stödja (och hålla bakåtkompatibla).

- Dokumentation och exempel: onboarding kräver förklaring av abstraktionen, inte bara funktionen.

- Migrationer: när annan kod beror på ett generaliserat gränssnitt kräver ändringar adaptrar, deprecations och release notes.

- Testmatris: “generisk” kod ökar scenarion—flera implementationer, fler mockar, fler integrationspunkter.

AI-drivna arbetsflöden gör dessa kostnader svårare att ignorera eftersom de snabbt kan lista vad du skriver upp dig för.

Använd AI för att uppskatta komplexitet: räkna rörliga delar

En praktisk prompt är: “Lista rörliga delar och beroenden som denna design introducerar.” En bra AI-assistent kan bryta ner planen i konkreta punkter som:

- nya moduler/paket

- publika gränssnitt och versionsförväntningar

- databaschemaändringar och migrationssteg

- cross-service-anrop och felmod

- nya konfigurationsflaggor, behörigheter eller köer

Att se den listan bredvid en enklare direkt implementation gör "ren arkitektur"-argument till en tydligare avvägning: vill du underhålla åtta nya koncept för att undvika en duplicering som kanske aldrig inträffar?

En "komplexitetsbudget" för att hålla arbetet ärligt

En lättviktig policy: begränsa antalet nya begrepp per feature. Till exempel, tillåt högst:

- 1 nytt publikt API

- 1 ny delad abstraktion (gränssnitt/bas-klass)

- 1 ny datamodell/tabell

Om featuret överskrider budgeten, krävs en motivering: vilken framtida förändring möjliggör detta, och vilka bevis finns att den är nära förestående? Team som använder AI för att skriva denna motivering (och förutse underhållsarbete) tenderar att välja mindre, reversibla steg—eftersom de återkommande kostnaderna syns innan koden skickas.

När AI kan driva dig åt fel håll (och hur du förhindrar det)

AI-drivna arbetsflöden leder ofta team mot små, testbara steg—men de kan också göra motsatsen. Eftersom AI är bra på att snabbt producera “kompletta” lösningar kan den ha en tendens att defaulta till bekanta mönster, lägga till extra struktur eller generera scaffolding du inte bad om. Resultatet kan bli mer kod än du behöver, tidigare än du behöver den.

Hur AI av misstag uppmuntrar överkonstruering

En modell belönas ofta (av mänskligt omdöme) för att låta grundlig. Det kan översättas till extra lager, fler filer och generaliserade designer som ser professionella ut men inte löser ett verkligt, aktuellt problem.

Vanliga varningssignaler inkluderar:

- Nya abstraktioner utan konkret användningsfall (t.ex. “för framtida flexibilitet”)

- Extra lager: service → manager → adapter → factory, när en funktion skulle räcka

- Generiska gränssnitt med bara en implementation

- Plugin-system, event-bussar eller dependency-injection-setup inför tidigt

- Ett “ramverk inom ett ramverk” skapat för att standardisera något du inte upprepat än

Motåtgärder som håller AI-output jordnära

Behandla AI som snabba händer, inte ett arkitekturmöte. Några begränsningar ger mycket:

- Begränsa prompts till nuet. Be om den minsta förändring som uppfyller dagens krav, och förbjud nya mönster om det inte är nödvändigt.

- Kräv riktiga exempel. Innan du accepterar en abstraktion, be om 2–3 konkreta call sites (eller användarflöden) och säkerställ att abstraktionen förenklar dem.

- Begränsa arkitekturändring per iteration. Tillåt bara en strukturell ändring åt gången (t.ex. “introducera en ny modul” eller “inga nya lager i denna PR”).

- Granska för borttagbarhet. Om det vore lätt att ta bort det nya lagret utan att påverka beteende är det sannolikt inte motiverat.

Ett enkelt råd: låt inte AI generalisera tills din kodbas uppvisar upprepad smärta.

Ett praktiskt beslutsramverk: Bygg först, abstrahera senare

Bevisa appen på mobil

Verifiera flödet i Flutter innan du investerar i en återanvändbar arkitektur.

AI gör det billigt att generera kod, refaktorera och prova alternativ. Det är en gåva—om du använder den för att skjuta upp abstraktion tills den förtjänats.

Steg 1: Börja konkret (optimera för lärande)

Börja med den enklaste versionen som löser dagens problem för en “happy path”. Namnge saker efter vad de gör (inte vad de kan göra senare) och håll API:er snäva. Om du är osäker på om en parameter, ett gränssnitt eller ett plugin-system behövs—leverera utan det.

En hjälpsam regel: föredra duplicering framför spekulation. Duplicerad kod är synlig och lätt att ta bort; spekulativ generalitet gömmer komplexitet i indirektion.

Steg 2: Extrahera senare (optimera för stabilitet)

När funktionen används och förändras, refaktorera med bevis. Med AI-hjälp kan du gå snabbt här: be den föreslå en extraktion, men håll kravet på minimalt diff och läsbara namn.

Om dina verktyg stödjer det, använd säkerhetsnät som gör refaktorer lågriskiga. Till exempel gör Koder.ai:s snapshots och rollback det lättare att experimentera med refaktorer tryggt, eftersom du snabbt kan återställa om den “renare” designen visar sig vara sämre i praktiken.

När abstraktion är motiverad (snabb checklista)

Abstraktion förtjänar sin plats när de flesta av följande är sanna:

- Upprepad logik: samma beteende finns på 2–3 ställen och uppdateringar redan krävt flera ändringar.

- Bevisad variation: du sett verkliga variationer i produktion eller validerade prototyper (inte “vi kanske behöver X någon dag”).

- Tydligt ägarskap: en person/team äger abstraktionen, dess docs och framtida ändringar.

- Stabil gräns: input/output-formen hållit sig konsekvent över minst några iterationer.

- Nettoförenkling: extraktionen minskar total kod och kognitiv belastning, inte bara omorganiserar den.

En enkel ritual: “en vecka senare”-granskningen

Lägg in en kalenderpåminnelse en vecka efter att en feature skickats:

- Öppna diffen igen och lista vad som förändrats sedan releasen.

- Identifiera eventuella copy-paste-ändringar eller återkommande buggar.

- Bestäm ett av tre utfall: behåll konkret, extrahera en liten hjälpare, eller introducera ett delat modul.

Detta håller standarden: bygg först, generalisera sedan bara när verkligheten tvingar dig.

Vad att mäta för att hålla ingenjörskapet lean

Lean engineering är inte en känsla—det är något du kan observera. AI-drivna arbetsflöden gör det enklare att leverera små förändringar snabbt, men du behöver fortfarande signaler för att märka när teamet glider tillbaka in i spekulativ design.

Ett litet set mått som fångar överkonstruering tidigt

Håll koll på några ledande indikatorer som korrelerar med onödig abstraktion:

- Cycle time: tid från “arbete startat” till “mergat och deployat.” När cycle time växer utan tydlig scope-ökning betyder det ofta extra indirektion.

- Diff-storlek: genomsnittliga rader ändrade (eller filer berörda) per change. Stora diffs är svårare att granska och inbjuder generalisering.

- Antal introducerade begrepp: räkna nya moduler/tjänster/paket, nya gränssnitt, nya konfigurationsknappar, nya ramverkslika primitiva.

- Felrate: produktbuggar eller supportärenden per release. Abstraktioner kan dölja kantfall; stigande fel efter “cleanup” är en varningssignal.

- Onboarding-tid: hur lång tid det tar för en ny ingenjör att leverera sin första lilla ändring. Om onboarding blir långsammare kan systemet optimera för elegans framför tydlighet.

Du behöver ingen perfektion—trendlinjer räcker. Granska dessa veckovis eller per iteration och fråga: “Införde vi fler begrepp än produkten krävde?”

Lättviktig dokumentation som förhindrar mystiska abstraktioner

Kräv en kort “varför detta finns”-anteckning när någon introducerar en ny abstraktion (nytt gränssnitt, hjälparlager, internt bibliotek osv.). Håll den till några rader i README eller som en kommentar nära ingångspunkten:

- Vilket konkret problem löste det idag?

- Vilka alternativ provades?

- Vad skulle motivera att ta bort det?

En handlingsplan för att börja

Pilotera ett litet AI-assisterat arbetsflöde för ett team i 2–4 veckor: AI-stödd ärendedelning, AI-assisterade kodgranskningschecklistor och AI-genererade testfall.

I slutet, jämför måtten ovan och gör en kort retro: behåll det som minskade cycle time och onboarding-friktion; rulla tillbaka allt som ökade “antal introducerade begrepp” utan mätbar produktnytta.

Om du söker en praktisk miljö för att köra detta experiment end-to-end kan en vibe-coding-plattform som Koder.ai hjälpa dig förvandla små, konkreta skivor till deploybara appar snabbt (med möjlighet att exportera källkod när du behöver det), vilket förstärker vanan denna artikel argumenterar för: leverera något verkligt, lär och först därefter abstrahera.