Vad den här berättelsen förklarar (och varför det spelar roll)

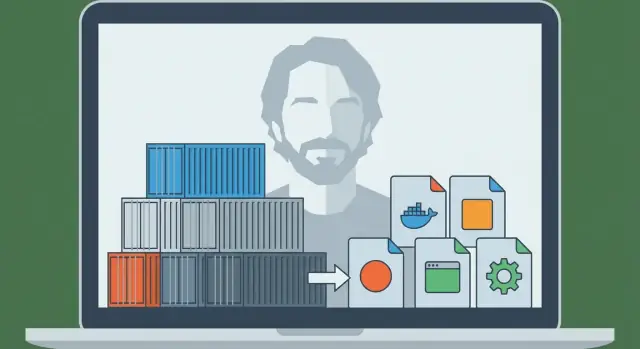

Solomon Hykes är ingenjören som hjälpte till att göra en långvarig idé—att isolera mjukvara så att den körs likadant överallt—till något team faktiskt kunde använda i vardagen. År 2013 blev projektet han presenterade för världen Docker, och det förändrade snabbt hur företag levererar applikationer.

Då var problemet enkelt och välkänt: en app fungerade på en utvecklares laptop, beteedde sig annorlunda på en kollegas maskin och gick sönder igen i staging eller produktion. Dessa “inkonsekventa miljöer” var inte bara irriterande—they bromsade releaser, gjorde buggar svåra att reproducera och skapade oändliga överlämningar mellan utveckling och drift.

Problemet Docker löste (enkelt förklarat)

Docker gav team ett upprepbart sätt att paketera en applikation tillsammans med de beroenden den förväntar sig—så appen kan köra likadant på en laptop, en testserver eller i molnet.

Därför säger folk att containrar blev "standarden för paketering och distribution." Enkelt uttryckt:

- Paketeringsenhet: det du bygger och lagrar (en containerimage)

- Distributionsenhet: det du kör i en miljö (en container)

Istället för att deploya “en ZIP-fil plus en wiki-sida med installationssteg” deployar många team en image som redan innehåller vad appen behöver. Resultatet är färre överraskningar och snabbare, mer förutsägbara releaser.

Vad du får av den här berättelsen

Denna artikel blandar historia med praktiska koncept. Du får veta vem Solomon Hykes är i detta sammanhang, vad Docker introducerade i rätt ögonblick, och de grundläggande mekanismerna—utan krav på djup infrastrukturkunskap.

Du får också se var containrar passar idag: hur de kopplar till CI/CD och DevOps-arbetsflöden, varför orkestrationsverktyg som Kubernetes blev viktiga senare, och vad containrar inte automatiskt löser (särskilt kring säkerhet och förtroende).

I slutändan ska du kunna förklara—klart och tryggt—varför “ship it as a container” blev en standardantagelse för modern applikationsdistribution.

Före Docker: Varför det var så svårt att leverera appar

Innan containrar blev mainstream var det ofta mer smärtsamt att få en applikation från utvecklarens laptop till en server än att skriva själva appen. Team saknade inte talang—de saknade ett pålitligt sätt att flytta “det som fungerar” mellan miljöer.

“Works on my machine” var ett verkligt problem

En utvecklare kunde köra appen perfekt på sin dator och sedan se den krascha i staging eller produktion. Inte för att koden ändrats, utan för att miljön gjorde det. Olika operativsystemsversioner, saknade bibliotek, lätt olika konfigurationsfiler eller en databas med andra default-inställningar kunde alla få samma build att misslyckas.

Beroendekonflikter och oändliga installationsdokument

Många projekt förlitade sig på långa, sköra instruktioner:

- installera detta runtime

- kompilera det systempaketet

- peka en specifik biblioteksversion

- sätt miljövariabler på precis rätt plats

Även när dessa guider var noggrant skrivna åldrades de snabbt. En kollega som uppgraderade ett beroende kunde av misstag förstöra onboardingen för alla andra.

Värre var att två appar på samma server kunde kräva inkompatibla versioner av samma runtime eller bibliotek, vilket tvingade team till obekväma workarounds eller separata maskiner.

Paketering och distribution var separata—och stämde sällan överens

"Paketering" innebar ofta att skapa en ZIP, en tarball eller en installerare. "Distribution" var ett annat set av skript och serversteg: provisionera en maskin, konfigurera den, kopiera filer, starta om tjänster och hoppas att inget annat på servern påverkades.

Dessa två bekymmer gick sällan hand i hand. Paketet beskrev inte fullt ut vilken miljö som krävdes, och distributionsprocessen var starkt beroende av att målservern var förberedd "på rätt sätt."

Den saknade biten: en portabel enhet

Team behövde en enda, portabel enhet som kunde resa med sina beroenden och köra konsekvent på laptops, testservrar och produktion. Det trycket—upprepbar setup, färre konflikter och förutsägbar distribution—lade grunden för att containrar skulle bli standarden för att leverera applikationer.

Solomon Hykes och Dockers födelse (översiktlig tidslinje)

Docker började inte som en storslagen plan att "ändra mjukvara för alltid." Det växte fram ur praktiskt ingenjörsarbete lett av Solomon Hykes när han byggde en platform-as-a-service-produkt. Teamet behövde ett upprepbart sätt att paketera och köra applikationer över olika maskiner utan de vanliga "it works on my laptop"-överraskningarna.

Innan Docker blev ett känt namn var behovet enkelt: leverera en app med sina beroenden, kör den pålitligt, och upprepa det för många kunder.

Projektet som blev Docker började som en intern lösning—något som gjorde distributioner förutsägbara och miljöer konsekventa. När teamet insåg att paketerings- och körmekanismen var användbar bortom deras egen produkt släpptes den publikt.

Detta release spelade roll eftersom det förvandlade en privat distributionsmetod till ett delat verktygskedja som hela branschen kunde adoptera, förbättra och standardisera kring.

“Docker” vs. “containrar”: inte samma sak

Det är lätt att blanda ihop dem, men de är olika:

- Containrar är konceptet: isolerade processer som använder OS-nivåfunktioner (som namespaces och cgroups på Linux) för att köra appar med sina beroenden.

- Docker (projektet och senare företaget) var den produktifierade upplevelsen som gjorde containrar tillgängliga för vardagliga utvecklare.

Containrar fanns i olika former före Docker. Det som ändrades var att Docker paketerade arbetsflödet i en utvecklarvänlig uppsättning kommandon och konventioner—builda en image, kör en container, dela den med någon annan.

Viktiga milstolpar som förändrade vardagsarbetet

Några välkända steg fick Docker att gå från “intressant” till “standard”:

- Ett enkelt buildformat (Dockerfile) gjorde paketering som att skriva ett recept istället för att underhålla sköra installationsdokument.

- Ett standardobjekt (imagen) innebar att teamen kunde behandla miljöer som versionshanterade leverabler.

- Enkel delning via registries gjorde "pull and run"-arbetsflöden möjliga över laptops, CI-servrar och produktion.

- Ekosystem och standardiseringsinsatser hjälpte containerimages och runtimes att bli mindre bundna till en leverantör och mer som ett gemensamt branschgränssnitt.

Det praktiska resultatet: utvecklare slutade bråka om hur man replikerar miljöer och började skicka samma körbara enhet överallt.

Containrar 101: Vad de är (och inte är)

Containrar är ett sätt att paketera och köra en applikation så att den beter sig likadant på din laptop, på en kollegas maskin och i produktion. Nyckelidén är isolering utan ett helt nytt operativsystem.

Containrar vs. virtuella maskiner (enkelt tankesätt)

En virtuell maskin (VM) är som att hyra en hel lägenhet: du får din egen dörr, dina egna tjänster och en egen kopia av operativsystemet. Därför kan VM:ar köra olika OS-typer sida vid sida, men de är tyngre och tar längre tid att starta.

En container är mer som att hyra ett låst rum i en delad byggnad: du tar med dina möbler (appkod + bibliotek), men byggnadens tjänster (hostens OS-kärna) är delade. Du får separation mot andra rum, men du startar inte ett helt nytt OS varje gång.

Hur containrar isolerar appar (konceptuellt)

På Linux förlitar sig containrar på inbyggda isoleringsfunktioner som:

- ger processer sin egen "vy" av systemet (så app A inte ser app B:s filer och processer)

- begränsar och räknar resurser som CPU och minne (så en högljudd app inte enkelt kan svälta andra)

Du behöver inte kunna kernel-detaljer för att använda containrar, men det hjälper att veta att de använder OS-funktioner—inte magi.

Varför folk gillar dem

Containrar blev populära eftersom de är:

- Lätta: mindre än VM- images eftersom de inte inkluderar ett fullt OS

- Snabba att starta: ofta sekunder (eller mindre), vilket är bra för skalning och testning

- Konsekventa: samma paketerade runtime minskar "it works on my machine"-problem

Vad containrar inte är

Containrar är inte en säkerhetsgräns automatiskt. Eftersom containrar delar hostens kernel kan en kärnrelaterad sårbarhet potentiellt påverka flera containrar. Det innebär också att du inte kan köra en Windows-container på en Linux-kärna (och vice versa) utan extra virtualisering.

Så: containrar förbättrar paketering och konsekvens—men du behöver fortfarande smart säkerhet, patchning och konfigurationsrutiner.

Docker-modellen: Dockerfile, image, container

Docker lyckades delvis eftersom det gav team ett enkelt tankesätt med tydliga "delar": en Dockerfile (instruktioner), en image (det byggda artefaktet) och en container (den körande instansen). När du förstår den kedjan börjar resten av Docker-ekosystemet att falla på plats.

Dockerfile: ett upprepbart recept

En Dockerfile är en textfil som beskriver hur man bygger din applikationsmiljö steg för steg. Tänk på den som ett matlagningsrecept: det matar ingen själv, men talar om exakt hur man producerar samma rätt varje gång.

Typiska Dockerfile-steg inkluderar: välja en bas (som ett språkruntime), kopiera in din appkod, installera beroenden och deklarera kommandot som ska köras.

Image vs. container: mall vs. körande app

En image är det byggda resultatet av en Dockerfile. Den är ett paketat snapshot av allt som behövs för att köra: din kod, beroenden och konfigurationsdefaults. Den är inte "levande"—mer som en förseglad låda du kan skicka runt.

En container är vad du får när du kör en image. Det är en levande process med sitt eget isolerade filsystem och inställningar. Du kan starta den, stoppa den, starta om den och skapa flera containers från samma image.

Lager och cache: varför builds kan vara snabba

Images byggs i lager. Varje instruktion i en Dockerfile skapar vanligtvis ett nytt lager, och Docker försöker återanvända ("cacha") lager som inte ändrats.

Enkelt uttryckt: om du bara ändrar din applikationskod kan Docker ofta återanvända lager som installerade OS-paket och beroenden, vilket gör ombyggen mycket snabbare. Detta uppmuntrar också återanvändning mellan projekt—många images delar vanliga baslager.

Ett litet end-to-end-flöde

Så här ser "recept → artefakt → körande instans"-flödet ut:

FROM node:20-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

CMD ["node", "server.js"]

- Dockerfile: instruktionerna ovan

- Bygg en image:

docker build -t myapp:1.0 .

- Kör en container:

docker run --rm -p 3000:3000 myapp:1.0

Detta är det kärnargument Docker populariserade: om du kan bygga imagen kan du köra samma sak pålitligt—på din laptop, i CI eller på en server—utan att skriva om installationssteg varje gång.

Från laptop till team: registries och delning av images

Behåll full kontroll över källkoden

Exportera hela källkoden så att ditt team kan köra den i er egen pipeline.

Att köra en container på din laptop är användbart—men det är inte genombrottet. Den verkliga förändringen kom när team kunde dela exakt samma build och köra den var som helst, utan "it works on my machine"-argument.

Docker gjorde den delningen lika naturlig som att dela kod.

Vad en registry är (enkel förklaring)

En container registry är ett förråd för containerimages. Om en image är den paketerade appen är en registry platsen där du förvarar versioner så att andra personer och system kan hämta dem.

Registries stödjer ett enkelt arbetsflöde:

- Push: ladda upp en image du byggt

- Pull: ladda ner en image någon annan byggt

- Versionera: behåll flera namngivna utgåvor så att du kan rulla fram eller tillbaka

Publika registries (som Docker Hub) gjorde det lätt att komma igång. Men de flesta team behövde snart en registry som matchade deras åtkomstregler och compliance-krav.

Images identifieras vanligtvis som name:tag—t.ex. myapp:1.4.2. Den taggen är mer än en etikett: det är hur människor och automationen är överens om vilken build som ska köras.

Ett vanligt misstag är att förlita sig på latest. Det låter praktiskt, men det är otydligt: "latest" kan ändras utan varning och göra att miljöer glider isär. En deploy kan dra en nyare build än föregående deploy—även om ingen avsiktligen uppgraderade.

Bättre vanor:

- Använd explicit versions-taggar (t.ex.

1.4.2) för releaser

- Tagga gärna även med en commit hash för spårbarhet

- Behandla taggar som en del av din releaseprocess, inte som en eftertanke

Varför privata registries spelar roll för riktiga team

Så fort du delar interna tjänster, betalda beroenden eller företagskod vill du typiskt en privat registry. Den låter dig kontrollera vem som kan pulla eller pusha images, integrera med single sign-on och hålla proprietär mjukvara utanför publika index.

Detta är steget från laptop till team: när images ligger i en registry kan din CI, dina kollegor och dina produktionsservrar alla pulla samma artefakt—och distribution blir upprepbar, inte improviserad.

Varför containrar passar CI/CD så bra

CI/CD fungerar bäst när den kan behandla din applikation som en enda, upprepbar "sak" som går framåt genom stadier. Containrar erbjuder just det: ett paketerat artefakt (imagen) som du kan bygga en gång och köra många gånger, med mycket färre "it worked on my machine"-överraskningar.

Standardiserad lokal utveckling

Före containrar försökte team ofta matcha miljöer med långa installationsguider och delade skript. Docker förändrade standardarbetsflödet: klona repot, bygg en image, kör appen. Samma kommandon tenderar att fungera över macOS, Windows och Linux eftersom applikationen körs inne i containern.

Denna standardisering snabbar upp onboarding. Nya medarbetare lägger mindre tid på att installera beroenden och mer tid på att förstå produkten.

"Build once, run everywhere" i praktiken

Ett starkt CI/CD-upplägg strävar efter ett enda pipeline-resultat. Med containrar är output en image taggad med en version (ofta kopplad till en commit SHA). Den samma imagen promotoras från dev → test → staging → produktion.

Istället för att bygga om appen olika för varje miljö ändrar du konfiguration (som miljövariabler) samtidigt som artefaktet förblir identiskt. Detta minskar drift och gör releaser enklare att debugga.

Containrar kartläggs smidigt till pipeline-steg:

- Build: skapa imagen från en Dockerfile

- Test: kör enhet/integrationstester inne i containern

- Scan: kontrollera imagen för kända sårbarheter och osäkra paket

- Deploy: pusha till en registry, pulla och kör i nästa miljö

Eftersom varje steg körs mot samma paketerade app blir fel mer meningsfulla: ett test som passerade i CI kommer troligen att bete sig likadant efter distribution.

Om du förfinar din process är det värt att sätta enkla regler (taggkonventioner, image-signering, grundläggande scanning) så pipelinen förblir förutsägbar. Du kan bygga utifrån det när teamet växer.

Var detta kopplar till moderna AI-accelererade arbetsflöden: plattformar som Koder.ai kan generera och iterera fullstack-appar (React för webben, Go + PostgreSQL för backend, Flutter för mobil) via en chatgränssnitt—but du behöver fortfarande en pålitlig paketeringsenhet för att gå från "det körs" till "det levereras." Att behandla varje build som en versionerad containerimage håller även AI-accelererad utveckling i linje med samma CI/CD-förväntningar: reproducerbara builds, förutsägbara deploys och rollback-klara releaser.

Körning i skala: varför Kubernetes kom in i bilden

Gör idéer till React snabbt

Skapa en React-webbapp och iterera funktioner utan att göra om setupen varje gång.

Docker gjorde det praktiskt att paketera en app en gång och köra den var som helst. Nästa utmaning dök upp snabbt: team körde inte en container på en laptop—de körde dussintals (sedan hundratals) containrar över många maskiner, med versioner som ändrades konstant.

Då slutade "starta en container" vara det svåra. Det svåra blev att hantera en flotta: bestämma var varje container ska köras, hålla rätt antal kopior online och återhämta sig automatiskt när något går fel.

Varför orkestratorer dök upp

När du har många containrar över många servrar behöver du ett system som kan koordinera dem. Det är vad containerorkestratorer gör: de behandlar din infrastruktur som en pool resurser och jobbar kontinuerligt för att hålla applikationerna i önskat tillstånd.

Kubernetes blev det vanligaste svaret på detta behov (om än inte det enda). Det erbjuder ett gemensamt set begrepp och API:er som många team och plattformar standardiserat kring.

Docker vs. orkestrering: olika jobb

Det hjälper att separera ansvar:

- Docker (och liknande verktyg) fokuserar på att bygga containerimages och köra containrar på en enda maskin.

- Kubernetes fokuserar på att köra containrar i skala: över flera maskiner, availability zones och under rullande uppdateringar.

Kärnidéerna Kubernetes bidrog med

Kubernetes introducerade (och populariserade) några praktiska möjligheter team behövde när containrar flyttade bortom en single host:

- Schemaläggning: placera containrar på lämpliga maskiner baserat på CPU/minne och constraints.

- Skalning: öka eller minska antalet körande kopior efter belastning.

- Service discovery och lastbalansering: ge containrar stabila sätt att hitta varandra även när IP:er och instanser förändras.

- Självläkning: starta om kraschar, ersätta ohälsosamma instanser och schemalägga om arbete när en maskin fallerar.

Kort sagt: Docker gjorde enheten portabel; Kubernetes gjorde den hanterbar—förutsägbart och kontinuerligt—när många enheter var i rörelse.

Hur containrar förändrade applikationsarkitektur

Containrar förändrade inte bara hur vi deployar mjukvara—de uppmuntrade också team att designa mjukvara annorlunda.

"Microservices blev lättare att leverera" (utan att förbjuda monoliter)

Före containrar innebar att dela upp en app i många små tjänster ofta att man multiplicerade operations-smärtan: olika runtimes, konflikter i beroenden och komplicerade deployskript. Containrar minskade det motståndet. Om varje tjänst levereras som en image och körs på samma sätt blir det mindre riskfyllt att skapa en ny tjänst.

Samtidigt fungerar containrar också bra för monoliter. En monolit i en container kan vara enklare än en halvfärdig microservices-migration: en deploybar enhet, en uppsättning loggar, en skalningsspak. Containrar tvingar inte ett stilval—de gör flera stilar mer hanterbara.

Standardgränssnitt blev normen

Containerplattformar uppmuntrade appar att bete sig som väluppfostrade "black boxes" med förutsägbara in- och utgångar. Vanliga konventioner inkluderar:

- Portar: appen lyssnar på en känd port och plattformen dirigerar trafiken.

- Miljövariabler: konfiguration injiceras vid körning, inte bakad i koden.

- Volymer: persistenta data mountas, vilket gör containern lättare att ersätta.

Dessa gränssnitt gjorde det lättare att byta versioner, rulla tillbaka och köra samma app över laptop, CI och produktion.

Nya mönster (och nya frestelser)

Containrar populariserade återanvändbara byggstenar som sidecars (en hjälpkontainer vid sidan av huvudappen för logging, proxies eller certifikat). De förstärkte också riktlinjen om en process per container—inte en hård regel, men ett hjälpsamt default för tydlighet, skalning och felsökning.

Huvudfällan är överdriven uppdelning. Bara för att du kan göra allt till en tjänst betyder det inte att du bör. Om en "microservice" ökar koordinations-, latenstid- och deploykostnader mer än den avlastar, behåll det tillsammans tills det finns en tydlig gräns—som olika skalningsbehov, ägarskap eller felisolering.

Säkerhet och förtroende: vad containrar inte löser automatiskt

Containrar gör det enklare att leverera mjukvara, men de gör den inte magiskt säkrare. En container är fortfarande bara kod plus beroenden, och den kan vara felkonfigurerad, föråldrad eller rentav illvillig—särskilt när images hämtas från internet med minimal granskning.

Förtroende börjar med image-proveniens

Om du inte kan svara på "Var kom den här imagen ifrån?" tar du redan en risk. Team rör sig ofta mot en tydlig kedja av ägandeskap: bygg images i kontrollerad CI, signera eller attestera vad som byggts och behåll en logg över vad som fanns i imagen (beroenden, base image-version, buildsteg).

Det är också där SBOMs (Software Bills of Materials) hjälper: de gör innehållet i din container synligt och granskningsbart.

Skanning är nästa praktiska steg. Skanna images regelbundet för kända sårbarheter, men betrakta resultaten som indata till beslut—inte som en garanti för säkerhet.

Minsta privilegier och hemligheter: vanliga fallgropar

Ett vanligt misstag är att köra containrar med för vida rättigheter—root som standard, extra Linux-capabilities, host networking eller privileged mode "eftersom det funkar." Var och en av dessa vidgar skadeomfånget om något går fel.

Hemligheter är en annan fallgrop. Miljövariabler, inbakade konfigurationsfiler eller committade .env-filer kan läcka credentials. Föredra secret stores eller orchestrator-hanterade secrets och rotera dem som om exponering var oundviklig.

Runtime-risker som förbises

Även "rena" images kan vara farliga i körning. Håll koll på exponerade Docker-sockets, överdrivet generösa volymmounts och containrar som når interna tjänster de inte behöver.

Kom också ihåg: patchning av host och kernel är fortfarande viktigt—containrar delar kärnan.

Ett enkelt checklist-tänk

Tänk i fyra faser:

- Bygg: kontrollerade builds, SBOMs, skanna, minimera base images

- Lagra: privata registries, åtkomstkontroll, immutability-policies

- Kör: minsta privilegier, nätverksbegränsningar, resursbegränsningar, ingen hemlighetsspridning

- Övervaka: loggar, larm, anomalidetektion, snabb rebuild-och-redeploy

Containrar minskar friktion—men förtroende måste förtjänas, verifieras och underhållas kontinuerligt.

Vanliga misstag och hur man undviker dem

Bygg ett Go + Postgres API

Generera en Go-API med PostgreSQL och håll koden redo för CI och containrar.

Docker gör paketering förutsägbar, men bara om du använder det med lite disciplin. Många team kör in i samma potthål—och skyller sedan på "containrar" för vad som egentligen är processproblem.

Antimönster som bromsar alla

Ett klassiskt misstag är att bygga alldeles för stora images: använda fullständiga OS-bilder, installera byggverktyg du inte behöver i runtime och kopiera hela repot (inklusive tester, dokumentation och node_modules). Resultatet är långsamma nedladdningar, långsam CI och större attackyta för säkerhetsproblem.

Ett annat vanligt problem är långsamma, cache-brytande builds. Om du kopierar hela källträdet innan du installerar beroenden tvingas du ofta återinstallera beroenden för varje liten kodändring.

Slutligen använder team ofta oklara eller flytande taggar som latest eller prod. Det gör rollbacks smärtsamma och förvandlar deploys till gissningsarbete.

"Det fungerar lokalt men inte i prod": de verkliga orsakerna

Det brukar bero på skillnader i konfiguration (saknade miljövariabler eller hemligheter), nätverk (olika hostnames, portar, proxies, DNS) eller lagring (data skrivs till containerns filsystem istället för en volym, eller filrättigheter som skiljer mellan miljöer).

Praktiska åtgärder du kan göra idag

Använd slim base images när det går (eller distroless om teamet är redo). Pinna versioner för base images och viktiga beroenden så builds blir upprepbara.

Använd multi-stage builds för att hålla compilationsverktyg utanför slutimagen:

FROM node:20 AS build

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

RUN npm run build

FROM node:20-slim

WORKDIR /app

COPY --from=build /app/dist ./dist

CMD ["node","dist/server.js"]

Tagga också images med något spårbart, som en git-SHA (och gärna en människovänlig release-tagg).

När man inte ska containerisera

Om en app är extremt enkel (en enda statisk binär, körs sällan, inga skalningsbehov) kan containrar lägga till onödig overhead. Legacy-system med starkt OS-koppling eller specialiserade hårdvarudrivrutiner kan också vara dåliga kandidater—ibland är en VM eller managed service det renare valet.

Vad "standard" betyder idag—och vad du bör göra härnäst

Containrar blev standarden eftersom de löste ett mycket specifikt, upprepbart problem: att få samma app att köra samma sätt på laptops, testservrar och produktion. Att paketera appen och dess beroenden tillsammans gjorde releaser snabbare, rollbacks säkrare och överlämningar mellan team mindre sköra.

Lika viktigt: containrar standardiserade arbetsflödet: bygg en gång, skeppa, kör.

Vad "standard" betyder i praktiken

"Standard" betyder inte att allt körs i Docker överallt. Det betyder att de flesta moderna leveranspipelines betraktar en containerimage som det primära artefaktet—mer än en zip-fil, VM-snapshot eller en uppsättning manuella installationssteg.

Detta standardupplägg brukar inkludera tre delar som fungerar tillsammans:

- Images: immutabla byggoutputs taggade med versioner (och helst en commit SHA).

- Registries: en delad plats för att lagra och hämta images (privat eller publik), så team kan återanvända samma artefakt över miljöer.

- Orkestrering: en schemaläggare (ofta Kubernetes) som kör containrar pålitligt, ersätter felande instanser och skalar upp/ner.

Nästa steg du kan ta den här veckan

Börja smått och fokusera på upprepbarhet.

- Lär dig Dockerfile-grunderna: håll images minimala, pinna base image-versioner och strukturera lager så ombyggen blir snabba. Lägg till en

.dockerignore tidigt.

- Använd en registry med eftertanke: publicera images med meningsfulla taggar (t.ex.

1.4.2, main, sha-…) och definiera vem som får pusha respektive pull.

- Inför CI-buildregler: bygg images i CI, kör tester i containerkontext och promota samma image genom staging till produktion (inga ombyggnader per miljö).

Om du experimenterar med snabbare sätt att bygga mjukvara (inklusive AI-assisterade metoder) behåll samma disciplin: versionera imagen, lagra den i en registry och gör deployment genom att promota det enda artefaktet framåt. Det är en av anledningarna till att team som använder Koder.ai fortfarande gynnas av container-first delivery—snabb iteration är bra, men reproducerbarhet och rollback-klarhet gör det säkert.

Behåll ett balanserat perspektiv

Containrar minskar "it works on my machine"-problem, men de ersätter inte goda operationella vanor. Du behöver fortfarande övervakning, incidenthantering, secrets-hantering, patchning, åtkomstkontroll och tydligt ägarskap.

Behandla containrar som en kraftfull paketeringsstandard—inte en genväg runt ingenjörsdisciplin.