29 aug. 2025·6 min

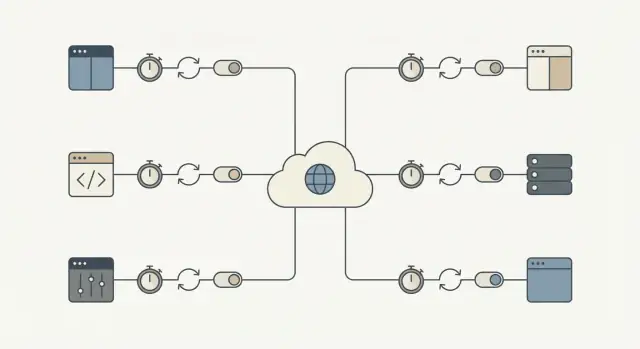

Säker tredjeparts‑API‑integration: återförsök, timeouter, kretsbrytare

Säker tredjeparts‑API‑integration som håller appen igång vid driftstörningar. Lär dig om timeouter, återförsök, kretsbrytare och snabba kontroller.

Varför tredjeparts-API:er kan blockera dina kärnflöden

Ett tredjeparts-API kan falla på sätt som inte ser ut som ett tydligt "nere"-läge. Det vanligaste problemet är slöhet: förfrågningar hänger sig, svar kommer sent och din app fortsätter att vänta. Om dessa anrop ligger på den kritiska vägen bygger en liten störning utanför er kontroll upp köer inuti systemet.

Så blir en lokal fördröjning snabbt ett fullständigt driftstopp. Trådar eller workers fastnar i väntan, köer växer, databastransaktioner är öppna längre och nya förfrågningar börjar timea ut. Förr eller senare känner även sidor som inte använder det externa API:et av att systemet är överbelastat av väntande arbete.

Konsekvenserna är konkreta. En ostabil identitetsleverantör blockerar registreringar och inloggningar. En betalningsgateway som timeout:ar fryser kassan och lämnar användare osäkra på om de blivit debiterade. Fördröjningar i meddelandetjänster stoppar lösenordsåterställningar och orderbekräftelser, vilket utlöser en andra våg av återförsök och supportärenden.

Målet är enkelt: isolera externa fel så att kärnflödenen fortsätter att röra sig. Det kan betyda att en användare får lägga en order medan du bekräftar betalningen senare, eller att registrering godkänns även om välkomstmailet misslyckas.

Ett praktiskt framgångsmått: när en leverantör är långsam eller nere ska din app fortfarande svara snabbt och tydligt, och påverkansområdet ska vara litet. Till exempel att de flesta kärnförfrågningar fortfarande klarar din normala latensbudget, att fel begränsas till funktioner som verkligen är beroende av det API:et, att användaren ser en tydlig status (köad, väntar, försök igen senare) och att återhämtning sker automatiskt när leverantören är tillbaka.

Feltyper du bör planera för

De flesta fel är förutsägbara, även om tidpunkten inte är det. Namnge dem i förväg så kan du bestämma vad som ska återförsökas, vad som ska stoppas och vad som ska visas för användaren.

Vanliga kategorier:

- Latensspikar (förfrågningar som plötsligt tar 10x längre)

- Transitora server- eller nätverksfel (timeouts, 502/503, anslutningsåterställningar)

- Rate limits och kvotutslagning (429, dagliga tak)

- Auth- och behörighetsproblem (utgångna nycklar, återkallad åtkomst)

- Felaktiga eller överraskande data (saknade fält, fel format, partiella svar)

Inte alla fel betyder samma sak. Transitora problem är ofta värda att återförsöka eftersom nästa anrop kan lyckas (nätverksstörningar, timeouter, 502/503 och vissa 429 efter väntan). Permanenta problem fixar sig sällan själva (ogiltiga autentiseringsuppgifter, felaktiga endpoints, felaktiga förfrågningar, behörighetsavslag).

Att behandla alla fel likadant förvandlar en liten incident till driftstopp. Att återförsöka permanenta fel slösar tid, träffar rate limits snabbare och bygger en backlog som saktar ner allt annat. Att aldrig återförsöka transitora fel tvingar användare att upprepa åtgärder och förlorar arbete som kunde ha slutförts strax senare.

Ge extra uppmärksamhet åt flöden där en paus känns som ett avbrott: kassa, inloggning, lösenordsåterställning och notiser (e-post/SMS/push). En tvåsekunders spik i ett marknadsförings-API är irriterande. En tvåsekunders spik i betalningsautorisering blockerar intäkter.

Ett användbart test är: "Behöver detta anrop slutföras för att användarens huvuduppgift ska bli klar nu?" Om svaret är ja behöver du tajta timeouter, omsorgsfulla återförsök och en tydlig felväg. Om nej, flytta det till en kö och håll appen responsiv.

Timeouter: välj en gräns och håll dig till den

En timeout är den maximala tid du är villig att vänta innan du slutar och går vidare. Utan en tydlig gräns kan en långsam leverantör samla väntande förfrågningar och blockera viktig arbetskraft.

Det hjälper att särskilja två sorters väntan:

- Connect-timeout: hur länge du försöker etablera en anslutning.

- Read-timeout: hur länge du väntar på ett svar efter att anslutningen är upprättad.

Att välja exakta siffror handlar inte om perfektion. Det handlar om att matcha mänsklig tålamodsnivå och ert arbetsflöde.

- Om en användare stirrar på en spinner behöver du vanligtvis ett snabbt svar och en tydlig nästa åtgärd.

- Om det är ett bakgrundsjobb (som att synka fakturor över natten) kan du tillåta mer tid, men det måste ändå ha ett tak så det inte hänger för evigt.

Ett praktiskt sätt att välja timeouter är att utgå från upplevelsen:

- Hur länge kan en användare vänta innan du behöver visa ett tydligt meddelande?

- Om detta anrop misslyckas nu, kan du försöka senare eller använda en fallback?

- Hur många av dessa anrop körs vid peak?

Tradeoffen är verklig. För långa timeouter binder trådar, workers och databasanslutningar. För korta ger falska fel och triggar onödiga återförsök.

Återförsök som inte gör driftstopp värre

Återförsök hjälper när ett fel sannolikt är tillfälligt: en kort nätverksstörning, DNS-hicka eller en enstaka 500/502/503. I sådana fall kan ett nytt försök lyckas och användaren märker inget.

Risken är en återförsöksstorm. När många klienter misslyckas samtidigt och alla försöker igen kan de överbelasta leverantören (och era egna workers). Backoff och jitter förhindrar det.

En återförsöksbudget håller dig ärlig. Håll antalet försök lågt och sätt en tidsbegränsning så att kärnflöden inte fastnar i väntan på någon annan.

Ett säkert standardrecept för återförsök

- Återförsök bara ett fåtal gånger (ofta 1–3 försök totalt, beroende på flöde).

- Använd exponentiell backoff (t.ex. 200 ms, 500 ms, 1 s) plus slumpmässig jitter.

- Sätt en övre gräns för total tid som spenderas på återförsök (ofta några sekunder i användarflöden).

- Använd en per-försök-timeout istället för en lång timeout för alla försök.

Återförsök inte förutsägbara klientfel som 400/422 valideringsfel, 401/403 autentiseringsproblem eller 404. De kommer nästan alltid att misslyckas igen och bara öka belastningen.

En sista skyddsåtgärd: återförsök skrivoperationer (POST/PUT) endast när du har idempotens på plats, annars riskerar du dubbla debiteringar eller dubbletter.

Idempotens: gör återförsök säkra i praktiken

Idempotens betyder att du säkert kan köra samma förfrågan flera gånger och ändå få samma slutresultat. Det är viktigt eftersom återförsök är normala: nätverk fallerar, servrar startar om och klienter time:ar ut. Utan idempotens kan ett "hjälpsamt" återförsök skapa dubbletter och riktiga problem med pengar.

Tänk checkout: betalnings-API:t är långsamt, din app time:ar ut och du försöker igen. Om det första anropet faktiskt lyckades kan återförsöket skapa en andra debitering. Samma risk finns för att skapa en order, starta en prenumeration, skicka ett mejl/SMS, utfärda en återbetalning eller skapa ett supportärende.

Lösningen är att bifoga en idempotensnyckel (eller request-ID) till varje "gör något"-anrop. Den ska vara unik per användaråtgärd, inte per försök. Leverantören (eller din egen tjänst) använder den nyckeln för att upptäcka dubbletter och returnera samma utfall istället för att utföra åtgärden igen.

Behandla idempotensnyckeln som en del av datamodellen, inte som en header du hoppas att ingen glömmer.

Ett mönster som håller i produktion

Generera en nyckel när användaren startar åtgärden (t.ex. när de klickar Betala), och spara den med din lokala post.

Vid varje försök:

- Skicka samma nyckel.

- Spara det slutliga resultatet du fick tillbaka (svar vid framgång, felkod, charge-ID).

- Om du redan har ett registrerat utfall, returnera det utfallet istället för att upprepa åtgärden.

Om du är "leverantören" för interna anrop, tvinga samma beteende server-side.

Kretsbrytare: sluta anropa API:t när det misslyckas

Äg koden du genererar

Generera integrationen och exportera sedan källkoden för granskning och anpassning.

En kretsbrytare är en säkerhetsbrytare. När en extern tjänst börjar misslyckas slutar du anropa den under en kort period istället för att stapla fler förfrågningar som sannolikt kommer att time:a ut.

Kretsbrytare har vanligtvis tre tillstånd:

- Closed: förfrågningar flyter normalt.

- Open: anrop blockeras under ett cooldown-fönster.

- Half-open: efter cooldown tillåts ett begränsat antal testanrop för att kontrollera om tjänsten återhämtat sig.

När brytaren är öppen ska din app göra något förutsägbart. Om en adressvalideringstjänst är nere under registrering, acceptera adressen och markera den för senare granskning. Om en betalningsriskkontroll är nere, köa ordern för manuell granskning eller inaktivera alternativet temporärt och förklara det.

Välj trösklar som matchar användarpåverkan:

- på varandra följande fel (t.ex. 5 fel i rad)

- hög felprocent under ett kort fönster

- många långsamma svar (timeouts)

- specifika statuskoder (upprepade 503)

Håll cooldown-perioderna korta (sekunder till en minut) och begränsa half-open-proverna. Målet är att skydda kärnflödet först och återhämta sig snabbt.

Fallbacks och köer: håll appen användbar

När ett externt API är långsamt eller nere är målet att låta användaren fortsätta. Det betyder att ha en plan B som är ärlig om vad som hände.

Fallbacks: välj en "tillräckligt bra" upplevelse

En fallback är vad appen gör när API:et inte kan svara i tid. Alternativ inkluderar att använda cachedata, byta till ett degraderat läge (göm icke-väsentliga widgets, inaktivera frivilliga åtgärder), be om användarinmatning istället för att anropa API:t (manuell adressinmatning) eller visa ett tydligt meddelande med nästa steg.

Var ärlig: säg inte att något slutförts om det inte gjorde det.

Köer: gör det senare när "nu" inte krävs

Om arbetet inte måste slutföras i användarförfrågan, skjut det till en kö och svara snabbt. Vanliga kandidater: skicka e-post, synka till CRM, generera rapporter och posta analys-händelser.

Misslyckas snabbt för kärnaktioner. Om ett API inte krävs för att slutföra kassan (eller kontoskapande), blockera inte förfrågan. Acceptera ordern, köa det externa anropet och avstäm senare. Om API:t krävs (t.ex. betalningsautorisering), misslyckas snabbt med ett tydligt meddelande och håll inte användaren väntande.

Vad användaren ser bör matcha vad som händer bakom kulisserna: en tydlig status (slutförd, väntande, misslyckad), ett löfte du kan hålla (kvitto nu, bekräftelse senare), ett sätt att försöka igen och en synlig post i UI (aktivitetlogg, väntande-badge).

Rate limits och belastning: undvik självförvållade fel

Rate limits är leverantörens sätt att säga: "Du kan anropa oss, men inte för ofta." Du träffar dem snabbare än du tror: trafikspikar, bakgrundsjobb som startar samtidigt eller en bugg som loopar på fel.

Börja med att kontrollera hur många förfrågningar ni skapar. Batcha när det är möjligt, cacha svar även i 30–60 sekunder när det är säkert, och throttla klientsidan så att appen aldrig får en burst snabbare än leverantören tillåter.

När du får 429 Too Many Requests, behandla det som en signal att sakta ner.

- Respektera Retry-After när det finns.

- Lägg till jitter så att många workers inte försöker samtidigt.

- Begränsa återförsök för 429 så det inte blir oändliga loopar.

- Backa mer aggressivt vid upprepade 429.

- Mät och logga det så du ser mönster innan användarna gör det.

Begränsa också samtidighet. Ett enda arbetsflöde (som att synka kontakter) ska inte konsumera alla worker-platser och svälta kritiska flöden som inloggning eller kassa. Separata pooler eller per-funktion-gränser hjälper.

Steg-för-steg: ett säkert standardrecept för integrationer

Köa arbetet som kan vänta

Flytta icke-kritiska API-anrop till en kö så att användarförfrågningar blir snabba.

Varje tredjepartsanrop behöver en plan för fel. Du behöver inte perfektion. Du behöver förutsägbart beteende när leverantören har en dålig dag.

1) Klassificera anropet (måste-ha vs kan-vänta)

Bestäm vad som händer om anropet misslyckas just nu. En skatteberäkning i kassan kan vara måste-ha. Att synka en marknadsföringskontakt kan oftast vänta. Det här valet styr resten.

2) Sätt timeouter och en återförsöksbudget

Välj timeouter per anropstyp och håll dem konsekventa. Sätt sedan en återförsöksbudget så ni inte fortsätter slå mot ett långsamt API.

- Måste-ha, användaren väntar: kort timeout, 0–1 återförsök.

- Kan-vänta, bakgrundsjobb: längre timeout, några återförsök med backoff.

- Återförsök aldrig för evigt: begränsa total tid per uppgift.

3) Gör återförsök säkra med idempotens och spårning

Om en förfrågan kan skapa något eller debitera pengar, lägg till idempotensnycklar och spara en förfrågningspost. Om ett betalningsanrop time:ar ut ska ett återförsök inte kunna dubbeldebiteras. Spårning hjälper också support att svara: "Gick det igenom?"

4) Lägg till en kretsbrytare och fallback-beteende

När fel spikar, sluta anropa leverantören under en kort period. För måste-ha-anrop: visa en tydlig "försök igen"-väg. För kan-vänta-anrop: köa arbetet och bearbeta senare.

5) Övervaka det grundläggande

Mät latens, felrate och brytarhändelser (öppen/stängd). Larma på uthålliga förändringar, inte enstaka blippar.

Vanliga misstag som förvandlar en liten incident till driftstopp

De flesta API-avbrott börjar små. De blir stora eftersom din app reagerar på det sämsta sättet: den väntar för länge, återförsöker för aggressivt och binder samma workers som håller allt annat igång.

Mönster som orsakar kaskader:

- Återförsök för varje fel, inklusive 4xx-problem som ogiltiga förfrågningar, utgången auth eller saknade behörigheter.

- Mycket långa timeouter "för att vara säker", som tyst konsumerar trådar, DB-anslutningar eller jobbrunners tills kapaciteten är slut.

- Återförsök av skapa-aktioner utan idempotensnycklar, vilket leder till dubbeldebiteringar, dubblettleveranser eller upprepade poster.

- Felkonfigurerade kretsbrytare som aldrig återhämtar sig eller fladdrar öppna/stängda.

- Att behandla partiella avbrott som total fel i stället för att degradera bara den berörda funktionen.

Små fixar förhindrar stora driftstopp: återförsök bara fel som sannolikt är tillfälliga (timeouts, vissa 429, vissa 5xx) och sätt ett lock med backoff och jitter; håll timeouter korta och med avsikt; kräva idempotens för operationer som skapar eller debiterar; och designa för partiella fel.

Snabb checklista innan ni släpper

Designa ärliga fel-lägen

Skapa en tydlig pending- och återförsöks-UX så att användare förstår vad som hände under driftstörningar.

Innan du pushar en integration till produktion, gör en snabb genomgång med ett felsinne. Om du inte kan svara "ja" på ett item, behandla det som en blockerare för utgivning för kärnflöden som registrering, kassa eller meddelandetjänster.

- Tidsgränser är explicita (connect-timeout och read/response-timeout).

- Återförsök är begränsade (liten återförsöksbudget, backoff, jitter och en total tidsgräns).

- Återförsök är säkra för verkliga åtgärder (idempotensnycklar eller tydlig deduplisering).

- Det finns en brytare och en plan B (fallback, degraderat läge eller en kö).

- Du kan se problem tidigt (latens, felrate och beroendehälsa per leverantör och endpoint).

Om en betalningsleverantör börjar time:outa är rätt beteende: "kassan laddar fortfarande, användaren får ett tydligt meddelande och ni hänger inte kvar för alltid", inte "allt hänger tills det time:ar ut."

Exempel: skydda kassan när en leverantör är ostabil

Tänk dig en kassa som anropar tre tjänster: ett betalnings-API för att debitera kortet, ett skatte-API för att beräkna moms och ett e-post-API för att skicka kvittot.

Betalningsanropet är det enda som måste vara synkront. Problem i skatt eller e-post ska inte blockera köpet.

När skatte-API:t är långsamt

Säg att skatte-API:t ibland tar 8–15 sekunder. Om kassan väntar överger användarna sina varukorgar och appen binder workers.

Ett säkrare flöde:

- Sätt en hård timeout (t.ex. 800 ms till 2 s) och misslyckas snabbt.

- Återförsök högst en gång, bara om det är säkert, med jitter.

- Om timeout inträffar, använd en cachead sats eller senaste tabell för köparens region.

- Om ni inte kan använda cachelagrade satser av lagliga skäl, placera ordern som "pending tax" och köa en omräkning.

Resultat: färre övergivna varukorgar och färre fastnade ordrar när skatteleverantören är långsam.

När e-post-API:t är nere

Kvittot via e-post är viktigt, men det får aldrig blockera betalningscapturen. Om e-post-API:t misslyckas ska kretsbrytaren öppna efter några snabba fel och stoppa anrop under en kort cooldown.

I stället för att skicka e-post inline, lägg ett "skicka kvitto"-jobb i en kö med en idempotensnyckel (t.ex. order_id + email_type). Om leverantören är nere gör kön återförsök i bakgrunden och kunden ser ändå ett lyckat köp.

Resultat: färre supportärenden från saknade bekräftelser och inga tappade intäkter eftersom kassan inte misslyckas av icke-betalningsskäl.

Nästa steg: rulla ut detta i hela appen

Välj ett arbetsflöde som skadar mest när det bryter (kassa, registrering, fakturering) och gör det till er referensintegration. Kopiera sedan samma standardinställningar över allt.

En enkel utrullningsordning:

- Sätt timeouter och misslyckas snabbt med ett tydligt fel.

- Lägg till återförsök med backoff, men bara för återförsökningsbara fel.

- Lägg till idempotens så återförsök inte dubbeldebiterar eller skapar dubbletter.

- Lägg till kretsbrytare så en dålig leverantör inte kan blockera ditt kärnflöde.

Skriv ner era standarder och håll dem tråkiga: en connect-timeout, en request-timeout, max antal återförsök, backoff-intervall, brytar-cooldown och regler för vad som är återförsökningsbart.

Kör en felövning innan ni expanderar till nästa flöde. Tvinga timeouter (eller blockera leverantören i en testmiljö), och kontrollera att användaren ser ett användbart meddelande, att fallback-vägar fungerar och att köade återförsök inte staplas upp för alltid.

Om ni bygger nya produkter snabbt är det värt att göra dessa pålitlighetsstandarder till en återanvändbar mall. För team som använder Koder.ai (koder.ai) betyder det ofta att definiera timeout, återförsök, idempotens och brytarregler en gång och sedan applicera samma mönster i nya tjänster när ni genererar och itererar.