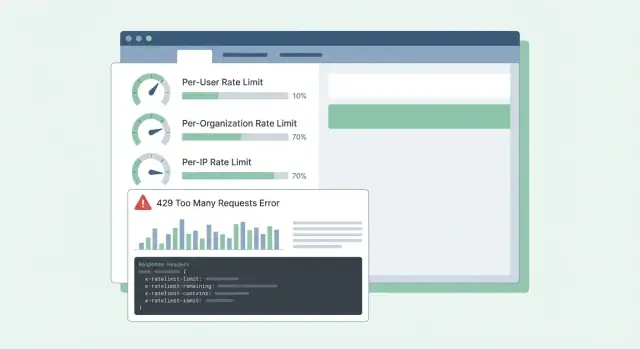

Varför kunder blir förvirrade av begränsningar\n\nRate limits och kvoter låter lika, så folk behandlar dem ofta som samma sak. En rate limit är hur snabbt du kan anropa ett API (requests per sekund eller per minut). En kvot är hur mycket du får använda över en längre period (per dag, per månad eller per faktureringscykel). Båda är normala, men de upplevs som slumpmässiga när reglerna inte syns.\n\nDet klassiska klagomålet är: “det fungerade igår.” Användning är sällan jämn. En kort spike kan putta någon över gränsen även om deras dagliga total ser okej ut. Föreställ dig en kund som kör en rapport en gång per dag, men idag gör jobbet omförsök efter en timeout och gör 10× fler anrop på 2 minuter. API:t blockerar dem, och allt de ser är ett plötsligt fel.\n\nFörvirringen blir värre när felmeddelanden är vaga. Om API:t returnerar 500 eller ett generiskt meddelande antar kunder att din tjänst ligger nere, inte att de nått en gräns. De öppnar brådskande ärenden, bygger workarounds eller byter leverantör. Även 429 Too Many Requests kan vara frustrerande om det inte säger vad man ska göra härnäst.\n\nDe flesta SaaS-API:er begränsar trafik av två olika skäl:\n\n- Stoppa missbruk: skydda systemet från scraping, brute force eller runaway-skript.\n- Forma normal användning: håll prestanda stabil för alla, särskilt under peak-tider.\n\nAtt blanda dessa mål leder till dåliga designval. Abuse-kontroller är ofta per-IP eller per-token och kan vara hårda. Normal användningsformning är vanligtvis per-användare eller per-organisation och bör komma med tydlig vägledning: vilken gräns som träffades, när den återställs och hur man undviker att träffa den igen.\n\nNär kunder kan förutsäga begränsningar planerar de runt dem. När de inte kan det känns varje spike som ett trasigt API.\n\n## Bestäm vad du skyddar\n\nRate limits är inte bara en gaspedal. De är ett säkerhetssystem. Innan du väljer siffror, var tydlig med vad du försöker skydda, eftersom varje mål leder till olika gränser och olika förväntningar.\n\nTillgänglighet är vanligtvis först. Om några klienter kan spike trafik och pressa ditt API in i timeouts, lider alla. Begränsningar här bör hålla servrarna responsiva vid burstar och misslyckas snabbt istället för att låta requests bygga upp köer.\n\nKostnad är den tysta drivaren bakom många API:er. Vissa requests är billiga, andra är dyra (LLM-anrop, filbearbetning, skrivningar, betalda tredjepartssökningar). På en plattform som Koder.ai kan en enda användare trigga många modellanrop via chattbaserad appgenerering. Gränser som spårar dyra åtgärder kan förhindra överraskande räkningar.\n\nMissbruk ser annorlunda ut än hög legitim användning. Credential stuffing, token-gissning och scraping visar ofta som många små requests från ett snävt set av IP:er eller konton. Här vill du ha strikta gränser och snabb blockering.\n\nRättvisa spelar roll i multi-tenant-system. En bullrig kund ska inte försämra för alla andra. I praktiken betyder det ofta lager av kontroller: en burst-guard för att hålla API:t friskt minut för minut, en kostnadsguard för dyra endpoints eller åtgärder, en abuse-guard fokuserad på auth och misstänkta mönster, och en fairness-guard så att en org inte tränger ut andra.\n\nEtt enkelt test hjälper: välj en endpoint och fråga, “Om den här requesten ökar 10×, vad går sönder först?” Svaret talar om vilket skyddsmål som ska prioriteras och vilken dimension (användare, org, IP) som bör bära gränsen.\n\n## Välj rätt begränsningsdimensioner\n\nDe flesta team börjar med en gräns och upptäcker senare att den skadar fel personer. Målet är att välja dimensioner som matchar verklig användning: vem ringer, vem betalar och vad som ser ut som missbruk.\n\nVanliga dimensioner i SaaS ser ut så här:\n\n- Per användare: stoppar en tung slutanvändare från att sakta ner alla andra i samma konto.\n- Per org/workspace: sätter ett tydligt tak på en tenants totala användning (ofta vad faktureringsplaner faktiskt säljer).\n- Per IP: fångar bots, credential stuffing och misskonfigurerade klienter som hamrar från en adress.\n- Per API-nyckel/token: användbart för partners och integrationer där “användare” inte är meningsfullt eller är delat.\n\nPer-användare-gränser handlar om rättvisa inom en tenant. Om en person kör en stor export, bör de känna av sänkningen mer än resten av teamet.\n\nPer-org-gränser handlar om budget och kapacitet. Även om tio användare kör jobb samtidigt, ska inte orgen spike till en nivå som bryter din tjänst eller dina prissättningsantaganden.\n\nPer-IP-gränser är bäst som ett säkerhetsnät, inte ett faktureringsverktyg. IP:er kan delas (kontors-NAT, mobiloperatörer), så håll dessa gränser generösa och lita på dem främst för att stoppa uppenbart missbruk.\n\nNär du kombinerar dimensioner, bestäm vilken som “vinner” när flera gränser gäller. En praktisk regel är: avvisa requesten om någon relevant gräns överskrids, och returnera den mest handlingsbara orsaken. Om ett workspace är över sin org-kvot, skyll inte på användaren eller IP:n.\n\nExempel: ett Koder.ai-workspace på Pro-plan kan tillåta en stadig flöde av build-requests per org, samtidigt som en enskild användare begränsas från att skjuta hundratals requests i minuten. Om en partnerintegration använder en delad token kan en per-token-begränsning stoppa den från att dränka interaktiva användare.\n\n## Algoritmer som funkar i produktion\n\nDe flesta rate limiting-problem handlar inte om matte. De handlar om att välja beteende som matchar hur kunder anropar ditt API, och att hålla det förutsägbart under belastning.\n\nToken bucket är ett vanligt standardval eftersom det tillåter korta burstar samtidigt som det upprätthåller ett stabilt långtidsgenomsnitt. En användare som uppdaterar en dashboard kan trigga 10 snabba requests. Token bucket tillåter det om de har sparat tokens, och saktar sedan ner.\n\nLeaky bucket är stramare. Den jämnar ut trafiken till en konstant utflöde, vilket hjälper när din backend inte klarar spikes (t.ex. dyra rapportgenereringar). Bytet är att kunder känner av det tidigare, eftersom burstar blir köade eller avvisade.\n\nFönsterbaserade räknare är enkla, men detaljerna spelar roll. Fixed windows skapar skarpa kanter vid gränsen (en användare kan göra en burst vid 12:00:59 och igen vid 12:01:00). Sliding windows känns rättvisare och minskar gränsspikar, men kräver mer state eller bättre datastrukturer.\n\nEn separat klass är samtidighet (in-flight requests). Detta skyddar mot långsamma klientanslutningar och långkörande endpoints. En kund kan hålla sig inom 60 requests per minut men ändå överbelasta dig genom att ha 200 öppna requests samtidigt.\n\nI verkliga system kombinerar team ofta en liten uppsättning kontroller: en token bucket för generell request-hastighet, en concurrency-gräns för långsamma eller tunga endpoints, och separata budgetar för endpoint-grupper (billiga läsningar vs kostsamma exports). Om du bara begränsar efter request-count kan en dyr endpoint tränga undan allt annat och få API:t att kännas slumpmässigt trasigt.\n\n## Designa kvoter som matchar prissättning och användning\n\nBra kvoter känns rättvisa och förutsägbara. Kunder ska inte upptäcka reglerna först efter att ha blivit blockerade.\n\nHåll separationen tydlig:\n\n- Kortsiktiga rate limits (som 10 requests/sekund) skyddar din tjänst från burstar.\n- Långsiktiga kvoter (dagliga/månadsvisa) skyddar kostnader och håller prissättningsnivåer jämförbara.\n\nMånga SaaS-team använder båda: en kort rate limit för att stoppa burstar plus en månadsquota kopplad till prissättning.\n\nHard vs soft limits är mest ett supportval. En hard limit blockerar omedelbart. En soft limit varnar först, och blockerar sedan senare. Soft limits minskar arga tickets eftersom folk får chans att fixa en bugg eller uppgradera innan en integration går sönder.\n\nNär någon går över bör beteendet matcha vad du skyddar. Blockering fungerar när överanvändning kan skada andra tenants eller spränga kostnader. Degradering (långsammare bearbetning eller lägre prioritet) fungerar när du hellre vill hålla saker igång. “Fakturera senare” kan fungera när användningen är förutsägbar och du redan har ett faktureringsflöde.\n\nNivåbaserade begränsningar fungerar bäst när varje nivå har en klar "förväntad användningsform". Ett gratislager kan tillåta små månatliga kvoter och låga burst-hastigheter, medan business och enterprise får högre kvoter och högre burst-limiter så bakgrundsjobb kan slutföras snabbt. Det liknar hur Koder.ai:s free, pro, business och enterprise-nivåer sätter olika förväntningar för vad du kan göra innan du uppgraderar.\n\nAnpassade begränsningar är värda att stödja tidigt, särskilt för enterprise. Ett rent tillvägagångssätt är "standard per plan, överskrivningar per kund." Spara en admin-överskrivning per org (och ibland per endpoint) och se till att den överlever planändringar. Bestäm också vem som kan begära ändringar och hur snabbt de träder i kraft.\n\nExempel: en kund importerar 50 000 poster sista dagen i månaden. Om deras månadsquota nästan är slut ger en soft-varning vid 80–90% tid att pausa. En kort per-sekund-rate limit förhindrar att importen översvämmar API:t. En godkänd org-överskrivning (tillfällig eller permanent) håller affären igång.\n\n## Steg för steg: implementera begränsningar i ett SaaS-API\n\nBörja med att skriva ner vad du räknar och vem det tillhör. De flesta team landar i tre identiteter: inloggad användare, kundens org (eller workspace) och klient-IP.\n\nEn praktisk plan:\n\n- Definiera identitetsregler: user ID från auth, org ID från token eller API-nyckel, IP från första betrodda proxy-hop (vara explicit om vilken header du litar på).\n- Gruppera endpoints efter kostnad: reads, writes, tunga exports, auth-flöden. Ge varje grupp olika limiter så en dyr endpoint inte tömmer hela budgeten.\n- Välj var räknare bor: in-memory för enskild instans, Redis för delade limiter över många servrar, och en databas bara för långsammare revisions-kvoter. Använd TTLs som matchar fönstret (t.ex. 60 sek för per-minut-limiter).\n- Verkställ konsekvent: gör grov blocking i kanten (gateway/CDN) för IP-flöden, sedan finare per-user/org-kontroller i app-middleware där du ser route och tenant.\n- Instrumentera allt: spåra block-rate (429s), latens som läggs på av limitern, och topp-nycklar som blockas. Larma när blocks spikar eller när Redis-fel tvingar "fail open/closed"-beteende.\n\nNär du sätter gränser, tänk i nivåer och endpoint-grupper, inte ett enda globalt nummer. Ett vanligt fel är att förlita sig på in-memory-räknare över flera app-servrar. Räknare blir oense och användare ser "slumpmässiga" 429s. En delad store som Redis håller limiter stabila över instanser, och TTLs håller data liten.\n\nRollout spelar roll. Starta i "report only"-läge (logga vad som skulle ha blockerats), sedan verkställ en endpoint-grupp, och expandera. Så undviker du att vakna till en vägg av supportärenden.\n\n## Gör begränsningar begripliga med responser och headers\n\nNär en kund träffar en gräns är det värsta resultatet förvirring: "Är ert API nere, eller gjorde jag något fel?" Klara, konsekventa responser minskar supportärenden och hjälper folk att fixa klientbeteende.\n\nAnvänd HTTP 429 Too Many Requests när du aktivt blockerar anrop. Håll response-body förutsägbar så SDKs och dashboards kan läsa den.\n\nHär är en enkel JSON-form som funkar bra för per-user, per-org och per-IP-limiter:\n\njson\n{\n \"error\": {\n \"code\": \"rate_limit_exceeded\",\n \"message\": \"Rate limit exceeded for org. Try again later.\",\n \"limit_scope\": \"org\",\n \"reset_at\": \"2026-01-17T12:34:56Z\",\n \"request_id\": \"req_01H...\"\n }\n}\n\n\nHeaders bör förklara det aktuella fönstret och vad klienten kan göra härnäst. Om du bara lägger till några, börja här: RateLimit-Limit, RateLimit-Remaining, RateLimit-Reset, Retry-After och X-Request-Id.\n\nExempel: en kunds cron-jobb kör varje minut och börjar plötsligt misslyckas. Med 429 plus RateLimit-Remaining: 0 och Retry-After: 20 vet de omedelbart att det är en gräns, inte ett driftstopp, och kan fördröja omförsök med 20 sekunder. Om de delar X-Request-Id med support kan du snabbt hitta händelsen.\n\nEn detalj till: returnera samma headers även på lyckade svar. Kunder kan se att de börjar närma sig kanten innan de träffar den.\n\n## Klientbeteende: retries, backoff och säkra skrivningar\n\nBra klienter får begränsningar att kännas rättvisa. Dåliga klienter förvandlar en temporär gräns till ett driftstopp genom att öka takten.\n\nNär du får en 429, behandla det som en signal att sakta ner. Om responsen talar om när man ska försöka igen (t.ex. via Retry-After), vänta åtminstone så länge. Om den inte gör det, använd exponentiell backoff och lägg till jitter så tusentals klienter inte försöker samtidigt.\n\nHåll retries begränsade: takta fördröjning mellan försök (t.ex. 30–60 sek) och total retry-tid (t.ex. sluta efter 2 minuter och visa ett fel). Logga även händelsen med begränsningsdetaljer så utvecklare kan tweaka senare.\n\nFörsök inte återställa allt. Många fel kommer inte att lyckas utan en förändring eller användaråtgärd: 400 valideringsfel, 401/403 auth-fel, 404 not found och 409 konflikter som speglar affärsregler.\n\nRetries är riskabla på skrivendpoints (create, charge, send email). Om en timeout händer och klienten försöker igen kan du skapa dubbletter. Använd idempotency-nycklar: klienten skickar en unik nyckel per logisk åtgärd, och servern returnerar samma resultat för upprepningar av den nyckeln.\n\nBra SDKs kan göra detta enklare genom att exponera vad utvecklare verkligen behöver: status (429), hur länge att vänta, om requesten är säker att försöka igen, och ett meddelande som "Rate limit exceeded for org. Retry after 8s or reduce concurrency."\n\n## Vanliga misstag som skapar arga ärenden\n\nDe flesta supportärenden om begränsningar handlar inte om begränsningen själv. De handlar om överraskningar. Om användare inte kan förutsäga vad som händer härnäst antar de att API:t är trasigt eller orättvist.\n\nAtt endast använda IP-baserade begränsningar är ett frekvent misstag. Många team sitter bakom en publik IP (kontors-Wi‑Fi, mobiloperatörer, cloud NAT). Om du sätter en hård IP-gräns kan en aktiv kund blockera alla andra på samma nätverk. Föredra per-user och per-org-begränsningar, och använd per-IP främst som ett abuse-säkerhetsnät.\n\nEtt annat problem är att behandla alla endpoints lika. En billig GET och ett tungt exportjobb bör inte dela samma budget. Annars förbrukar kunder sin tilldelning på normal surfning och blir blockerade när de försöker utföra riktiga uppgifter. Separera hinkar per endpoint-grupp eller vik requests efter kostnad.\n\nReset-timing behöver också vara explicit. "Återställs dagligen" räcker inte. Vilken tidszon? Rullande fönster eller midnatt-reset? Om du gör kalenderresets, uppge tidszonen. Om du gör rullande fönster, ange fönsterlängden.\n\nSlutligen skapar vaga fel kaos. Att returnera 500 eller generisk JSON gör att folk försöker igen hårdare. Använd 429 och inkludera RateLimit-headers så klienter kan backa av intelligent.\n\nExempel: om ett team bygger en Koder.ai-integration från ett delat företagsnätverk kan enbart IP-baserad kapning blockera hela deras org och se ut som slumpmässiga driftstopp. Klara dimensioner och tydliga 429-responser förhindrar det.\n\n## Snabb checklista innan du släpper\n\nInnan du aktiverar limiter för alla, gör en sista koll som fokuserar på förutsägbarhet:\n\n- Definiera limiter per prissättningsnivå och endpoint-grupp (auth, reads, writes, exports). Ha en liten säkerhetsbuffert för viktiga saker som login och token refresh.\n- Gör identitetsregler deterministiska och dokumenterade. Bestäm exakt hur du räknar (user, org, API key, IP) och vad som har företräde.\n- Gör 429-responser självförklarande. Inkludera Retry-After plus RateLimit-headers (Limit, Remaining, Reset). I JSON-bodyn, ha ett kort meddelande, vilken limit som träffades och när man kan försöka igen.\n- Övervaka både spikar och falska positiva. Spåra 429-rate per endpoint-grupp, topp-anropare och plötsliga dropp i lyckade requests. Larma när blocks spikar.\n- Ha en undantagsplan: vitlistor, tillfälliga ökningar, nödoverrides och vem som kan godkänna dem.\n\nEn magkänsla: om din produkt har nivåer som Free, Pro, Business och Enterprise (som Koder.ai) ska du kunna förklara enkelt vad en normal kund kan göra per minut och per dag, och vilka endpoints som behandlas annorlunda.\n\nOm du inte kan förklara en 429 tydligt, kommer kunder anta att API:t är trasigt, inte att det skyddar tjänsten.\n\n## Exempel på rollout-plan och nästa steg\n\nFöreställ dig en B2B SaaS där folk jobbar i ett workspace (org). Några power users kör tunga exports, och många anställda sitter bakom en delad företags-IP. Om du bara begränsar per IP blockerar du hela bolag. Om du bara begränsar per användare kan ett skript ändå skada hela workspace.\n\nEn praktisk mix är:\n\n- Per-user burst-limit för korta spike:ar.\n- Per-org sustained-limit för att hålla workspace rättvis över tid.\n- Per-IP abuse-guard för att fånga läckta tokens, bots och bullriga delade nätverk.\n\nNär någon träffar en gräns bör ditt meddelande säga vad som hände, vad de kan göra härnäst och när de kan försöka igen. Support ska kunna stå bakom formuleringar som:\n\n"Request rate exceeded for workspace ACME. You can retry after 23 seconds. If you are running an export, reduce concurrency to 2 or schedule it off-peak. If this blocks normal use, reply with your workspace ID and timestamp and we can review your quota."\n\nPara det med Retry-After och konsekventa RateLimit-headers så kunder inte behöver gissa.\n\nEn rollout som undviker överraskningar: observera först, varna (headers och soft-warnings), verkställ sedan (429s med tydlig retry-tid), finjustera trösklar per nivå och granska efter stora lanseringar och kundonboardingar.\n\nOm du vill ha ett snabbt sätt att förvandla dessa idéer till fungerande kod kan en vibe-coding-plattform som Koder.ai (koder.ai) hjälpa dig att skissa en kort rate limit-spec och generera Go-middleware som verkställer den konsekvent över tjänster.