28 dec. 2025·6 min

Objektlagring kontra databasblobs för snabba, billiga uppladdningar

Objektlagring vs databasblobs: modellera filmetadata i Postgres, lagra byten i objektlagring och håll nedladdningar snabba med förutsägbara kostnader.

Objektlagring vs databasblobs: modellera filmetadata i Postgres, lagra byten i objektlagring och håll nedladdningar snabba med förutsägbara kostnader.

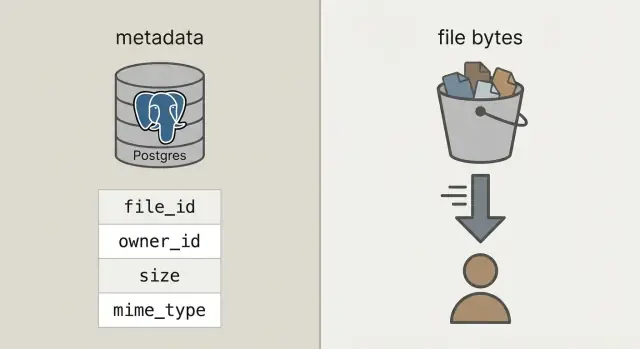

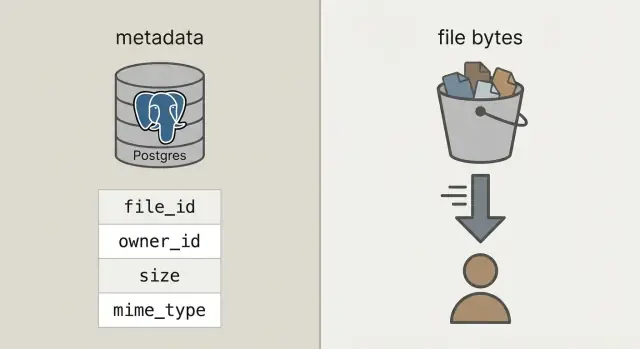

BYTEA-kolumn (råa bytes i en rad) eller Postgres "large objects" (en funktion som lagrar stora värden separat). Båda kan fungera, men båda gör din databas ansvarig för att servera filbyten.\n\nObjektlagring är en annan idé: filen ligger i en bucket som ett objekt, adresserat med en nyckel (som uploads/2026/01/file.pdf). Den är byggd för stora filer, billig lagring och strömmade nedladdningar. Den hanterar också många samtidiga läsningar väl, utan att binda upp dina databasanslutningar.\n\nPostgres glänser i frågor, constraints och transaktioner. Det är utmärkt för metadata som vem som äger filen, vad den är, när den laddades upp och om den kan laddas ned. Den metadata är liten, lätt att indexera och enkel att hålla konsekvent.\n\nEn praktisk tumregel:\n\n- Använd Postgres för filmetadata, behörigheter och relationer.\n- Använd objektlagring för byten när filer kan växa till mer än några MB, eller när nedladdningar är frekventa.\n- Överväg DB-blobs endast för pyttesmå tillgångar som måste vara transactionellt kopplade till en post (som en liten ikon) och du är säker på att databasens tillväxt förblir måttlig.\n\nEn snabb sundhetskontroll: om backuper, repliker och migrationer skulle bli besvärliga med filbyten inkluderade, håll bytena utanför Postgres.\n\n## En enkel arkitektur som är hanterbar\n\nUpplägget som de flesta team landar i är enkelt: lagra byten i objektlagring och lagra filposten (vem som äger den, vad den är, var den ligger) i Postgres. Din API koordinerar och auktoriserar, men proxy:ar inte stora uppladdningar och nedladdningar.\n\nDet ger dig tre tydliga ansvar:\n\n- Postgres håller en liten rad per fil: ett stabilt file_id, ägare, storlek, content type och pekare till objektet.\n- Objektlagring håller de faktiska bytena, optimerat för stora filer och billig lagring.\n- Din API skapar och auktoriserar filposter och delar ut kortlivade behörigheter till lagringen.\n\nDet stabila file_id blir primärnyckeln för allt: kommentarer som refererar en bilaga, fakturor som pekar på en PDF, audit logs och supportverktyg. Användare kan byta namn på en fil, du kan flytta den mellan buckets, och file_id förblir densamma.\n\nNär det är möjligt, behandla lagrade objekt som immutabla. Om en användare ersätter ett dokument, skapa ett nytt objekt (och vanligtvis en ny rad eller en ny versionsrad) istället för att skriva över byten på plats. Det förenklar caching, undviker "gammal länk visar ny fil"-överraskningar och ger en tydlig rollback-berättelse.\n\nBestäm sekretess tidigt: privat som standard, publik bara undantagsvis. En bra regel är: databasen är sanningskällan för vem som kan komma åt en fil; objektlagringen genomdriver de kortlivade behörigheter din API utfärdar.\n\n## Hur modellera filmetadata i Postgres\n\nMed den rena uppdelningen lagrar Postgres fakta om filen, och objektlagring lagrar bytena. Det håller din databas mindre, backuper snabbare och queries enkla.\n\nEn praktisk uploads-tabell behöver bara några fält för att svara på verkliga frågor som "vem äger detta?", "var lagras det?" och "är det säkert att ladda ner?"\n\n```sqlCREATE TABLE uploads ( id uuid PRIMARY KEY, owner_id uuid NOT NULL, bucket text NOT NULL, object_key text NOT NULL, size_bytes bigint NOT NULL, content_type text, original_filename text, checksum text, state text NOT NULL CHECK (state IN ('pending','uploaded','failed','deleted')), created_at timestamptz NOT NULL DEFAULT now() );

CREATE INDEX uploads_owner_created_idx ON uploads (owner_id, created_at DESC); CREATE INDEX uploads_checksum_idx ON uploads (checksum);

Använd Postgres för metadata du behöver fråga och säkra (ägare, behörigheter, status, checksum, pekare). Lägg bytena i objektlagring så att nedladdningar och stora överföringar inte använder upp databasanslutningar eller blåser upp backupstorleken.

Det gör att din databas får dubbel roll som filserver. Det ökar tabellstorleken, saktar ner backup och restore, ökar replikationsbelastning och kan göra prestandan mindre förutsägbar när många användare laddar ner samtidigt.

Ja. Ha en stabil file_id i din app, lagra metadata i Postgres och byten i objektlagring adresserade av bucket och object_key. Din API ska auktorisera åtkomst och utfärda kortlivade uppladdnings-/nedladdningstillstånd istället för att proxy:a bytena.

Skapa först en pending-rad, generera en unik object_key, låt klienten ladda upp direkt till lagringen med ett kortlivat tillstånd. Efter uppladdning anropar klienten en finalize-endpoint så servern kan verifiera storlek och checksum (om du använder det) innan raden märks som uploaded.

För att verkliga uppladdningar som misslyckas och försöker igen ska hanteras korrekt. Ett fält för status låter dig skilja på förväntade men frånvarande filer (pending), färdiga (uploaded), trasiga (failed) och borttagna (deleted) så UI, cleanup-jobb och supportverktyg beter sig rätt.

Använd original_filename som enbart visningsdata. Generera en unik lagringsnyckel (ofta en UUID-baserad sökväg) för att undvika kollisioner, konstiga tecken och säkerhetsöverraskningar. Du kan fortfarande visa det ursprungliga namnet i UI medan lagringsvägarna hålls rena och förutsägbara.

Använd en stabil app-URL som /files/{file_id} som åtkomstkontroll. Efter att ha kontrollerat åtkomst i Postgres, returnera en redirect eller ett kortlivat signerat nedladdningstillstånd så klienten laddar ner direkt från objektlagringen och håller din API utanför den hetaste vägen.

Utgående trafik och upprepade nedladdningar dominerar ofta kostnaderna, inte rå lagringsvolym. Sätt filstorleksgränser och kvoter, använd retention-/livscykelregler, deduplicera via checksum där det är meningsfullt, och spåra användning så du kan varna innan kostnaderna skjuter i höjden.

Lagra behörigheter och synlighet i Postgres som sanningskälla, och håll lagringen privat som standard. Validera typ och storlek före och efter uppladdning, använd HTTPS end-to-end, kryptera i vila, och lägg till auditfält så du kan utreda incidenter senare.

Börja med en metadata-tabell, ett direkt-till-lagring-uppladdningsflöde och en nedladdnings-gate-endpoint, sedan lägg till cleanup-jobb för föräldralösa objekt och soft-deleted rader. Koder.ai kan snabba upp prototypandet på en React/Go/Postgres-stack genom att generera endpoints, schema och bakgrundsuppgifter från chatten så du slipper skriva samma boilerplate om och om igen.

\nNågra beslut som sparar smärta senare:\n\n- Använd `bucket + object_key` som lagringspekare. Håll den oföränderlig efter uppladdning.\n- Spåra state. När en användare startar en uppladdning, sätt in en `pending`-rad. Växla till `uploaded` först efter att ditt system bekräftar att objektet finns och storleken (och helst checksum) stämmer.\n- Spara `original_filename` enbart för visning. Lita inte på det för typ- eller säkerhetsbeslut.\n\nOm du stödjer ersättningar (som att en användare laddar upp en faktura på nytt), lägg till en separat `upload_versions`-tabell med `upload_id`, `version`, `object_key` och `created_at`. På så sätt kan du behålla historik, rulla tillbaka misstag och undvika att bryta gamla referenser.\n\n## Uppladdningsflödet steg för steg (utan att blockera din API)\n\nHåll uppladdningar snabba genom att låta din API sköta koordinering, inte filbytena. Din databas förblir responsiv medan objektlagringen tar bandbreddsbelastningen.\n\nBörja med att skapa en uppladdningspost innan något skickas. Din API returnerar ett `upload_id`, var filen kommer att ligga (en `object_key`) och en kortlivad uppladdningsbehörighet.\n\nEtt vanligt flöde:\n\n1. **Klient ber om att ladda upp**: din API skapar en rad med `pending`, plus förväntad storlek och avsedd content type.\n2. **API returnerar en presignerad URL**: för stora filer generera en presignerad uppladdnings-URL. För små filer (som avatarer) kan du fortfarande proxy:a genom din backend om du vill ha enklare klientkod.\n3. **Klient laddar upp direkt till objektlagring**: webbläsaren eller mobilappen skickar byten till lagringen, inte via din API.\n4. **Finalisera**: klienten anropar din API med `upload_id` och eventuella svarsfält från lagringen (som ETag). Din server verifierar storlek, checksum (om du använder en) och content type, och markerar sedan raden `uploaded`.\n5. **Faila säkert**: om verifieringen misslyckas, markera `failed` och ta bort objektet vid behov.\n\nRetry och dubbletter är normalt. Gör finalize-anropet idempotent: om samma `upload_id` finaliseras två gånger, returnera framgång utan att ändra något.\n\nFör att minska dubbletter vid retries och re-uploads, lagra en checksum och behandla "samma ägare + samma checksum + samma storlek" som samma fil.\n\n## Nedladdningsflödet steg för steg (snabbt och cache-vänligt)\n\nEtt bra nedladdningsflöde börjar med en stabil URL i din app, även om bytena lever någon annanstans. Tänk: `/files/{file_id}`. Din API använder `file_id` för att slå upp metadata i Postgres, kontrollerar behörighet och bestämmer sedan hur filen levereras.\n\n1) Klienten begär din stabila URL med `file_id`.\n2) API verifierar att användaren kan komma åt den och att filen är `uploaded`.\n3) API returnerar antingen en redirect till objektlagringen (oftast bäst), eller en kortlivad presignerad GET-URL för privata filer.\n4) Klienten laddar ner direkt från objektlagringen, vilket håller din API och appservrar utanför den heta vägen.\n\nRedirects är enkla och snabba för publika eller semi-publika filer. För privata filer behåller presignerade GET-URL:er lagringen privat samtidigt som webbläsaren kan ladda ner direkt.\n\nFör video och stora nedladdningar, säkerställ att din objektlagring (och eventuellt proxy-lager) stödjer range-förfrågningar (`Range`-headers). Det möjliggör sökning och återupptagbara nedladdningar. Om du skickar byten genom din API, bryts ofta range-stöd eller blir dyrt.\n\nCaching är där hastigheten kommer ifrån. Din stabila `/files/{file_id}`-endpoint bör oftast vara icke-cachebar (det är en auth-gate), medan objektlagringens svar ofta kan cache:as baserat på innehåll. Om filer är immutabla (ny uppladdning = ny nyckel) kan du sätta lång cache-tid. Om du skriver över filer, håll cache-tider korta eller använd versionsnycklar.\n\nEtt CDN hjälper när du har många globala användare eller stora filer. Om din publik är liten eller mestadels i en region räcker ofta objektlagring ensam och är billigare att börja med.\n\n## Hålla kostnader förutsägbara över tid\n\nÖverraskningsräkningar kommer oftast från nedladdningar och churn, inte råa bytes som ligger på disk.\n\nPris fyra drivare som påverkar kostnaderna: hur mycket du lagrar, hur ofta du läser och skriver (requests), hur mycket data som lämnar din leverantör (utgående trafik) och om du använder ett CDN för att minska upprepade origin-nedladdningar. En liten fil som laddas ner 10 000 gånger kan kosta mer än en stor fil som ingen rör.\n\nKontroller som håller kostnaden stabil:\n\n- Begränsa filstorlek per uppladdning och sätt per-användar-kvoter baserat på din plan.\n- Rate-limita uppladdningar och nedladdningar för att undvika missbruk och oavsiktliga loopar.\n- Använd livscykelregler så att gamla filer flyttas till en billigare nivå eller tas bort när de inte längre behövs.\n- Deduplicera med checksum så att retries eller re-uploads inte skapar extra kopior.\n- Spara användningsräknare i Postgres så att fakturering och varningar baseras på fakta, inte uppskattningar.\n\nLivscykelregler är ofta den enklaste vinsten. Till exempel: behåll originalfoton "hot" i 30 dagar, flytta dem sedan till en billigare lagringsklass; behåll fakturor i 7 år, men ta bort misslyckade uppladdningsdelar efter 7 dagar. Även grundläggande retention-regler stoppar lagringstillväxt.\n\nDeduplicering kan vara enkel: spara en innehållshash (som SHA-256) i din filmetadata-tabell och upprätthåll unikhet per ägare. När en användare laddar upp samma PDF två gånger kan du återanvända det befintliga objektet och bara skapa en ny metadata-rad.\n\nSlutligen, spåra användning där du redan gör användarkonton: Postgres. Spara bytes_uploaded, bytes_downloaded, object_count och last_activity_at per användare eller workspace. Det gör det enkelt att visa gränser i UI och trigga varningar innan räkningen kommer.\n\n## Säkerhet och compliance-grunder för uppladdningar\n\nSäkerhet för uppladdningar handlar om två saker: vem kan komma åt en fil, och vad du kan bevisa senare om något går fel.\n\n### Åtkomstkontroll som matchar verklig användning\n\nBörja med en tydlig accessmodell och koda den i Postgres-metadata, inte i ad hoc-regler spridda över tjänster.\n\nEn enkel modell som täcker de flesta appar:\n\n- **Owner-only**: endast uppladdaren (och admins) kan komma åt.\n- **Shared**: åtkomlig för specifika användare eller ett team/workspace.\n- **Public**: åtkomlig utan inloggning (använd sparsamt, men spåra det).\n\nFör privata filer, undvik att exponera råa object keys. Utfärda tidsbegränsade, scope-begränsade presignerade upload- och download-URL:er, och rotera dem ofta.\n\n### Compliance-kontroller som sparar dig senare\n\nVerifiera kryptering både i transit och i vila. I transit betyder HTTPS end-to-end, inklusive uppladdningar direkt till lagring. I vila betyder server-side encryption hos din lagringsleverantör, och att backuper och repliker också är krypterade.\n\nLägg till checkpoints för säkerhet och datakvalitet: validera content type och storlek innan du utfärdar en upload-URL, och validera igen efter uppladdning (baserat på faktiskt lagrade bytes, inte bara filnamnet). Om din riskprofil kräver det, kör malware-scanning asynkront och karantänsätt filen tills den passerar.\n\nSpara auditfält så att du kan utreda incidenter och uppfylla grundläggande compliance-krav: `uploaded_by`, `ip`, `user_agent` och `last_accessed_at` är en praktisk bas.\n\nOm du har krav på dataresidens, välj lagringsregion med eftertanke och håll den konsekvent med var du kör compute.\n\n## Vanliga misstag som orsakar nedgångar och incidenter\n\nDe flesta uppladdningsproblem handlar inte om rå hastighet. De kommer av designval som känns bekväma i början, men blir smärtsamma när du får riktig trafik, verklig data och riktiga supportärenden.\n\n- **Att lagra filbyten i Postgres**: Det funkar för små appar, men backuperna blåser upp, restores tar evigheter och rutinunderhåll blir riskabelt. En enda stor tabell kan sakta ner vacuum, replikation och till och med enkla queries.\n- **Använda användarens filnamn som objektkey**: Kollisioner uppstår (två användare laddar upp "invoice.pdf"), och konstiga tecken skapar edgecases. Håll filnamn som visningsdata, men generera en unik nyckel (som en UUID) för lagringen.\n- **Hoppa över validering vid finalize-tid**: Även om du validerar på klienten behöver du server-side checks för storlek, content type och ägarskap när du markerar en uppladdning som klar.\n- **Göra objekt publika av misstag och aldrig rotera åtkomst**: En "tillfällig" publik bucket-policy eller långlivade URL:er blir ofta permanenta. Föredra kortlivade nedladdningslänkar och ha ett sätt att snabbt återkalla åtkomst.\n- **Radera bara ena sidan (metadata eller byten)**: Radera Postgres-raden men lämna objektet kvar skapar tysta kostnadsläckor. Radera objektet men behåll metadata ger brutna nedladdningar och supportbelastning.\n\nEtt konkret exempel: om en användare ersätter en profilbild tre gånger kan du råka betala för tre gamla objekt för alltid om du inte schemalägger cleanup. Ett säkert mönster är soft delete i Postgres, följt av ett bakgrundsjobb som tar bort objektet och loggar resultatet.\n\n## Snabb pre-launch-checklista\n\nDe flesta problem dyker upp när den första stora filen anländer, en användare uppdaterar sidan mitt i en uppladdning eller någon tar bort ett konto och bytena blir kvar.\n\nSe till att din Postgres-tabell registrerar filens storlek, checksum (så du kan verifiera integritet) och en tydlig state-bana (t.ex. `pending`, `uploaded`, `failed`, `deleted`).\n\nEn sista-milen checklist:\n\n- Bekräfta att retries är säkra: upprepade försök får inte skapa extra objekt eller "uploaded"-rader med saknade bytes.\n- Gör uppladdningar återupptagningsbara eller åtminstone återstartbara utan supportärenden (timeouts och mobila nätverk händer).\n- Verifiera att nedladdningar hanterar range-förfrågningar så att stora filer kan starta snabbt och återupptas efter en paus.\n- Definiera radering end-to-end: tombstone-metadata, ta bort objektbytes och hantera fördröjd cleanup om ett jobb misslyckas.\n- Lägg till grundläggande övervakning: felgrad för uppladdning/nedladdning, lagringstillväxt och plötsliga egress-spikar.\n\nEtt konkret test: ladda upp en 2 GB-fil, uppdatera sidan vid 30 %, och försök sedan återuppta. Ladda sedan ner på en långsam anslutning och hoppa till mitten. Om något av flödena är skakigt, åtgärda det nu, inte efter lansering.\n\n## Exempelscenario: foton och fakturor i samma app\n\nEn enkel SaaS-app har ofta två väldigt olika uppladdningstyper: profilfoton (frekventa, små, säkra att cache:a) och PDF-fakturor (känsliga, måste vara privata). Här lönar sig uppdelningen mellan metadata i Postgres och byten i objektlagring.\n\nHär är hur metadata kan se ut i en `files`-tabell, med några fält som påverkar beteendet:\n\n| field | profilfoto-exempel | faktura PDF-exempel |\n|---|---|---|\n| `kind` | `avatar` | `invoice_pdf` |\n| `visibility` | `private` (serveras via signad URL) | `private` |\n| `cache_control` | `public, max-age=31536000, immutable` | `no-store` |\n| `object_key` | `users/42/avatars/2026-01-17T120102Z.webp` | `orgs/7/invoices/INV-1049.pdf` |\n| `status` | `uploaded` | `uploaded` |\n| `size_bytes` | `184233` | `982341` |\n\nNär en användare ersätter en bild, behandla det som en ny fil, inte en överskrivning. Skapa en ny rad och ny `object_key`, uppdatera sedan användarprofilen att peka på det nya file ID:t. Markera den gamla raden som `replaced_by=\u003cnew_id\u003e` (eller `deleted_at`) och ta bort det gamla objektet senare med ett bakgrundsjobb. Det håller historik, gör rollback enklare och undviker race conditions.\n\nSupport och felsökning blir enklare eftersom metadata berättar en historia. När någon säger "min uppladdning misslyckades" kan support kolla `status`, ett lättläst `last_error`, ett `storage_request_id` eller `etag` (för att spåra lagringsloggar), tidsstämplar (stallede det?) och `owner_id` och `kind` (är åtkomstpolicyn korrekt?).\n\n## Nästa steg för att implementera utan att överbygga\n\nBörja litet och gör happy-pathen tråkig: filer laddas upp, metadata sparas, nedladdningar är snabba och inget går förlorat.\n\nEtt bra första mål är en minimal Postgres-tabell för filmetadata plus ett enda uppladdningsflöde och ett enda nedladdningsflöde som du kan förklara på en whiteboard. När det fungerar end-to-end, lägg till versioner, kvoter och livscykelregler.\n\nVälj en tydlig lagringspolicy per filtyp och skriv ner den. Till exempel kan profilbilder vara cachebara medan fakturor ska vara privata och endast nås via kortlivade nedladdnings-URL:er. Att blanda policyer i ett och samma bucket-prefix utan plan är hur oavsiktlig exponering uppstår.\n\nLägg in instrumentering tidigt. Siffrorna du vill ha från dag ett är finalize-felgrad för uppladdning, orphan-rate (objekt utan matchande DB-rad och vice versa), utgående volym per filtyp, P95-nedladdningslatens och genomsnittlig objektstorlek.\n\nOm du vill prototypa detta snabbare kan Koder.ai hjälpa till att generera hela appar från chatten; det matchar den vanliga stacken här (React, Go, Postgres). Det kan vara ett praktiskt sätt att iterera på schema, endpoints och bakgrundsrensningsjobb utan att skriva om samma scaffolding om och om igen.\n\nEfter det, lägg bara till det du kan förklara på en mening: "vi behåller gamla versioner i 30 dagar" eller "varje workspace får 10 GB." Håll det enkelt tills verklig användning tvingar fram ändringar.