Dlaczego prognozy Kurzweila dotyczące AGI mają znaczenie

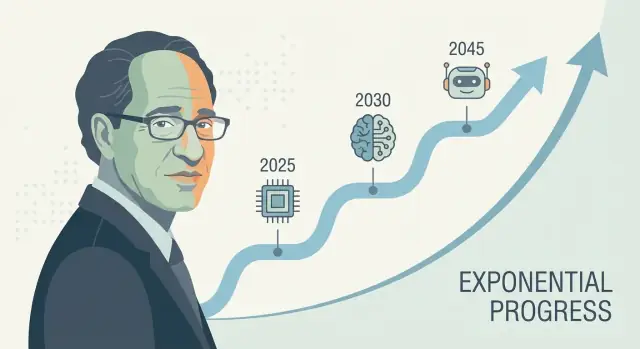

Ray Kurzweil jest jednym z najbardziej rozpoznawalnych głosów w prognozowaniu technologii na długi horyzont — zwłaszcza w kwestii sztucznej inteligencji i technologicznej osobliwości. Kiedy przedstawia konkretną prognozę dotyczącą AGI (często w formie daty, a nie mglista „kiedyś”), wywołuje to efekt fali: inwestorzy ją cytują, dziennikarze o niej dyskutują, a badacze są proszeni o odpowiedź.

Dlaczego jego prognozy przyciągają uwagę

Wpływ Kurzweila nie wynika tylko z optymizmu. Chodzi o zaproponowanie powtarzalnej narracji wyjaśniającej dlaczego postęp ma przyspieszać — często powiązanej z wykładniczym wzrostem mocy obliczeniowej i ideą, że kolejne generacje narzędzi pomagają budować następną. Niezależnie od tego, czy się zgadzasz, dostarcza struktury do rozmowy o harmonogramie sztucznej ogólnej inteligencji, zamiast traktować go jak czystą fantastykę naukową.

Co naprawdę znaczy „prognozować na dekady naprzód”

Prognoza na dekady to mniej zgadywanie daty w kalendarzu, a bardziej projekcja zestawu trendów: moc obliczeniowa, koszt, dane, algorytmy i praktyczna zdolność do budowania systemów, które uogólniają. Zakład jest taki, że te krzywe będą się dalej przesuwać — i że dzisiejsze „brakujące elementy” to rozwiązywalne problemy inżynierskie, które zmniejszają się, gdy poprawiają się dane wejściowe.

Czego dowiesz się z tego artykułu

Ten tekst wyjaśnia:

- Metodę stojącą za prognozowaniem technologicznym Kurzweila (co mierzy i ekstrapoluje),

- Jakie dowody wspierają pogląd, że wskaźniki postępu w AI przyspieszają — i gdzie dane są skąpe,

- Najsilniejsze krytyki prognoz AI opartych na prostych ekstrapolacjach wykładniczego wzrostu,

- Praktyczne wnioski, jak używać prognoz do planowania, nie traktując ich jak pewników.

Krótka uwaga o niepewności

Nawet wśród poważnych ekspertów harmonogramy AGI różnią się znacznie, ponieważ zależą od założeń: co oznacza „AGI”, które wąskie gardła są najważniejsze i jak szybko przełomy przekładają się na niezawodne produkty. Harmonogramy Kurzweila są wpływowe nie dlatego, że są gwarantowane, lecz dlatego, że są wystarczająco konkretne, by je testować — i wystarczająco trudne do zignorowania.

Kim jest Ray Kurzweil?

Ray Kurzweil to amerykański wynalazca, autor i futurolog znany z długoterminowych prognoz technologicznych — oraz z popierania ich wykresami, danymi historycznymi i odważnymi terminami.

Wynalazca, przedsiębiorca i „wyłapywacz wzorców”

Kurzweil zyskał rozgłos dzięki praktycznym wynalazkom, zwłaszcza w technologiach mowy i tekstu. Zakładał firmy skupione na optycznym rozpoznawaniu znaków (OCR), syntezie mowy i narzędziach muzycznych, i od dekad jest blisko rzeczywistych ograniczeń produktów: jakości danych, kosztów sprzętu i tego, co użytkownicy faktycznie przyjmą. To podejście „budowniczego” kształtuje jego prognozy — zwykle traktuje postęp jako coś, co można inżynieryjnie zaprojektować i skalować.

Pracował też w dużych organizacjach technologicznych (w tym Google), co utrwaliło jego pogląd, że duże skoki często wynikają ze stałych inwestycji, lepszych narzędzi i kumulujących się ulepszeń — nie tylko z pojedynczych przełomów.

Kluczowe książki i idee wpływające na debaty o AGI

Harmonogram AGI Kurzweila zwykle omawia się przez pryzmat jego popularnych książek, zwłaszcza The Age of Spiritual Machines (1999) i The Singularity Is Near (2005). Dzieła te argumentują, że technologie informacyjne rozwijają się w przyspieszający, kumulatywny sposób — i że to przyspieszenie w końcu doprowadzi do maszyn o możliwościach na poziomie ludzkim (a potem przekraczających ludzkie możliwości).

Niezależnie od zgody, jego pisma pomogły ustalić warunki publicznej rozmowy: postęp AI jako coś mierzalnego, napędzanego trendami i (przynajmniej w zasadzie) przewidywalnego.

Szybkie definicje (by mówić to samo)

AGI (Artificial General Intelligence): system AI, który potrafi uczyć się i wykonywać szeroki zakres zadań na mniej więcej ludzkim poziomie, adaptując się do nowych problemów bez wąskiej specjalizacji.

Osobliwość (Singularity): termin Kurzweila na okres, kiedy postęp technologiczny staje się tak szybki (a AI tak zdolna), że zmienia społeczeństwo w sposób nieprzewidywalny i trudny do modelowania.

Harmonogram: prognoza z datami i kamieniami milowymi (np. „AGI na poziomie ludzkim do roku X”), a nie tylko ogólne twierdzenie, że postęp będzie trwać.

Główne tezy Kurzweila o harmonogramach AGI

Kurzweil wielokrotnie twierdził, że AGI na poziomie ludzkim jest prawdopodobne w pierwszej połowie XXI wieku — najszerzej kojarzone z późnymi latami 2020. i 2030. W swoich publicznych wypowiedziach nie zawsze podaje pojedynczy, sztywny rok, ale centralna teza jest spójna: gdy moc obliczeniowa, dane i algorytmy przekroczą określone progi, systemy dorównają zakresowi i elastyczności ludzkiego poznania.

Jak AGI łączy się z „osobliwością”

W ujęciu Kurzweila AGI nie jest linią mety — jest wyzwalaczem. Gdy maszyny osiągną (a potem przekroczą) ludzki poziom ogólnej inteligencji, postęp się skumuluje: mądrzejsze systemy pomogą zaprojektować jeszcze mądrzejsze systemy, przyspieszając odkrycia naukowe, automatyzację i integrację człowiek–maszyna. To skumulowane przyspieszenie wiąże z szerszą ideą „technologicznej osobliwości”: okresu, w którym zmiany zachodzą tak szybko, że codzienna intuicja przestaje być wiarygodnym przewodnikiem.

AGI vs. dzisiejsze systemy AI

Istotna niuansa w jego twierdzeniach o harmonogramie to definicja AGI. Wiodące modele dzisiaj potrafią imponować w wielu zadaniach, ale wciąż mają tendencję do bycia:

- kruchymi poza wzorcami treningowymi,

- słabymi w długoterminowym planowaniu i osadzaniu w realnym świecie,

- zależnymi od celów i ewaluacji przygotowanych przez ludzi.

Kurzweilowskie „AGI” oznacza system, który potrafi przenosić naukę między domenami, formułować i realizować cele w nowych sytuacjach oraz niezawodnie radzić sobie z otwartą różnorodnością świata rzeczywistego — nie tylko dobrze wypadać w benchmarkach.

Dlaczego kamienie milowe są lepsze niż pojedyncza data

Prognoza kalendarzowa łatwo podlega dyskusji i trudno ją wykorzystać praktycznie. Kamienie milowe są bardziej użyteczne: trwałe autonomiczne uczenie się, niezawodne używanie narzędzi i planowanie, silne wyniki w złożonych środowiskach rzeczywistych oraz oczywista substytucja ekonomiczna w wielu zawodach. Nawet jeśli nie zgadzasz się co do dokładnego terminu, te punkty kontrolne sprawiają, że prognoza jest testowalna — i bardziej użyteczna niż obstawianie jednego roku nagłówkowego.

Dorobek: trafienia, pudła i co jest dyskusyjne

Kurzweil bywa opisywany jako „seryjny prorok”, i ta reputacja wpływa na to, że jego harmonogram AGI przyciąga uwagę. Jego dorobek jest jednak mieszany w sposób użyteczny do zrozumienia prognozowania: niektóre zapowiedzi były konkretne i mierzalne, inne kierunkowo trafne, ale nieprecyzyjne, a kilka pominęło istotne ograniczenia.

Zauważalne prognozy często kojarzone z Kurzweilem

W książkach i wystąpieniach bywa łączony z przewidywaniami takimi jak:

- Komputery systematycznie poprawiające stosunek koszt/osiągi (kontynuacja trendów typu prawo Moore'a),

- Rozpoznawanie mowy stające się powszechnie użyteczne dla konsumentów,

- Mobilne, zawsze połączone urządzenia stające się domyślne,

- AI przewyższająca ludzi w wąskich zadaniach (gry, rozpoznawanie wzorców),

- Zwiększająca się „integracja człowiek–maszyna” (ubrania, implanty, technologia wspomagająca).

Jasne, sprawdzalne vs. nieostre prognozy

Jasne, sprawdzalne prognozy są związane z datą i mierzalnym wynikiem: „do roku X technologia Y osiągnie wydajność Z” albo „większość urządzeń będzie miała funkcję F”. Można je porównać z publicznymi benchmarkami (współczynniki dokładności, dane sprzedaży/adaptacji, koszty obliczeń).

Nieostre prognozy brzmią wiarygodnie, ale trudno je obalić, np. „komputery będą wszędzie”, „AI zmieni społeczeństwo” lub „ludzie połączą się z technologią”. Takie stwierdzenia mogą wydawać się prawdziwe, nawet jeśli szczegóły, termin lub mechanizm będą inne.

Jak oceniać „trafne”, „częściowo trafne” i „błędne” (bez punktowania)

Praktyczny sposób oceny prognozodawcy to rozdzielenie kierunku, terminu i szczegółowości.

- Trafne: wynik odpowiada tezie, a termin jest na tyle bliski, że wyraźnie wpływał na oczekiwania.

- Częściowo trafne: kierunek jest prawidłowy, ale termin się przesuwa, adopcja jest wolniejsza albo wynik pojawia się w innej formie (np. „działa w demo” vs. „działa dla większości ludzi, większość czasu”).

- Błędne: kluczowych ograniczeń nie oszacowano — ograniczenia danych, regulacje, zachowanie użytkowników, koszty lub luka między wydajnością w laboratorium a niezawodnością w realnym świecie.

Sens nie polega na ocenianiu prognoz jako „dobre” lub „złe”. Chodzi o zauważenie, że pewne, oparte na danych przewidywania nadal opierają się na ukrytych założeniach — zwłaszcza gdy dotyczą skomplikowanej adopcji społecznej, nie tylko poprawy sprzętu czy algorytmów.

"Prawo przyspieszających zwrotów" prosto

"Prawo przyspieszających zwrotów" Kurzweila to pomysł, że gdy technologia się poprawia, te ulepszenia często ułatwiają kolejne ulepszenia. To tworzy sprzężenie zwrotne, w wyniku którego postęp przyspiesza z czasem.

Trendy wykładnicze, bez matematyki

Prosty trend liniowy to jak dodawanie tej samej wartości co roku: 1, 2, 3, 4.

Trend wykładniczy to mnożenie: 1, 2, 4, 8. Na początku wydaje się wolny — potem nagle wszystko dzieje się naraz. Kurzweil twierdzi, że wiele technologii (szczególnie informacyjnych) ma taki charakter, bo każda generacja narzędzi pomaga budować następną.

Dlaczego krzywe koszt/wydajność są ważne dla jego harmonogramów

Kurzweil nie pyta tylko „Czy możemy zrobić X?”. Pyta też „Jak tanio możemy zrobić X?”. Powszechny wzorzec w informatyce to: wydajność rośnie, a koszt spada. Gdy koszt uruchomienia użytecznego modelu spada, więcej ludzi może eksperymentować, wdrażać produkty i finansować kolejną falę — co przyspiesza postęp.

Dlatego zwraca uwagę na długookresowe krzywe typu „obliczenia na dolara”, a nie tylko efektowne dema.

Gdzie pasuje prawo Moore'a — a gdzie nie

Prawo Moore'a to klasyczny przykład: przez dekady liczba tranzystorów na chipie w przybliżeniu się podwajała w ustalonym tempie, co pchało komputery do bycia szybszymi i tańszymi.

Argument Kurzweila nie brzmi „prawo Moore'a będzie trwać wiecznie”. Jest szerszy: nawet jeśli jedno podejście sprzętowe zwolni, inne metody (lepsze układy, GPU/TPU, równoległość, nowe architektury, wydajność oprogramowania) mogą utrzymać ogólny trend poprawy stosunku koszt/wydajność.

Dlaczego myślenie liniowe wprowadza w błąd

Ludzie często przewidują przyszłość, przedłużając ostatnie tempo zmian liniowo. To pomija efekt składany. Może sprawić, że wczesny postęp wygląda nieimponująco — a późniejszy postęp wydaje się „nagle” się pojawić, choć przez lata budował się przewidywalnie na krzywej.

Jakie dane wspierają (i ograniczają) te prognozy

Prototypuj, nie tylko przewiduj

Zamień pomysły o harmonogramie AI w działający prototyp, nie angażując się na długo.

Prognozy takie jak Kurzweila zwykle zaczynają się od mierzalnych trendów — rzeczy, które można umieścić na wykresie. To zaleta: można debatować o wejściach zamiast polegać wyłącznie na intuicji. To też miejsce, gdzie pojawiają się największe ograniczenia.

„Łatwe do zmierzenia” krzywe: obliczenia, pamięć, przepustowość, koszt

Prognozujący technologię często śledzą:

- Obliczenia (ile operacji można kupić za dolara),

- Pamięć (ile danych można przechować za dolara),

- Przepustowość (jak szybko można przenosić dane i w jakiej cenie),

- Spadki kosztów (dla chipów, instancji w chmurze, treningów i energii na jednostkę pracy).

Te krzywe są przekonujące, bo trwają długo i są często aktualizowane. Jeśli twoje widzenie AGI to „wystarczający sprzęt plus właściwe oprogramowanie”, te zbiory danych mogą wydawać się solidnym fundamentem.

Postęp sprzętowy ≠ postęp zdolności

Główna luka: więcej sprzętu nie daje automatycznie mądrzejszych systemów. Zdolności AI zależą od algorytmów, jakości danych, receptur treningowych, narzędzi i sprzężenia zwrotnego od ludzi — nie tylko od FLOPów.

Użyteczny obraz: sprzęt to budżet, zdolność to wynik. Relacja między nimi jest realna, ale nie stała. Czasem drobna zmiana algorytmiczna odblokowuje duże zyski; czasem skalowanie napotyka malejące zwroty.

Dlaczego benchmarki i zastosowania w rzeczywistości mają znaczenie

Aby połączyć „wejścia” (obliczenia, pieniądze) z „wyjściami” (co modele faktycznie potrafią), prognozujący potrzebują:

- Benchmarków mierzących rozumowanie, planowanie i uogólnianie — nie tylko dopasowywanie wzorców,

- Wydajności w świecie rzeczywistym w złożonych środowiskach: niezawodność, bezpieczeństwo, zadania długoterminowe i adaptacyjność.

Benchmarki da się zmanipulować, więc najbardziej przekonujące sygnały łączą wyniki testów z dowodami trwałej użyteczności.

Typowe pułapki: schludne wykresy, ukryte wąskie gardła

Dwa częste błędy to wybieranie krzywych (dobieranie okien czasowych, które wyglądają najbardziej wykładniczo) oraz ignorowanie wąskich gardeł jak ograniczenia energetyczne, limity danych, opóźnienia, regulacje lub trudność przekształcenia wąskiej kompetencji w ogólną kompetencję. Nie przekreślają one prognozowania — ale powiększają margines błędu.

Kluczowe założenia stojące za prognozami na dekady

Długoterminowe harmonogramy AGI — w tym Kurzweila — zależą mniej od pojedynczego „momentu przełomowego”, a bardziej od stosu założeń, z których każde musi się sprawdzić. Jeśli któraś warstwa osłabnie, data może się przesunąć, nawet jeśli ogólny postęp będzie trwał.

1) Obliczenia, algorytmy i dane nadal się kumulują

Większość prognoz na dekady zakłada, że trzy krzywe rosną razem:

- Skala obliczeń staje się tańsza i łatwiejsza do wdrożenia (więcej chipów, większe klastry, lepsze wykorzystanie).

- Postęp algorytmiczny nadal dostarcza znaczących zysków efektywności — tak że każda jednostka obliczeń daje więcej zdolności.

- Dostępność danych pozostaje wystarczająca, czy to dzięki nowym źródłom (dane multimodalne), danym syntetycznym, lepszym narzędziom etykietowania czy poprawionej samonadzorowanej nauce.

Ukryte założenie: te trzy czynniki nie zastępują się idealnie. Jeśli jakość danych utkwi, „dodanie obliczeń” może dawać mniejsze korzyści.

2) Ograniczenia fizyczne i przemysłowe nie blokują tempa

Prognozy często traktują obliczenia jako gładką krzywą, ale rzeczywistość przebiega przez fabryki i sieci energetyczne.

Koszty energii, zdolności produkcyjne chipów, kontrole eksportowe, przepustowość pamięci, sprzęt sieciowy i wstrząsy w łańcuchu dostaw mogą ograniczać skalowanie treningów i wdrożeń. Nawet jeśli teoria mówi „10× więcej obliczeń”, droga do tego może być wyboista i kosztowna.

3) Systemy ludzkie pozwalają na szybkie wdrożenie

Prognozy na dekady zakładają też, że społeczeństwo nie spowolni adopcji nadmiernie:

Regulacje, odpowiedzialność, zaufanie publiczne, integracja w miejscu pracy i zwrot z inwestycji wpływają na to, czy zaawansowane systemy są trenowane i szeroko wykorzystywane — czy raczej utrzymywane w wąskich, wysokofrakcyjnych zastosowaniach.

4) Zyski zdolności przekładają się na ogólność

Może to być najważniejsze założenie: ulepszenia zdolności wynikające ze skalowania (lepsze rozumowanie, planowanie, używanie narzędzi) naturalnie zbliżają się do ogólnej inteligencji.

„Więcej obliczeń” może dać modele bardziej płynne i użyteczne, ale niekoniecznie bardziej ogólne w sensie niezawodnego transferu między domenami, autonomii długoterminowej czy stabilnych celów. Długoterminowe harmonogramy często zakładają, że te luki to problemy inżynieryjne — a nie bariery fundamentalne.

Co może opóźnić AGI (nawet jeśli trendy się utrzymają)

Nadaj wygląd produkcyjny

Wprowadź produkt w wersji produkcyjnej, przypisując mu własną domenę.

Nawet gdy moc obliczeniowa i rozmiary modeli będą nadal rosnąć, AGI może pojawić się później niż przewidują niektórzy, z powodów mało związanych z samą szybkością. Kilka wąskich gardeł dotyczy tego, co budujemy i jak to weryfikujemy.

1) Definicja problemu może pozostać nieostra

„AGI” nie jest pojedynczą funkcją, którą można włączyć. Użyteczna definicja zwykle sugeruje agenta, który potrafi szybko uczyć się nowych zadań, przenosić umiejętności między domenami, planować na długi termin i radzić sobie z nieporządkiem i zmiennymi celami z wysoką niezawodnością.

Jeśli cel będzie się przesuwać — asystent czatu vs. autonomiczny pracownik vs. rozumny na poziomie naukowca — postęp może wyglądać imponująco, a jednak brakować kluczowych zdolności jak pamięć długoterminowa, rozumowanie przyczynowe czy spójne podejmowanie decyzji.

2) Mierzenie AGI jest trudniejsze niż mierzenie GPU

Benchmarki można zmanipulować, przeuczyć lub zrobić je nieaktualnymi. Sceptycy chcą zwykle dowodu, że AI potrafi odnosić sukces w nierozpoznanych zadaniach, pod nowymi ograniczeniami, z niskim poziomem błędów i powtarzalnymi wynikami.

Jeśli branża nie osiągnie porozumienia co do testów, które wyraźnie rozdzielają „doskonałe uzupełnianie wzorców” od „ogólnej kompetencji”, harmonogramy staną się spekulacją — a ostrożność może spowolnić wdrożenie.

3) Alignment i bezpieczeństwo mogą stać się czynnikiem spowalniającym

Zdolności mogą rosnąć szybciej niż kontrolowalność. Jeśli systemy staną się bardziej agentowe, podnosi się poprzeczka w zapobieganiu oszustwom, dryfowi celów i szkodliwym skutkom ubocznym.

Regulacje, audyty i inżynieria bezpieczeństwa mogą dodać czasu, nawet jeśli modele szybko się poprawiają — szczególnie w zastosowaniach wysokiego ryzyka.

4) Uczenie w świecie rzeczywistym i interakcja fizyczna pozostają otwartymi kwestiami

Wiele definicji AGI domyślnie zakłada kompetencje w świecie fizycznym: manipulowanie obiektami, prowadzenie eksperymentów, obsługa narzędzi i adaptacja do informacji zwrotnej w czasie rzeczywistym.

Jeśli nauka w rzeczywistym świecie okaże się bardzo zasobochłonna, powolna lub ryzykowna, AGI może ugrzęznąć na etapie „genialne w ekranie”, podczas gdy praktyczna ogólność poczeka na lepszą robotykę, symulacje i bezpieczne metody treningu.

Główne krytyki podejścia Kurzweila

Prognozy Kurzweila są wpływowe częściowo dlatego, że są jasne i ilościowe — ale ta sama klarowność przyciąga ostre krytyczne uwagi.

1) Ekstrapolowanie przeszłych trendów może ukryć „zmiany reżimu”

Częsta uwaga to fakt, że Kurzweil mocno polega na przedłużaniu historycznych krzywych (obliczenia, pamięć, przepustowość). Krytycy twierdzą, że technologia nie zawsze skaluje gładko: postęp w chipach może zwolnić, koszty energii mogą stać się istotne, a bodźce ekonomiczne mogą się przesunąć. Nawet jeśli długoterminowy kierunek jest wzrostowy, tempo może zmienić się w sposób, który czyni konkretne daty zawodnymi.

2) Złożone systemy nie dostarczają przełomów na zamówienie

AGI to nie tylko szybszy sprzęt. To problem systemowy obejmujący algorytmy, dane, metody trenowania, ewaluację, ograniczenia bezpieczeństwa i adopcję społeczną. Przełomy mogą blokować pojedyncze brakujące idee — coś, czego nie da się wiarygodnie „zkalendariozować”. Sceptycy wskazują, że nauka często postępuje nierównomiernie: długie płaskie okresy, a potem nagłe skoki.

3) Efekty selekcji sprawiają, że odważne prognozy wyglądają lepiej

Inny zarzut to psychologia: pamiętamy dramatyczne trafienia znacznie bardziej niż ciche pudła lub bliskie niepowodzenia. Jeśli ktoś formułuje wiele mocnych prognoz, kilka pamiętnych trafień może zdominować postrzeganie publiczne. To nie znaczy, że prognosta jest „zły”, ale może zawyżać pewność co do dokładności harmonogramów.

4) Dlaczego mądrzy ludzie nie zgadzają się co do terminów

Nawet eksperci, którzy akceptują szybki postęp AI, różnią się w ocenie, co „liczy się” jako AGI, jakie zdolności muszą uogólnić i jak to mierzyć. Małe różnice definicyjne (szerokość zadań, autonomia, niezawodność, uczenie się w realnym świecie) mogą przesunąć prognozy o dekady — bez zmiany podstawowego poglądu na obecny postęp.

Jak inni eksperci prognozują harmonogramy AGI

Kurzweil to jeden z głośniejszych głosów, ale harmonogramy AGI to zatłoczona debata. Użyteczne mapowanie to obóz krótkoterminowy (AGI w ciągu kilku lat do dekady) kontra obóz długoterminowy (kilkadziesiąt lat lub „nie w tym stuleciu”). Często patrzą na te same trendy, ale różnią się w ocenie, co jest brakujące: zwolennicy krótkiego terminu podkreślają szybkie skalowanie i emergentne zdolności, a obóz długoterminowy wskazuje na nierozwiązane problemy, jak niezawodne rozumowanie, autonomia i odporność w realnym świecie.

Popularne podejścia do prognozowania (poza ekstrapolacją)

Ankiety ekspertów agregują przekonania badaczy i praktyków (np. ankiety pytające o 50% szansę na „AI na poziomie ludzkim”). Mogą ujawnić zmieniające się nastroje, ale odzwierciedlają też, kogo badano i jak formułowano pytania.

Planowanie scenariuszowe unika wskazywania jednej daty. Zamiast tego szkicuje wiele prawdopodobnych przyszłości (szybki postęp, wolny postęp, wąskie gardła regulacyjne, ograniczenia sprzętowe) i pyta, jakie sygnały wskazywałyby każdą ścieżkę.

Prognozowanie oparte na benchmarkach i zdolnościach śledzi konkretne kamienie milowe (zadania związane z kodowaniem, rozumowanie naukowe, niezawodność agentów) i szacuje, jak szybko muszą się poprawiać, by osiągnąć szerszą kompetencję.

Definicje zmieniają datę

„AGI” może oznaczać zdanie szerokiego zestawu testów, wykonywanie większości zawodów, działanie jako autonomiczny agent lub dorównanie ludziom w wielu domenach przy minimalnym nadzorze. Bardziej restrykcyjna definicja zwykle przesuwa termin dalej, a rozbieżności w definicjach wyjaśniają dużą część rozrzutu prognoz.

Najbliższe do konsensusu: niepewność

Nawet optymistyczni i sceptyczni eksperci zgadzają się co do jednego punktu: harmonogramy są wyjątkowo niepewne, i prognozy powinny być traktowane jako zakresy z założeniami — nie jako zobowiązania kalendarzowe.

Sygnały, które warto obserwować w ciągu najbliższych 5–10 lat

Zrealizuj pomysł na mobile

Rozpocznij aplikację Flutter z czatu i trzymaj funkcje blisko opinii użytkowników.

Prognozy AGI mogą wydać się abstrakcyjne, więc pomaga śledzić konkretne sygnały, które powinny przesunąć się przed jakimkolwiek „wielkim momentem”. Jeśli harmonogramy w stylu Kurzweila mają rację kierunkowo, następna dekada powinna pokazać stałe zyski w zdolnościach, niezawodności, ekonomii i zarządzaniu.

1) Wskaźniki zdolności (co systemy faktycznie potrafią)

Obserwuj modele, które wiarygodnie planują na wiele kroków, adaptują się, gdy plany zawodzą, i używają narzędzi (kod, przeglądarki, aplikacje danych) bez ciągłego nadzoru. Najważniejszy znak to nie efektowne demo, ale autonomia z jasnymi granicami: agenci kończący zadania trwające wiele godzin, zadający pytania wyjaśniające i przekazujący pracę bezpiecznie, gdy są niepewni.

2) Wskaźniki niezawodności (jak często się mylą)

Postęp będzie wyglądać jak niższe stopy błędów w realistycznych przepływach pracy, nie tylko wyższe wyniki w benchmarkach. Obserwuj, czy „halucynacje” spadają, gdy systemy muszą podawać źródła, wykonywać kontrole lub weryfikować się samodzielnie. Kluczowy kamień milowy: silne wyniki w warunkach audytu — to samo zadanie, wielokrotne uruchomienia, spójne rezultaty.

3) Wskaźniki ekonomiczne (gdzie pojawia się wartość)

Szukaj mierzalnych zysków produktywności w konkretnych rolach (wsparcie, analiza, oprogramowanie, operacje) oraz nowych kategorii pracy związanych z nadzorem i integracją AI. Ważne są też koszty: jeśli wysokiej jakości rezultaty stają się tańsze (za zadanie, za godzinę), adopcja przyspiesza — zwłaszcza w małych zespołach.

4) Wskaźniki zarządzania (jak społeczeństwo reaguje)

Jeśli zdolności rosną, zarządzanie powinno przejść od zasad do praktyki: standardy, audyty zewnętrzne, raportowanie incydentów i regulacje wyjaśniające odpowiedzialność. Obserwuj też monitorowanie obliczeń i zasady raportowania — sygnały, że rządy i przemysł traktują skalowanie jako mierzalny, kontrolowany parametr.

Jeśli chcesz korzystać z tych sygnałów bez reagowania na nagłówki, zobacz sekcję dotyczącą wskaźników postępu AI.

Praktyczne wnioski: używaj prognoz, ale im nie ufaj bezgranicznie

Harmonogramy AGI najlepiej traktować jak prognozę pogody na odległy termin: użyteczne do planowania, niepewne jako obietnica. Prognozy w stylu Kurzweila mogą pomóc zauważyć trendy długoterminowe i poddać w wątpliwość decyzje, ale nie powinny być jedynym punktem awarii w Twojej strategii.

Jak czytać prognozy AGI (bez traktowania ich jak gwarancji)

Używaj prognoz do badania zakresów i scenariuszy, a nie jednej daty. Gdy ktoś mówi „AGI do 203X”, przetłumacz to na: „Jakie zmiany musiałyby nastąpić, żeby to było prawdą — a co jeśli się nie zdarzą?” Potem planuj na kilka rezultatów.

Pytania, które warto zadać każdej prognozie

- Definicja: Co rozumieją przez „AGI”? Poziom ludzki w testach, szeroka użyteczność w pracy czy „potrafi uczyć się wszystkiego”? Różne definicje dają różne terminy.

- Dane: Jakie wskaźniki wykorzystują — obliczenia, efektywność treningu, benchmarki, tempo wdrożeń — i co pomijają?

- Założenia: Czy zakładają, że algorytmy, dostępność danych, energia, chipy i zarządzanie będą się rozwijać bez zakłóceń?

- Motywacje: Czy autor prognozy sprzedaje produkt, pozyskuje finansowanie lub lobbinguje za polityką? Motywacje mogą wpływać na pewność i terminy.

Planowanie praktyczne: umiejętności, strategia i świadomość ryzyka

Dla osób: rozwijaj trwałe umiejętności (formułowanie problemów, wiedza domenowa, komunikacja) i utrzymuj nawyk uczenia się nowych narzędzi.

Dla firm: inwestuj w alfabetyzację AI, jakość danych i pilotażowe projekty z jasnym ROI — równocześnie mając plan „bez żalu”, który działa, nawet jeśli AGI pojawi się później.

Praktyczny sposób operacjonalizacji "obserwuj sygnały i iteruj" to skrócenie cykli budowy: prototypuj przepływy pracy, testuj niezawodność i kwantyfikuj zyski produktywności przed podjęciem dużych decyzji. Platformy takie jak Koder.ai pasują do tego podejścia, pozwalając zespołom tworzyć aplikacje webowe, backendy i mobilne przez interfejs czatu (z trybem planowania, migawkami i możliwością rollbacku), aby szybko testować procesy wspomagane agentami, eksportować kod źródłowy w razie potrzeby i nie uzależniać strategii od jednej prognozy.

Zrównoważone podsumowanie: harmonogramy mogą kierować przygotowaniami, nie stanowią pewności. Używaj ich do priorytetyzowania eksperymentów i zredukowania ślepych punktów — a potem regularnie weryfikuj swoje założenia w świetle nowych dowodów.