Dlaczego klienci się gubią przez limity

Limity szybkości i kwoty brzmią podobnie, więc ludzie często traktują je jak to samo. Rate limit określa, jak szybko możesz wywoływać API (zapytania na sekundę lub na minutę). Kwota to ile możesz użyć w dłuższym okresie (na dzień, miesiąc lub cykl rozliczeniowy). Oba są normalne, ale wydają się losowe, gdy zasady nie są widoczne.

Klasyczna skarga brzmi: „działało wczoraj”. Użycie rzadko jest stałe. Krótkie skoki mogą przepchnąć kogoś ponad próg, nawet gdy ich dzienny total wygląda dobrze. Wyobraź sobie klienta, który uruchamia raport raz dziennie, ale dziś job powtarza się po timeoutcie i robi 10× więcej wywołań w 2 minuty. API go blokuje, a on widzi tylko nagłą awarię.

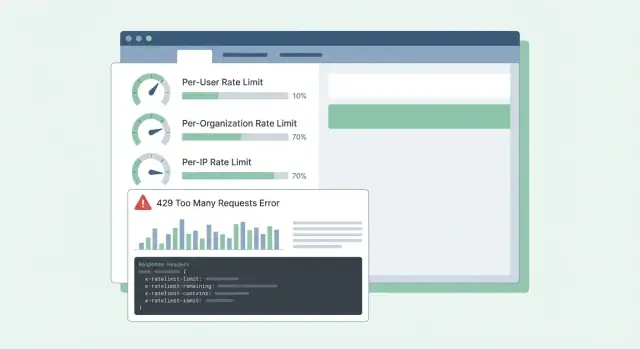

Zamieszanie pogłębiają niejasne błędy. Jeśli API zwraca 500 lub ogólny komunikat, klienci zakładają, że usługa jest nieczynna, a nie że osiągnęli limit. Otwierają pilne tickety, tworzą obejścia albo zmieniają dostawcę. Nawet 429 Too Many Requests może frustrować, jeśli nie mówi, co zrobić dalej.

Większość SaaS API ogranicza ruch z dwóch powodów:

- Zatrzymać nadużycia: chronić system przed scrapingiem, brute force lub uruchomionymi skryptami.

- Kształtować normalne użycie: utrzymać wydajność dla wszystkich, szczególnie w godzinach szczytu.

Mieszanie tych celów prowadzi do złych projektów. Kontrole przeciw nadużyciom są często per-IP lub per-token i mogą być surowe. Kształtowanie normalnego użycia zwykle jest per-user lub per-org i powinno iść w parze z jasnymi wskazówkami: który limit został przekroczony, kiedy nastąpi reset i jak unikać ponownego przekroczenia.

Kiedy klienci mogą przewidzieć limity, planują z nimi. Kiedy nie mogą, każdy skok wydaje się zepsutym API.

Zdecyduj, co chronisz

Limity to nie tylko przepustnica. To system bezpieczeństwa. Zanim wybierzesz liczby, określ jasno, co chcesz chronić, bo każdy cel prowadzi do innych limitów i innych oczekiwań.

Dostępność jest zwykle najważniejsza. Jeśli kilku klientów może spowodować skoki i doprowadzić Twoje API do timeoutów, wszyscy cierpią. Limity tu powinny utrzymywać serwery responsywne podczas nagłych wzrostów i szybko odrzucać zamiast pozwalać na gromadzenie się żądań.

Koszt jest cichym motywatorem wielu API. Niektóre żądania są tanie, inne drogie (wywołania LLM, przetwarzanie plików, zapisy do magazynu, płatne zewnętrzne odpytywania). Na platformie takiej jak Koder.ai pojedynczy użytkownik może wyzwolić wiele wywołań modeli przez czatową generację aplikacji. Limity śledzące kosztowne akcje mogą zapobiec niespodziewanym rachunkom.

Nadużycia wyglądają inaczej niż duże, legalne użycie. Credential stuffing, zgadywanie tokenów i scraping często objawiają się jako wiele małych zapytań z wąskiego zbioru IP lub kont. Tu chcesz surowych limitów i szybkiego blokowania.

Sprawiedliwość ma znaczenie w systemach multi-tenant. Jeden hałaśliwy klient nie powinien degradawać wszystkich innych. W praktyce oznacza to często warstwowanie kontroli: ochrona przed burstami, kontrola kosztów dla drogich endpointów/akcji, ochrona przed nadużyciami skupiona na auth i podejrzanych wzorcach oraz strażnik sprawiedliwości, żeby jedna organizacja nie zagłuszyła innych.

Prosty test pomaga: wybierz jeden endpoint i zapytaj „jeśli to żądanie zwiększy się 10×, co najpierw się zepsuje?” Odpowiedź mówi, który cel ochrony priorytetyzować i która oś (user, org, IP) powinna mieć limit.

Wybierz właściwe wymiary limitowania

Większość zespołów zaczyna od jednego limitu i później odkrywa, że szkodzi niewłaściwym ludziom. Celem jest wybór wymiarów pasujących do rzeczywistego użycia: kto dzwoni, kto płaci i co wygląda jak nadużycie.

Typowe wymiary w SaaS wyglądają tak:

- Per user: zatrzymuje jednego ciężkiego użytkownika przed spowalnianiem reszty tego samego konta.

- Per org/workspace: daje wyraźny sufit na całkowite użycie tenantów (często to, co sprzedają plany billingowe).

- Per IP: łapie boty, credential stuffing i źle skonfigurowanych klientów bijących z jednego adresu.

- Per API key/token: użyteczne dla partnerów i integracji, gdzie „user” nie ma sensu albo jest współdzielony.

Limity per-user dotyczą sprawiedliwości wewnątrz tenantów. Jeśli jedna osoba uruchamia duży eksport, to ona powinna odczuć spowolnienie bardziej niż reszta zespołu.

Limity per-org dotyczą budżetu i pojemności. Nawet jeśli dziesięciu użytkowników uruchomi zadania jednocześnie, organizacja nie powinna skoczyć do poziomu, który zepsuje usługę lub Twoje założenia cenowe.

Limity per-IP traktuj raczej jako siatkę bezpieczeństwa niż narzędzie billingowe. IP mogą być współdzielone (NAT biura, operatorzy mobilni), więc trzymaj te limity łagodne i polegaj na nich głównie do zatrzymywania oczywistych nadużyć.

Gdy łączysz wymiary, zdecyduj, który „wygrywa”, gdy kilka limitów ma zastosowanie. Praktyczna zasada: odrzuć żądanie, jeśli którykolwiek odpowiedni limit jest przekroczony, i zwróć najbardziej pomocny powód. Jeśli workspace przekroczy swoją kwotę org, nie obwiniaj użytkownika ani IP.

Przykład: workspace Koder.ai na planie Pro może pozwalać na stały przepływ buildów per-org, a jednocześnie ograniczać pojedynczego użytkownika przed wysłaniem setek żądań w minutę. Jeśli integracja partnera używa jednego współdzielonego tokena, limit per-token może zapobiec zagłuszeniu użytkowników interaktywnych.

Algorytmy, które działają w produkcji

Większość problemów z limitowaniem to nie matematyka. To wybór zachowania pasującego do sposobu, w jaki klienci wywołują API, i utrzymanie przewidywalności pod obciążeniem.

Token bucket jest popularnym domyślnym rozwiązaniem, ponieważ pozwala na krótkie bursty przy jednoczesnym egzekwowaniu stałej średniej. Użytkownik odświeżający dashboard może wywołać 10 szybkich zapytań. Token bucket pozwoli, jeśli zgromadził tokeny, potem spowolni.

Leaky bucket jest bardziej restrykcyjny. Wygładza ruch do stałego wypływu, co pomaga, gdy backend nie radzi sobie ze skokami (np. kosztowne generowanie raportów). W zamian klienci odczuwają ograniczenie wcześniej, bo burst zamienia się na kolejkę lub odrzucenie.

Licznik okienkowy (window-based) jest prosty, ale detale mają znaczenie. Stałe okna dają ostre krawędzie na granicy (użytkownik może robić burst o 12:00:59 i znowu o 12:01:00). Sliding windows wydają się sprawiedliwsze i redukują skoki na granicach, ale wymagają więcej stanu lub lepszych struktur danych.

Osobną klasą limitów jest współbieżność (in-flight requests). To chroni przed wolnymi połączeniami klientów i długimi endpointami. Klient może trzymać się 60 requestów/min, a mimo to przeciążyć Cię trzymając 200 otwartych requestów jednocześnie.

W prawdziwych systemach zespoły często łączą kilka kontroli: token bucket dla ogólnej prędkości, limit równoległości dla wolnych lub ciężkich endpointów oraz oddzielne budżety dla grup endpointów (tanie odczyty kontra kosztowne eksporty). Jeśli ograniczasz tylko liczbę zapytań, jeden kosztowny endpoint może zająć wszystko i sprawić, że API będzie wydawać się losowo zepsute.

Projektowanie kwot zgodnych z cenami i użyciem

Ship a quotas dashboard

Zbuduj po drodze widok admina w React pokazujący użycie, pozostały budżet i czasy resetu.

Dobre kwoty wydają się uczciwe i przewidywalne. Klienci nie powinni odkrywać zasad dopiero po zablokowaniu.

Zachowaj jasne rozdzielenie:

- Krótkoterminowe limity (np. 10 requestów/sekundę) chronią usługę przed skokami.

- Długoterminowe kwoty (dziennie/miesięcznie) chronią koszty i utrzymują porównywalność planów cenowych.

Wiele zespołów używa obu: krótki limit, by zatrzymać bursty, plus miesięczna kwota związana z cenami.

Hard vs soft limits to głównie decyzja wsparcia. Hard blockuje natychmiast. Soft najpierw ostrzega, potem blokuje. Soft limits zmniejszają wściekłe tickety, bo dają szansę naprawić błąd lub zaktualizować plan.

Kiedy ktoś przekroczy limit, zachowanie powinno odpowiadać temu, co chronisz. Blokowanie działa, gdy nadmierne użycie mogłoby zaszkodzić innym tenantom lub eksplodować koszty. Degradacja (wolniejsze przetwarzanie lub niższy priorytet) działa, gdy wolisz, żeby ruch się toczył. „Bill later” może działać, gdy użycie jest przewidywalne i masz już przepływ rozliczeń.

Limity oparte na progach planów działają najlepiej, gdy każdy tier ma jasny „oczekiwany kształt użycia”. Darmowy plan może mieć małe miesięczne kwoty i niskie bursty, podczas gdy business i enterprise mają większe kwoty i większe limity burstów, żeby zadania w tle mogły się szybko zakończyć. Podobnie jak w Koder.ai, gdzie Free, Pro, Business i Enterprise mają różne oczekiwania co do tego, ile można zrobić zanim trzeba awansować.

Wczesne wspieranie limitów niestandardowych jest warte wysiłku, szczególnie dla enterprise. Czyste podejście to „domyślne według planu, nadpisania przez klienta”. Przechowuj override ustawiony przez admina per-org (i czasem per-endpoint) i upewnij się, że przetrwa zmianę planu. Zdecyduj też, kto może prosić o zmiany i jak szybko wchodzą w życie.

Przykład: klient importuje 50 000 rekordów w ostatnim dniu miesiąca. Jeśli miesięczna kwota jest prawie wykorzystana, miękkie ostrzeżenie przy 80–90% daje czas na zatrzymanie. Krótki limit per-second zapobiega zalaniu API przez import. Zatwierdzone override per-org (tymczasowe lub stałe) pozwala biznesowi działać dalej.

Krok po kroku: implementacja limitów w SaaS API

Zacznij od spisania, co będziesz liczyć i do kogo to należy. Większość zespołów kończy z trzema tożsamościami: zalogowany użytkownik, organizacja klienta (workspace) i IP klienta.

Praktyczny plan:

- Zdefiniuj zasady identyfikacji: user ID z auth, org ID z tokena lub API key, IP z pierwszego zaufanego hopu proxy (bądź eksplicytna co do nagłówka, któremu ufasz).

- Grupuj endpointy według kosztu: odczyty, zapisy, ciężkie eksporty, flowy auth. Daj każdej grupie różne limity, żeby jeden drogi endpoint nie wyssał całego budżetu.

- Wybierz, gdzie trzymać liczniki: in-memory dla pojedynczej instancji, Redis dla współdzielonych limitów między serwerami, a baza danych tylko do wolniejszych, audytowych kwot. Użyj TTL odpowiadających oknu (np. 60 sekund dla limitów per-minute).

- Egzekwuj konsekwentnie: rób wstępne blokowanie na krawędzi (gateway/CDN) dla fal IP, potem drobniejsze sprawdzenia per-user/org w middleware aplikacji, gdzie widzisz trasę i tenant.

- Instrumentuj wszystko: śledź stopę blokad (429s), latencję dodaną przez limiter oraz top klucze blokowane. Alertuj, gdy bloki rosną lub gdy błędy Redis zmuszają do „fail open/closed”.

Przy ustalaniu limitów myśl w kategoriach tierów i grup endpointów, nie jednej globalnej liczby. Częsty błąd to poleganie na licznikach in-memory na wielu serwerach. Liczniki się nie zgadzają i użytkownicy widzą „losowe” 429. Wspólny magazyn jak Redis utrzymuje limity stabilne między instancjami, a TTLy utrzymują stan mały.

Rollout ma znaczenie. Zacznij w trybie „report only” (loguj, co byłoby zablokowane), potem egzekwuj jedną grupę endpointów, potem rozszerzaj. Dzięki temu unikniesz budzenia się w lawinie ticketów do supportu.

Uczyń limity zrozumiałymi przez odpowiedzi i nagłówki

Gdy klient trafia na limit, najgorszy wynik to zamieszanie: „Czy wasze API leży, czy zrobiłem coś źle?” Jasne, spójne odpowiedzi obniżają liczbę ticketów i pomagają ludziom naprawić zachowanie klienta.

Używaj HTTP 429 Too Many Requests, gdy aktywnie blokujesz wywołania. Trzymaj ciało odpowiedzi przewidywalne, żeby SDK i dashboardy mogły to czytać.

Oto prosty format JSON, który dobrze działa przy per-user, per-org i per-IP limits:

{

"error": {

"code": "rate_limit_exceeded",

"message": "Rate limit exceeded for org. Try again later.",

"limit_scope": "org",

"reset_at": "2026-01-17T12:34:56Z",

"request_id": "req_01H..."

}

}

Nagłówki powinny wyjaśniać bieżące okno i co klient może zrobić dalej. Jeśli dodasz tylko kilka, zacznij od: RateLimit-Limit, RateLimit-Remaining, RateLimit-Reset, Retry-After i X-Request-Id.

Przykład: czyjś job cron uruchamiany co minutę nagle zaczyna się nie powodzić. Z 429 plus RateLimit-Remaining: 0 i Retry-After: 20 natychmiast wiedzą, że to limit, a nie awaria, i mogą opóźnić retry o 20 sekund. Jeśli podadzą X-Request-Id do supportu, łatwo znajdziesz zdarzenie.

Jeszcze jedna uwaga: zwracaj te same nagłówki także przy udanych odpowiedziach. Klienci zobaczą, że zbliżają się do progu zanim go przekroczą.

Zachowanie klienta: retry, backoff i bezpieczne zapisy

Turn rules into clear client docs

Wygeneruj wskazówki dla klientów dotyczące backoffu, jitter, limitów równoległości i kiedy nie retry'ować.

Dobrzy klienci sprawiają, że limity wydają się sprawiedliwe. Źli klienci zamieniają tymczasowy limit w awarię, bo uderzają mocniej.

Gdy otrzymasz 429, traktuj to jako sygnał do zwolnienia. Jeśli odpowiedź mówi, kiedy spróbować ponownie (np. przez Retry-After), poczekaj co najmniej tyle. Jeśli nie, użyj wykładniczego backoffu i dołóż jitter (losowość), żeby tysiąc klientów nie retry'owało w tym samym momencie.

Ogranicz retry: nałóż limit opóźnienia między próbami (np. 30–60 sekund) i limit całkowitego czasu retry (np. przerwij po 2 minutach i pokaż błąd). Loguj zdarzenie z detalami limitu, aby deweloperzy mogli później dostroić.

Nie retry'uj wszystkiego. Wiele błędów nie powiedzie się bez zmiany lub działań użytkownika: 400 walidacja, 401/403 błędy auth, 404 nie znaleziono oraz 409 konflikty odzwierciedlające realne reguły biznesowe.

Retry na endpointach zapisujących (create, charge, send email) jest ryzykowny — timeout i retry mogą stworzyć duplikaty. Używaj idempotency keys: klient wysyła unikalny klucz dla logicznej akcji, a serwer zwraca ten sam wynik dla powtórek z tym kluczem.

Dobre SDK mogą to ułatwić, pokazując deweloperom: status (429), ile czekać, czy żądanie jest bezpieczne do retry oraz komunikat typu „Rate limit exceeded for org. Retry after 8s or reduce concurrency.”

Częste błędy wywołujące gniewne tickety

Większość ticketów o limitach nie dotyczy samego limitu. Chodzi o niespodzianki. Jeśli użytkownicy nie mogą przewidzieć, co się stanie dalej, zakładają, że API jest zepsute lub niesprawiedliwe.

Używanie tylko limitów per-IP to częsty błąd. Wiele zespołów działa z jednego publicznego IP (Wi‑Fi biura, operator mobilny, cloud NAT). Jeśli ograniczasz po IP, jeden zajęty klient może zablokować wszystkich w tej samej sieci. Preferuj per-user i per-org, a per-IP używaj głównie jako siatki bezpieczeństwa.

Inny problem to traktowanie wszystkich endpointów równo. Tanie GET i ciężki eksport nie powinny dzielić tego samego budżetu. Wtedy klienci przepalają limit podczas zwykłego przeglądania i dostają blokadę przy próbie wykonania realnego zadania. Oddziel kubełki według grup endpointów lub waż żądania według kosztu.

Timing resetu także musi być eksplicytne. „Resetuje codziennie” to za mało. W jakiej strefie czasowej? Okno przesuwane czy reset o północy? Jeśli robisz reset kalendarzowy, powiedz strefę. Jeśli rolling windows, powiedz długość okna.

Wreszcie niejasne błędy tworzą chaos. Zwracanie 500 lub ogólnego JSON powoduje, że ludzie retry'ują mocniej. Użyj 429 i dołącz nagłówki RateLimit, żeby klienci mogli się inteligentnie wycofać.

Przykład: zespół buduje integrację Koder.ai z sieci korporacyjnej — kapu IP-only może zablokować całą ich organizację i wyglądać jak losowe awarie. Jasne wymiary i czytelne 429 temu zapobiegają.

Szybka lista kontrolna przed wdrożeniem

Keep control with code export

Zbuduj w Koder.ai, a potem eksportuj kod źródłowy, gdy będziesz gotowy.

Zanim włączysz limity dla wszystkich, zrób finalny przegląd skupiony na przewidywalności:

- Zdefiniuj limity według tieru cenowego i grup endpointów (auth, reads, writes, exports). Zachowaj mały bufor bezpieczeństwa dla podstawowych czynności jak logowanie i refresh tokena.

- Uczyń zasady identyfikacji deterministycznymi i udokumentowanymi. Zdecyduj dokładnie, jak liczysz (user, org, API key, IP) i co ma pierwszeństwo.

- Spraw, by odpowiedzi 429 były samoopisowe. Dołącz Retry-After oraz nagłówki RateLimit (Limit, Remaining, Reset). W ciele JSON krótka wiadomość, który limit został przekroczony i kiedy retry.

- Monitoruj zarówno skoki, jak i false positives. Śledź 429 wg grup endpointów, top callerów i nagłe spadki w udanych odpowiedziach. Alertuj, gdy bloki rosną.

- Miej plan wyjątków: whitelisty, tymczasowe zwiększenia, emergency overrides i osoby, które mogą je zatwierdzić.

Sprawdź intuicyjnie: jeśli Twój produkt ma tierów jak Free, Pro, Business, Enterprise (jak Koder.ai), powinieneś umieć w prostych słowach wyjaśnić, co normalny klient może zrobić na minutę i na dzień, i które endpointy traktowane są inaczej.

Jeśli nie potrafisz jasno wytłumaczyć 429, klienci założą, że API jest zepsute, a nie że chroni usługę.

Przykładowy plan wdrożenia i następne kroki

Wyobraź sobie B2B SaaS, gdzie ludzie pracują w workspace (org). Kilku power userów uruchamia ciężkie eksporty, a wielu pracowników siedzi za jednym współdzielonym IP biura. Jeśli ograniczasz tylko po IP, blokujesz całe firmy. Jeśli tylko per-user, skrypt nadal może zaszkodzić całemu workspace.

Praktyczne podejście miesza:

- Per-user burst limit dla krótkich skoków.

- Per-org sustained limit, by workspace było uczciwe w czasie.

- Per-IP abuse guard, by łapać wyciekłe tokeny, boty i hałaśliwe sieci współdzielone.

Gdy ktoś trafia na limit, Twoja wiadomość powinna powiedzieć, co się stało, co zrobić dalej i kiedy retry. Support powinien móc stanąć za sformułowaniem takim jak:

„Request rate exceeded for workspace ACME. You can retry after 23 seconds. If you are running an export, reduce concurrency to 2 or schedule it off-peak. If this blocks normal use, reply with your workspace ID and timestamp and we can review your quota.”

Sparuj to z Retry-After i spójnymi nagłówkami RateLimit, aby klienci nie musieli zgadywać.

Plan wdrożenia unikający niespodzianek: najpierw observe-only, potem warn (nagłówki i miękkie ostrzeżenia), potem enforce (429 z jasnym czasem retry), potem dostrajaj progi wg tieru, a następnie przegląd po dużych launchach i onboardingu klientów.

Jeśli chcesz szybko przenieść te pomysły do działającego kodu, platforma vibe-coding jak Koder.ai (koder.ai) może pomóc naszkicować krótki spec limitów i wygenerować middleware w Go, które to konsekwentnie egzekwuje w serwisach.