23 dec 2025·7 min

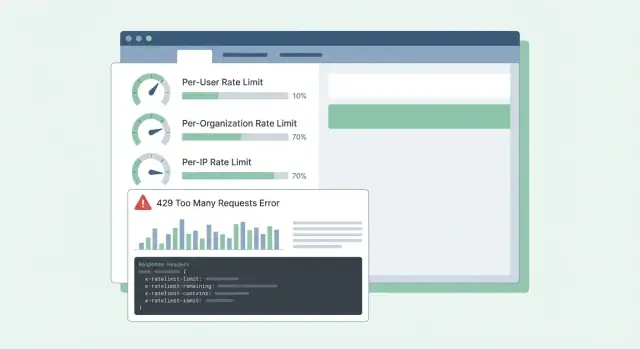

SaaS API-rate-limieten: patronen per gebruiker, organisatie en IP

Patronen voor SaaS API-rate-limieten per gebruiker, organisatie en IP, met duidelijke headers, foutantwoorden en uitroltips die klanten begrijpen.

Patronen voor SaaS API-rate-limieten per gebruiker, organisatie en IP, met duidelijke headers, foutantwoorden en uitroltips die klanten begrijpen.

Rate limits en quota klinken vergelijkbaar, dus mensen behandelen ze vaak hetzelfde. Een rate limit bepaalt hoe snel je een API kunt aanroepen (verzoeken per seconde of per minuut). Een quota bepaalt hoeveel je kunt gebruiken over een langere periode (per dag, per maand of per factureringsperiode). Beide zijn normaal, maar ze voelen willekeurig aan als de regels niet zichtbaar zijn.

De klassieke klacht is: “het werkte gisteren nog.” Gebruik is zelden constant. Een korte piek kan iemand over de limiet duwen, zelfs als het dagtotaal er goed uitziet. Stel je een klant voor die één keer per dag een rapport draait, maar vandaag herhaalt de taak na een timeout en doet in 2 minuten 10× meer calls. De API blokkeert ze en alles wat zij zien is een plotselinge fout.

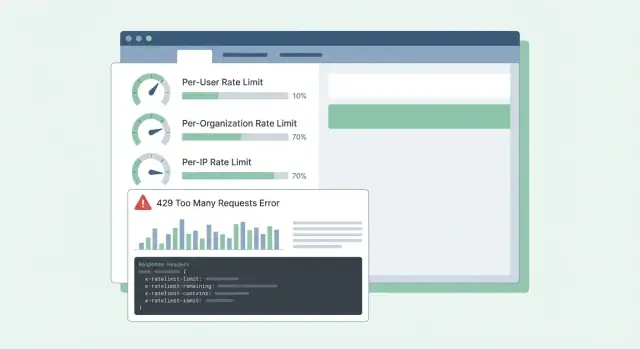

De verwarring wordt erger als fouten vaag zijn. Als de API 500 terugstuurt of een generieke boodschap, denken klanten dat je service down is, niet dat ze een limiet raakten. Ze maken urgente tickets aan, bouwen workarounds of stappen over naar een andere provider. Zelfs 429 Too Many Requests kan frustrerend zijn als het niet zegt wat ze daarna moeten doen.

De meeste SaaS-API’s limiteren verkeer om twee verschillende redenen:

Het mixen van deze doelen leidt tot slechte ontwerpen. Abuse-controls zijn vaak per-IP of per-token en kunnen streng zijn. Normale gebruiksregeling is meestal per-gebruiker of per-organisatie en zou duidelijke aanwijzingen moeten hebben: welke limiet is geraakt, wanneer het reset en hoe je het kunt vermijden.

Als klanten limieten kunnen voorspellen, plannen ze er omheen. Als dat niet kan, voelt elke piek als een kapotte API.

Rate limits zijn niet alleen een gaspedaal. Het is een veiligheidssysteem. Voordat je nummers kiest, wees duidelijk over wat je probeert te beschermen, want elk doel leidt tot verschillende limieten en verschillende verwachtingen.

Beschikbaarheid staat meestal bovenaan. Als een paar clients verkeer kunnen pieken en je API in time-outs duwen, lijden alle anderen. Limieten hier moeten servers responsief houden tijdens bursts en snel falen in plaats van verzoeken te laten opstapelen.

Kosten zijn de stille drijfveer achter veel API’s. Sommige verzoeken zijn goedkoop, andere duur (LLM-calls, bestandsverwerking, opslagwrites, betaalde third-party lookups). Bijvoorbeeld op een platform als Koder.ai kan één gebruiker veel modelcalls triggeren via chat-gebaseerde appgeneratie. Limieten die dure acties volgen kunnen verrassende rekeningen voorkomen.

Misbruik ziet er anders uit dan veel legitiem gebruik. Credential stuffing, token-raadpogingen en scraping tonen zich vaak als veel kleine verzoeken vanaf een beperkt aantal IP’s of accounts. Hier wil je strikte limieten en snelle blokkering.

Fairness is belangrijk in multi-tenant systemen. Eén luidruchtige klant mag niet iedereen anders laten degraderen. In de praktijk betekent dat vaak gelaagde controles: een burst-guard om de API gezond te houden minuut-tot-minuut, een kosten-guard voor dure endpoints of acties, een abuse-guard gericht op authenticatie en verdachte patronen, en een fairness-guard zodat één org anderen niet wegdrukt.

Een simpele test helpt: kies één endpoint en vraag: “Als dit verzoek 10× toeneemt, wat faalt er eerst?” Het antwoord vertelt welk beschermingsdoel prioriteit heeft en welke dimensie (gebruiker, org, IP) de limiet moet dragen.

De meeste teams beginnen met één limiet en ontdekken later dat het de verkeerde mensen treft. Het doel is dimensies te kiezen die bij echt gebruik passen: wie belt, wie betaalt en wat op misbruik lijkt.

Veelvoorkomende dimensies in SaaS zijn:

Per-gebruiker limieten gaan over eerlijkheid binnen een tenant. Als één persoon een grote export draait, moeten zij de vertraging vaker voelen dan de rest van het team.

Per-org limieten gaan over budget en capaciteit. Zelfs als tien gebruikers gelijktijdig jobs draaien, mag de org niet zo pieken dat jouw service of prijsassumpties breken.

Per-IP limieten moet je meer als vangnet behandelen dan als facturatiehulpmiddel. IP’s kunnen gedeeld worden (office NAT, mobiele providers), dus houd deze limieten royaal en gebruik ze vooral om duidelijk misbruik te stoppen.

Wanneer je dimensies combineert, beslis welke “wint” als meerdere limieten van toepassing zijn. Een praktische regel is: verwerp het verzoek als een relevante limiet overschreden is en geef de meest bruikbare reden terug. Als een workspace over zijn org-quota zit, geef dan niet de schuld aan de gebruiker of het IP.

Voorbeeld: een Koder.ai-workspace op een Pro-plan kan een gestage stroom build-requests per org toestaan, terwijl je ook een enkele gebruiker beperkt die honderden requests per minuut zou kunnen sturen. Als een partnerintegratie één gedeelde token gebruikt, kan een per-token limiet voorkomen dat het interactieve gebruikers verdringt.

De meeste rate-limitingproblemen gaan niet over wiskunde. Het gaat om gedrag kiezen dat past bij hoe klanten je API aanroepen en het voorspelbaar houden onder belasting.

Token bucket is een veelvoorkomende standaard omdat het korte bursts toestaat terwijl het een constant langetermijngemiddelde afdwingt. Een gebruiker die een dashboard ververs, kan 10 snelle verzoeken triggeren. Token bucket laat dat toe als ze tokens hebben opgespaard en vertraagt daarna.

Leaky bucket is strikter. Het maakt verkeer gelijkmatiger, wat helpt wanneer je backend pieken niet aankan (bijvoorbeeld dure rapportgeneratie). Het nadeel is dat klanten het eerder voelen, omdat bursts leiden tot wachtrijen of afwijzingen.

Window-gebaseerde tellers zijn simpel, maar details doen er toe. Fixed windows creëren scherpe randen op de grens (een gebruiker kan bursten op 12:00:59 en opnieuw op 12:01:00). Sliding windows voelen eerlijker en verminderen grenspieken, maar hebben meer state of betere datastructuren nodig.

Een aparte klasse limieten is concurrency (in-flight verzoeken). Dit beschermt je tegen trage clientverbindingen en langlopende endpoints. Een klant kan binnen 60 verzoeken per minuut blijven maar je toch overbelasten door 200 verzoeken tegelijk open te houden.

In echte systemen combineren teams vaak een kleine set controles: een token bucket voor algemene request rate, een concurrency-cap voor trage of zware endpoints, en aparte budgetten voor endpointgroepen (goedkope reads vs kostbare exports). Als je alleen op request-aantal limiteert, kan één duur endpoint alles verdringen en lijkt de API willekeurig kapot.

Goede quota voelen eerlijk en voorspelbaar. Klanten moeten de regels niet pas ontdekken nadat ze geblokkeerd zijn.

Houd de scheiding duidelijk:

Veel SaaS-teams gebruiken beide: een korte rate limit om bursts te stoppen plus een maandelijkse quota gekoppeld aan prijsplannen.

Harde vs zachte limieten is vooral een supportkeuze. Een harde limiet blokkeert meteen. Een zachte limiet waarschuwt eerst en blokkeert later. Zachte limieten verminderen boze tickets omdat mensen een kans krijgen om een bug te fixen of te upgraden voordat een integratie stopt.

Als iemand overgaat, moet het gedrag passen bij wat je beschermt. Blokkeren werkt wanneer overmatig gebruik andere tenants schaadt of kosten explodeert. Degraderen (langzamer verwerken of lagere prioriteit) werkt wanneer je liever alles in beweging houdt. “Later factureren” kan werken wanneer gebruik voorspelbaar is en je al een factureringsflow hebt.

Laaggebaseerde limieten werken het best wanneer elk niveau een duidelijk “verwachte gebruiksvorm” heeft. Een gratis laag kan kleine maandelijkse quota en lage burst-rates toestaan, terwijl business en enterprise hogere quota en burst-limieten krijgen zodat achtergrondjobs snel klaar kunnen. Dat lijkt op hoe Koder.ai's Free, Pro, Business en Enterprise tiers verschillende verwachtingen zetten over hoeveel je kunt doen voordat je opschaalt.

Aangepaste limieten zijn de moeite waard om vroeg te ondersteunen, vooral voor enterprise. Een nette aanpak is “standaarden per plan, overrides per klant.” Sla een admin-override per org op (en soms per endpoint) en zorg dat het wijzigingen bij planwissel overleeft. Bepaal ook wie wijzigingen kan aanvragen en hoe snel ze ingaan.

Voorbeeld: een klant importeert 50.000 records op de laatste dag van de maand. Als hun maandelijkse quota bijna op is, geeft een zachte waarschuwing bij 80–90% hen tijd om te pauzeren. Een korte per-seconde rate limit voorkomt dat de import de API overspoelt. Een goedgekeurde org-override (tijdelijk of permanent) houdt de business draaiende.

Begin met opschrijven wat je telt en bij wie het hoort. De meeste teams eindigen met drie identiteiten: de ingelogde gebruiker, de klantorg (of workspace) en het client-IP.

Een praktisch plan:

Als je limieten instelt, denk in lagen en endpointgroepen, niet in één globaal getal. Eén veelvoorkomende fout is vertrouwen op in-memory tellers over meerdere app-servers. Counters verschillen en gebruikers zien “willekeurige” 429s. Een gedeelde store zoals Redis houdt limieten stabiel over instanties en TTLs houden data klein.

Uitrol doet er toe. Begin in “report only” modus (log wat geblokkeerd zou zijn), dan afdwingen voor één endpointgroep, en daarna uitbreiden. Zo voorkom je dat je wakker wordt met een muur van supporttickets.

Als een klant een limiet raakt, is het slechtste resultaat verwarring: “Is jullie API down, of heb ik iets verkeerd gedaan?” Duidelijke, consistente responses verminderen supporttickets en helpen mensen hun clientgedrag aan te passen.

Gebruik HTTP 429 Too Many Requests wanneer je actief calls blokkeert. Houd het response-lichaam voorspelbaar zodat SDKs en dashboards het kunnen uitlezen.

Hier is een eenvoudige JSON-structuur die goed werkt voor per-user, per-org en per-IP limieten:

{

"error": {

"code": "rate_limit_exceeded",

"message": "Rate limit exceeded for org. Try again later.",

"limit_scope": "org",

"reset_at": "2026-01-17T12:34:56Z",

"request_id": "req_01H..."

}

}

Headers moeten het huidige venster en wat de client daarna kan doen uitleggen. Als je er maar een paar toevoegt, begin met: RateLimit-Limit, RateLimit-Remaining, RateLimit-Reset, Retry-After en X-Request-Id.

Voorbeeld: de cron job van een klant draait elke minuut en faalt plots. Met 429 plus RateLimit-Remaining: 0 en Retry-After: 20 weten ze meteen dat het een limiet is, geen outage, en kunnen ze retries 20 seconden uitstellen. Als ze X-Request-Id delen met support, vind je de gebeurtenis snel.

Nog een detail: geef dezelfde headers ook terug bij succesvolle verzoeken. Klanten zien dan dat ze dicht bij de rand komen voordat ze hem raken.

Goede clients laten limieten eerlijk voelen. Slechte clients veranderen een tijdelijke limiet in een outage door harder te blijven hammeren.

Als je een 429 krijgt, behandel het als een signaal om te vertragen. Als het antwoord zegt wanneer je het opnieuw kunt proberen (bijv. via Retry-After), wacht dan minstens zo lang. Als dat niet aanwezig is, gebruik exponentiële backoff en voeg jitter toe zodat duizend clients niet tegelijk opnieuw proberen.

Beperk retries: zet een bovengrens op de vertraging tussen pogingen (bijv. 30–60 seconden) en op de totale retrytijd (bijv. stop na 2 minuten en toon een fout). Log de gebeurtenis met limietdetails zodat ontwikkelaars later kunnen bijsturen.

Retry niet alles. Veel fouten slagen niet zonder wijziging of gebruikersactie: 400 validatiefouten, 401/403 auth-fouten, 404 not found en 409 conflicts die een echte bedrijfsregel reflecteren.

Retries zijn riskant op write-endpoints (create, charge, send email). Als een timeout optreedt en de client opnieuw probeert, kun je duplicaten maken. Gebruik idempotentiesleutels: de client stuurt een unieke sleutel per logische actie en de server geeft hetzelfde resultaat terug voor herhalingen van die sleutel.

Goede SDKs kunnen dit makkelijker maken door ontwikkelaars te vertellen wat ze echt nodig hebben: status (429), hoe lang te wachten, of het verzoek veilig is om opnieuw te proberen, en een boodschap als “Rate limit exceeded for org. Retry after 8s or reduce concurrency.”

De meeste supporttickets over limieten gaan niet over de limiet zelf. Ze gaan over verrassingen. Als gebruikers niet kunnen voorspellen wat er daarna gebeurt, denken ze dat de API kapot of oneerlijk is.

Alleen op IP gebaseerde limieten gebruiken is een frequente fout. Veel teams zitten achter één publiek IP (kantoor Wi‑Fi, mobiele providers, cloud NAT). Als je per-IP cap stelt, kan één drukke klant iedereen op hetzelfde netwerk blokkeren. Geef de voorkeur aan per-user en per-org limieten en gebruik per-IP vooral als abuse-veiligheidsnet.

Een ander probleem is alle endpoints als gelijk behandelen. Een goedkope GET en een zware exportjob mogen niet hetzelfde budget delen. Anders verbranden klanten hun tegoed met normaal browsen en worden ze geblokkeerd bij echte taken. Scheid buckets per endpointgroep of weeg requests op basis van kosten.

Reset-timing moet ook expliciet zijn. “Resets dagelijks” is niet genoeg. Welke tijdzone? Rolling window of middernacht reset? Als je calendar-resets doet, zeg de tijdzone. Als je rolling windows doet, vermeld de vensterlengte.

Tot slot creëren vage fouten chaos. 500 of generieke JSON teruggeven zorgt dat mensen harder proberen. Gebruik 429 en includeer RateLimit-headers zodat clients intelligent backoffen.

Voorbeeld: als een team een Koder.ai-integratie bouwt vanaf een gedeeld kantoornetwerk, kan een IP-only cap hun hele org blokkeren en op willekeurige outages lijken. Duidelijke dimensies en consistente 429-responses voorkomen dat.

Voordat je limieten voor iedereen inschakelt, doorloop een laatste check gericht op voorspelbaarheid:

Een gevoelstest: als je product lagen heeft zoals Free, Pro, Business en Enterprise (zoals Koder.ai), moet je in gewone taal kunnen uitleggen wat een normale klant per minuut en per dag kan doen en welke endpoints anders behandeld worden.

Als je een 429 niet duidelijk kunt uitleggen, zullen klanten aannemen dat de API kapot is in plaats van de service te beschermen.

Stel je een B2B SaaS voor waar mensen in een workspace (org) werken. Een paar power users draaien zware exports en veel medewerkers zitten achter één gedeeld kantoor-IP. Als je alleen op IP limiteert, blokkeer je hele bedrijven. Als je alleen per-user limiteert, kan één script nog steeds de hele workspace schaden.

Een praktisch mengsel is:

Als iemand een limiet raakt, moet je bericht zeggen wat er gebeurde, wat te doen en wanneer te retryen. Support moet achter wording kunnen staan zoals:

“Request rate exceeded for workspace ACME. You can retry after 23 seconds. If you are running an export, reduce concurrency to 2 or schedule it off-peak. If this blocks normal use, reply with your workspace ID and timestamp and we can review your quota.”

Koppel dat bericht aan Retry-After en consistente RateLimit-headers zodat klanten niet hoeven te raden.

Een uitrol die verrassingen vermijdt: eerst observe-only, dan waarschuwen (headers en zachte waarschuwingen), dan afdwingen (429s met duidelijke retry-timing), dan thresholds per laag tunen en ten slotte evalueren na grote lanceringen en klantonboardings.

Als je snel wilt beginnen met deze ideeën in werkende code, kan een vibe-coding platform zoals Koder.ai (koder.ai) je helpen een korte rate-limit-spec te schrijven en Go-middleware te genereren die het consistent afdwingt over services.

Een rate limit begrenst hoe snel je verzoeken kunt doen, bijvoorbeeld aantal verzoeken per seconde of per minuut. Een quota begrenst hoeveel je kunt gebruiken over een langere periode, zoals per dag, per maand of per factureringscyclus.

Als je minder “het werkte gisteren”-verrassingen wilt, toon beide duidelijk en maak de resettijd expliciet zodat klanten het gedrag kunnen voorspellen.

Begin bij het falen dat je voorkomt. Als pieken time-outs veroorzaken, heb je korte-termijn burst-control nodig; als bepaalde endpoints veel kosten veroorzaken, heb je een kostenbudget nodig; als je brute force of scraping ziet, heb je strikte abuse-controls nodig.

Een snelle manier om te beslissen is: “Als dit ene endpoint 10× verkeer krijgt, wat faalt er eerst: latency, kosten of security?” Ontwerp de limiet rond dat doel.

Gebruik per-gebruiker limieten om te voorkomen dat één persoon zijn team vertraagt, en per-organisatie limieten om een workspace binnen een voorspelbaar plafond te houden dat bij prijsstelling en capaciteit past. Voeg per-token limieten toe wanneer een gedeelde integratiesleutel interactieve gebruikers kan overstemmen.

Behandel per-IP limieten als een veiligheidsnet voor duidelijk misbruik, omdat gedeelde netwerken onschuldige gebruikers kunnen blokkeren.

Token bucket is een goede standaard wanneer je korte bursts wilt toestaan maar een gemiddeld tempo over tijd wilt afdwingen. Het past bij veel UX-patronen zoals dashboards die meerdere verzoeken tegelijk sturen.

Als je backend geen pieken kan verdragen, kan een striktere aanpak zoals leaky bucket of expliciete wachtrijen consistenter aanvoelen, maar minder vergevingsgezind zijn tijdens bursts.

Voeg een concurrency-limiet toe wanneer de schade komt van te veel gelijktijdige in-flight verzoeken in plaats van het aantal verzoeken. Dit komt vaak voor bij trage endpoints, long polling, streaming, grote exports of cliënten met slechte netwerkcondities.

Concurrency-caps voorkomen dat een client “binnen 60 verzoeken/min” blijft maar toch honderden open verbindingen bezet houdt.

Geef HTTP 429 terug wanneer je actief throttlet, en voeg een duidelijk foutlichaam toe dat zegt welke scope geraakt is (user, org, IP of token) en wanneer de client het opnieuw kan proberen. De meest behulpzame header is Retry-After, omdat die clients precies vertelt hoe lang ze moeten wachten.

Geef ook rate limit-headers terug bij succesvolle verzoeken zodat klanten kunnen zien dat ze de rand naderen voordat ze geblokkeerd worden.

Een eenvoudige regel: als Retry-After aanwezig is, wacht minstens zo lang voordat je opnieuw probeert. Als die ontbreekt, gebruik exponentiële backoff met wat willekeur (jitter) zodat veel clients niet tegelijk opnieuw proberen.

Beperk retries en probeer niet blind fouten te retryen die niet slagen zonder wijziging, vooral auth- en validatiefouten.

Gebruik harde limieten wanneer overschrijding andere klanten zou schaden of directe kosten zou veroorzaken die je niet kunt dragen. Gebruik zachte limieten wanneer je eerst wilt waarschuwen, tijd wilt geven om een bug te herstellen, of een upgrade wilt laten plaatsvinden voordat je blokkeert.

Een praktisch patroon is waarschuwen op 80–90% gebruik en later afdwingen, zodat je dringende supporttickets vermindert zonder runaway gebruik te blijven toestaan.

Houd IP-limieten ruim en richt ze voornamelijk op misbruikpatronen, omdat veel bedrijven één publieke IP delen achter NAT, kantoornetwerken of mobiele providers. Strenge per-IP caps kunnen per ongeluk een heel klantnetwerk blokkeren.

Voor normale gebruiksregeling geef je de voorkeur aan per-user en per-org limieten; per-IP is vooral een backstop.

Rol uit in fasen zodat je de impact kunt zien voordat klanten pijn voelen. Begin met “alleen rapportage” logging om te meten wat geblokkeerd zou worden, handhaaf dan op een kleine set endpoints of subset van tenants en breid pas daarna uit.

Let op spikes in 429s, verhoogde latency door de limiter en de top-identiteiten die geblokkeerd worden; die signalen tonen waar drempels of dimensies verkeerd staan voordat het een supportgolf wordt.