Waarom Kurzweils AGI-voorspellingen ertoe doen

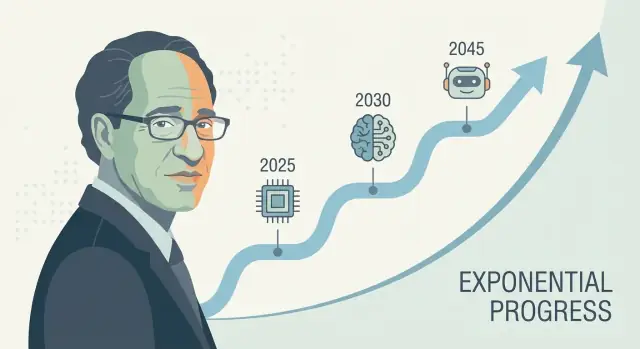

Ray Kurzweil is een van de bekendste stemmen op het gebied van langetermijn technologievoorspelling—vooral rond kunstmatige intelligentie en de technologische singulariteit. Wanneer hij een concrete AGI-voorspelling doet (vaak als een datum, niet als een vaag “ooit”), krijgt die vaak veel aandacht: investeerders verwijzen ernaar, journalisten debatteren erover en onderzoekers worden gevraagd erop te reageren.

Waarom zijn zijn voorspellingen zo actueel

Kurzweils invloed draait niet alleen om optimisme. Het gaat ook om het aanbieden van een herhaalbaar narratief voor waarom vooruitgang zou moeten versnellen—vaak gekoppeld aan exponentiële groei in computerkracht en het idee dat elke generatie gereedschappen helpt de volgende te bouwen. Of je het er mee eens bent of niet, hij levert een gestructureerde manier om over een tijdlijn voor kunstmatige algemene intelligentie te praten in plaats van het als pure sciencefiction te behandelen.

Wat “decennia vooruit voorspellen” echt betekent

Een voorspelling decennia vooruit gaat minder over het raden van een kalenderdatum en meer over het projecteren van een bundel trends: compute, kosten, data, algoritmes en het praktische vermogen om systemen te bouwen die generaliseren. De gok is dat deze krommen blijven bewegen—en dat de huidige “missende stukjes” oplosbare engineeringproblemen zijn die krimpen naarmate de inputs verbeteren.

Wat je in dit artikel leert

Dit stuk behandelt:

- De methode achter Kurzweils technologievoorspellingen (wat hij meet en extrapoleert)

- Welke aanwijzingen pleiten voor het idee dat AI-voortgang accelereert—en waar de data dun is

- De sterkste kritieken op AI-voorspellingen die rechte-lijn extrapolaties van exponentiële groei volgen

- Praktische lessen voor het gebruiken van voorspellingen als planningshulpmiddel zonder ze als zekerheden te behandelen

Een korte opmerking over onzekerheid

Zelfs onder serieuze experts variëren AGI-voorspellingen sterk omdat ze afhankelijk zijn van aannames: wat “AGI” betekent, welke knelpunten het meest tellen en hoe snel doorbraken zich vertalen naar betrouwbare producten. Kurzweils tijdlijnen zijn invloedrijk niet omdat ze gegarandeerd zijn, maar omdat ze concreet genoeg zijn om te testen—en lastig om te negeren.

Wie is Ray Kurzweil?

Ray Kurzweil is een Amerikaanse uitvinder, auteur en toekomstvoorspeller die bekendstaat om zijn langetermijntechnologievoorspellingen—en om ze te ondersteunen met grafieken, historische data en gedurfde deadlines.

Uitvinder, ondernemer en “patroonherkenner”

Kurzweil werd eerst breed bekend door praktische uitvindingen, vooral in spraak- en teksttechnologieën. Hij bouwde bedrijven rond optical character recognition (OCR), text-to-speech en muziekgereedschappen, en bracht decennia dicht bij echte productbeperkingen door: datakwaliteit, hardwarekosten en wat gebruikers daadwerkelijk zullen adopteren. Die bouwersmentaliteit kleurt zijn voorspellingen—hij neigt ertoe vooruitgang te zien als iets dat geïngineerd en opgeschaald kan worden.

Hij werkte ook binnen grote techorganisaties (waaronder Google), wat zijn visie versterkte dat grote sprongen vaak voortkomen uit aanhoudende investeringen, betere tooling en samenhangende verbeteringen—niet alleen geïsoleerde doorbraken.

Belangrijke boeken en ideeën die AGI-debatten beïnvloeden

Kurzweils AGI-tijdlijn wordt meestal besproken via zijn populaire boeken, vooral The Age of Spiritual Machines (1999) en The Singularity Is Near (2005). Deze werken betogen dat informatietechnologieën op versnellende, samengestelde manieren verbeteren—en dat die versnelling uiteindelijk machines met menselijk niveau (en daarna bovenmenselijk niveau) capaciteiten zal opleveren.

Of je het er mee eens bent of niet, zijn schrijven hielp de termen van het publieke gesprek te bepalen: AI-voortgang als meetbaar, trendgestuurd en (in principe) voorspelbaar.

Korte definities (zodat we het over hetzelfde hebben)

AGI (Artificial General Intelligence): een AI-systeem dat kan leren en een breed scala aan taken op ongeveer menselijk niveau kan uitvoeren, zich aanpassend aan nieuwe problemen zonder sterk gespecialiseerd te zijn.

Singulariteit: Kurzweils term voor een periode waarin technologische vooruitgang zo snel wordt (en AI zo capabel) dat het de samenleving op onvoorspelbare, moeilijk te modelleren manieren verandert.

Tijdlijn: een voorspelling met datums en mijlpalen (bijvoorbeeld “menselijk-niveau AI tegen jaar X”), niet alleen een algemene bewering dat vooruitgang zal doorgaan.

Kurzweils kernclaims over AGI-tijdlijnen

Kurzweil heeft herhaaldelijk betoogd dat menselijk-niveau kunstmatige algemene intelligentie (AGI) waarschijnlijk binnen de eerste helft van de 21e eeuw ligt—het meest bekend clustering rond de late jaren 2020 tot de jaren 2030 in publieke toespraken en boeken. Hij is niet altijd star over één specifiek jaar, maar de centrale bewering is consistent: zodra computerkracht, data en algoritmes bepaalde drempels overschrijden, zullen systemen de breedte en aanpasbaarheid van menselijke cognitie evenaren.

Hoe AGI verbindt met de “singulariteit”

In Kurzweils framing is AGI geen eindpunt—het is een trigger. Nadat machines menselijk-niveau (en daarna meer) algemene intelligentie bereiken, versterkt vooruitgang zichzelf: slimere systemen helpen bij het ontwerpen van nog slimere systemen, waardoor wetenschappelijke ontdekking, automatisering en mens–machine integratie versnellen. Die compoundingdynamiek koppelt hij aan het bredere idee van de “technologische singulariteit”: een periode waarin verandering zo snel wordt dat alledaagse intuïtie geen betrouwbare gids meer is.

AGI versus de huidige AI-systemen

Een belangrijk nuanceverschil in zijn tijdlijnclaims is de definitie van AGI. De huidige toonaangevende modellen kunnen indrukwekkend zijn op veel taken, maar ze zijn nog steeds vaak:

- broos buiten trainingspatronen,

- zwak in langetermijnplanning en grounding in de echte wereld,

- afhankelijk van menselijk-gekureerde doelen en evaluatie.

Kurzweils “AGI” impliceert een systeem dat leren kan overdragen tussen domeinen, doelen kan vormen en nastreven in nieuwe situaties, en betrouwbaar de open-eind variëteit van de echte wereld aankan—niet alleen uitmuntend is in benchmarks.

Waarom mijlpalen beter zijn dan één enkele datum

Een kalendervoorspelling is makkelijk te debatteren en moeilijk te gebruiken. Mijlpalen zijn praktischer: aanhoudend autonoom leren, betrouwbaar gebruik van tools en planning, sterke prestaties in rommelige echte omgevingen en duidelijke economische vervanging over veel functietypes. Zelfs als je het niet eens bent met zijn exacte timing, maken deze checkpoints de voorspelling toetsbaar—en nuttiger dan wedden op één headline-jaar.

Track record: treffers, missers en wat debatbaar is

Kurzweil wordt vaak beschreven als een “serievoorspeller”, en die reputatie is deel van waarom zijn AGI-tijdlijn aandacht krijgt. Maar zijn track record is gemengd op een manier die nuttig is om voorspellen te begrijpen: sommige uitspraken waren specifiek en meetbaar, andere waren richtinggevend maar vaag, en een paar onderschatten belangrijke beperkingen.

Opvallende voorspellingen die vaak met Kurzweil worden geassocieerd

Door boeken en toespraken heen wordt hij in verband gebracht met voorspellingen zoals:

- Computers die gestaag verbeteren in kost/prestatie (een voortzetting van Moore’s law–achtige trends)

- Spraakherkenning die breed bruikbaar wordt voor consumenten

- Mobiel, altijd-verbonden rekenen als standaard worden

- AI die mensen overtreft in smalle taken (bijv. spellen, patroonherkenning)

- Toenemende “mens–machine” integratie (wearables, implants, assistieve tech)

Duidelijke, controleerbare versus vage voorspellingen

Duidelijke, controleerbare voorspellingen zijn gekoppeld aan een datum en een meetbaar resultaat: “tegen jaar X zal technologie Y bereik Z prestatie”, of “de meerderheid van apparaten zal functie F hebben.” Deze zijn te toetsen aan publieke benchmarks (nauwkeurigheidspercentages, verkoop/adoptiegegevens, computekosten).

Vage voorspellingen klinken aannemelijk maar zijn moeilijk te falsifiëren, zoals “computers zullen overal zijn”, “AI zal de samenleving transformeren” of “mensen zullen samensmelten met technologie.” Deze voelen vaak waar aan zelfs als details, timing of mechanisme verschillen.

Hoe beoordeel je “juist”, “gedeeltelijk juist” en “fout” (zonder score bij te houden)

Een praktische manier om elke voorspeller te evalueren is richting, timing en specificiteit te scheiden.

- Juist: het resultaat komt overeen met de bewering en de timing is dicht genoeg om verwachtingen duidelijk te sturen.

- Gedeeltelijk juist: de richting is correct, maar timing schuift, adoptie is trager, of het resultaat arriveert in een andere vorm (bijv. “werkt in demo’s” vs. “werkt voor de meeste mensen, de meeste tijd”).

- Fout: belangrijke beperkingen werden onderschat—datalimieten, regelgeving, gebruikersgedrag, kosten, of de kloof tussen labprestaties en betrouwbaarheid in de echte wereld.

Het punt is niet om voorspellingen als “goed” of “slecht” te bestempelen. Het is om te zien hoe zelfverzekerde, data-gedreven voorspellingen nog steeds afhangen van verborgen aannames—vooral wanneer ze rommelige sociale adoptie betreffen, niet alleen betere hardware of algoritmes.

De “Law of Accelerating Returns” in gewone taal

Kurzweils “Law of Accelerating Returns” is het idee dat wanneer een technologie verbetert, die verbeteringen het vaak weer makkelijker maken om die technologie verder te verbeteren. Dat creëert een feedbacklus waardoor vooruitgang in de loop van de tijd versnelt.

Exponentiële trends, zonder wiskunde

Een rechte-lijn (lineaire) trend is zoals elk jaar hetzelfde bedrag optellen: 1, 2, 3, 4.

Een exponentiële trend is zoals vermenigvuldigen: 1, 2, 4, 8. Vroeg lijkt het langzaam—dan voelt het ineens alsof alles tegelijk gebeurt. Kurzweil betoogt dat veel technologieën (vooral informatietechnologieën) dit patroon volgen omdat elke generatie gereedschappen helpt de volgende te bouwen.

Waarom kosten/prestatie-krommen belangrijk zijn voor zijn tijdlijnen

Kurzweil vraagt niet alleen “Kunnen we X doen?” Hij vraagt “Hoe goedkoop kunnen we X doen?” Een veelvoorkomend patroon in computing is: prestatie stijgt terwijl kosten dalen. Wanneer de kosten om een nuttig model te draaien dalen, kunnen meer mensen experimenteren, producten uitrollen en de volgende golf financieren—wat de vooruitgang versnelt.

Daarom let hij op langlopende krommen zoals “berekeningen per dollar”, niet alleen op headline-demo’s.

Waar Moore’s law past—en waar niet

Moore’s law is het klassieke voorbeeld: decennialang verdubbelde het aantal transistors op chips ongeveer volgens een schema, waardoor computers sneller en goedkoper werden.

Kurzweils argument is niet dat “Moore’s law voor altijd blijft doorlopen.” Het is breder: zelfs als één hardware-aanpak vertraagt, kunnen andere methoden (betere chips, GPUs/TPUs, parallelisme, nieuwe architecturen, software-efficiëntie) de algehele kost/prestatie-trend blijven verbeteren.

Waarom rechte-lijn denken misleidt

Mensen voorspellen de toekomst vaak door recente verandering in hetzelfde tempo door te trekken. Dat mist compounding. Het kan vroege vooruitgang onbeduidend doen lijken—en latere vooruitgang “plotseling”, terwijl het misschien al voorspelbaar was op een kromme die zich jaren opbouwde.

Welke data deze voorspellingen ondersteunt (en beperkt)

Zet het snel live

Deploy en host je app snel wanneer je er klaar voor bent, zonder extra stappen.

Voorspellingen zoals die van Kurzweil beginnen meestal met meetbare trends—dingen die je op een grafiek kunt zetten. Dat is een kracht: je kunt de inputs bespreken in plaats van puur op intuïtie te redeneren. Het is ook waar de grootste beperkingen zichtbaar worden.

De “makkelijk te meten” krommen: compute, opslag, bandbreedte, kosten

Technologie-voorspellers volgen vaak:

- Compute (hoeveel bewerkingen je per dollar kunt kopen)

- Opslag (hoeveel data je per dollar kunt bewaren)

- Bandbreedte (hoe snel je data kunt verplaatsen en tegen welke prijs)

- Kostenverlagingen (voor chips, cloud-instanties, trainingsruns en energie per eenheid werk)

Deze curves kunnen overtuigend zijn omdat ze langlopend en vaak bijgewerkt worden. Als je blik op AGI is “genoeg hardware plus de juiste software”, voelen deze datasets als solide grond.

Hardware-voortgang is niet hetzelfde als capaciteits-voortgang

Het belangrijkste gat: meer hardware levert niet automatisch slimmere systemen op. AI-capaciteit hangt af van algoritmes, datakwaliteit, trainingsrecepten, tooling en menselijke feedback—niet alleen van FLOPs.

Een nuttige manier om erover te denken: hardware is een budget, capaciteit is het resultaat. De relatie tussen beide is echt, maar niet vast. Soms ontgrendelt een kleine algorithmische verandering grote winst; soms stuit opschaling op afnemende meeropbrengsten.

Waarom benchmarks en prestaties in de echte wereld ertoe doen

Om “inputs” (compute, geld) te verbinden met “outputs” (wat modellen daadwerkelijk kunnen), hebben voorspellers nodig:

- Benchmarks die redeneren, planning en generalisatie meten—niet alleen patroonherkenning

- Prestaties in de echte wereld in rommelige omgevingen: betrouwbaarheid, veiligheid, langetermijntaken en aanpasbaarheid

Benchmarks zijn te manipuleren, dus de meest overtuigende signalen combineren testscores met bewijs van duurzame bruikbaarheid.

Veelvoorkomende valkuilen: nette grafieken, verborgen knelpunten

Twee frequente fouten zijn cherry-picken van curves (tijdvensters kiezen die het meest exponentieel lijken) en het negeren van knelpunten zoals energiebeperkingen, datalimieten, latentie, regelgeving of de moeilijkheid om smalle competentie om te zetten in algemene competentie. Deze beëindigen voorspellen niet, maar vergroten wel de foutmarges.

Belangrijke aannames achter decennia-voorspellingen

Langetermijn AGI-tijdlijnen—ook die van Kurzweil—hangen minder af van één “doorbraakhitte” en meer van een stapel aannames die tegelijk waar moeten zijn. Als een laag verzwakt, kan de datum opschuiven zelfs als vooruitgang doorgaat.

1) Compute, algoritmes en data blijven compounding

De meeste decennia-voorspellingen veronderstellen dat drie curves samen stijgen:

- Schaal van compute blijft goedkoper en makkelijker inzetbaar (meer chips, grotere clusters, betere benutting).

- Algorithmische vooruitgang levert aanhoudende efficiëntiewinst op—waardoor elke eenheid compute meer capaciteit oplevert.

- Beschikbaarheid van data blijft voldoende, of via nieuwe bronnen (multimodale data), synthetische data, betere labelingtools of verbeterde zelfsupervisie.

Een verborgen aanname: deze drie drijfveren substitueren elkaar niet perfect. Als datakwaliteit stagneert, levert “gewoon meer compute” mogelijk kleinere opbrengsten.

2) Fysieke en industriële beperkingen bijten niet te hard

Voorspellingen behandelen compute vaak als een vloeiende curve, maar de realiteit loopt via fabrieken en stroomnetten.

Energieprijzen, chipproductiecapaciteit, exportcontroles, geheugenbandbreedte, netwerkapparatuur en supply-chain schokken kunnen allemaal beperken hoe snel training en uitrol opschalen. Zelfs als de theorie zegt “10× meer compute”, is de weg ernaartoe hobbelig en duur.

3) Menselijke systemen staan snelle uitrol toe

Langetermijnvoorspellingen nemen ook aan dat de samenleving adoptie niet te veel vertraagt:

Regelgeving, aansprakelijkheid, publiek vertrouwen, werkplek-integratie en ROI beïnvloeden of geavanceerde systemen worden getraind en breed ingezet—of in nauwe, dure settings blijven.

4) Capaciteitswinst vertaalt zich naar generaliteit

Misschien is de grootste aanname dat capaciteitsverbeteringen door opschaling (beter redeneren, plannen, toolgebruik) natuurlijk convergeren naar algemene intelligentie.

“Meer compute” kan modellen vloeiender en nuttiger maken, maar niet automatisch algemener in de zin van betrouwbare overdracht over domeinen, langetermijn-autonomie of stabiele doelen. Lange tijdlijnen veronderstellen vaak dat deze gaps engineeringproblemen zijn—niet fundamentele barrières.

Wat AGI kan vertragen (zelfs als trends blijven stijgen)

Bouw en verdien credits

Verdien credits door te delen wat je bouwt of anderen uit te nodigen Koder.ai te proberen.

Zelfs als computerkracht en modelgroottes blijven toenemen, kan AGI later arriveren dan voorspeld vanwege redenen die weinig met ruwe snelheid te maken hebben. Verschillende knelpunten gaan over wat we bouwen en hoe we weten dat het werkt.

1) De probleemdefinitie kan vager blijven

“AGI” is geen enkele schakelaar die je aanzet. Een bruikbare definitie impliceert gewoonlijk een agent die snel nieuwe taken leert, vaardigheden tussen domeinen overdraagt, over lange horizons plant en rommelige, veranderende doelen met hoge betrouwbaarheid aankan.

Als het doel blijft schuiven—klevende assistent vs. autonome werker vs. wetenschapper-niveau redeneerder—kan vooruitgang indrukwekkend lijken terwijl belangrijke vaardigheden ontbreken zoals langetermijngeheugen, causaal redeneren of consistente besluitvorming.

2) AGI meten is moeilijker dan GPUs meten

Benchmarks zijn te manipuleren, kunnen overfitten of verouderen. Sceptici willen doorgaans bewijs dat een AI kan slagen op onbekende taken, onder nieuwe beperkingen, met lage foutpercentages en herhaalbare resultaten.

Als het veld het niet eens kan worden over tests die overtuigend “uitstekende patrooncompletion” scheiden van “algemene competentie”, worden tijdlijnen gissingen—en voorzichtigheid kan de uitrol vertragen.

3) Alignment en safety kunnen het tempo bepalen

Capaciteit kan sneller groeien dan beheersbaarheid. Als systemen agentachtiger worden, stijgt de lat om bedrog, doelafwijking en schadelijke bijeffecten te voorkomen.

Regelgeving, audits en safety-engineering kunnen tijd kosten ook al verbeteren modellen snel—vooral voor toepassingen met hoge inzet.

4) Belichaming en interactie met de echte wereld blijven open vragen

Veel definities van AGI veronderstellen impliciet competentie in de fysieke wereld: objecten manipuleren, experimenten doen, gereedschappen gebruiken en aanpassen aan realtime feedback.

Als leren in de echte wereld datavretend, traag of risicovol blijkt, kan AGI stagneren op “briljant op het scherm” prestaties—terwijl praktische generaliteit wacht op betere robotica, simulatie en veilige trainingsmethoden.

Belangrijkste kritieken op Kurzweils aanpak

Kurzweils voorspellingen zijn invloedrijk deels omdat ze duidelijk en kwantitatief zijn—maar diezelfde duidelijkheid nodigt ook uit tot scherpe kritiek.

1) Past extrapolatie van historische trends wel bij “regimeveranderingen”?

Een veelgehoord bezwaar is dat Kurzweil sterk leunt op het verlengen van historische curves (compute, opslag, bandbreedte) naar de toekomst. Critici stellen dat technologie niet altijd soepel schaalt: chipvooruitgang kan vertragen, energiekosten kunnen knellen en economische prikkels kunnen verschuiven. Zelfs als de lange termijn richting omhoog blijft, kan het tempo veranderen op manieren die specifieke datums onbetrouwbaar maken.

2) Complexe systemen leveren geen doorbraken op schema

AGI is niet alleen een kwestie van snellere hardware. Het is een complex-systeemprobleem met algoritmes, data, trainingsmethoden, evaluatie, veiligheidsbeperkingen en menselijke adoptie. Doorbraken kunnen gebottlenecked worden door één ontbrekend idee—iets wat je niet betrouwbaar op een kalender kunt zetten. Sceptici wijzen erop dat wetenschap vaak gaat via ongelijke stappen: lange plateaus gevolgd door plotselinge sprongen.

3) Selectie-effecten laten gedurfde voorspellingen beter lijken

Een andere kritiek is psychologisch: we onthouden dramatische juiste voorspellingen meer dan de stillere missers of bijna-missers. Als iemand veel sterke voorspellingen doet, kunnen een paar memorabele treffers de publieke perceptie domineren. Dit betekent niet dat de voorspeller “fout” is, maar het kan vertrouwen in de nauwkeurigheid van tijdlijnen opblazen.

4) Waarom slimme mensen het oneens zijn over tijdlijnen

Zelfs experts die snelle AI-voortgang accepteren verschillen over wat “meetelt” als AGI, welke capaciteiten moeten generaliseren en hoe die te meten. Kleine verschillen in definities (taalbreedte, autonomie, betrouwbaarheid, leren in de echte wereld) kunnen voorspellingen tientallen jaren verschuiven—zonder dat iemand van mening verandert over de huidige vooruitgang.

Hoe andere experts AGI-tijdlijnen voorspellen

Kurzweil is één luide stem, maar AGI-tijdlijnen zijn een druk debat. Een nuttige manier om dat te schetsen is het nabij-termijn kamp (AGI binnen jaren tot een paar decennia) versus het lange-termijn kamp (meerdere decennia of “niet deze eeuw”). Ze kijken vaak naar dezelfde trends maar verschillen over wat ontbreekt: nabij-optimisten benadrukken snelle opschaling en opkomende emergente capaciteiten, terwijl langetermijnsceptici onopgeloste problemen benadrukken zoals betrouwbaar redeneren, autonomie en robuustheid in de echte wereld.

Expertenquêtes aggregeren opvattingen van onderzoekers en beoefenaars (bijv. polls die vragen wanneer er 50% kans is op “menselijk-niveau AI”). Deze kunnen verandering in sentiment tonen, maar ze weerspiegelen ook wie is ondervraagd en hoe vragen zijn geformuleerd.

Scenario-planning vermijdt het kiezen van één datum. In plaats daarvan schetst het meerdere plausibele toekomsten (snelle vooruitgang, trage vooruitgang, regelgevende knelpunten, hardwarebeperkingen) en vraagt welke signalen elk pad zouden aangeven.

Benchmark- en capaciteitsgebaseerde voorspelling volgt concrete mijlpalen (codeertaken, wetenschappelijk redeneren, agentbetrouwbaarheid) en schat welke verbeteringssnelheid nodig is om bredere competentie te bereiken.

Definities veranderen de datum

“AGI” kan betekenen het halen van een brede testsuite, het kunnen doen van de meeste banen, opereren als een autonome agent of mensen matchen over domeinen met minimale supervisie. Een strengere definitie duwt doorgaans tijdlijnen later, en onenigheid hierover verklaart veel van de spreiding.

Het enige wat consensus lijkt: onzekerheid

Zelfs optimistische en sceptische experts zijn het vaak over één punt eens: tijdlijnen zijn zeer onzeker, en voorspellingen moeten worden behandeld als bereiken met aannames—geen kalenderbeloften.

Signalen om de komende 5–10 jaar te volgen

Voeg een echte backend toe

Zet een Go-backend met PostgreSQL op en ontwikkel deze mee als de eisen veranderen.

Voorspellingen over AGI kunnen abstract aanvoelen, dus het helpt concrete signalen te volgen die voor elk “groot moment” zouden moeten bewegen. Als Kurzweil-achtige tijdlijnen richting correct zijn, zou het volgende decennium gestage winst moeten laten zien in capaciteit, betrouwbaarheid, economie en governance.

1) Capaciteitsindicatoren (wat systemen daadwerkelijk kunnen)

Let op modellen die betrouwbaar over meerdere stappen plannen, zich aanpassen wanneer plannen falen, en tools gebruiken (code, browsers, data-apps) zonder constante hand-holding. Het meest betekenisvolle teken is geen spectaculaire demo—het is autonomie binnen duidelijke grenzen: agenten die meeruurstaken kunnen afronden, verduidelijkende vragen stellen en werk veilig overdragen wanneer ze onzeker zijn.

2) Betrouwbaarheidsindicatoren (hoe vaak ze het mis hebben)

Vooruitgang zal eruitzien als lagere foutpercentages in realistische workflows, niet alleen hogere benchmarkscores. Volg of “hallucinaties” afnemen wanneer systemen verplicht worden bronnen te citeren, checks uit te voeren of zichzelf te verifiëren. Een belangrijke mijlpaal: sterke prestaties onder auditcondities—dezelfde taak, meerdere runs, consistente uitkomsten.

3) Economische indicatoren (waar waarde zichtbaar wordt)

Zoek naar meetbare productiviteitswinst in specifieke rollen (support, analyse, software, operations), samen met nieuwe functiecategorieën rond toezicht en integratie van AI. Kosten zijn ook belangrijk: als hoogwaardige output goedkoper wordt (per taak, per uur), versnelt adoptie—vooral bij kleine teams.

4) Governance-indicatoren (hoe de samenleving reageert)

Als capaciteit stijgt, zou governance moeten verschuiven van principes naar praktijk: standaarden, derdepartij-audits, incidentrapportage en regelgeving die aansprakelijkheid verduidelijkt. Let ook op compute-monitoring en rapportageregels—signalen dat overheden en industrie opschaling als een meetbare, beheersbare hefboom beschouwen.

Als je deze signalen wilt gebruiken zonder te overreageren op headlines, zie /blog/ai-progress-indicators.

Praktische conclusies: voorspellingen gebruiken zonder ze te overschatten

AGI-tijdlijnen kun je het beste behandelen als weersvoorspellingen voor een verre datum: nuttig voor planning, onbetrouwbaar als belofte. Kurzweil-achtige voorspellingen kunnen je helpen langetermijntrends op te merken en je keuzes te beproeven, maar ze zouden niet het enige anker in je strategie moeten zijn.

Hoe AGI-voorspellingen te lezen (zonder ze als garanties te zien)

Gebruik voorspellingen om bereiken en scenario’s te verkennen, niet één jaar. Als iemand zegt “AGI tegen 203X”, vertaal dat naar: “Welke veranderingen zouden moeten gebeuren om dat waar te maken—en wat als ze dat niet doen?” Plan vervolgens voor meerdere uitkomsten.

Vragen om een voorspelling te bevragen

- Definitie: Wat bedoelen ze met “AGI”? Menselijk-niveau op tests, brede bruikbaarheid op de werkvloer of “kan alles leren”? Verschillende definities geven verschillende tijdlijnen.

- Data: Welke indicatoren gebruiken ze—compute, trainings-efficiëntie, benchmarks, uitrolsnelheden—en wat wordt genegeerd?

- Aannames: Gaan ze ervan uit dat algoritmes, data, energie, chips en governance soepel doorgaan?

- Incentives: Verkopen ze een product, halen ze geld op of pleiten ze voor beleid? Incentives kunnen zekerheid en tijdschalen beïnvloeden.

Praktische planning: vaardigheden, strategie en risicobewustzijn

Voor individuen: bouw duurzame vaardigheden (probleemdefiniëring, domeinkennis, communicatie) en houd de gewoonte om nieuwe tools te leren.

Voor bedrijven: investeer in AI-geletterdheid, datakwaliteit en pilotprojecten met duidelijke ROI—terwijl je een “no regrets” plan houdt dat ook werkt als AGI later arriveert.

Een pragmatische manier om “signaleren en itereren” te operationaliseren is bouwcycli te verkorten: prototype workflows, test betrouwbaarheid en kwantificeer productiviteitswinst voordat je grote inzetten doet. Platforms zoals Koder.ai passen bij deze aanpak door teams toe te staan web-, backend- en mobiele apps via een chatinterface te maken (met planningsmodus, snapshots en rollback), zodat je agent-ondersteunde processen snel kunt uitproberen, broncode kunt exporteren wanneer nodig en voorkomt dat je strategie aan één voorspelling vastzit.

Een evenwichtige conclusie: tijdlijnen kunnen voorbereiding sturen, niet zekerheid geven. Gebruik ze om experimenten te prioriteren en blinde vlekken te verkleinen—en herzie je aannames regelmatig naarmate nieuw bewijs binnenkomt.