Waarom datamodellen op lange termijn vergrendelen

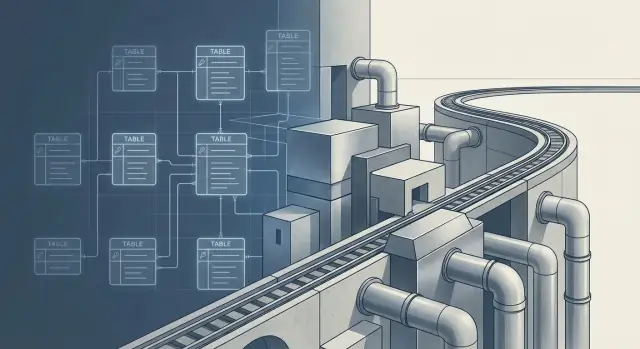

"Lock‑in" in data‑architectuur gaat niet alleen over leveranciers of tools. Het gebeurt wanneer het wijzigen van je schema zo risicovol of duur wordt dat je het niet meer doet—omdat het dashboards, rapporten, ML‑features, integraties en de gedeelde interpretatie van wat de data betekent zou breken.

Een datamodel is een van de weinige beslissingen die alles overleeft. Warehouses worden vervangen, ETL‑tools verwisseld, teams reorganiseren en naamgevingsconventies verschuiven. Maar zodra tientallen downstream‑consumenten afhankelijk zijn van kolommen, sleutels en grain van een tabel, wordt het model een contract. Het wijzigen ervan is niet alleen een technische migratie; het is een coördinatieprobleem tussen mensen en processen.

Tools zijn uitwisselbaar; afhankelijkheden niet. Een metric die in het ene model "revenue" heet, kan in een ander model "gross" betekenen. Een klantkey kan in het ene systeem "billing account" betekenen en in een ander "persoon". Zulke betekenisniveau‑afspraken zijn moeilijk ongedaan te maken zodra ze zich verspreid hebben.

De belangrijkste beslismomenten die lock‑in creëren

De meeste langdurige lock‑in valt terug te voeren op een paar vroege keuzes:

- Grain: wat één rij vertegenwoordigt (per event, per dag, per klant, per orderregel)

- Sleutels en identiteit: hoe je dingen uniek identificeert en of die identiteit kan veranderen

- Geschiedenis: of je veranderingen in de tijd bewaart en hoe (snapshots, langzaam veranderende dimensies, eventlogs)

- Semantiek: waar bedrijfsdefinities leven (metrics, dimensies en gedeelde logica)

- Toegangspatronen: optimaliseer je voor analisten, BI‑tools, applicaties of ML

Afwegingen zijn normaal. Het doel is niet om geen keuzes te maken, maar de belangrijkste keuzes doelbewust te maken en zoveel mogelijk andere keuzes omkeerbaar te houden. Latere secties richten zich op praktische manieren om breuk te verminderen wanneer verandering onvermijdelijk is.

Wat een datamodel aanraakt (meer dan je denkt)

Een datamodel is niet alleen een set tabellen. Het wordt een contract waarop veel systemen stilzwijgend vertrouwen—vaak nog voordat je de eerste versie hebt afgerond.

De voor de hand liggende afhankelijkheden

Zodra een model "geaccepteerd" is, verspreidt het zich naar:

- Dashboards en rapporten (opgeslagen queries, chart‑logica, filters)

- ML‑features (feature stores, trainingspipelines, online scoring inputs)

- Reverse ETL (sync van "customer status" of "churn risk" terug naar CRM)

- Interne of partner‑API's (services die het warehouse direct lezen)

- Data‑sharing (shares, Delta sharing, exports naar vendors)

Elke afhankelijkheid vergroot de kosten van verandering: je bewerkt niet langer één schema, je coördineert vele consumenten.

Hoe één metric vele kopieën wordt

Een enkele gepubliceerde metric (bijv. "Actieve Klant") blijft zelden gecentraliseerd. Iemand definieert het in een BI‑tool, een ander recreëert het in dbt, een growth‑analist hardcodeert het in een notebook, en een productdashboard embedt het opnieuw met licht verschillende filters.

Na een paar maanden is "één metric" eigenlijk meerdere vergelijkbare metrics met verschillende uitzonderingsregels. Het veranderen van het model loopt nu het risico niet alleen queries te breken, maar ook vertrouwen te schaden.

Verborgen koppelingen die je niet in ER‑diagrammen ziet

Lock‑in schuilt vaak in:

- Naamgevingsconventies waar downstream tools op rekenen (bijv.

*_id, created_at)

- Join‑paden die mensen als canoniek beschouwen ("orders joinen altijd customers op X")

- Impliciete bedrijfsregels vastgelegd in kolommen (bijv. uitsluiting van refunds, timezone‑logica)

Operationele impact: kosten, latency en incidentrespons

De vorm van je model beïnvloedt dagelijkse operatie: brede tabellen drijven scantkosten op, hoge‑grain eventmodellen kunnen latency verhogen, en onduidelijke lineage maakt incidents lastiger te triëren. Wanneer metrics afwijken of pipelines falen, hangt je on‑call reactie af van hoe begrijpelijk en testbaar het model is.

De grain‑beslissing: de eerste architectuurbindende keuze

"Grain" is het detailniveau dat een tabel weergeeft—één rij per wat, precies. Het klinkt klein, maar het is vaak de eerste beslissing die stilletjes je architectuur vastzet.

Grain, met eenvoudige voorbeelden

- Orders grain: één rij per order (

order_id). Goed voor ordertotalen, status en hoogover rapportage.

- Order items grain: één rij per orderregel (

order_id + product_id + line_number). Nodig voor productmix, kortingen per item, retouren per SKU.

- Sessions grain: één rij per usersessie (

session_id). Handig voor funnelanalyse en attributie.

Problemen beginnen als je een grain kiest die niet natuurlijk de vragen kan beantwoorden die het bedrijf onvermijdelijk zal stellen.

Als je alleen orders opslaat maar later "topproducten op omzet" nodig hebt, word je gedwongen om:

- arrays/JSON van items in een orders‑rij te proppen (moeilijk te querien), of

- later een

order_items tabel te bouwen en die backfillen (migratiepijn), of

- meerdere afgeleide tabellen met gedupliceerde logica te maken (

orders_by_product, orders_with_items_flat), die in de loop der tijd gaan driften.

Evenzo maakt het kiezen van sessions als primaire fact grain "netto omzet per dag" ongemakkelijk tenzij je aankopen zorgvuldig aan sessies koppelt. Je krijgt fragiele joins, kans op dubbel tellen en "speciale" metricdefinities.

Relaties die je toekomstige joins bepalen

Grain hangt nauw samen met relaties:

- One‑to‑many (order → items): als je modelleert aan de "one"‑kant, verlies je detail of creëer je herhaalde kolommen.

- Many‑to‑many (sessions ↔ campaigns, products ↔ categories): je hebt bridge‑tabellen nodig. Sla je die vroeg over, dan leiden latere workarounds vaak tot businesslogica in ETL.

Een korte grain‑validatie checklist

Voor je bouwt, stel stakeholders vragen die ze kunnen beantwoorden:

- “Als je 'een order' zegt, bedoel je dan de hele order of elk item binnenin?”

- “Moet je ooit op beide niveaus rapporteren (order en item)? Welke is primair?”

- “Wat zijn de top 5 vragen die je volgend kwartaal zult stellen? Hebben die item‑level detail nodig?”

- “Kan één event bij meerdere dingen horen (meerdere campagnes, meerdere categorieën)?”

- “Wat mag nooit dubbel worden geteld (omzet, gebruikers, sessies), en op welk grain is dat veilig?”

Sleutels en identiteit: natuurlijk vs surrogate en waarom het uitmaakt

Sleutels bepalen wanneer je model besluit "deze rij is hetzelfde echte ding als die rij." Fout hiermee en je voelt het overal: joins worden rommelig, incrementele loads vertragen, en het integreren van nieuwe systemen wordt een onderhandeling in plaats van een checklist.

Natuurlijke sleutels vs surrogate sleutels (in gewone taal)

Een natuurlijke sleutel is een identifier die al in het bedrijf of bronsysteem bestaat—zoals een factuurnummer, SKU, e‑mailadres of een CRM customer_id. Een surrogaat sleutel is een interne ID die je zelf creëert (vaak een integer of gegenereerde hash) en buiten je warehouse geen betekenis heeft.

Natuurlijke sleutels zijn aantrekkelijk omdat ze er al zijn en makkelijk te begrijpen. Surrogaat sleutels zijn aantrekkelijk omdat ze stabiel zijn—als je ze goed beheert.

Stabiliteit in de tijd: wat er gebeurt als ID's veranderen

Lock‑in toont zich wanneer een bronsysteem onvermijdelijk verandert:

- Een CRM‑migratie wijzigt customer IDs.

- Een productcatalogus hernummerd SKUs.

- Een overname brengt een tweede

customer_id namespace die overlapt.

Als je warehouse overal natuurlijke bronkeys gebruikt, kunnen die veranderingen terugwerken door feiten, dimensies en downstream dashboards. Plots verschuiven historische metrics omdat "customer 123" vroeger één persoon was en nu iets anders betekent.

Met surrogaat sleutels kun je een stabiele warehouse‑identiteit behouden door nieuwe bron‑IDs naar de bestaande surrogaatidentiteit te mappen.

Merge/dup‑logica: identiteit is geen join, het is een beleid

Echte data heeft merge‑regels nodig: "zelfde e‑mail +zelfde telefoon = dezelfde klant", of "geef voorkeur aan het nieuwste record", of "behoud beide totdat geverifieerd". Dat dedup‑beleid beïnvloedt:

- Joins: als identity resolution laat gebeurt (in BI), wordt elke join conditioneel en inconsistent.

- Incrementele loads: als merges geschiedenis kunnen herschrijven, heb je mogelijk backfills of "re‑keying" nodig, wat duur en risicovol is.

Een praktisch patroon is een aparte mapping‑tabel (identity map) bij te houden die bijhoudt hoe meerdere source‑keys naar één warehouse‑identiteit rollen.

Gevolgen voor data‑sharing en integratie van nieuwe producten

Bij het delen van data met partners of het integreren van een overgenomen bedrijf bepaalt je sleutelstrategie de benodigde inspanning. Natuurlijke sleutels die aan één systeem zijn gebonden reizen vaak slecht. Surrogaat sleutels reizen intern goed, maar vereisen een consistente crosswalk als anderen er op willen joinen.

In elk geval zijn sleutels een verbintenis: je kiest niet alleen kolommen, je bepaalt hoe bedrijfseenheden veranderingen overleven.

Tijd en verandering modelleren: je toekomstige zelf zal dankbaar zijn

Maak schema-evolutie zichtbaar

Maak een intern changelog‑app voor deprecations, eigenaars en uitroldata.

Tijd is waar "simpel" modellen duur worden. De meeste teams beginnen met een current‑state tabel (één rij per klant/order/ticket). Dat is makkelijk te queryen, maar het verwijdert stilletjes antwoorden die je later nodig zult hebben.

Bepaal wat “geschiedenis” betekent (voordat je het nodig hebt)

Meestal heb je drie opties, en elk vergrendelt verschillende tooling en kosten:

- Overschrijven (snapshot van nu): minste opslag, eenvoudigste tabellen, zwakste traceerbaarheid.

- Append‑only events (immutabele log): beste auditbaarheid, maar queries vereisen meer werk (dedupen, sessionizen, "laatste staat").

- Slowly Changing Dimensions (SCD): een middenweg voor entiteiten, typisch met

effective_start, effective_end en een is_current vlag.

Als je ooit "wat wisten we toen?" nodig hebt, heb je meer nodig dan overwrite.

Wanneer current state niet genoeg is

Teams ontdekken vaak ontbrekende geschiedenis tijdens:

- Audits en finance: "Wat was de prijs/discount/belasting ten tijde van facturatie?"

- Customer support: "Welke adres of plan was actief toen het incident gebeurde?"

- Compliance en vertrouwen: "Wie had er toegang op die datum?"

Dit achteraf reconstrueren is pijnlijk omdat upstream systemen mogelijk al de waarheid hebben overschreven.

Tijd heeft scherpe randen: zones, effective dates, late data

Tijdmodellering is niet alleen een timestampkolom.

- Tijdzones: sla een ondubbelzinnig moment op (UTC) en, indien nodig, de originele lokale tijdzone voor rapportage.

- Effective dates vs event times: “effective” is zakelijke realiteit (contractstart), “event” is wanneer het werd vastgelegd.

- Late binnenkomende data en backfills: append‑only en SCD‑patronen verwerken correcties; overwrite dwingt vaak fragiele rebuilds af.

De kosten‑ en eenvoudafweging

Geschiedenis verhoogt opslag en compute, maar kan later ook complexiteit verminderen. Append‑only logs kunnen ingest goedkoop en veilig maken, terwijl SCD‑tabellen veel voorkomende "as of" queries eenvoudig maken. Kies het patroon dat past bij de vragen die je bedrijf zal stellen—niet alleen de dashboards van vandaag.

Genormaliseerd vs dimensioneel: voor wie optimaliseer je?

Normalisatie en dimensioneel modelleren zijn meer dan "stijlen." Ze bepalen voor wie je systeem vriendelijk is—data‑engineers die pipelines onderhouden, of mensen die dagelijks vragen beantwoorden.

Genormaliseerde modellen: minder duplicatie, minder update‑pijn

Een genormaliseerd model (vaak 3NF) splitst data in kleinere, gerelateerde tabellen zodat elke feit één keer wordt opgeslagen. Het doel is duplicatie en de bijbehorende problemen te vermijden:

- Wijzig je het adres van een klant, dan update je het op één plek—niet in tien verschillende rapportagetabellen.

- Corrigeer je een productnaam, dan staat die niet inconsistent in dashboards.

Deze structuur is goed voor dataintegriteit en voor systemen waar updates vaak voorkomen. Het past bij engineering‑zware teams die duidelijke eigendomsgrezen en voorspelbare datakwaliteit willen.

Dimensionele modellen (star schema): snelheid en gebruiksgemak

Dimensioneel modelleren herschikt data voor analyse. Een typisch star schema heeft:

- Een fact table (events of metingen zoals orders, sessions, betalingen)

- Meerdere dimension tables (beschrijvende context zoals klant, product, datum, regio)

Dit formaat is snel en intuïtief: analisten kunnen filteren en groeperen zonder complexe joins, en BI‑tools werken er doorgaans goed mee. Productteams profiteren ook—self‑service exploratie wordt realistischer wanneer veelgebruikte metrics makkelijk te queryen zijn.

Wie profiteert van elke keuze?

Genormaliseerde modellen optimaliseren voor:

- data platform beheerders (schoon updaten, minder duplicatie)

- consistentie over meerdere downstream‑gebruikers

Dimensionele modellen optimaliseren voor:

- analisten en analytics engineers (simpelere SQL)

- BI‑tools (eenduidige relaties)

- productteams (snellere antwoorden, meer self‑service)

De lock‑in is reëel: zodra tientallen dashboards afhankelijk zijn van een star schema, wordt het politiek en operationeel duur om grain of dimensies te veranderen.

Een praktisch hybride: genormaliseerde staging + curated marts

Een veelgebruikte anti‑drama aanpak is beide lagen te behouden met duidelijke verantwoordelijkheden:

- Genormaliseerde staging/core: land en standaardiseer data met minimale reshaping, behoud bronnen en beperk duplicatie.

- Gecurateerde dimensionele marts: publiceer star schemas voor de meest waardevolle use cases (omzet, groei, retentie) met stabiele metricdefinities.

Dit hybride model houdt je "systeem van record" flexibel en geeft het bedrijf tegelijkertijd de snelheid en gebruiksvriendelijkheid die het verwacht—zonder één model alle taken te laten doen.

Event‑centrisch vs entiteit‑centrisch

Event‑centrische modellen beschrijven wat er gebeurde: een klik, een betaalpoging, een zendingupdate, een support‑reply. Entiteit‑centrische modellen beschrijven wat iets is: een klant, een account, een product, een contract.

Waar je voor optimaliseert

Entiteit‑centrisch modelleren (stabiele tabellen met "huidige staat" kolommen) is goed voor operationele rapportage en eenvoudige vragen zoals "Hoeveel actieve accounts hebben we?" of "Wat is het huidige plan van elke klant?" Het is intuïtief: één rij per ding.

Event‑centrisch modelleren (append‑only feiten) optimaliseert voor analyse over tijd: "Wat veranderde?" en "In welke volgorde?" Het ligt vaak dichter bij bronsystemen, wat het makkelijker maakt nieuwe vragen later toe te voegen.

Waarom event‑modellen flexibeler kunnen zijn

Als je een goed beschreven stream van events houdt—elk met timestamp, actor, object en context—kun je later nieuwe vragen beantwoorden zonder het kernmodel te herschikken. Bijvoorbeeld: "first value moment", "drop‑off tussen stappen" of "tijd van trial start tot eerste betaling" kun je afleiden uit bestaande events.

Er zijn grenzen: als de event‑payload nooit een belangrijke attribuut vastlegde (bijv. welke marketingcampagne van toepassing was), kun je die niet later verzinnen.

De verborgen kosten

Event‑modellen zijn zwaarder:

- Volume: veel meer rijen, hogere opslag en compute.

- Late/out‑of‑order events: je hebt regels nodig voor correctie en backfills.

- Sessionization en state‑reconstructie: events omzetten in "sessions", "actieve gebruikers" of "huidige status" kan complex en kostbaar zijn.

Waar entiteiten essentieel blijven

Zelfs event‑first architecturen hebben meestal stabiele entiteitstabellen nodig voor accounts, contracten, productcatalogus en andere referentiedata. Events vertellen het verhaal; entiteiten definiëren de cast. De lock‑in‑keuze is hoeveel betekenis je encodeert als "huidige staat" versus het afleiden uit historie.

Semantische lagen en metrics: lock‑in op het niveau van bedrijfsbetekenis

Beheer sleutels en identiteitswijzigingen

Zet een key‑crosswalk reviewtool op om identiteit en merges in de tijd te beheren.

Een semantische laag (metrics layer) is het vertaalblad tussen ruwe tabellen en de cijfers die mensen echt gebruiken. In plaats van dat elk dashboard (of analist) logica als "Revenue" of "Active customer" opnieuw implementeert, definieert de semantische laag die termen één keer—met de dimensies waarop je mag slicen en de filters die altijd moeten gelden.

Metricdefinities worden een API

Zodra een metric breed is geadopteerd, gedraagt het zich als een API voor het bedrijf. Honderden rapporten, alerts, experimenten, forecasts en bonusplannen kunnen ervan afhankelijk zijn. Een wijziging in de definitie kan het vertrouwen breken, zelfs als de SQL blijft draaien.

De lock‑in is niet alleen technisch—het is sociaal. Als "Revenue" altijd refunds uitsloot, zal een plotselinge switch naar nettorevenue trends er opeens vreemd uit laten zien. Mensen stoppen met het vertrouwen van de data voordat ze vragen wat er veranderd is.

Waar betekenis zich vastzet

Kleine keuzes harden snel uit:

- Naamgeving: Een metric

orders impliceert een telling van orders, niet van orderregels. Onduidelijke namen nodigen inconsistent gebruik uit.

- Dimensies: Bepalen of je per

order_date of ship_date mag groeperen verandert verhalen en operationele beslissingen.

- Filters: Standaardinstellingen zoals "exclude internal accounts" of "only paid invoices" zijn makkelijk te vergeten en moeilijk terug te draaien.

- Attributieregels: "Signups by channel" kan first‑touch, last‑touch of een 7‑daags venster gebruiken. Die ene standaard kan bepalen welke teams succesvol lijken.

Versionering en communicatie van verandering

Behandel metricveranderingen als productreleases:

- Versioneer metrics expliciet:

revenue_v1, revenue_v2 en houd beide beschikbaar tijdens transitie.

- Documenteer het contract: definitie, inclusies/exclusies, attributievenster en toegestane dimensies.

- Kondig breaking changes vroeg aan: release‑notes in docs, een migratietijdlijn en side‑by‑side validatie‑dashboards.

- Deprecateer met data: "v1 verwijderd na Q2" is duidelijker dan "gebruik v2 voortaan."

Als je de semantische laag doelbewust ontwerpt, reduceer je lock‑in pijn door betekenissen veranderbaar te maken zonder iedereen te verrassen.

Schema‑evolutie: breaking changes vermijden

Schemawijzigingen zijn niet gelijk. Het toevoegen van een nieuwe nullable kolom is meestal laag risico: bestaande queries negeren hem, downstream jobs blijven draaien en je kunt later backfillen.

Het veranderen van de betekenis van een bestaande kolom is de dure soort. Als status vroeger "betalingsstatus" betekende en nu "orderstatus", worden dashboards, alerts en joins stilzwijgend fout—ook al faalt er niets duidelijk. Betekeniswijzigingen veroorzaken stille dataklachten, niet luide fouten.

Behandel gedeelde tabellen als contracten

Voor tabellen die door meerdere teams worden gebruikt, definieer een expliciet contract en test het:

- Verwacht schema: kolomnamen, types en of een kolom verwijderd mag worden.

- Toegestane nulls: welke velden altijd aanwezig moeten zijn vs optioneel.

- Toegestane waarden: enums (bijv.

pending|paid|failed) en numerieke grenzen.

Dit is in wezen contracttesten voor data. Het voorkomt onopzettelijke drift en maakt "breaking change" een duidelijke categorie, niet een eindeloze discussie.

Achterwaarts compatibele patronen die werken

Als je een model moet evolueren, mik op een periode waarin oude en nieuwe consumenten naast elkaar bestaan:

- Deprecate, verwijder niet direct: behoud oude kolommen voor een gedefinieerd venster en markeer ze als deprecated in docs.

- Dual‑write: vul zowel oude als nieuwe velden/tabellen totdat consumenten migreren.

- Alias‑views: exposeer een stabiele view die oude namen behoudt terwijl onderliggende tabellen veranderen.

Eigenaarschap en goedkeuringen

Gedeelde tabellen hebben duidelijk eigenaarschap nodig: wie verandert keurt goed, wie krijgt notificaties en wat is het rollout‑proces. Een lichtgewicht wijzigingsbeleid (owner + reviewers + deprecatie‑tijdlijn) doet meer om breuk te voorkomen dan welk tool ook.

Prestatie- en kostenbeperkingen die het model vormen

Versiebeheer metrics zonder verrassingen

Maak een stakeholder review‑app om revenue_v1 vs revenue_v2 zij-aan-zij te vergelijken.

Een datamodel is niet alleen een logisch diagram—het zijn fysieke keuzes over hoe queries draaien, hoeveel ze kosten en wat later pijnlijk wordt om te veranderen.

Partitionering en clustering dicteren querygedrag

Partitionering (vaak op datum) en clustering (op veelgefilterde sleutels zoals customer_id of event_type) belonen bepaalde querypatronen en straffen andere.

Als je partitioneert op event_date, blijven dashboards die "laatste 30 dagen" filteren goedkoop en snel. Maar als veel gebruikers vaak slicen op account_id over lange periodes, scan je alsnog veel partitities—kosten stijgen en teams beginnen workarounds te maken (summary tables, extracts) die het model verder verankeren.

Brede tabellen vs veel joins: snelheid vs flexibiliteit

Brede tabellen (gedenormaliseerd) zijn vriendelijk voor BI‑tools: minder joins, minder verrassingen, snellere "time to first chart." Ze kunnen ook goedkoper per query zijn als ze herhaalde joins vermijden.

De afweging: brede tabellen dupliceren data. Dat verhoogt opslag, bemoeilijkt updates en maakt consistente definities afdwingen lastiger.

Sterk genormaliseerde modellen beperken duplicatie en kunnen integriteit verbeteren, maar herhaalde joins vertragen queries en geven een slechtere gebruikerservaring—vooral wanneer niet‑technische gebruikers eigen rapporten bouwen.

Incrementele loads beperken schema‑keuzes

De meeste pipelines laden incrementeel (nieuwe rijen of gewijzigde rijen). Dat werkt het beste met stabiele sleutels en een append‑vriendelijke structuur. Modellen die frequent de "verleden herschrijven" vereisen (bijv. vele afgeleide kolommen herbouwen) zijn duur en operationeel risicovol.

Datakwaliteitschecks, backfills en reprocessing

Je model bepaalt wat je kunt valideren en wat je kunt repareren. Als metrics afhankelijk zijn van complexe joins, worden kwaliteitschecks moeilijk te lokaliseren. Als tabellen niet gepartitioneerd zijn op de manier waarop je backfillt (per dag, per bronbatch), kan reprocessing betekenen dat je veel meer data moet scannen en herschrijven—waardoor routinecorrecties grote incidenten worden.

Hoe moeilijk is het later te veranderen? Migratie realiteitscheck

Het veranderen van een datamodel later is zelden een "refactor." Het lijkt meer op het verplaatsen van een stad terwijl mensen er nog wonen: rapporten moeten blijven draaien, definities moeten consistent blijven en oude aannames zitten ingebakken in dashboards, pipelines en zelfs beloningsplannen.

Wat typisch een migratie forceert

Enkele triggers die vaak terugkomen:

- Een nieuw warehouse/lakehouse (kosten, performance, vendorstrategie) dat niet goed matcht met je huidige schema.

- M&A of desinvesteringen, waar twee bedrijven incompatibele customer IDs, producthiërarchieën en metricdefinities meenemen.

- Nieuwe productlijnen of kanalen die de oorspronkelijke grain breken (bijv. je modelde subscriptions en voegde later usage‑based billing toe).

Een veiliger stappenplan dan "big bang"

De laagste‑risico aanpak behandelt migratie als engineering‑project én change‑managementproject.

- Draai parallelle modellen: houd het oude schema stabiel terwijl je het nieuwe naast het oude opbouwt.

- Reconcilieer continu: publiceer zij‑aan‑zij outputs en onderzoek verschillen vroeg (niet pas aan het eind).

- Plan cutover doelbewust: migreer de belangrijkste, minst complexe use cases eerst; freeze definities; communiceer data.

Als je ook interne data‑apps (admin tools, metric explorers, QA dashboards) onderhoudt, behandel die als first‑class migratieconsumenten. Teams gebruiken soms een snelle app‑bouwworkflow—zoals Koder.ai—om lightweight "contract check" UIs, reconciliatie‑dashboards of stakeholder reviewtools te maken tijdens parallelle runs, zonder weken aan engineeringtijd af te leiden.

Hoe je kunt zien of het gelukt is

Succes is niet "de nieuwe tabellen bestaan." Het is:

- Query‑pariteit: kritieke queries geven dezelfde antwoorden binnen afgesproken toleranties.

- Metric‑pariteit: hoofd KPI's komen overeen door definitie, niet toevallig.

- Gebruikersadoptie: analisten en stakeholders stappen daadwerkelijk over en oude dashboards worden uitgefaseerd.

Budgettering en tijdslijnen

Modelmigraties kosten vaker meer tijd dan verwacht omdat reconciliatie en stakeholdergoedkeuring de echte knelpunten zijn. Behandel kostenplanning als een volwaardig werkstroom (personeelstijd, dubbele compute, backfills). Als je manieren nodig hebt om scenario's en afwegingen te kaderen, verwijst de originele tekst naar /pricing.