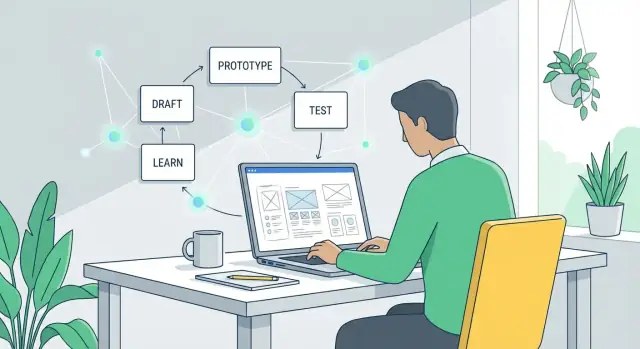

Wat “goedkoop en snel experimenteren” echt betekent

“Experimenteren met ideeën” betekent een kleine test met lage verplichting uitvoeren voordat je zwaar investeert. In plaats van te debatteren of een concept goed is, voer je een snelle controle uit om te leren wat mensen daadwerkelijk doen: klikken, zich aanmelden, reageren of negeren.

Experimenteren met ideeën, in gewone taal

Een idee-experiment is een mini-versie van het echte werk—net genoeg om één vraag te beantwoorden.

Bijvoorbeeld:

- Als je twijfelt over je boodschap, test twee kopregels en kijk welke meer aanmeldingen oplevert.

- Als je twijfelt over de set functies, laat een eenvoudige demo zien en vraag gebruikers wat ze verwachtten dat er zou gebeuren.

- Als je twijfelt of iemand het wil, zet een “coming soon”-pagina neer en meet de interesse.

Het doel is niet bouwen; het is onzekerheid verminderen.

Waarom experimenten vroeger duur waren

Traditioneel vereisten zelfs kleine tests coördinatie tussen meerdere rollen en tools:

- Tijd: copy schrijven, schermen ontwerpen, pagina’s bouwen, analytics opzetten, interviews plannen.

- Mensen: marketeers, ontwerpers, engineers en onderzoekers.

- Overhead: landingspage-builders, enquête-tools, advertentiekosten, prototype-software, plus revisies en afstemming.

Die kosten duwen teams naar “grote inzetten”: eerst bouwen, later leren.

Hoe “goedkoop en snel” eruitziet met AI

AI verlaagt de inspanning om testmaterialen te produceren—concepten, varianten, scripts, samenvattingen—zodat je meer experimenten kunt draaien met minder frictie.

- Goedkoop betekent vaak het valideren van een aanname zonder meerdere rollen dagenlang erbij te betrekken.

- Snel betekent van vraag → testmateriaal → eerste signaal in uren, niet weken.

Stel verwachtingen bij: sneller leren, geen gegarandeerde successen

AI maakt ideeën niet automatisch goed en kan echt gebruikersgedrag niet vervangen. Wat het wél goed kan:

- snel opties genereren (berichten, flows, vragen)

- experimentontwerp aanscherpen (duidelijke hypothese, heldere succesmetric)

- feedback sneller analyseren (thema’s, bezwaren, verwarring)

Je moet nog steeds de juiste vraag kiezen, eerlijke signalen verzamelen en beslissingen nemen op basis van bewijs—niet op hoe gepolijst het experiment eruitziet.

Waarom traditioneel idee-testen traag en kostbaar is

Traditioneel falen idee-tests zelden omdat teams niet om resultaten geven. Ze falen omdat de “simpele test” in werkelijkheid een keten van werk is over meerdere rollen—elk met echte kosten en kalendervertraging.

De echte kostenstapel (zelfs voor een klein experiment)

Een basis validatie-sprint bevat meestal:

- Onderzoek: concurrenten, klantcitaten, hypotheses, werving.

- Schrijven: landingspage-tekst, value props, outreach, interviewscripts, enquêtevragen.

- Ontwerp: wireframes, creatives, layouts, prototypes.

- Codering: een testpagina, analytics-events, experimentflags, formulieren.

- Analyse: resultaten opschonen, notities synthetiseren, overeenstemming over wat “succes” betekent.

Zelfs als elk onderdeel “lichtgewicht” is, loopt de gecombineerde inspanning op—vooral door revisierondes.

Vertragingen vermenigvuldigen de kosten meer dan werk doet

De grootste verborgen kost is wachten:

- Wachten op overdrachten tussen product, design, engineering, marketing en legal

- Wachten op meetings om af te stemmen wat getest wordt

- Wachten op reviews, goedkeuringen en meer edits

Die vertragingen rekken een 2-daagse test uit naar een cyclus van 2–3 weken. Als feedback laat komt, starten teams vaak opnieuw omdat aannames zijn verschoven.

De opportunity cost: langer gokken

Als testen traag is, compenseren teams door te discussiëren en besluiten te nemen op basis van onvolledig bewijs. Je blijft bouwen, communiceren of verkopen rond een ongetest idee langer dan nodig—en neemt beslissingen die moeilijker (en duurder) terug te draaien zijn.

Traditioneel testen is niet “te duur” op zich; het is duur omdat het leren vertraagt.

Hoe AI de economie van ideeën veranderen

AI maakt teams niet alleen “sneller.” Het verandert wat experimenteren kost—vooral de kosten om een geloofwaardige eerste versie te produceren.

De kernverandering: eerste versies worden goedkoop

Traditioneel is het dure deel van idee-validatie iets voldoende echt maken om te testen: een landingspagina, een salesmail, een demo-script, een klikbaar prototype, een enquête of zelfs een duidelijke positionering.

AI-tools verminderen dramatisch de tijd (en specialistische moeite) om deze vroege artefacten te maken. Als de opzetkosten dalen, kun je je veroorloven om:

- meer ideeën te testen voordat je je vastlegt

- meer varianten te verkennen (doelgroepen, prijsstellingen, messaging)

- stakeholders eerder te betrekken (omdat er iets concreets is om op te reageren)

Het resultaat is meer “shots on goal” zonder een groter team of weken wachten.

Ingekorte cycli: schets → feedback → herzien

AI comprimeert de lus tussen denken en leren:

- Schets: genereer meerdere opties (copy, flows, functiebeschrijvingen, FAQ, value props).

- Feedback: deel met gebruikers/ prospects/collega’s, of voer gestructureerde kritiekrondes uit met een checklist.

- Herzien: iterate direct terwijl bezwaren en vragen vers zijn.

Als deze lus in uren draait in plaats van weken, besteden teams minder tijd aan het verdedigen van halfgebouwde oplossingen en meer tijd aan reageren op bewijs.

Snelheid is niet hetzelfde als betere beslissingen

Snel outputten kan een vals gevoel van vooruitgang geven. AI maakt het makkelijk om plausibele materialen te produceren, maar plausibiliteit is geen validatie.

De kwaliteit van beslissingen hangt nog steeds af van:

- de juiste vragen stellen (welk risico verminder je?)

- testen met de juiste mensen

- signalen meten die uitkomsten voorspellen (niet alleen “lijkt goed” feedback)

Goed gebruikt verlaagt AI de kosten van leren. Onzorgvuldig gebruikt verlaagt het alleen de kosten om sneller meer gissingen te doen.

Snelle content-schetsen: test messaging in minuten

Bij het valideren van een idee heb je geen perfecte tekst nodig—je hebt geloofwaardige opties die je snel aan mensen kunt voorleggen. Generatieve AI is uitstekend in het produceren van eerste drafts die goed genoeg zijn om te testen en daarna te verfijnen op basis van wat je leert.

Wat je snel moet schetsen (en waarom het ertoe doet)

Je kunt messaging-assets binnen enkele minuten opzetten die normaal dagen kosten:

- Koppen en subkoppen voor verschillende value propositions

- Landingspagina-teksten (hero, voordelen, bezwaren, call-to-action)

- E-mailreeksen (welkomst, follow-up, herinnering)

- FAQ’s die bezwaren adresseren en wrijving verminderen

Het doel is snelheid: zet meerdere plausibele versies live, en laat echt gedrag (klikken, reacties, aanmeldingen) je vertellen wat resoneert.

Genereer meerdere invalshoeken zonder opnieuw te beginnen

Vraag AI om verschillende benaderingen voor hetzelfde aanbod:

- Voordeel-gericht: “Krijg X resultaat zonder Y gedoe.”

- Probleem-gericht: “Heb je nog steeds last van X? Hier is een simpelere manier.”

- Verhaal-gericht: een korte narrative met voor/na.

Omdat elke invalshoek snel te schetsen is, kun je vroeg messaging-breedte testen—voordat je investeert in design, product of lange copywritingcycli.

Pas toon aan voor verschillende doelgroepen

Je kunt hetzelfde kernidee afstemmen op verschillende lezers (founders vs. operations-teams) door toon en context te specificeren: “zelfverzekerd en beknopt,” “vriendelijk en eenvoudig,” of “formeel en compliance-bewust.” Dit maakt gerichte experimenten mogelijk zonder helemaal opnieuw te schrijven.

Tip: houd één “source of truth” boodschap

Snelheid kan inconsistentie veroorzaken. Hou een kort berichtendocument (1–2 alinea’s): voor wie het is, de hoofdbelofte, belangrijkste bewijspunten en wat je uitsluit. Gebruik dit als input voor elke AI-schets zodat varianten op één lijn blijven—en je invalshoeken test, niet tegenstrijdige claims.

Prototypes zonder zwaar ontwerpwerk

Je hebt geen volledige design-sprint nodig om te zien of een idee “klikt.” Met AI kun je een geloofwaardig prototype maken dat goed genoeg is om op te reageren—zonder weken aan mockups, stakeholder-reviewloops en pixel-perfect discussies.

Begin met een prototype-kit, niet een leeg canvas

Geef AI een korte productbrief en vraag om bouwstenen:

- een functieslijst (moet-hebben vs. leuk-om-te-hebben)

- een eenvoudige gebruikersflow (wat gebeurt eerst, daarna en als laatste)

- voorgestelde schermen (home, onboarding, instellingen, checkout, enz.)

- UI-tekst voor knoppen, tooltips, lege toestanden en foutmeldingen

Zet die flow daarna om in snelle wireframes met eenvoudige tools (Figma, Framer of zelfs slides). AI-gegenereerde copy laat de schermen realistischer aanvoelen, wat feedback veel specifieker maakt dan “ziet er goed uit.”

Maak klikbare prototypes in uren

Als je schermen hebt, koppel ze aan een klikbare demo en test de kernactie: aanmelden, zoeken, boeken, betalen of delen.

AI kan ook realistisch tijdelijke inhoud genereren—voorbeeldvermeldingen, berichten, productbeschrijvingen—zodat testers niet in de war raken door “Lorem ipsum.”

Produceer varianten voor verschillende gebruikers

In plaats van één prototype, maak 2–3 versies:

- nieuwe gebruikers: meer begeleiding, minder keuzes, duidelijkere labels

- power users: snelkoppelingen, bulkacties, geavanceerde filters

Dit helpt valideren of je idee verschillende paden nodig heeft, niet alleen ander woordgebruik.

Snelle toegankelijkheids- en duidelijkheidschecks

AI kan UI-tekst scannen op verwarrende jargon, inconsistente labels, ontbrekende lege-toestand-voorlichting en te lange zinnen. Het kan ook veelvoorkomende toegankelijkheidsproblemen signaleren (contrast, onduidelijke linktekst, onduidelijke foutmeldingen) zodat je vermijdbare wrijving opvangt voordat je iets aan gebruikers toont.

Snelle MVP’s: van concept naar demo in korte tijd

Test een idee vandaag

Zet één hypothese om in een werkend demo vandaag met Koder.ai en leer van echt gebruik.

Een snelle MVP is geen kleinere versie van het uiteindelijke product—het is een demo die een kernaanname bewijst of ontkracht. Met AI kun je in dagen (of uren) bij die demo komen door “perfect” over te slaan en te focussen op één taak: de kernwaarde duidelijk genoeg tonen zodat iemand reageert.

Waar AI bij versnelt

AI is nuttig wanneer de MVP net genoeg structuur nodig heeft om echt aan te voelen:

- Eenvoudige scripts en pseudo-code om een concept om te zetten in een klikbare of werkende flow.

- API-voorbeelden om “integratie” te faken (ook als de echte backend nog niet bestaat).

- Scaffolding voor kleine tools zoals calculators, schatters, onboarding-wizards, interne dashboards of een lichte Chrome-extensie.

Bijvoorbeeld: als je idee een “terugbetalings-eligibilitychecker” is, kan de MVP een enkele pagina zijn met een paar vragen en een gegenereerd resultaat—geen accounts, geen facturering, geen randgeval-afhandeling.

answers = collect_form_inputs()

score = rules_engine(answers)

result = generate_explanation(score, answers)

return result

Als je verder wilt gaan dan een klikbare mock en iets wilt demo’en dat als een echte app voelt, kan een vibe-coding platform zoals Koder.ai een praktische shortcut zijn: je beschrijft de flow in chat, genereert een werkende webapp (vaak React aan de voorkant met een Go + PostgreSQL backend) en iterereert snel—met de optie om broncode te exporteren als het experiment doorgaat naar productiewaarde.

Houd de scope veilig: prototypekwaliteit vs. productiekwaliteit

AI kan snel werkende code genereren, maar die snelheid kan het verschil vervagen tussen een prototype en iets dat je in productie wilt zetten. Stel verwachtingen vooraf:

- Prototypekwaliteit: bewijst wenselijkheid, bruikbaarheid en basishaalbaarheid.

- Productiekwaliteit: handelt schaal, beveiliging, monitoring, randgevallen, compliance en onderhoud af.

Een goede vuistregel: als de demo vooral voor leren is, mag je hoeken afsnijden—zolang die hoeken geen risico creëren.

Sla review niet over: beveiliging, privacy, betrouwbaarheid

Zelfs MVP-demos hebben een korte sanity-check nodig. Voordat je gebruikers laat zien of echte data aansluit:

- Beveiliging: geen blootgestelde sleutels, onveilige dependencies of open admin-eindpunten.

- Privacy: vermijd persoonsgegevens tenzij echt noodzakelijk; anonimiseer en minimaliseer.

- Betrouwbaarheid: handel voor de hand liggende fouten af (lege inputs, API-timeouts) zodat de test het idee meet—niet een kapotte demo.

Goed gedaan verandert AI “concept naar demo” in een herhaalbare gewoonte: bouwen, tonen, leren, itereren—zonder vroeg te veel te investeren.

Goedkoper gebruikersonderzoek met betere voorbereiding

Gebruikersonderzoek wordt duur als je het “ad hoc” doet: onduidelijke doelen, slechte werving en rommelige notities die uren kosten om te interpreteren. AI kan de kosten verlagen door je te helpen de voorbereidingen goed te doen—voordat je überhaupt een call plant.

Maak solide materialen in één sessie

Begin met AI je interviewgids te laten opstellen en verfijn die met je specifieke doel (welke beslissing moet dit onderzoek informeren?). Je kunt ook genereren:

- screenervragen om de juiste deelnemers te vinden (en de verkeerde uit te sluiten)

- outreach-berichten voor e-mail, LinkedIn of in-product prompts

- een korte onderzoeksbrief die je met teamgenoten deelt zodat iedereen weet wat je test

Dit verkleint de opzet van dagen naar een uur, waardoor kleine, frequente studies realistischer worden.

Consistentere notities en snellere synthese

Na interviews plak je aantekeningen (of een transcript) in je AI-tool en vraag je om een gestructureerde samenvatting: belangrijkste pijnpunten, huidige alternatieven, momenten van delight en directe quotes.

Je kunt het ook vragen feedback per thema te taggen zodat elk interview hetzelfde wordt verwerkt—ongeacht wie de sessie leidde.

Vraag daarna het AI-systeem om hypotheses voor te stellen op basis van wat het hoorde, duidelijk gemarkeerd als hypotheses (geen feiten). Bijvoorbeeld: “Hypothese: gebruikers haken af omdat onboarding de waarde niet in de eerste sessie toont.”

Houd onderzoek eerlijk (vermijd sturende vragen)

Laat AI je vragen controleren op bias. Vervang prompts zoals “Zou je deze snellere workflow gebruiken?” door neutrale vragen zoals “Hoe doe je dit nu?” en “Wat zou je doen om over te stappen?”

Als je een snelle checklist voor deze stap wilt, bewaar die als teamreferentie (bijv. /blog/user-interview-questions).

Snelle experimenten: enquêtes, A/B-tests en smoke tests

Verdien credits voor leren

Deel wat je bouwde op Koder.ai en verdien credits om meer experimenten te draaien.

Snelle experimenten helpen de richting van een beslissing te leren zonder je aan een volledige build te verbinden. AI helpt je ze sneller op te zetten—vooral als je meerdere varianten en consistente materialen nodig hebt.

Enquêtes: snelle feedback, betere vragen

AI is uitstekend in het opstellen van enquêtes, maar de echte winst is het verbeteren van de vraagkwaliteit. Vraag het om neutrale bewoording (geen sturende taal), heldere antwoordopties en logische flow.

Een eenvoudige prompt als “Herschrijf deze vragen zodat ze onbevooroordeeld zijn en voeg antwoordopties toe die resultaten niet vertekenen” kan onbedoelde overtuiging verwijderen.

Definieer voordat je verzendt wat je met de resultaten doet: “Als minder dan 20% optie A kiest, gaan we deze positionering niet doorzetten.”

A/B-tests: genereer varianten zonder tijd te verbranden

Voor A/B-testen kan AI snel meerdere varianten genereren—kopregels, hero-secties, e-mailonderwerpen, prijspagina-tekst en calls to action.

Blijf gedisciplineerd: verander één element tegelijk zodat je weet wat het verschil veroorzaakt.

Plan succesmetrics vooraf: click-through rate, aanmeldingen, demo-aanvragen of conversie van prijspagina → checkout. Koppel de metric aan de beslissing die je moet nemen.

Smoke tests: vraag naar vraag voordat je bouwt

Een smoke test is een lichtgewicht “doen alsof”-experiment: een landingspagina, een checkout-knop of een aanmeldformulier. AI kan de pagina-tekst, FAQ’s en alternatieve value propositions schetsen zodat je kunt testen wat resoneert.

Waarschuwingsregels tegen valse zekerheid

Kleine steekproeven kunnen misleiden. AI kan helpen resultaten te interpreteren, maar kan geen zwakke data fixen. Beschouw vroege resultaten als signalen, niet als definitief bewijs, en let op:

- te kleine steekproefomvang (gemakkelijk om te overreageren)

- bevooroordeelde verkeersbronnen (collega’s, interne teams)

- metrics die geen echte intentie weerspiegelen (klikken vs. aanmeldingen)

Gebruik snelle experimenten om opties te verkleinen—en bevestig daarna met een sterkere test.

Snellere analyse en helderdere beslissingen

Snel experimenteren helpt alleen als je rommelige inputs kunt omzetten in een vertrouwd besluit. AI is hier nuttig omdat het notities, feedback en resultaten kan samenvatten, vergelijken en patronen kan laten zien—zonder uren in spreadsheets.

Zet ruwe notities om in een beslisbrief

Na een call, enquête of kleine test plak je ruwe notities en vraag je AI om een één-pagina “decision brief” te maken:

- wat we testten (hypothese, doelgroep, kanaal)

- wat er gebeurde (belangrijkste signalen, opvallende quotes, cijfers)

- wat we denken dat het betekent (interpretatie + vertrouwen)

- aanbevolen volgende stap (doorgaan, aanpassen of stoppen)

Dit voorkomt dat inzichten alleen in iemands hoofd blijven of begraven raken in een document dat niemand opent.

Vergelijk opties met voor- en nadelen en aannames

Als je meerdere richtingen hebt, vraag AI om een kant-en-klare vergelijking:

- Optie A vs. B: pro’s, con’s, risico’s

- Aannames die waar moeten zijn

- goedkoopste experiment om elke aanname te testen

Je vraagt AI niet om “de winnaar te kiezen.” Je gebruikt het om redenering expliciet en gemakkelijker te weerleggen.

Definieer criteria die je overtuigen

Schrijf voordat je het volgende experiment draait beslissingsregels. Voorbeeld: “Als minder dan 5% van bezoekers op ‘Request access’ klikt, stoppen we met deze boodschap.” AI kan helpen criteria op te stellen die meetbaar zijn en gekoppeld aan de hypothese.

Houd een lichtgewicht experimentlog bij

Een simpel logboek (datum, hypothese, methode, resultaten, beslissing, link naar brief) voorkomt dubbel werk en maakt leren cumulatief.

Bewaar het waar je team al kijkt (gedeeld document, interne wiki of een map met links).

Risico’s en regels: nauwkeurig en ethisch blijven

Snel werken met AI is een superkracht—maar het kan ook fouten versterken. Als je in tien minuten tien concepten kunt genereren, is het makkelijk om “veel output” te verwarren met “goed bewijs.”

Waar het mis kan gaan

Hallucinaties zijn het grootste risico: een AI kan vol vertrouwen feiten, citaten, gebruikersquotes of marktgetallen verzinnen. In snel experimenteren kunnen verzonnen details stilletjes de basis van een MVP of pitch worden.

Een andere valkuil is overfitten op AI-voorstellen. Als je steeds vraagt naar “het beste idee,” achtervolg je misschien wat tekstueel plausibel klinkt in plaats van wat klanten willen. Het model optimaliseert samenhang, niet waarheid.

Tot slot maakt AI het makkelijk om onbewust concurrenten te kopiëren. Als je prompt vraagt om “voorbeelden uit de markt,” kun je afglijden naar bijna-kopieën van bestaande positionering of features—risicovol voor differentiatie en mogelijk IP.

Eenvoudige regels die je eerlijk houden

Vraag de AI om onzekerheid te tonen:

- “Noem de aannames die je maakt en beoordeel het vertrouwen (laag/midden/hoog).”

- “Wat zou je antwoord veranderen? Welke data heb je nodig?”

Voor claims die geld, veiligheid of reputatie raken, verifieer kritische punten. Behandel AI-output als een concept-onderzoeksrapport, niet als het onderzoek zelf.

Als het model statistieken noemt, eis controleerbare bronnen (en check die daarna): “Geef bronnen en quotes uit de originele bron.”

Beperk ook inputbias: hergebruik een consistente prompttemplate, houd een versieerbaar document met “feiten die we geloven” bij, en voer kleine experimenten met verschillende aannames uit zodat één prompt het resultaat niet dicteert.

Privacy en ethiek basics

Plak geen gevoelige data (klantinfo, interne omzet, eigencode, juridische documenten) in niet-goedgekeurde tools. Gebruik geredigeerde voorbeelden, synthetische data of veilige enterprise-oplossingen.

Als je messaging test, maak AI-betrokkenheid duidelijk waar dat gepast is en verzin geen testimonials of gebruikersquotes.

Een praktische workflow voor snelle iteratie

Test varianten sneller

Bouw twee versies van een flow en vergelijk welke de gewenste actie krijgt.

Snelheid is niet alleen “sneller werken”—het is een herhaalbare lus draaien die voorkomt dat je het verkeerde gaat polijsten.

Een eenvoudige workflow is:

Hypothese → Bouwen → Testen → Leren → Itereren

1) Begin met een scherpe hypothese

Schrijf het in één zin:

“We geloven dat [doelgroep] [actie] zal doen omdat [reden]. We weten dat we gelijk hebben als [metric] [drempel] haalt.”

AI kan helpen vage ideeën om te zetten in testbare verklaringen en meetbare succescriteria voorstellen.

2) Definieer “goed genoeg om te testen”

Stel vooraf een minimale kwaliteitsdrempel:

- duidelijke belofte (één zin)

- één primaire call-to-action

- één realistisch gebruikersscenario

- geen merk-perfecte visuals nodig

Als het daaraan voldoet, stuur het naar een test. Zo niet, repareer alleen wat begrip blokkeert.

3) Run timeboxed cycli (kies er één)

2-uur cyclus: Schrijf landingspagina-tekst + 2 advertentievarianten, lanceer een kleine mediabesteding of deel met een kleine doelgroep, verzamel klikken + reacties.

1-dag cyclus: Maak een klikbaar prototype (ruwe UI is ok), voer 5 korte gebruiksgesprekken uit, noteer waar mensen aarzelen en wat ze daarna verwachten.

1-week cyclus: Bouw een dunne MVP-demo (of concierge-versie), rekruteer 15–30 doelgebruikers, meet activatie en bereidheid om door te gaan.

4) Wijs rollen toe—ook als het één persoon is

- Founder: kiest de hypothese en de beslissing om te verzenden.

- Marketeer: definieert doelgroep, kanalen en succesmetrics.

- Ontwerper: zorgt dat de flow begrijpelijk is (niet mooi).

- Analist: zet tracking op, logt resultaten, vat leerpunten samen.

5) Sluit de lus met een beslissing

Na elke test schrijf je een korte “learning memo”: wat gebeurde, waarom, en wat verander je volgende keer. Beslis dan: iterate, pivot de hypothese, of stop.

Deze memo’s bewaren in één document maakt voortgang zichtbaar—en herhaalbaar.

Impact meten: leer je daadwerkelijk sneller?

Snelheid is alleen nuttig als het helderdere beslissingen oplevert. AI helpt je meer experimenten te draaien, maar je hebt nog steeds een eenvoudige scorekaart nodig om te kijken of je sneller leert—of alleen meer activiteit genereert.

Kernmetrics om te volgen

Begin met een klein aantal maatstaven die je tussen experimenten kunt vergelijken:

- Time-to-first-test: dagen (of uren) van idee tot iets echt voor gebruikers.

- Kosten per inzicht: totale uitgaven (tools, advertenties, incentives, tijd) gedeeld door het aantal besluitbare inzichten.

- Conversieverbetering: verbetering vs. baseline (bijv. landingspagina-aanmelding van 2,0% → 2,6%).

- Retentiesignalen: vroege indicatoren zoals terugkerende bezoeken, herhaald gebruik of “ik zou teleurgesteld zijn als dit verdween” reacties.

Leading indicators vs. leerkwaliteit

AI maakt het makkelijk om op klikken en aanmeldingen te jagen. De echte vraag is of elk experiment eindigt met een helder resultaat:

- Heb je een aanname bevestigd of verworpen?

- Kun je het resultaat in één zin samenvatten (bijv. “Prijs $19 converteerde 30% beter dan $29 voor freelancers”)?

- Weet je wat je daarna doet—bouwen, aanpassen of stoppen?

Als resultaten vaag zijn, verscherp dan je experimentontwerp: duidelijkere hypothesen, scherpere succescriteria of een beter publiek.

Stopregels: beslis voordat je de test draait

Commit van tevoren wat er gebeurt als de data binnenkomt:

- Kill als de sleutelmetric onder een minimum valt (bijv. <1% aanmelding na 500 gekwalificeerde bezoeken).

- Pivot als er interesse is maar messaging, doelgroep of use case anders blijkt te zijn.

- Double down als je de drempel haalt en kunt verklaren waarom het werkte.

Volgende stap

Kies één idee en plan vandaag een eerste kleine test: definieer één aanname, één metric, één doelgroep en één stopregel.

Streef ernaar je time-to-first-test bij het volgende experiment te halveren.