2025年4月22日·1 分

Samsung SDS と、稼働率が『製品』になるエンタープライズITのスケーリング

稼働率、変更管理、信頼が『製品』となるパートナーエコシステムで、Samsung SDS型のエンタープライズプラットフォームがどのようにスケールするかを実務的に解説します。

稼働率、変更管理、信頼が『製品』となるパートナーエコシステムで、Samsung SDS型のエンタープライズプラットフォームがどのようにスケールするかを実務的に解説します。

企業が財務、製造、物流、HR、カスタマーチャネルを動かすために共有プラットフォームに依存すると、稼働率は「あると良い」品質属性ではなく、売られるものになります。Samsung SDS のような大規模なエンタープライズITサービス/プラットフォーム提供者にとって、信頼性は単なる機能ではなく、それ自体がサービスです。

コンシューマアプリでは短時間の障害は煩わしい程度かもしれませんが、エンタープライズのエコシステムでは売上計上の停止、出荷遅延、コンプライアンス報告の破綻、契約上のペナルティを招くことがあります。「信頼性が製品である」とは、新機能よりも次のような成果で成功が評価されることを意味します:

また、エンジニアリングと運用は別々の「フェーズ」ではありません。顧客や内部関係者はシステムが一貫して、計測可能に、負荷下でも動くことを期待しており、これが同じ約束の一部です。

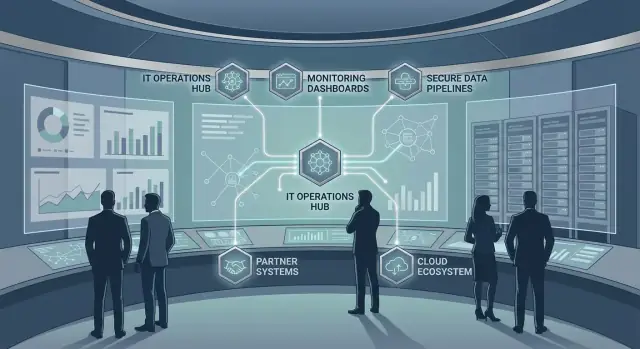

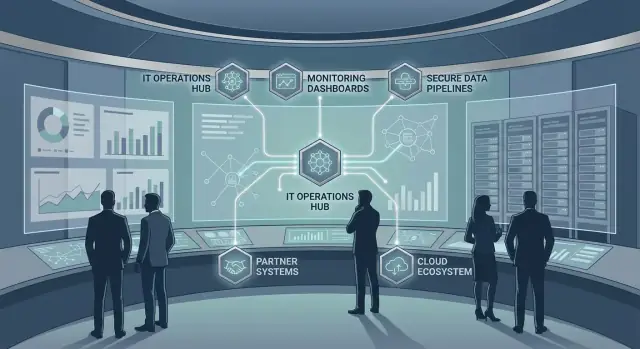

エンタープライズの信頼性は単一アプリの話ではありません。以下のような依存のネットワークです:

この相互接続性は障害のブラスト半径を増やします:あるサービスの劣化が数十の下流システムや外部義務に波及する可能性があります。

本稿は内部や専有の詳細ではなく、例と再現可能なパターンに焦点を当てます。オペレーティングモデル(誰が何を所有するか)、プラットフォームの判断(標準化しつつもデリバリ速度を支える)、および指標(SLO、インシデントパフォーマンス、ビジネスに整合した目標)を通じて企業が信頼性にアプローチする方法を学べます。

最後まで読めば、中央IT組織、共有サービスチーム、あるいは依存する事業群を支えるプラットフォームグループのいずれであっても、自分の環境に当てはめられる地図が描けるはずです。

Samsung SDS は複雑なエンタープライズITを運用・近代化することで広く知られています。単一アプリや製品ラインに焦点を当てるのではなく、企業の“配管”に近い領域――プラットフォーム、統合、運用、そして業務クリティカルなワークフローを信頼できるものにするサービス――に取り組んでいます。

実務では多くの大企業が同時に必要とするいくつかのカテゴリにまたがります:

スケールは単にトラフィック量の話ではありません。グループ企業や大規模なパートナーネットワーク内では、スケールは**広がり(breadth)**に関する問題です:多数の事業部門、異なるコンプライアンス体制、複数の地域、そして依然として重要なレガシーシステムとモダンなクラウドサービスの混在。

その広がりは異なる運用現実を生みます:

最も難しい制約は依存の結合です。コアプラットフォーム(認証、ネットワーク、データパイプライン、ERP、統合ミドルウェア)が共有されていると、小さな問題が波及します。遅い認証サービスは「アプリが落ちている」ように見え、データパイプラインの遅延はレポートや予測、コンプライアンス提出を止めます。

このため、Samsung SDSのような企業プロバイダーは機能で評価されるよりも、どれだけ一貫して数千の下流ワークフローを稼働させ続けられるかで判断されることが多いのです。

エンタープライズプラットフォームは孤立して壊れることはめったにありません。Samsung SDS 型のエコシステムでは、あるサービス内の「小さな」障害がサプライヤー、物流パートナー、内部事業部門、顧客向けチャネルに波及します――なぜなら誰もが同じ共有依存に頼っているからです。

多くのエンタープライズの旅路は以下の馴染み深いチェーンを横断します:

どれか1つが劣化すると、チェックアウト、出荷作成、返品、請求、またはパートナーのオンボーディングといった複数の「ハッピーパス」を同時にブロックすることがあります。

エコシステムはさまざまな「パイプ」を通じて統合され、各々に故障パターンがあります:

重要なリスクは相関故障です:複数のパートナーが同じエンドポイント、同じIDプロバイダ、同じ共有データセットに依存していると、1つの障害が多数のインシデントになります。

エコシステムは単一企業のシステムでは見られない問題を生みます:

ブラスト半径を減らす第一歩は依存関係とパートナージャーニーを明示的にマップし、障害時に一斉に落ちるのではなく段階的に劣化する設計を行うことです(参照:/blog/reliability-targets-slos-error-budgets)。

標準化が役立つのは、それがチームを速くする場合だけです。大規模エンタープライズエコシステムでは、プラットフォーム基盤が成功するのは反復的な決定(と反復的な失敗)を排除しつつ、プロダクトチームに出荷の余地を残すときです。

プラットフォームを明確なレイヤーとそれぞれの契約で考えると実用的です:

この分離は、エンタープライズグレードの要件(セキュリティ、可用性、監査可能性)をプラットフォーム側に組み込み、各アプリがそれを再実装する必要をなくします。

ゴールデンパスは承認済みのテンプレートやワークフローで、セキュアで信頼できる選択肢を最も簡単にします:標準サービススケルトン、事前設定パイプライン、デフォルトダッシュボード、既知の良好なスタック。チームは必要に応じて逸脱できますが、意図的に行い、追加の複雑性に対する明確な所有権を持ちます。

増えつつあるパターンは、これらのゴールデンパスを製品化されたスターターキットとして扱うことです――スキャフォールディング、環境作成、"day-2" のデフォルト(ヘルスチェック、ダッシュボード、アラートルール)を含みます。Koder.ai のようなプラットフォームでは、チャット駆動のワークフローで動作するアプリを生成し、planning mode、snapshots、rollback で変更を可逆に保ちながら迅速に進めることができます。重要なのはツールブランドではなく、信頼できる経路を最小摩擦にすることです。

マルチテナントプラットフォームはコストを下げオンボーディングを早めますが、強力なガードレール(クォータ、ノイジーネイバー対策、明確なデータ境界)が必要です。専用環境はコストが高い一方で、コンプライアンスや性能の分離、顧客別の変更ウィンドウが簡素になります。

良いプラットフォーム選択は日々の意思決定の表面積を縮めます:"どのログライブラリ?","どうやってシークレットをローテーション?","展開パターンは?" といった会話が減り、チームはビジネスロジックに集中できます。プラットフォームが一貫性を暗黙に強制することが、標準化が速度を上げる理由です。

エンタープライズITのプロバイダーは「信頼性」をオプションとして扱いません—信頼性は顧客が買うものの一部です。これを実現する実務的な方法は、期待を誰もが理解できる計測可能な目標に翻訳することです。

**SLI(Service Level Indicator/サービスレベル指標)**は計測値です(例:「チェックアウトトランザクションの成功率」)。**SLO(Service Level Objective/サービスレベル目標)**はその計測値の目標です(例:「30日間でチェックアウトが99.9%成功する」)。

なぜ重要か:契約と業務運用は明確な定義に依存します。定義がないとインシデント後に「良い状態」が何だったのかで議論になります。定義があれば、サービス提供、サポート、パートナー依存を同じスコアボードで整合できます。

すべてのサービスを単純な稼働率だけで評価すべきではありません。エンタープライズで有用な目標例:

データプラットフォームでは「99.9%の稼働」であっても、主要データセットが遅れたり不完全だったり誤っていれば月次は失敗と見なされます。適切な指標を選べば誤った安心感を防げます。

エラーバジェットはSLOによって許される「悪さ」の量です(ダウンタイム、失敗リクエスト、遅延パイプライン)。それを意思決定ツールにします:

これにより、企業プロバイダーは稼働率期待とデリバリコミットメントをバランスできます—意見や階層に頼らずに。

効果的なレポートは対象に合わせて調整します:

目的はダッシュボードを増やすことではなく、信頼性成果がビジネスを支えているかどうかを契約的に一致した可視性で示すことです。

稼働率が顧客の購入要素である場合、可観測性は後回しにできません。特にパートナーや共有プラットフォームがあるエコシステムでは、良好なインシデント対応は運用者が体験するのと同じ方法でシステムを見られることから始まります:エンドツーエンド。

高パフォーマンスチームはログ、メトリクス、トレース、シンセティックチェックを一貫したシステムとして扱います:

目標は迅速に次の問いに答えることです:「これはユーザーに影響しているか?」「ブラスト半径はどれくらいか?」「最近何が変わったか?」

エンタープライズ環境は無限の信号を生成します。使えるアラートと使えないアラートの差は、アラートが顧客向け症状と明確な閾値に結びついているかどうかです。内部カウンタよりもSLOスタイルの指標(エラーレート、p95レイテンシ)でアラートすることを優先してください。各ページには影響を受けるサービス、推定影響、主要依存、最初の診断ステップを含めるべきです。

エコシステムは継ぎ目で壊れます。内部プラットフォーム、ベンダー、IDプロバイダ、ネットワークなどの依存関係を示すサービスマップを維持し、ダッシュボードやインシデントチャネルで可視化してください。パートナーのテレメトリが限られていても、シンセティックチェック、エッジメトリクス、共有リクエストIDを使って依存をモデル化できます。

ロールバック、フィーチャーフラグ無効化、トラフィックシフトといった繰り返しのアクションは自動化してMTTRを減らします。顧客への連絡、エスカレーションパス、パートナー調整など判断を要する決定は文書化します。良いランブックは短く、実際のインシデントでテストされ、ポストインシデントのフォローアップで更新されるものです。

Samsung SDSのようなエコシステムでは「安全」か「速い」かを選べません。肝は変更管理を予測可能なシステムにすることです:リスクの低い変更は速く流れ、ハイリスクの変更は相応の精査を受けます。

ビッグバンリリースは大規模障害を生みます。稼働率を高く保つには小さなスライスで出荷し、一度に壊れるものの数を減らすべきです。

フィーチャーフラグは「デプロイ」と「リリース」を分離し、コードをプロダクションに置きつつ即座にユーザーに影響させないようにします。カナリア展開はまず一部にリリースしてから全社的に展開することで早期警告を提供します。

リリースガバナンスは単なる書類仕事ではありません。企業が重要サービスを保護し統制を示す方法です。

実用的モデルの例:

「正しい方法」を容易にすることが目的で、承認や証拠は通常のデリバリの一部として取得されるべきです。

エコシステムには月次クローズ、ピーク小売イベント、年次加入更新、大きなパートナー切替など予測可能なストレス時点があります。変更ウィンドウはこれらのサイクルと展開を合わせます。

ブラックアウト期間は明示的に公表し、チームが事前計画しリスクの高い作業を凍結直前に押し込まないようにします。

すべての変更がきれいにロールバックできるわけではありません(特にスキーマ変更や跨社統合)。強い変更管理は事前に決めておくことを要求します:

事前にこれらを定義すれば、インシデントは長期の即興ではなく制御された修正になります。

レジリエンスエンジニアリングは簡単な仮定から始まります:上流のAPI、ネットワークセグメント、データベースノード、あるいはあなたが制御しないサードパーティ依存のいずれかが壊れるだろう、ということです。エコシステムで動くプロバイダーの目標は「故障しないこと」ではなく、制御された故障と予測可能な復旧です。

スケールで常に有効なパターン:

重要なのは「必ず生き延びるべき」ユーザージャーニーを定義し、それらのために明確なフォールバックを設計することです。

災害復旧計画は各システムが明確な目標を持つと実用的になります:

すべてに同じ数値は不要です。認証サービスは数分のRTOとほぼゼロのRPOが必要かもしれませんが、内部分析パイプラインは数時間を許容できます。ビジネス影響に応じてRTO/RPOを合わせることで過剰投資を避けつつ重要点を保護できます。

重要ワークフローでは複製の選択が重要です。同期複製はデータ損失を最小化できますがレイテンシを増やすかネットワーク問題で可用性を下げる可能性があります。非同期複製は性能と稼働率を改善しますが最新の書き込みを失うリスクがあります。良い設計はこれらのトレードオフを明示し、冪等性、照合ジョブ、明確な「保留」状態といった補償制御を追加します。

レジリエンスは実行されて初めて価値があります:

定期的に実施し、復旧時間を追跡して結果をプラットフォーム基準とサービス所有にフィードバックしてください。

セキュリティ障害やコンプライアンスの欠如は単にリスクを生むだけでなくダウンタイムを引き起こします。エンタープライズのエコシステムでは、1つの誤設定アカウント、未パッチサーバ、欠けた監査証跡がサービス凍結、緊急変更、顧客影響を伴う停止を招くことがあります。セキュリティとコンプライアンスを信頼性の一部として扱うことで「稼働し続ける」ことを共有目標にできます。

複数の子会社、パートナー、ベンダーが同じサービスに接続するとIDが信頼性のコントロールになります。SSOとフェデレーションはパスワードスプロールを減らし、ユーザーがリスクの高い回避策を取らずにアクセスできるようにします。さらに重要なのは最小権限原則:アクセスは期限付き、ロールベース、定期レビューされ、侵害されたアカウントがコアシステムを破壊できないようにすることです。

セキュリティ運用はインシデントを防ぐか、あるいは予期せぬ中断を生むことがあります。パッチや脆弱性対応を運用の信頼性に結びつけて予測可能にします:

保持、プライバシー、監査トレイルといったコンプライアンス要件はプラットフォーム設計に組み込むと満たしやすくなります。フィールドが一貫した中央ログ、強制された保持ポリシー、アクセス制御されたエクスポートにより、監査が火消し作業にならず、システムを凍結して対応する事態を避けられます。

パートナー統合は機能とブラスト半径を広げます。第三者リスクを減らすには契約で定めたセキュリティ基準、バージョン管理されたAPI、明確なデータ処理ルール、および依存ヘルスの継続的監視を用います。パートナーが故障しても、あなたのシステムが予測不能に止まるのではなく段階的に劣化するように設計します。

エンタープライズが「稼働率」と言うとき、多くはアプリやネットワークを指しますが、請求、フルフィルメント、リスク、レポーティングの多くのワークフローにとってデータの正確性こそ運用上同等に重要です。不正確なバッチが誤った顧客IDを公開すると、パートナー全体に数時間のインシデントを引き起こします。

顧客、製品、ベンダーなどのマスターデータはすべての参照点です。これを信頼性の対象として扱うには「良い状態」を(完全性、一意性、鮮度)定義し、継続的に計測します。

実用的なアプローチは業務に直結する小さな品質指標を追うことです(例:「有効な顧客にマップされた注文の割合」)――それがズレ始めたら下流が壊れる前にアラートします。

バッチは予測可能な報告窓に向きます。ストリーミングは準リアルタイム操作向けです。どちらも大規模ではガードレールが必要:

信頼はチームが3つの質問に素早く答えられると高まります:このフィールドはどこから来たか?誰が使っているか?誰が変更を承認するか?

ラインエージとカタログ化は単なるドキュメント作業ではなく運用ツールです。重要データセットについては名前付きのオーナー、定義されたアクセスポリシー、高影響変更のための軽量レビューを組み合わせます。

エコシステムは境界で失敗します。パートナー関連のインシデントを減らすにはデータ契約を使います:バージョン管理されたスキーマ、検証ルール、互換性期待値。取り込み時にバリデーションし、不良レコードは検疫し、エラーは発生元に明確にフィードバックしてもらうことで下流でのパッチを減らします。

エンタープライズスケールの信頼性は最も多くの場合「ギャップ」で失敗します:チーム間、ベンダー間、そして "運用" と "構築" の間。ガバナンスはそれ自体が官僚主義ではなく、インシデントが誰が対処すべきかの数時間に及ぶ議論にならないよう所有権を明確にする方法です。

一般的なモデルは二つあります:

多くの企業はハイブリッドを採る:プラットフォームチームが舗装された道を提供し、プロダクトチームが自分たちが出すものの信頼性を所有する。

信頼できる組織はサービスカタログを公開し、次に答えます:このサービスのオーナーは誰か?サポート時間は?重要な依存関係は?エスカレーションパスは?

同様に重要なのは所有範囲の境界です:どのチームがデータベース、統合ミドルウェア、ID、ネットワークルール、監視を所有するか。境界が不明瞭だとインシデントは技術的問題ではなく調整問題になります。

エコシステム重視の環境では信頼性は契約に依存します。顧客向けコミットメントにはSLA、内部ハンドオフにはOLA、そしてバージョン管理、レート制限、変更ウィンドウ、ロールバック期待を定めた統合契約を使い、パートナーが意図せずあなたを壊せないようにします。

ガバナンスは学習を強制すべきです:

これがうまく回れば、信頼性は「みんなの仕事」ではなく測定可能で所有されたシステムになります。

Samsung SDS そのものになる必要はありませんが、同じ運用原則から利益を得られます。目標は信頼性を管理可能な能力にすること:可視化され、計測され、小さく反復可能なステップで改善されること。

完璧でなくても来週に使えるサービスインベントリから始めてください。

これが優先付け、インシデント対応、変更管理のバックボーンになります。

可用性、レイテンシ、鮮度、正確性など、影響の大きいSLOを2~4個選んでください。例:

エラーバジェットを追跡し、機能作業の一時停止、変更量の削減、修正投資の意思決定に使ってください。

ツールの氾濫は基本的なギャップを隠しがちです。まず「十分な可視性」が何かを標準化してください:

「何が壊れて、どこで、誰が所有するか」を数分で答えられないなら、ベンダーを増やす前に明確化を進めてください。

エコシステムは継ぎ目で壊れます。変動を減らすパートナー向けガイドラインを公開しましょう:

統合標準を製品として扱い、文書化し、レビューし、更新してください。

3~5サービスで30日間のパイロットを実施し、その後拡張してください。テンプレートや例は /blog を参照してください。

チームがサービスを構築し運用する方法を近代化する場合、ランタイムと可観測性だけでなく作成ワークフロー自体を標準化すると役立ちます。Koder.ai のようなチャット駆動の“vibe-coding”プラットフォームは、エンタープライズのコントロールを保ちつつデリバリを加速できます――例:変更を生成する前の planning mode、実験時の snapshots/rollback など。マネージドサポートやプラットフォーム支援を評価するなら、まず /pricing のように制約と成果から始めてください(保証ではなく選択肢を整理するための指針です)。

それは、利害関係者が「信頼性そのもの」を主要な価値として受け取る、という意味です。ビジネスプロセスが時間通りに完了し、統合が健全に保たれ、ピーク時に性能が予測可能で、障害時の復旧が速い――こうしたことが提供物(プロダクト)となります。エンタープライズのエコシステムでは短時間の劣化でも請求、出荷、給与、コンプライアンス報告が止まるため、信頼性が裏方の属性ではなく主要な「納品物」になります。

エンタープライズのワークフローは共有プラットフォーム(認証、ERP、データパイプライン、統合ミドルウェア)に密接に結びついているためです。小さな障害が発注の停止、月次決算の遅延、パートナーのオンボーディング障害、契約上のペナルティなどへ連鎖します。いわゆる“ブラスト半径”は故障したコンポーネントを大きく上回ることが多いのです。

よく問題を起こす共有依存部品には、例えば次があります:

これらが劣化すると、多くの下流アプリが同時に「ダウンしている」ように見えることがあります。

「十分に使える」インベントリと依存マップで始めれば大きなドキュメントプロジェクトを回避できます。

これがSLOの優先付け、アラート、変更管理の基盤になります。

結果に結びつく指標を少数選びます。単なる稼働率ではなく成果に直結するものを:

まず2~4件、ビジネスが認知するSLOを設定し、計測が信頼できるようになったら拡張します。

エラーバジェットはSLOが許す“許容される不具合量”(失敗リクエスト、ダウンタイム、遅延データ量)です。運用上の方針として使います:

こうすることで、信頼性と変更スピードのトレードオフを恣意的な判断ではなく明確なルールで扱えます。

実用的なレイヤード構成の一例は:

こうした層によって、エンタープライズ向け要求(セキュリティ、可用性、監査性)を各アプリが再実装する必要がなくなります。

ゴールデンパスは「舗装された道(paved roads)」――セキュアで信頼できる選択肢を最も簡単にするテンプレートやワークフローです:標準のサービススケルトン、事前設定済みパイプライン、デフォルトのダッシュボード、既知で良好なスタック。効果は:

インシデントから学び改良していく「製品」として扱うと効果的です。

パートナー重視の環境ではエンドツーエンドの可視化と調整が重要です:

パートナーのテレメトリが限定的な場合は、シーム上のシンセティックチェックを追加し、共有リクエストIDで相関させると良いでしょう。