Perché le previsioni di Kurzweil sull'AGI contano

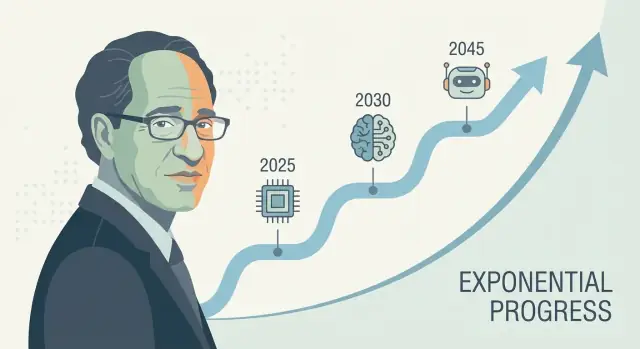

Ray Kurzweil è una delle voci più riconosciute nelle previsioni tecnologiche a lungo termine—soprattutto riguardo all'intelligenza artificiale e alla singolarità tecnologica. Quando formula una previsione concreta sull'AGI (spesso presentata come una data, non come un vago “un giorno”), tende a riverberare: investitori la citano, giornalisti la dibattono e i ricercatori vengono chiamati a rispondere.

Perché le sue previsioni attirano attenzione

L'influenza di Kurzweil non è solo questione di ottimismo. Sta nel fornire una narrativa ripetibile su perché il progresso dovrebbe accelerare—spesso legata alla crescita esponenziale del calcolo e all'idea che ogni generazione di strumenti aiuti a costruire la successiva. Che si sia d'accordo o no, offre un modo strutturato per discutere una timeline dell'intelligenza artificiale generale anziché trattarla come puro racconto fantascientifico.

Cosa significa davvero “prevedere decenni avanti”

Una previsione a decenni non è tanto indovinare un giorno sul calendario quanto proiettare un fascio di tendenze: compute, costo, dati, algoritmi e la capacità pratica di costruire sistemi che generalizzino. La scommessa è che queste curve continuino a muoversi—e che i “pezzi mancanti” di oggi siano problemi di ingegneria risolvibili che si riducono man mano che gli input migliorano.

Cosa imparerai in questo articolo

Questo pezzo scompone:

- Il metodo dietro le previsioni tecnologiche di Kurzweil (cosa misura ed extrapola)

- Le evidenze che sostengono l'idea che gli indicatori di progresso dell'AI stiano accelerando—e dove i dati sono scarsi

- Le critiche più forti alle previsioni che si basano su semplici estrapolazioni di crescita esponenziale

- Spunti pratici per usare le previsioni come strumenti di pianificazione senza considerarle certezze

Una nota rapida sull'incertezza

Anche tra esperti seri, le timeline per l'AGI variano molto perché dipendono dalle assunzioni: cosa si intende per “AGI”, quali colli di bottiglia contano di più e quanto rapidamente le scoperte si traducono in prodotti affidabili. Le timeline di Kurzweil sono influenti non perché siano garantite, ma perché sono abbastanza specifiche da poter essere testate—e abbastanza scomode da non poter essere ignorate.

Chi è Ray Kurzweil?

Ray Kurzweil è un inventore, autore e futurologo americano noto per le sue previsioni tecnologiche a lungo termine—e per supportarle con grafici, dati storici e scadenze audaci.

Inventore, imprenditore e “osservatore di pattern”

Kurzweil è diventato noto grazie a invenzioni pratiche, specialmente nelle tecnologie del parlato e del testo. Ha fondato aziende focalizzate su OCR (riconoscimento ottico dei caratteri), text-to-speech e strumenti musicali, e ha passato decenni vicino ai vincoli reali dei prodotti: qualità dei dati, costi hardware e cosa gli utenti adotteranno davvero. Quel mindset da costruttore plasma le sue previsioni—tende a considerare il progresso come qualcosa da ingegnerizzare e scalare.

Ha inoltre lavorato in grandi organizzazioni tech (inclusa Google), rafforzando la sua visione che i grandi salti spesso derivano da investimenti sostenuti, tooling migliore e miglioramenti composti—non solo da breakthrough isolati.

Libri chiave e idee che influenzano il dibattito sull'AGI

La timeline di Kurzweil viene spesso discussa attraverso i suoi libri più noti, in particolare The Age of Spiritual Machines (1999) e The Singularity Is Near (2005). Queste opere sostengono che le tecnologie dell'informazione migliorano in modi accelerati e composti—e che questa accelerazione produrrà macchine con capacità a livello umano (e poi oltre).

Che si sia d'accordo o no, la sua scrittura ha contribuito a definire i termini della conversazione pubblica: il progresso dell'AI come misurabile, guidato da tendenze e (in linea di principio) prevedibile.

Definizioni rapide (per parlare la stessa lingua)

AGI (Artificial General Intelligence): un sistema AI che può apprendere ed eseguire un'ampia gamma di compiti a livello approssimativamente umano, adattandosi a nuovi problemi senza essere specializzato in modo ristretto.

Singolarità: il termine di Kurzweil per un periodo in cui il progresso tecnologico diventa così rapido (e l'AI così capace) da cambiare la società in modi imprevedibili e difficili da modellare.

Timeline: una previsione con date e milestone (per esempio, “AGI a livello umano entro l'anno X”), non solo un'affermazione generale che il progresso continuerà.

Le affermazioni centrali di Kurzweil sulle timeline dell'AGI

Kurzweil ha ripetutamente sostenuto che l'AGI a livello umano è probabile nella prima metà del XXI secolo—più famosamente raggruppando le sue previsioni verso la fine degli anni 2020 e gli anni 2030 in interventi pubblici e libri. Non è sempre rigido su un anno preciso, ma la tesi centrale è coerente: una volta che potenza di calcolo, dati e algoritmi superano certe soglie, i sistemi eguaglieranno l'ampiezza e l'adattabilità della cognizione umana.

Come l'AGI si collega alla “singolarità”

Nella sua cornice, l'AGI non è il traguardo finale—è un innesco. Dopo che le macchine raggiungono (e poi superano) l'intelligenza generale a livello umano, il progresso si compone: sistemi più intelligenti aiutano a progettare sistemi ancora più intelligenti, accelerando scoperta scientifica, automazione e integrazione uomo–macchina. Questa dinamica composita è ciò che collega alla più ampia idea di “singolarità tecnologica”: un periodo in cui il cambiamento diventa così rapido che l'intuizione quotidiana smette di essere una guida affidabile.

AGI vs. i sistemi AI di oggi

Una sfumatura chiave nelle sue affermazioni sulle timeline è la definizione di AGI. I modelli attuali possono essere impressionanti su molti compiti, ma tendono ancora a essere:

- fragili al di fuori dei pattern di training,

- deboli nella pianificazione a lungo termine e nell'ancoraggio al mondo reale,

- dipendenti da obiettivi e valutazioni curati dall'uomo.

Per Kurzweil, “AGI” implica un sistema che può trasferire apprendimento tra domini, formare e perseguire obiettivi in situazioni nuove e gestire in modo affidabile la varietà aperta del mondo reale—non solo eccellere nei benchmark.

Perché i traguardi sono meglio di una singola data

Una previsione sul calendario è facile da discutere e difficile da usare. I traguardi sono più pratici: apprendimento autonomo sostenuto, uso affidabile di strumenti e pianificazione, forte performance in ambienti reali e disordinati e chiara sostituzione economica in molti tipi di lavoro. Anche se non concordi sul timing esatto, questi checkpoint rendono la previsione verificabile—e più utile che scommettere su un singolo anno di copertina.

Storico: successi, fallimenti e ciò che è discutibile

Kurzweil è spesso descritto come un “predittore seriale”, e quella reputazione contribuisce all'attenzione sulle sue timeline AGI. Ma il suo record è misto in un modo che aiuta a capire il forecasting: alcune previsioni sono state specifiche e misurabili, altre direzionalmente corrette ma vaghe, e alcune hanno sottovalutato vincoli importanti.

Previsioni note spesso associate a Kurzweil

Nei libri e nei discorsi è associato a previsioni come:

- il continuo miglioramento del rapporto costo/performance dei computer (una continuazione delle tendenze stile legge di Moore)

- il riconoscimento vocale diventare ampiamente utilizzabile per i consumatori

- il computing mobile sempre connesso diventare la norma

- l'AI superare gli umani in compiti ristretti (ad es. giochi, riconoscimento di pattern)

- crescente integrazione uomo–macchina (wearable, impianti, tecnologie assistive)

Previsioni chiare e verificabili vs. vaghe

Previsioni chiare e verificabili sono legate a una data e a un risultato misurabile: “entro l'anno X, la tecnologia Y raggiungerà la performance Z”, o “la maggior parte dei dispositivi avrà la caratteristica F.” Queste possono essere testate con benchmark pubblici (tassi di accuratezza, dati di vendita/adozione, costi del compute).

Previsioni vaghe suonano plausibili ma sono difficili da falsificare, come “i computer saranno ovunque”, “l'AI trasformerà la società” o “gli esseri umani si fonderanno con la tecnologia.” Queste possono sembrare vere anche se i dettagli, i tempi o i meccanismi differiscono.

Come giudicare “giusto”, “parzialmente giusto” e “sbagliato” (senza fare il tabellino)

Un modo pratico per valutare un previsore è separare direzione, tempistica e specificità.

- Giusto: l'esito corrisponde all'affermazione e la tempistica è sufficientemente vicina da aver guidato le aspettative.

- Parzialmente giusto: la direzione è corretta, ma i tempi slittano, l'adozione è più lenta o il risultato arriva in una forma diversa (es. “funziona in demo” vs. “funziona per la maggior parte delle persone, la maggior parte del tempo”).

- Sbagliato: sono stati sottovalutati vincoli chiave—limiti di dati, regolamentazione, comportamento degli utenti, costi o il divario tra performance di laboratorio e affidabilità nel mondo reale.

Il punto non è bollare le previsioni come “buone” o “cattive”, ma notare come affermazioni fiduciose e basate sui dati possano comunque dipendere da assunzioni nascoste—soprattutto quando coinvolgono l'adozione sociale e non solo miglioramenti hardware o algoritmici.

La “Legge dei Rendimenti Accelerati” in parole semplici

La “Legge dei Rendimenti Accelerati” di Kurzweil è l'idea che quando una tecnologia migliora, quei miglioramenti spesso rendono più facile migliorarla ulteriormente. Ciò crea un ciclo di feedback che accelera il progresso nel tempo.

Tendenze esponenziali, spiegate senza matematica

Una tendenza lineare è come aggiungere la stessa quantità ogni anno: 1, 2, 3, 4.

Una tendenza esponenziale è come moltiplicare: 1, 2, 4, 8. All'inizio sembra lenta—poi improvvisamente sembra che tutto accada in fretta. Kurzweil sostiene che molte tecnologie (soprattutto quelle dell'informazione) seguono questo schema perché ogni generazione di strumenti aiuta a costruire la successiva.

Kurzweil non si chiede solo “possiamo fare X?” Ma “a che costo possiamo fare X?”. Un modello comune nel computing è: la performance sale mentre il costo scende. Quando il costo per eseguire un modello utile diminuisce, più persone possono sperimentare, distribuire prodotti e finanziare l'ondata successiva—accelerando il progresso.

Per questo presta attenzione a curve di lungo periodo come “operazioni per dollaro”, non solo alle demo in prima pagina.

Dove si inserisce la legge di Moore—e dove non basta

La legge di Moore è l'esempio classico: per decenni il numero di transistor sui chip è raddoppiato a intervalli regolari, spingendo i computer a diventare più veloci ed economici.

L'argomento di Kurzweil non è che “la legge di Moore continuerà per sempre.” È più ampio: anche se un approccio hardware rallenta, altri metodi (chip migliori, GPU/TPU, parallelismo, nuove architetture, efficienza software) possono mantenere la tendenza complessiva di miglioramento costo/performance.

Perché il pensiero in linea retta fuorvia

La gente spesso predice il futuro estendendo il ritmo recente di cambiamento. Ciò ignora il compounding. Fa sembrare il progresso inizialmente modesto—e il progresso successivo “improvviso”, quando in realtà potrebbe essersi costruito in modo prevedibile su una curva per anni.

Quali dati supportano (e limitano) queste previsioni

Build and earn credits

Ottieni crediti condividendo ciò che costruisci o invitando altri a provare Koder.ai.

Previsioni come quelle di Kurzweil partono solitamente da tendenze misurabili—cose che puoi mettere su un grafico. Questo è un punto di forza: puoi discutere gli input invece di argomentare solo con l'intuizione. È anche il punto in cui emergono i limiti maggiori.

Le curve “facili da misurare”: compute, storage, banda, costo

Chi fa previsioni tecnologiche spesso traccia:

- Compute (quante operazioni puoi comprare per dollaro)

- Storage (quanta memoria puoi conservare per dollaro)

- Banda (quanto velocemente puoi muovere dati e a quale prezzo)

- Declino dei costi (per chip, istanze cloud, training run ed energia per unità di lavoro)

Queste curve sono convincenti perché durano a lungo e vengono aggiornate frequentemente. Se la tua visione dell'AGI è “hardware sufficiente più software giusto”, questi dataset possono sembrare una base solida.

Il progresso hardware non è la stessa cosa del progresso delle capacità

Il principale divario: più hardware non produce automaticamente sistemi più intelligenti. La capacità di un'AI dipende da algoritmi, qualità dei dati, ricette di training, tooling e feedback umano—non solo dai FLOP.

Un modo utile per pensarci: l'hardware è un budget, la capacità è il risultato. La relazione tra i due esiste, ma non è fissa. A volte una piccola modifica algoritmica sblocca grandi guadagni; altre volte la scala incontra rendimenti decrescenti.

Perché i benchmark e l'uso reale contano

Per connettere “input” (compute, soldi) a “output” (cosa i modelli sanno effettivamente fare), i previsori hanno bisogno di:

- Benchmark che misurino ragionamento, pianificazione e generalizzazione—non solo il matching di pattern

- Performance nel mondo reale in ambienti disordinati: affidabilità, sicurezza, compiti a orizzonte lungo e adattabilità

I benchmark possono essere aggirati, perciò i segnali più convincenti combinano punteggi di test con prove di utilità durevole.

Errori comuni: grafici ordinati, colli di bottiglia nascosti

Due errori frequenti sono selezionare curve (scegliere finestre temporali che appaiono più esponenziali) e ignorare i colli di bottiglia come limiti energetici, scarsità di dati, latenza, regolamentazione o la difficoltà di trasformare competenze ristrette in competenze generali. Questi non cancellano le previsioni—ma allargano le barre d'errore.

Assunzioni chiave dietro le previsioni a decenni

Le timeline AGI a lungo termine—inclusive di quelle di Kurzweil—dipendono meno da un singolo “momento di svolta” e più da uno stack di assunzioni che devono tenere tutte insieme. Se un livello si indebolisce, la data può slittare anche se il progresso continua.

1) Compute, algoritmi e dati continuano a comporre

La maggior parte delle previsioni a decenni presume che tre curve crescano insieme:

- Scala del compute continua a diventare più economica e facile da distribuire (più chip, cluster più grandi, migliore utilizzo).

- Progresso algoritmico continua a fornire guadagni di efficienza significativi—ogni unità di compute genera più capacità.

- Disponibilità di dati resta sufficiente, sia tramite nuove fonti (dati multimodali), dati sintetici, migliori strumenti di labeling o miglior auto-supervisione.

Un'assunzione nascosta: questi tre driver non si sostituiscono perfettamente. Se la qualità dei dati plateau, “metti più compute” può dare ritorni minori.

2) I vincoli fisici e industriali non mordono troppo forte

Le previsioni spesso trattano il compute come una curva liscia, ma la realtà passa per fabbriche e reti energetiche.

Costi energetici, capacità di produzione dei chip, controlli sulle esportazioni, bandwidth di memoria e shock alla supply chain possono limitare la velocità di training e deployment. Anche se la teoria dice “10× più compute”, il percorso può essere irregolare e costoso.

3) I sistemi umani permettono una rapida distribuzione

Le previsioni a decenni assumono anche che la società non rallenti troppo l'adozione:

Regolazione, responsabilità, fiducia pubblica, integrazione in azienda e ROI influenzano se i sistemi avanzati vengono allenati e usati ampiamente—o tenuti in contesti ristretti e ad alta frizione.

4) I guadagni di capacità si traducono in generalità

Forse l'assunzione più grande è che i miglioramenti di capacità derivanti dalla scala (miglior ragionamento, pianificazione, uso di strumenti) convergano naturalmente verso l'intelligenza generale.

“Più compute” può produrre modelli più fluenti e utili, ma non automaticamente più generali nel senso di trasferimento affidabile tra domini, autonomia a lungo termine o obiettivi stabili. Le timeline lunghe spesso presumono che questi gap siano problemi di ingegneria, non barriere fondamentali.

Cosa potrebbe ritardare l'AGI (anche se le tendenze continuano a salire)

Go from idea to mobile

Avvia un'app mobile Flutter dalla chat e mantieni le funzionalità allineate al feedback degli utenti.

Anche se potenza di calcolo e dimensioni dei modelli continuano a crescere, l'AGI potrebbe arrivare più tardi delle previsioni per ragioni che hanno poco a che fare con la sola velocità. Alcuni colli di bottiglia riguardano cosa stiamo costruendo e come sappiamo che funziona.

1) La definizione del problema può rimanere sfocata

“AGI” non è una singola funzione che si attiva. Una definizione utile implica tipicamente un agente che sa apprendere nuovi compiti rapidamente, trasferire abilità tra domini, pianificare su orizzonti lunghi e gestire obiettivi mutevoli con alta affidabilità.

Se l'obiettivo continua a spostarsi—assistente loquace vs. lavoratore autonomo vs. ragionatore a livello di scienziato—il progresso può sembrare impressionante pur mancando abilità chiave come memoria a lungo termine, ragionamento causale o decision making coerente.

2) Misurare l'AGI è più difficile che misurare i GPU

I benchmark possono essere forzati, overfittati o diventare obsoleti. Gli scettici vogliono prove che un'AI riesca in compiti non visti, sotto vincoli nuovi, con bassi tassi di errore e risultati ripetibili.

Se la comunità non si mette d'accordo su test che separino convincentemente “ottima completazione di pattern” da “competenza generale”, le timeline diventano congetture—e la cautela può rallentare la distribuzione.

3) Allineamento e sicurezza possono diventare l'elemento che detta i tempi

La capacità può aumentare più rapidamente del controllo. Se i sistemi diventano più agentici, il livello di attenzione per prevenire inganni, deriva di obiettivi ed effetti collaterali dannosi aumenta.

Regolazione, audit e ingegneria della sicurezza possono aggiungere tempo anche se i modelli migliorano in fretta—soprattutto per usi ad alto rischio.

4) Embodiment e interazione nel mondo reale restano questioni aperte

Molte definizioni di AGI implicano competenza nel mondo fisico: manipolare oggetti, condurre esperimenti, usare strumenti e adattarsi al feedback in tempo reale.

Se l'apprendimento nel mondo reale risulta molto affamato di dati, lento o rischioso, l'AGI potrebbe ristagnare su prestazioni “brillanti sullo schermo” mentre la generalità pratica aspetta migliori robotica, simulazione e metodi di training sicuri.

Critiche principali all'approccio di Kurzweil

Le previsioni di Kurzweil sono influenti in parte perché sono chiare e quantitative—ma quella stessa chiarezza attira forti critiche.

1) Estrarre trend passati può nascondere “cambi di regime”

Un'obiezione comune è che Kurzweil si appoggi molto sull'estensione di curve storiche (compute, storage, banda) nel futuro. I critici sostengono che la tecnologia non sempre scala in modo liscio: il progresso nei chip può rallentare, i costi energetici possono farsi sentire e gli incentivi economici possono cambiare. Anche se la direzione a lungo termine è positiva, il ritmo può cambiare in modi che rendono le date specifiche inaffidabili.

2) I sistemi complessi non forniscono scoperte secondo programma

L'AGI non è solo un problema di hardware più veloce. È un problema di sistemi complessi che coinvolge algoritmi, dati, metodi di training, valutazione, vincoli di sicurezza e adozione umana. I breakthrough possono essere vincolati da un'idea mancante—qualcosa che non puoi mettere a calendario con affidabilità. Gli scettici sottolineano che la scienza spesso avanza attraverso tappe irregolari: plateaux lunghi seguiti da salti improvvisi.

3) Gli effetti di selezione fanno sembrare migliori le predizioni audaci

Un'altra critica è psicologica: ricordiamo di più gli avvenimenti drammatici indovinati rispetto ai mancati o alle predizioni più timide. Se qualcuno fa molte previsioni forti, pochi successi memorabili possono dominare la percezione pubblica. Questo non significa che il previsore sia “sbagliato”, ma può gonfiare la fiducia nella precisione delle timeline.

4) Perché persone intelligenti divergono sulle timeline

Anche esperti che accettano un rapido progresso dell'AI divergono su cosa “conti” come AGI, quali capacità debbano generalizzare e come misurarle. Piccole differenze definitorie (ampiezza dei compiti, autonomia, affidabilità, apprendimento nel mondo reale) possono spostare le previsioni di decenni—senza che nessuno cambi sostanzialmente la propria valutazione del progresso corrente.

Come altri esperti prevedono le timeline AGI

Kurzweil è una voce forte, ma le timeline AGI sono un dibattito affollato. Un modo utile di mappare il panorama è il campo a breve termine (AGI in anni o poche decadi) versus il campo a lungo termine (decenni o “non in questo secolo”). Spesso guardano alle stesse tendenze ma non concordano su cosa manca: i preveditori a breve termine enfatizzano la scala rapida e le capacità emergenti, mentre quelli a lungo termine sottolineano problemi irrisolti come ragionamento affidabile, autonomia e robustezza nel mondo reale.

Approcci comuni di previsione (oltre l'estrapolazione delle tendenze)

Sondaggi tra esperti aggregano credenze di ricercatori e praticanti (per esempio, poll che chiedono quando c'è il 50% di probabilità di “AI a livello umano”). Possono mostrare come le opinioni cambino nel tempo, ma riflettono anche chi viene intervistato e come sono formulate le domande.

Scenario planning evita una data singola. Invece, disegna futuri plausibili multipli (progresso veloce, progresso lento, colli di bottiglia regolatori, limiti hardware) e chiede quali segnali indicherebbero ciascuna via.

Previsioni basate su benchmark e capacità tracciano traguardi concreti (compiti di coding, ragionamento scientifico, affidabilità degli agenti) e stimano quale ritmo di miglioramento servirebbe per raggiungere una competenza più ampia.

Le definizioni cambiano la data

“AGI” può significare superare una vasta suite di test, svolgere la maggior parte dei lavori, operare come agente autonomo o eguagliare gli umani attraverso domini con supervisione minima. Una definizione più rigorosa tende a spostare le timeline più in là, e la divergenza su questo spiega gran parte della dispersione delle opinioni.

La cosa che più si avvicina al consenso: l'incertezza

Anche ottimisti e scettici tendono a concordare su un punto: le timeline sono altamente incerte, e le previsioni dovrebbero essere trattate come intervalli con assunzioni—non come impegni di calendario.

Segnali da monitorare nei prossimi 5–10 anni

Ship a React UI fast

Crea rapidamente un front-end React e perfezionalo con semplici prompt.

Le previsioni sull'AGI possono sembrare astratte, quindi è utile seguire segnali concreti che dovrebbero muoversi prima di qualsiasi “grande momento”. Se le timeline in stile Kurzweil sono direzionalmente corrette, il prossimo decennio dovrebbe mostrare guadagni costanti in capacità, affidabilità, economia e governance.

1) Indicatori di capacità (cosa i sistemi riescono realmente a fare)

Osserva modelli che pianificano in modo affidabile su molti passi, si adattano quando i piani falliscono e usano strumenti (codice, browser, app di dati) senza bisogno di intervento continuo. Il segnale più significativo non è una demo appariscente—ma autonomia con confini chiari: agenti che completano compiti di più ore, fanno domande chiarificatrici e delegano in sicurezza quando incerti.

2) Indicatori di affidabilità (quanto spesso si sbagliano)

Il progresso si vedrà in tassi di errore più bassi in flussi di lavoro realistici, non solo in punteggi migliori sui benchmark. Monitora se le “allucinazioni” diminuiscono quando i sistemi devono citare fonti, eseguire controlli o autoverificarsi. Un traguardo chiave: forte performance in condizioni di audit—stesso compito, esecuzioni multiple, risultati coerenti.

3) Indicatori economici (dove si vede valore)

Cerca guadagni di produttività misurabili in ruoli specifici (supporto, analisi, software, operations), insieme a nuove categorie di lavoro costruite attorno alla supervisione e all'integrazione dell'AI. Contano anche i costi: se l'output di alta qualità diventa più economico (per compito, per ora), l'adozione accelera—specialmente per i team piccoli.

4) Indicatori di governance (come risponde la società)

Se le capacità aumentano, la governance dovrebbe passare dai principi alla pratica: standard, audit di terze parti, report di incidenti e regolamentazione che chiarisca la responsabilità. Osserva anche il monitoraggio e le regole di reporting del compute—segnali che governi e industria considerano la scala un lever tracciabile e controllabile.

Se vuoi usare questi segnali senza reagire eccessivamente ai titoli, vedi /blog/ai-progress-indicators.

Spunti pratici: usare le previsioni senza riporvi troppa fiducia

Le timeline AGI vanno trattate come previsioni del tempo per una data lontana: utili per pianificare, inaffidabili come promessa. Le previsioni in stile Kurzweil possono aiutarti a notare tendenze di lungo periodo e a mettere alla prova decisioni, ma non dovrebbero essere l'unico punto di fallimento nella tua strategia.

Come leggere le previsioni sull'AGI (senza prenderle come garanzie)

Usa le previsioni per esplorare intervalli e scenari, non per fissare un anno. Se qualcuno dice “AGI entro il 203X”, traduci in: “Quali cambiamenti dovrebbero avvenire perché ciò sia vero—e cosa succede se non accadono?” Poi pianifica per più esiti.

Domande da porre a qualsiasi previsione

- Definizione: Cosa intendono per “AGI”? Livello umano nei test, utilità ampia nel lavoro o “può imparare qualsiasi cosa”? Diverse definizioni producono timeline diverse.

- Dati: Quali indicatori usano—compute, efficienza di training, benchmark, tassi di deployment—e cosa ignorano?

- Assunzioni: Presumono che algoritmi, disponibilità di dati, energia, chip e governance continuino senza intoppi?

- Incentivi: Vendono un prodotto, raccolgono fondi o promuovono politiche? Gli incentivi possono inclinare certezza e scadenze.

Pianificazione pratica: competenze, strategia e consapevolezza del rischio

Per gli individui: costruisci competenze durevoli (problem framing, expertise di dominio, comunicazione) e mantieni l'abitudine di imparare nuovi strumenti.

Per le aziende: investi in alfabetizzazione AI, qualità dei dati e progetti pilota con ROI chiaro—mentre mantieni un piano “no regrets” che funzioni anche se l'AGI arriva più tardi.

Un modo pragmatico per operationalizzare “osserva i segnali e iterare” è accorciare i cicli di costruzione: prototipa flussi di lavoro, testa l'affidabilità e quantifica i guadagni di produttività prima di scommettere in grande. Piattaforme come Koder.ai si adattano a questo approccio permettendo ai team di creare app web, backend e mobile tramite un'interfaccia chat (con modalità di pianificazione, snapshot e rollback), così puoi sperimentare processi assistiti da agenti rapidamente, esportare il codice sorgente quando necessario ed evitare di vincolare la strategia a una singola previsione.

Una conclusione equilibrata: le timeline possono guidare la preparazione, non la certezza. Usale per priorizzare esperimenti e ridurre i punti ciechi—poi rivedi regolarmente le tue assunzioni man mano che arrivano nuove evidenze.