10 nov 2025·8 min

Come creare un sito per il registro degli esperimenti di prodotto

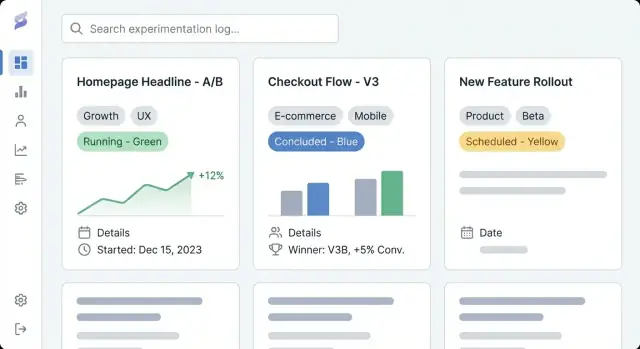

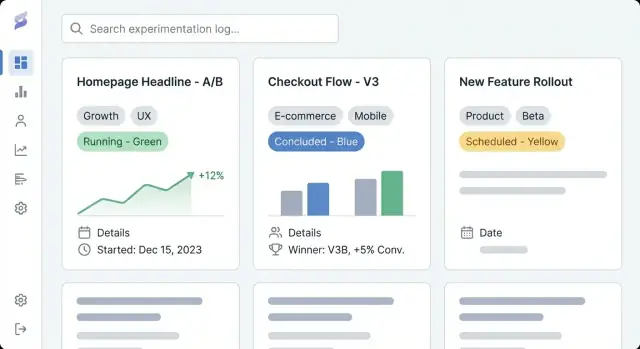

Scopri come pianificare, progettare e lanciare un sito che documenta gli esperimenti di prodotto con voci coerenti, tagging, ricerca e report chiari dei risultati.

Scopri come pianificare, progettare e lanciare un sito che documenta gli esperimenti di prodotto con voci coerenti, tagging, ricerca e report chiari dei risultati.

Un sito per il registro degli esperimenti di prodotto è un luogo condiviso per documentare ogni esperimento che il team esegue—test A/B, prove di prezzo, modifiche all'onboarding, feature flag, esperimenti email e anche idee “fallite” che comunque hanno insegnato qualcosa. Pensalo come un repository di esperimenti e un registro di apprendimento del prodotto insieme: una traccia di cosa avete provato, perché l'avete provato, cosa è successo e quale decisione avete preso dopo.

La maggior parte dei team ha già frammenti di tracciamento degli esperimenti sparsi tra documenti, dashboard e chat. Un sito dedicato raccoglie quegli artefatti in una storia unica e navigabile.

I risultati pratici sono:

Questa guida si concentra su come costruire un sito che renda la documentazione degli esperimenti facile da creare e da usare. Copriremo come pianificare struttura e navigazione, definire un modello dati per le voci di esperimento (così le voci rimangono coerenti), creare template di pagina leggibili, impostare tag e ricerca per una scoperta rapida e scegliere l'approccio di implementazione giusto (CMS vs app custom).

Alla fine avrai un piano chiaro per un sito di documentazione dei test A/B che supporta il lavoro quotidiano di prodotto—catturando ipotesi, metriche e reporting dei risultati, e decisioni in modo ricercabile, affidabile e utile nel tempo.

Prima di scegliere strumenti o disegnare template di esperimento, chiarisci perché esiste questo sito e a chi è destinato. Un registro degli esperimenti è utile solo se rispecchia come i team prendono davvero le decisioni.

Annota 2–4 risultati misurabili per il repository di esperimenti. Definizioni comuni di successo includono:

Questi obiettivi devono influenzare ogni scelta successiva: quali campi richiedere in ogni voce, quanto rigido sarà il workflow e quanto avanzata dovrà essere la tassonomia/ricerca.

Elenca i pubblici principali e cosa devono poter fare nel registro di apprendimento del prodotto:

Un modo semplice per validare: chiedi a ogni gruppo “Quale domanda vuoi che sia risposta in 30 secondi?” Poi assicurati che i template e il layout della pagina supportino quella risposta.

Decidi subito se il tuo CMS per il registro degli esperimenti dovrebbe essere:

Se scegli l’accesso misto, definisci cosa è consentito nelle voci pubbliche (es. niente metriche raw, segmenti anonimizzati, nessun nome di feature non rilasciate) e chi approva la pubblicazione. Questo evita rifare il lavoro più avanti quando il team vorrà condividere apprendimenti all’esterno.

Un registro degli esperimenti funziona solo se le persone trovano l’esperimento giusto in meno di un minuto. Prima di scegliere strumenti o progettare schermate, decidi come qualcuno sfoglierà il sito quando non sa esattamente cosa cercare.

Mantieni la navigazione principale limitata e prevedibile. Un punto di partenza pratico è:

Se “Metrics” sembra pesante, puoi collegarla inizialmente da Experiments e ampliarla più avanti.

Decidi la principale “forma” per la navigazione. Molti registri funzionano meglio con una vista primaria e il resto gestito da filtri:

Scegli quella che i tuoi stakeholder già usano nelle conversazioni. Tutto il resto può essere tag (es. piattaforma, tema dell'ipotesi, segmento, tipo di esperimento).

Rendi le URL leggibili e stabili così le persone possono condividerle in Slack e ticket:

/experiments/2025-12-checkout-free-shipping-thresholdAggiungi breadcrumb come Experiments → Checkout → Free shipping threshold per evitare vicoli ciechi e mantenere la scansione intuitiva.

Elenca cosa pubblicherai al giorno uno rispetto a più avanti: esperimenti recenti, playbook principali, un glossario metriche core e pagine team. Prioritizza le voci che saranno spesso consultate (test ad alto impatto, template canonici e definizioni metriche usate nei report dei risultati).

Un registro utile non è solo una lista di link—è un database di apprendimenti. Il modello dati è la “forma” di quel database: cosa archivi, come le voci si relazionano e quali campi devono essere presenti affinché gli esperimenti rimangano confrontabili nel tempo.

Inizia con un piccolo set di tipi di contenuto che rispecchiano come i team lavorano realmente:

Separare queste entità impedisce a ogni esperimento di inventare nuovi nomi di metriche o di seppellire decisioni nel testo libero.

Rendi la “voce minima” facile da compilare. Al minimo, richiedi:

Campi opzionali ma spesso utili includono pubblico target, allocazione traffico, tipo di test (A/B, multivariato) e link a ticket o design.

I risultati sono il punto dove i registri spesso si sfaldano, quindi standardizzali:

Se consenti allegati, mantieni uno slot coerente per gli screenshot così i lettori sanno dove guardare.

Modella le relazioni esplicitamente così la scoperta e i report funzionano meglio:

Standardizza gli stati in modo che ordinamenti e dashboard restino significativi: proposed, running, concluded, shipped, archived. Questo evita che “done”, “complete” e “finished” diventino tre stati diversi.

Buoni template trasformano le note di qualcuno in un record condiviso che tutta l'azienda può scorrere, fidarsi e riutilizzare. L'obiettivo è coerenza senza far sentire gli autori come se stessero compilando scartoffie.

Inizia con le informazioni che servono al lettore per decidere se continuare a leggere.

/docs/...) e metrica primaria.La pagina indice dovrebbe comportarsi come una dashboard. Includi filtri per stato, team, tag, range di date e piattaforma; ordinamento per aggiornati di recente, data inizio e (se puoi quantificarlo) impatto; e campi rapidi come stato, owner, date inizio/fine e una risultato in una riga.

Crea un template di default più varianti opzionali (es. “A/B test”, “test di pricing”, “esperimento onboarding”). Prefilla titoli, testo d'esempio e campi obbligatori così gli autori non partono da una pagina vuota.

Usa un layout a colonna singola, spaziatura generosa e tipografia chiara. Tieni i fatti chiave in un blocco sommario sticky (dove ha senso) e rendi le tabelle scrollabili orizzontalmente in modo che i risultati restino leggibili su telefono.

Un registro degli esperimenti è utile solo se le persone trovano rapidamente gli apprendimenti rilevanti. Tagging e tassonomia trasformano un mucchio di pagine in qualcosa che puoi sfogliare, filtrare e riutilizzare.

Definisci alcune categorie di tag che rispecchino come il tuo team cerca naturalmente. Una baseline pratica è:

Mantieni il numero di gruppi limitato. Troppe dimensioni rendono i filtri confusi e incoraggiano tagging incoerente.

I tag incontrollati diventano rapidamente “signup”, “sign-up” e “registration”. Crea un vocabolario controllato:

Un approccio semplice è una pagina “tag registry” che il team mantiene (es. /experiment-tags) più una revisione leggera durante la stesura degli esperimenti.

I tag sono ottimi per la scoperta, ma alcuni attributi dovrebbero essere campi strutturati per restare coerenti:

I campi strutturati alimentano filtri e dashboard affidabili, mentre i tag catturano le sfumature.

Aiuta i lettori a saltare tra lavori connessi. Aggiungi sezioni come Related experiments (stessa feature o metrica) e Similar hypotheses (stessa assunzione testata altrove). Questo può essere link manuali all’inizio e poi automatizzato con regole di “tag condivisi” per suggerire vicini.

Questa decisione definisce il tetto funzionale del tuo registro. Un CMS ti fa pubblicare in fretta, mentre un'app custom può trasformare il registro in un sistema integrato per prendere decisioni.

Un CMS è adatto quando il bisogno principale è documentazione coerente e leggibile dei test A/B con una struttura leggera.

Usa un CMS se vuoi:

Pattern tipico: un headless CMS (contenuto memorizzato nel CMS, presentato dal sito) abbinato a un static site generator. Questo mantiene il repository veloce, facile da ospitare e accessibile ai contributori non tecnici.

Un'app custom ha senso quando il registro deve collegarsi direttamente ai dati di prodotto e agli strumenti interni.

Considera un'app custom se hai bisogno di:

Se vuoi prototipare velocemente, una piattaforma vibe-coding come Koder.ai può essere un'opzione pratica: puoi descrivere il modello dati (experiments, metrics, decisions), i template di pagina e i workflow in chat, poi iterare su un'app React + Go + PostgreSQL funzionante, con deploy/hosting, esportazione del codice e snapshot/rollback per modifiche sicure.

Sii esplicito su dove risiedono i dati degli esperimenti.

Scrivi questo chiaramente fin da subito—altrimenti i team finiscono con voci duplicate in documenti, fogli di calcolo e strumenti, e il registro di apprendimento perde fiducia.

Il tuo registro non ha bisogno di tecnologie esotiche. Lo stack migliore è quello che il team sa operare, mettere in sicurezza e far evolvere senza attrito.

Un sito statico (pagine pre-costruite) è spesso la scelta più semplice: veloce, economico da ospitare e a bassa manutenzione. Funziona bene se gli esperimenti sono principalmente in sola lettura e gli aggiornamenti avvengono tramite CMS o pull request.

Un server-rendered app è adatto quando hai bisogno di controllo accessi più forte, filtri dinamici o viste per team senza complessità client. È anche più facile applicare permessi a livello server.

Una single-page app (SPA) è reattiva per filtri e dashboard, ma aggiunge complessità su SEO, auth e tempo di caricamento iniziale. Sceglila solo se davvero necessiti interazioni da app.

Se costruisci un'app custom, decidi anche se vuoi una pipeline di build convenzionale o un approccio accelerato. Per esempio, Koder.ai può generare lo scaffolding core (UI React, API Go, schema PostgreSQL) da uno spec scritto, utile quando stai iterando su template e workflow con più stakeholder.

Prioritizza affidabilità (uptime, monitoring, alerting) e backup (automazioni e restore testati). Mantieni separazione degli ambienti: almeno uno staging per provare cambi a tassonomia, template e permessi prima della produzione.

La maggior parte dei team ha bisogno di SSO (Okta, Google Workspace, Azure AD), più ruoli (viewer, editor, admin) e aree private per apprendimenti sensibili (revenue, dati utenti, note legali). Pianifica questo presto per non dover riprogettare più tardi.

Usa caching (CDN e caching browser), mantieni pagine leggere e ottimizza media (immagini compresse, lazy loading quando utile). La velocità è importante: le persone non useranno un registro che sembra lento, soprattutto quando cercano rapidamente un test passato durante una riunione.

Un registro diventa davvero utile quando le persone trovano “quel test lì” in pochi secondi—senza conoscere il titolo esatto.

La ricerca on-site (integrata nel CMS o nel DB dell'app) è spesso sufficiente con qualche centinaio di esperimenti, un team piccolo e bisogni semplici come cercare in titoli, riepiloghi e tag. È più facile da mantenere e evita setup di vendor esterni.

Un servizio di ricerca esterno (Algolia/Elastic/OpenSearch) vale la pena quando hai migliaia di voci, necessiti risultati rapidissimi, tolleranza ai refusi e sinonimi (es. “checkout” = “purchase”), o ranking avanzato per mostrare prima i risultati più rilevanti. È utile anche se il contenuto proviene da più fonti (docs + log + wiki).

La ricerca non basta. Aggiungi filtri che riflettano decisioni reali:

Rendi i filtri combinabili (es. “Concluded + Ultimi 90 giorni + Growth team + Metrica Activation”).

Le viste salvate trasformano domande ricorrenti in risposte con un click:

Consenti ai team di pinnare viste condivise nella navigazione e agli individui di salvare viste personali.

Nei risultati di ricerca mostra uno snippet breve: ipotesi, variante, audience e outcome principale. Evidenzia le parole corrispondenti nel titolo e nel riepilogo e mostra alcuni campi chiave (stato, owner, metrica primaria) così gli utenti decidono senza aprire troppe pagine.

Un ottimo registro non è solo pagine e tag—è un processo condiviso. Proprietà chiara e workflow leggeri prevengono voci a metà, risultati mancanti e “decisioni misteriose” mesi dopo.

Inizia decidendo chi può creare, modificare, approvare e pubblicare le voci. Un modello semplice funziona per la maggior parte dei team:

Mantieni i permessi coerenti con le decisioni sull'accesso (interno vs pubblico vs ristretto). Se supporti esperimenti privati, richiedi un owner esplicito per ogni voce.

Definisci una breve checklist che ogni esperimento deve soddisfare prima della pubblicazione:

Questa checklist può essere una sezione richiesta all'interno dei template.

Tratta le voci come documenti vivi. Abilita version history e richiedi brevi note di modifica per aggiornamenti materiali (correzione di metriche, rettifica di analisi, inversione di decisione). Questo mantiene la fiducia alta e semplifica audit.

Decidi in anticipo come memorizzare informazioni sensibili:

La governance non deve essere pesante; deve essere solo esplicita.

Un registro è utile solo se le persone lo trovano, si fidano e riutilizzano ciò che c'è dentro. Analytics leggere aiutano a capire cosa funziona e cosa no—senza trasformare il sito in uno strumento di sorveglianza.

Inizia con alcuni segnali pratici:

Se lo strumento analytics lo supporta, disabilita il logging di IP ed evita identificatori utente. Preferisci report aggregati a livello di pagina.

Le metriche d'uso non dicono se le voci sono complete. Aggiungi controlli di “salute del contenuto” che segnalino:

Può essere un report settimanale dal CMS/database o uno script che segnala le voci. L'obiettivo è rendere visibili i gap così gli owner li correggono.

Le write-up non dovrebbero quasi mai contenere dati personali. Mantieni le voci prive di:

Collega dashboard aggregati invece di incorporare dataset raw e conserva analisi sensibili in sistemi approvati.

I risultati A/B sono facili da interpretare fuori contesto. Aggiungi un breve disclaimer nel template dell'esperimento (e/o nel footer) che indica che:

Questo mantiene il registro onesto e riduce il riuso meccanico di risultati passati.

Un ottimo registro non è “finito” quando il sito è live. Il valore reale arriva quando i team si fidano, lo mantengono aggiornato e riescono ancora a trovare apprendimenti sei mesi dopo.

La maggior parte dei team parte da fogli di calcolo, slide o documenti sparsi. Scegli un piccolo batch pilota (es. gli esperimenti dell'ultimo trimestre) e mappa ogni campo di origine al nuovo template.

Se possibile, importa in blocco: esporta i fogli in CSV e poi usa script o l'importer del CMS per creare le voci nel nuovo formato. Per i documenti, migra prima i campi di sintesi (obiettivo, cambiamento, risultati, decisione) e collega il file originale come dettaglio di supporto.

Fai un controllo mirato su coerenza, non perfezione. Problemi comuni da correggere:

Questo è anche il momento giusto per accordarsi sui campi obbligatori per le voci segnate come complete.

Prima di annunciare, verifica:

Imposta una routine leggera: pulizia mensile (bozze stale, risultati mancanti) e revisione trimestrale della tassonomia (unisci tag, aggiungi categorie con giudizio).

Una volta stabilite le basi, valuta integrazioni: collegare automaticamente esperimenti ai tracker di issue o importare contesto analitico così ogni voce punta alla dashboard esatta usata per il reporting dei risultati.

Se stai evolvendo verso un'app custom, puoi anche iterare prima in “modalità pianificazione”—scrivendo workflow, campi richiesti e regole di approvazione—poi implementandoli. Piattaforme come Koder.ai supportano questo ciclo iterativo di build-and-refine (con deploy, snapshot e rollback) così il registro può crescere senza rifacimenti pesanti.

Un sito per il registro degli esperimenti di prodotto è un repository condiviso e ricercabile per documentare gli esperimenti (test A/B, prove di prezzo, cambiamenti di onboarding, rollout con feature flag, test email). Ogni voce registra cosa avete provato, perché, cosa è successo e quale decisione è stata presa dopo—così gli apprendimenti non si perdono in documenti, dashboard o chat.

Inizia definendo 2–4 risultati misurabili, per esempio:

Questi obiettivi devono guidare i campi obbligatori, la rigidità del workflow e quanto avanzata deve essere la tassonomia/ricerca.

Elenca i tuoi pubblici principali e la “domanda da 30 secondi” che ciascuno vuole vedere. Bisogni comuni includono:

Scegli uno dei tre modelli:

Se scegli il modello misto, definisci cosa è consentito pubblicamente (es. niente metriche raw, segmenti anonimizzati) e chi approva la pubblicazione per evitare lavoro duplicato dopo.

Mantieni la navigazione principale semplice e prevedibile, ad esempio:

Scegli una dimensione principale per la navigazione (area prodotto, fase del funnel o team) e usa filtri/tag per tutto il resto.

Richiedi un set minimo coerente per ogni voce:

Per i risultati, standardizza:

Un ordine pratico per la pagina dettaglio è:

Usa poche categorie di tag che rispecchino come le persone cercano, ad esempio:

Previeni la proliferazione dei tag con un vocabolario controllato (regole di naming, chi può crearli, brevi descrizioni). Mantieni attributi core come , e come campi strutturati, non tag liberi.

Usa un CMS se ti serve soprattutto documentazione coerente, permessi e tagging di base con un editor familiare.

Scegli un app custom se hai bisogno di integrazioni profonde (feature flags, analytics, data warehouse, ticketing), ricerca avanzata, regole di workflow (campi obbligatori/approvazioni) o estrazione automatica dei risultati.

Qualunque sia la scelta, documenta la source of truth (CMS vs database/app) per evitare voci duplicate o incongruenti.

Inizia con strumenti pratici per la scoperta:

Nella lista risultati mostra uno snippet del risultato e campi chiave (stato, owner, metrica primaria) così gli utenti decidono senza aprire troppe pagine.

Poi progetta template e layout pagina per far emergere subito quelle risposte.

Questo trasforma le note in record confrontabili nel tempo.

Questo rende le pagine scansionabili mantenendo la profondità quando serve.