Perché questa storia conta per i team che eseguono software

I team non faticano perché non sanno avviare un container. Faticano perché devono gestirne centinaia in modo sicuro, aggiornarli senza downtime, riprendersi quando qualcosa si rompe e continuare a rilasciare funzionalità nei tempi previsti.

La storia “cloud-native” di Craig McLuckie è importante perché non è una celebrazione di demo appariscenti. È la documentazione di come i container siano diventati operabili in ambienti reali—dove succedono incidenti, ci sono requisiti di conformità e il business ha bisogno di consegne prevedibili.

Cloud-native, in parole semplici

“Cloud-native” non significa semplicemente “girare nel cloud”. È un approccio per costruire e gestire software in modo che possa essere distribuito frequentemente, scalato quando la domanda cambia e riparato rapidamente quando parti si guastano.

In pratica, questo di solito significa:

- Applicazioni confezionate e distribuite in modo coerente (spesso con container)

- Sistemi progettati come servizi più piccoli, non come un'unica release gigantesca

- Automazione per deploy, scaling e rollback

- Modi standard per osservare, mettere in sicurezza e governare ciò che è in esecuzione

L’adozione iniziale dei container somigliava spesso a una cassetta degli attrezzi: i team prendevano Docker, incollavano script e speravano che l’operatività tenesse il passo. Il pensiero da piattaforma ribalta questo approccio. Invece che ogni team inventi la propria via verso la produzione, si costruiscono “percorsi agevolati”: una piattaforma che rende la via sicura, conforme e osservabile anche la via più semplice.

Questo cambiamento è il ponte tra “riusciamo a eseguire container” e “possiamo costruare un business su di essi”.

A chi si rivolge questo articolo

Questo articolo è per chi è responsabile dei risultati, non solo dei diagrammi architetturali:

- Leader tecnici che bilanciano velocità e affidabilità

- Team di prodotto che vogliono iterare più rapidamente senza interruzioni

- Persone di platform, DevOps e SRE che cercano di ridurre il lavoro ripetitivo e gli attriti

- Sviluppatori che vogliono semplicemente che i deploy siano noiosi e ripetibili

Se il tuo obiettivo è una consegna affidabile a scala, questa storia ha lezioni pratiche.

Chi è Craig McLuckie (e perché viene citato)

Craig McLuckie è uno dei nomi più noti legati al primo movimento cloud-native. Lo vedrai menzionato nelle conversazioni su Kubernetes, la Cloud Native Computing Foundation (CNCF) e l’idea che l’infrastruttura debba essere trattata come un prodotto—non una pila di ticket e conoscenza tribale.

Non “l’inventore”, ma un costruttore chiave

Vale la pena essere precisi. McLuckie non ha “inventato” il cloud-native da solo, e Kubernetes non è mai stato un progetto monopersonale. Kubernetes è nato da un team in Google, e McLuckie ha fatto parte di quel primo sforzo.

A lui viene spesso attribuito il merito di aver trasformato un concetto ingegneristico in qualcosa che l’industria potesse realmente adottare: costruzione di comunità più forte, packaging più chiaro e spinta verso pratiche operative ripetibili.

Un tema coerente: affidabilità tramite ripetibilità

Attraverso Kubernetes e l’era CNCF, il messaggio di McLuckie è stato meno incentrato sulle architetture alla moda e più sul rendere la produzione prevedibile. Questo significa:

- Modi standard per distribuire e fare rollback

- Ambienti coerenti dal laptop alla produzione

- Guardrail operativi che riducono le sorprese

Se hai già sentito termini come “percorsi agevolati”, “percorsi privilegiati” o “piattaforma come prodotto”, stai girando intorno alla stessa idea: ridurre il carico cognitivo per i team facendo in modo che la cosa giusta sia anche la più semplice.

Perché lo cito

Questo post non è una biografia. McLuckie è un punto di riferimento utile perché il suo lavoro sta all’incrocio di tre forze che hanno cambiato la delivery del software: container, orchestrazione e costruzione di ecosistemi. Le lezioni qui non riguardano la personalità ma il motivo per cui il pensiero da piattaforma si è rivelato la chiave per eseguire container in produzione reale.

Prima del cloud-native: i container c’erano, la produzione era difficile

I container erano un’idea entusiasmante molto prima che “cloud-native” diventasse un’etichetta comune. In termini semplici, un container è un modo per impacchettare un’applicazione insieme ai file e alle librerie di cui ha bisogno così da poter girare allo stesso modo su macchine diverse—come spedire un prodotto in una scatola sigillata con tutte le parti dentro.

Perché l’uso iniziale dei container è rimasto sperimentale

All’inizio molti team usavano i container per progetti laterali, demo e flussi di lavoro per sviluppatori. Erano ottimi per provare nuovi servizi rapidamente, creare ambienti di test e evitare il problema “funziona sul mio laptop” durante un passaggio.

Ma passare da una manciata di container a un sistema di produzione che gira 24/7 è un lavoro diverso. Gli strumenti c’erano, ma la storia operativa era incompleta.

I blocchi che i team incontravano in produzione

Problemi comuni emergevano rapidamente:

- Aggiornamenti e rollback: come aggiornare dozzine (o centinaia) di container in esecuzione in sicurezza, senza downtime? E come tornare indietro quando qualcosa si rompe?

- Networking: i container devono trovarsi reciprocamente in modo affidabile. Service discovery, instradamento del traffico, load balancing e “chi può parlare con chi” non erano standardizzati.

- Sicurezza: provenienza delle immagini, gestione dei segreti, controlli di accesso e patching delle vulnerabilità sono diventati lavoro continuo, non una configurazione una tantum.

- Monitoraggio e debugging: quando un container viene riavviato, i log possono sparire. Metriche, tracing e alerting dovevano essere progettati per un mondo in cui i processi sono effimeri.

Da “funziona sulla mia macchina” a “gira ogni giorno a scala”

I container hanno reso il software portabile, ma la sola portabilità non garantiva affidabilità. I team avevano ancora bisogno di pratiche di distribuzione coerenti, responsabilità chiare e guardrail operativi—così le app containerizzate non girassero solo una volta, ma in modo prevedibile ogni giorno.

Il pensiero da piattaforma è il momento in cui un’azienda smette di trattare l’infrastruttura come un progetto una tantum e inizia a considerarla come un prodotto interno. I “clienti” sono i tuoi sviluppatori, i team dati e chiunque rilasci software. L’obiettivo di prodotto non è più avere più server o più YAML—è un percorso più fluido dall’idea alla produzione.

Una vera piattaforma ha una promessa chiara: “Se costruisci e distribuisci seguendo questi percorsi, otterrai affidabilità, sicurezza e consegne prevedibili.” Quella promessa richiede abitudini da product: documentazione, supporto, versioning e loop di feedback. Richiede anche un’esperienza utente deliberata: default sensati, percorsi agevolati e una via d’uscita quando i team ne hanno veramente bisogno.

Perché la standardizzazione accelera la delivery (e riduce il rischio)

La standardizzazione rimuove la fatica decisionale e previene la complessità accidentale. Quando i team condividono gli stessi pattern di deploy, logging e controlli di accesso, i problemi diventano ripetibili—e quindi risolvibili. I turni on-call migliorano perché gli incidenti appaiono familiari. Le revisioni di sicurezza diventano più veloci perché la piattaforma incorpora i guardrail invece di affidarsi a ciascun team per reinventarli.

Non si tratta di costringere tutti nello stesso box. Si tratta di mettersi d’accordo sull’80% che dovrebbe essere noioso, così i team possono dedicare energia al 20% che differenzia il business.

Dai server fatti a mano ai pattern ripetibili

Prima che il pensiero da piattaforma prendesse piede, l’infrastruttura spesso dipendeva da conoscenze speciali: poche persone sapevano quali server erano patchati, quali impostazioni erano sicure e quali script erano “quelli buoni”. Il pensiero da piattaforma sostituisce questo con pattern ripetibili: template, provisioning automatizzato e ambienti coerenti da dev a produzione.

Governance senza burocrazia

Fatto bene, una piattaforma crea una governance migliore con meno carta. Le policy diventano controlli automatici, le approvazioni diventano workflow auditable e le evidenze di conformità vengono generate mentre i team distribuiscono—così l’organizzazione ha controllo senza rallentare tutti.

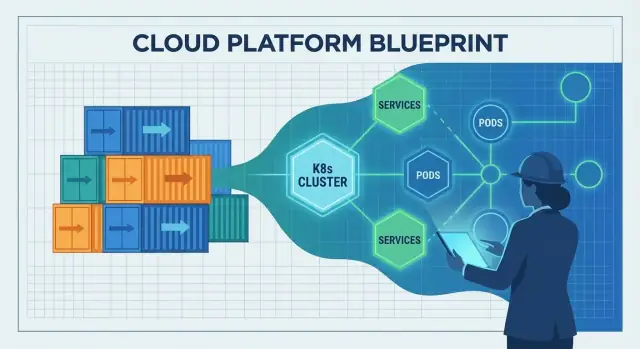

Kubernetes come ponte dai container alle operazioni

I container hanno reso facile impacchettare e spedire un’app. La parte difficile era cosa succedeva dopo: scegliere dove farla girare, mantenerla sana e adattarsi quando traffico o infrastruttura cambiavano.

Questo è il gap che Kubernetes ha colmato. Ha trasformato “una pila di container” in qualcosa che puoi operare giorno dopo giorno, anche quando nodi falliscono, avvengono release e la domanda schizza.

Cosa risolve realmente l’orchestrazione

Kubernetes è spesso descritto come “orchestrazione dei container”, ma i problemi pratici sono più specifici:

- Scheduling: decidere quale macchina dovrebbe eseguire ogni container, in base a CPU/memoria disponibili e regole di placement.

- Self-healing: riavviare container crashati, ripianificarli se un nodo muore e mantenere il numero desiderato di istanze.

- Scaling: aumentare o diminuire repliche in base alla domanda e distribuire nuove versioni senza prendere tutto offline.

Senza un orchestratore, i team finiscono per scriptare questi comportamenti e gestire le eccezioni a mano—finché gli script non corrispondono più alla realtà.

Un control plane condiviso

Kubernetes ha popolarizzato l’idea di un control plane condiviso: un posto dove dichiari cosa vuoi (“esegui 3 copie di questo servizio”) e la piattaforma lavora continuamente per far coincidere il mondo reale con quell’intento.

Questo è un grande spostamento di responsabilità:

- Gli sviluppatori deployano: costruiscono un’immagine, applicano una deployment, impostano richieste di risorse, definiscono health check.

- La piattaforma lo mantiene in funzione: posiziona i carichi, sostituisce istanze fallite, bilancia i rollout e mantiene il service discovery.

Nato da pattern operativi reali

Kubernetes non è nato perché i container erano di moda. È cresciuto da lezioni imparate gestendo flotte grandi: tratta l’infrastruttura come un sistema con loop di feedback, non come una serie di compiti su server singoli. Questa mentalità operativa è il motivo per cui è diventato il ponte tra “possiamo eseguire container” e “possiamo eseguirli affidabilmente in produzione”.

Cosa ha cambiato il cloud-native nella delivery quotidiana

Esporta nella tua pipeline

Genera codice, esportalo e integralo nella tua pipeline CI/CD e nel flusso Kubernetes.

Cloud-native non ha solo introdotto nuovi strumenti—ha cambiato il ritmo quotidiano della consegna del software. I team sono passati da “server fatti a mano e runbook manuali” a sistemi pensati per essere guidati da API, automazione e configurazione dichiarativa.

Da ticket e SSH ad API e automazione

Un setup cloud-native assume che l’infrastruttura sia programmabile. Serve un database, un load balancer o un nuovo ambiente? Invece di aspettare una configurazione manuale, i team descrivono ciò che vogliono e lasciano che l’automazione lo crei.

Lo spostamento chiave è la configurazione dichiarativa: definisci lo stato desiderato (“esegui 3 copie di questo servizio, esponilo su questa porta, limita la memoria a X”) e la piattaforma lavora continuamente per raggiungere quello stato. Questo rende le modifiche revisionabili, ripetibili e più facili da rollbackare.

Deploy immutabili riducono la deriva

La delivery tradizionale spesso comportava patchare server live. Col tempo ogni macchina diventava un po’ diversa—drift di configurazione che si manifesta solo durante un incidente.

La delivery cloud-native spinge verso deployment immutabili: costruisci un artefatto una volta (spesso un’immagine container), distribuiscilo e se serve un cambiamento distribuisci una nuova versione anziché modificare ciò che è in esecuzione. Combinato con rollout automatici e health check, questo riduce le “mystery outages” causate da fix ad hoc.

Microservizi e container: un circolo che si autoalimenta (con compromessi)

I container hanno reso più facile impacchettare ed eseguire molti piccoli servizi in modo coerente, incentivando architetture a microservizi. I microservizi, a loro volta, hanno aumentato la necessità di deployment coerenti, scaling e service discovery—aree dove l’orchestrazione dei container eccelle.

Il compromesso: più servizi significa più overhead operativo (monitoraggio, networking, versioning, risposta agli incidenti). Il cloud-native aiuta a gestire quella complessità, ma non la elimina.

Portabilità: reale, ma non magica

La portabilità è migliorata perché i team si sono standardizzati su primitive e API comuni. Tuttavia, “girare ovunque” richiede comunque lavoro—differenze in sicurezza, storage, networking e servizi gestiti contano. Cloud-native va capito come riduzione del lock-in e degli attriti, non come loro eliminazione.

CNCF e l’effetto ecosistema: perché ha accelerato l’adozione

Kubernetes non si è diffuso solo perché potente. Si è diffuso perché ha trovato una casa neutrale, una governance chiara e un posto dove aziende concorrenti potevano cooperare senza che un unico vendor "dettesse le regole".

Una foundation neutrale rende la collaborazione più sicura

La Cloud Native Computing Foundation (CNCF) ha creato una governance condivisa: decisioni aperte, processi di progetto prevedibili e roadmap pubbliche. Questo conta per i team che scommettono su infrastrutture core. Quando le regole sono trasparenti e non vincolate al modello di business di una singola azienda, l’adozione sembra meno rischiosa—e i contributi diventano più attraenti.

Il ruolo del CNCF: più di un logo

Ospitando Kubernetes e progetti correlati, la CNCF ha aiutato a trasformare “un popolare tool open source” in una piattaforma a lungo termine con supporto istituzionale. Ha fornito:

- Un modo coerente per gestire maintainer, release e pratiche di sicurezza

- Un luogo per il coordinamento cross-company

- Un segnale al mercato: questo progetto è pensato per durare oltre qualsiasi vendor

Standard aperti e contributori ampi

Con molti contributori (provider cloud, startup, imprese e ingegneri indipendenti), Kubernetes è evoluto più rapidamente e in direzioni più vicine al mondo reale: networking, storage, sicurezza e operazioni di day-2. API aperte e standard hanno facilitato l’integrazione degli strumenti, riducendo il vendor lock-in e aumentando la fiducia per l’uso in produzione.

L’effetto ecosistema (e il compromesso)

Il CNCF ha anche accelerato un’esplosione di ecosistemi: service mesh, ingress controller, tool CI/CD, motori di policy, stack di osservabilità e altro. Questa abbondanza è una forza—ma crea sovrapposizione.

Per la maggior parte dei team, il successo viene scegliendo un piccolo insieme di componenti ben supportati, favorendo l’interoperabilità e chiarendo la ownership. Un approccio “prendi il meglio di tutto” spesso porta più lavoro di manutenzione che a una migliore delivery.

Dagli strumenti all’affidabilità: lo strato operativo mancante

Esercita rilasci sicuri

Esercitati a rilasci sicuri con snapshot e iterazioni a fasi in chat.

Container e Kubernetes hanno risolto una grande parte della domanda “come eseguiamo il software?”. Non hanno automaticamente risolto la domanda più difficile: “come lo teniamo in funzione quando arrivano utenti reali?”. Lo strato mancante è l’affidabilità operativa—aspettative chiare, pratiche condivise e un sistema che rende i comportamenti corretti la scelta di default.

Definire la baseline di produzione

Un team può rilasciare rapidamente ed essere comunque a un cattivo deploy dall’essere catastrofico se la baseline di produzione non è definita. Al minimo, serve:

- Osservabilità: la capacità di vedere cosa succede e perché (non solo se è “up”).

- Risposta agli incidenti: ruoli, turni on-call, percorsi di escalation e revisioni post-incident.

- Pianificazione della capacità: comprensione dei carichi, dei limiti e del comportamento del sistema sotto stress.

Senza questa baseline, ogni servizio inventa le proprie regole e l’affidabilità diventa questione di fortuna.

DevOps e SRE hanno introdotto abitudini importanti: ownership, automazione, affidabilità misurata e apprendimento dagli incidenti. Ma le abitudini da sole non scalano su decine di team e centinaia di servizi.

Le piattaforme rendono quelle pratiche ripetibili. SRE definisce obiettivi (come SLO) e loop di feedback; la piattaforma fornisce i percorsi agevolati per soddisfarli.

Componenti “table stakes” per l’affidabilità

La delivery affidabile richiede in genere un insieme coerente di capacità:

- Logging, metriche, tracing (per debug e miglioramento)

- Alerting legato all’impatto sull’utente (così l’on-call non è rumore)

- Rollback sicuri e pattern di delivery progressiva (così i guasti non sono catastrofici)

Una buona piattaforma incorpora questi default in template, pipeline e policy runtime: dashboard standard, regole di alert comuni, guardrail di deployment e meccanismi di rollback. È così che l’affidabilità smette di essere opzionale e diventa un esito prevedibile del rilascio del software.

Gli strumenti cloud-native possono essere potenti e al tempo stesso sembrare “troppo” per la maggior parte dei team di prodotto. L’engineering di piattaforma esiste per colmare quel divario. La missione è semplice: ridurre il carico cognitivo per i team applicativi così da poter rilasciare funzionalità senza diventare esperti di infrastruttura a tempo parziale.

Un buon team di piattaforma tratta l’infrastruttura interna come un prodotto. Ciò significa utenti chiari (sviluppatori), risultati chiari (consegna sicura e ripetibile) e un loop di feedback. Invece di consegnare una pila di primitivi Kubernetes, la piattaforma offre modi opinionati per costruire, distribuire e operare servizi.

Una lente pratica è chiedersi: “Uno sviluppatore può passare dall’idea a un servizio in esecuzione senza aprire una dozzina di ticket?” Strumenti che comprimono quel flusso—mantenendo i guardrail—sono allineati con l’obiettivo di una piattaforma cloud-native.

Blocchi costitutivi che rendono il cloud-native pratico

La maggior parte delle piattaforme è un insieme di “percorsi agevolati” riutilizzabili che i team possono scegliere come default:

- Template e scaffolding per nuovi servizi (struttura repo, CI, osservabilità di base)

- Workflow self-service (creare un ambiente, richiedere un database, ruotare segreti)

- Pattern di deployment standard (ingress, autoscaling, health check, release canary)

L’obiettivo non è nascondere Kubernetes, ma impacchettarlo in default sensati che prevengano complessità accidentale.

In questo spirito, Koder.ai può essere usato come un livello "DX accelerator" per i team che vogliono creare strumenti interni o funzionalità prodotto rapidamente via chat, per poi esportare il codice sorgente quando è ora di integrarsi con una piattaforma più formale. Per i team di piattaforma, la sua planning mode e gli snapshot/rollback integrati possono rispecchiare la stessa postura orientata alla affidabilità che si desidera nei workflow di produzione.

Compromessi: flessibilità vs. coerenza

Ogni percorso agevolato è un compromesso: più coerenza e operazioni più sicure, ma meno opzioni ad hoc. I team di piattaforma ottengono i migliori risultati quando offrono:

- un percorso privilegiato per l’80% dei servizi

- un corridoio di fuga per i casi limite legittimi (con ownership esplicita)

Segnali che funziona

Il successo della piattaforma è visibile in modi misurabili: onboarding più veloce per nuovi ingegneri, meno script di deploy ad hoc, meno cluster “snowflake” e ownership più chiara durante gli incidenti. Se i team riescono a rispondere “chi possiede questo servizio e come lo rilasciamo?” senza una riunione, la piattaforma sta facendo il suo lavoro.

Cosa può andare storto: insidie che rallentano il progresso cloud-native

Cloud-native può rendere la delivery più veloce e le operazioni più calme—ma solo quando i team sono chiari su cosa vogliono migliorare. Molti rallentamenti avvengono quando Kubernetes e il suo ecosistema vengono trattati come l’obiettivo, non come il mezzo.

1) Kubernetes-first, risultati-dopo

Un errore comune è adottare Kubernetes perché è “ciò che fanno i team moderni”, senza un obiettivo concreto come lead time più breve, meno incidenti o migliore coerenza degli ambienti. Il risultato è tanto lavoro di migrazione senza ritorno evidente.

Se i criteri di successo non sono definiti all’inizio, ogni decisione diventa soggettiva: quale tool scegliere, quanto standardizzare e quando la piattaforma è “completa”.

2) Crescita incontrollata della complessità dall’ecosistema

Kubernetes è una fondazione, non una piattaforma completa. I team spesso aggiungono rapidamente componenti—service mesh, ingress controller multipli, operator custom, motori di policy—senza confini chiari o ownership.

La sovra-personalizzazione è un altro tranello: pattern YAML su misura, template fatti a mano e eccezioni che solo gli autori originali comprendono. La complessità sale, l’onboarding rallenta e gli upgrade diventano rischiosi.

3) Costi, sprawl e punti ciechi di sicurezza

Il cloud-native rende facile creare risorse—e facile dimenticarle. Sprawl di cluster, namespace inutilizzati e workload sovradimensionati gonfiano i costi.

I rischi di sicurezza sono altrettanto comuni:

- Permessi che crescono nel tempo (RBAC ampi, account di servizio condivisi)

- Rischio supply-chain (immagini non validate, troppi chart di terze parti)

- Policy incoerenti tra cluster e ambienti

4) Come mitigare (senza fermare il progresso)

Inizia in piccolo con uno o due servizi ben delimitati. Definisci standard presto (percorsi privilegiati, immagini base approvate, regole di upgrade) e mantieni intenzionalmente limitata la superficie della piattaforma.

Misura risultati come frequenza di deploy, mean time to recovery e tempo di primo deploy per sviluppatore—e tratta qualsiasi cosa che non migliori quei numeri come opzionale.

Un playbook pratico per applicare queste lezioni

Distribuisci un ambiente rapido

Ospita e distribuisci la tua app da Koder.ai quando ti serve un ambiente rapido.

Non si “adotta il cloud-native” in un solo colpo. I team che riescono seguono la stessa idea centrale associata all’era di McLuckie: costruire una piattaforma che renda la via giusta la via più semplice.

Un percorso di adozione semplice

Inizia in piccolo, poi codifica ciò che funziona.

- Pilota: scegli un servizio che dia abbastanza dolore da giustificare il cambiamento, ma non vitale per il business. Containerizzalo, automatizza le build e distribuiscilo ripetutamente finché non diventa routine.

- MVP di piattaforma: trasforma gli insegnamenti del pilota in una piattaforma interna sottile: template standard, un percorso di deploy agevolato, osservabilità di base e un modello di ownership chiaro.

- Espandi: onboarda più team e servizi usando gli stessi default. Concentrati sulla coerenza più che sulla personalizzazione.

- Ottimizza: aggiungi policy, controllo dei costi, workflow per incidenti e funzionalità self-service quando le basi sono stabili.

Se sperimenti nuovi workflow, un pattern utile è prototipare l’esperienza end-to-end del “percorso privilegiato” prima di standardizzarla. Per esempio, i team possono usare Koder.ai per generare rapidamente una web app funzionante (React), backend (Go) e database (PostgreSQL) via chat, poi usare quel codice come punto di partenza per i template della piattaforma e le convenzioni CI/CD.

Domande decisionali per restare onesti

Prima di aggiungere uno strumento, chiediti:

- Perché i container? Quale attrito stai rimuovendo (deriva degli ambienti, packaging, portabilità) e quale lavoro nuovo stai accettando?

- Perché l’orchestrazione? Hai davvero bisogno di scaling automatico, rollout e resilienza di servizio—o una automazione più semplice coprirebbe il bisogno?

- Perché ora? È guidato da dolore nella delivery, rischio di affidabilità o un obiettivo di prodotto chiaro (non solo pressione della moda)?

Metriche che dimostrano progresso reale

Misura i risultati, non l’uso degli strumenti:

- Frequenza di deploy e lead time (velocità di consegna)

- Affidabilità (raggiungimento degli SLO, tasso di incidenti, MTTR)

- Soddisfazione degli sviluppatori (brevi survey, tempo di onboarding, “tempo al primo deploy”)

Se vuoi esempi di come sono fatti buoni pacchetti “platform MVP”, vedi /blog. Per budget e pianificazione del rollout, puoi anche consultare /pricing.

Il prossimo capitolo del cloud-native (e come prepararsi)

La grande lezione dell’ultimo decennio è semplice: i container non hanno “vinto” perché erano un imballaggio ingegnoso. Hanno vinto perché il pensiero da piattaforma li ha resi dipendenti—deployment ripetibili, rollout sicuri, controlli di sicurezza coerenti e operazioni prevedibili.

Il prossimo capitolo non riguarda un singolo strumento rivoluzionario. Riguarda il rendere il cloud-native noioso nel modo migliore: meno sorprese, meno fix ad hoc e un percorso più fluido dal codice alla produzione.

Cosa osservare

Policy-as-code diventerà la norma. Invece di rivedere manualmente ogni deploy, i team codificheranno regole per sicurezza, networking e conformità in modo che i guardrail siano automatici e auditable.

L’esperienza sviluppatore (DX) sarà trattata come un prodotto. Prevedi più attenzione ai percorsi agevolati: template, ambienti self-service e percorsi privilegiati che riducono il carico cognitivo senza limitare l’autonomia.

Operazioni più semplici, non più dashboard. Le migliori piattaforme nasconderanno la complessità: default opinabili, meno parti mobili e pattern di affidabilità incorporati piuttosto che aggiunti.

Evita la trappola del “collezionare strumenti”

Il progresso cloud-native rallenta quando i team inseguono funzionalità invece che risultati. Se non riesci a spiegare come un nuovo strumento riduce il lead time, abbassa i tassi di incidente o migliora la postura di sicurezza, probabilmente non è una priorità.

Un passo successivo chiaro

Valuta i punti dolenti della tua delivery attuale e mappali sui bisogni della piattaforma:

- Dove i deploy falliscono o rallentano più spesso?

- Quali approvazioni e controlli dovrebbero diventare guardrail automatici?

- Cosa gli sviluppatori ricreano ripetutamente (e potrebbe essere standardizzato)?

Tratta le risposte come backlog della piattaforma—e misura il successo dagli esiti che i team percepiscono ogni settimana.