La plupart des gens expérimentent l'Internet à travers des produits : un site qui se charge instantanément, un appel vidéo qui (la plupart du temps) fonctionne, un paiement qui passe en quelques secondes. Sous ces expériences se trouvent des protocoles — des règles partagées qui permettent à des systèmes différents d'échanger des messages de manière suffisamment fiable pour être utiles.

Un protocole, c'est comme s'entendre sur une langue commune et une étiquette pour communiquer : quel est le format d'un message, comment on commence et termine une conversation, que faire quand quelque chose manque, et comment savoir à qui est destiné un message. Sans règles partagées, chaque connexion devient une négociation ponctuelle, et les réseaux ne grandissent pas au‑delà de petits cercles.

Vint Cerf est souvent présenté comme un des « pères de l'Internet », mais il est plus juste (et plus utile) de voir son rôle comme faisant partie d'une équipe qui a pris des choix pragmatiques — surtout autour du TCP/IP — qui ont transformé des « réseaux » en un internetwork. Ces choix n'étaient pas inéluctables. Ils reflétaient des compromis : simplicité vs fonctionnalités, flexibilité vs contrôle, rapidité d'adoption vs garanties parfaites.

Pourquoi les équipes produit devraient s'en soucier

Les plateformes mondiales d'aujourd'hui — applications web, services mobiles, infrastructures cloud et API inter‑entreprises — vivent ou meurent toujours par la même idée : si vous standardisez les bonnes frontières, vous permettez à des millions d'acteurs indépendants de construire par dessus sans demander la permission. Votre téléphone peut parler à des serveurs à l'autre bout du monde non seulement parce que le matériel est plus rapide, mais parce que les règles de circulation sont restées suffisamment stables pour que l'innovation s'accumule.

Cet état d'esprit compte même quand vous « faites juste du logiciel ». Par exemple, des plateformes d'itération rapide comme Koder.ai réussissent lorsqu'elles fournissent un petit ensemble de primitives stables (projets, déploiements, environnements, intégrations) tout en laissant les équipes itérer vite sur les bords — que ce soit pour générer un frontend React, un backend Go + PostgreSQL, ou une application mobile Flutter.

Ce que vous retirerez de cet article

Nous effleurerons l'histoire, mais l'accent est mis sur les décisions de conception et leurs conséquences : comment la mise en couches a permis la croissance, où la livraison « assez bonne » a débloqué de nouvelles applications, et quelles hypothèses initiales se sont révélées erronées sur la congestion et la sécurité. L'objectif est pratique : prendre la pensée protocolaire — interfaces claires, interopérabilité et compromis explicites — et l'appliquer à la conception de plateformes modernes.

Le problème avant l'Internet : nombreux réseaux, pas de colle commune

Avant que « l'Internet » n'existe, il y avait beaucoup de réseaux — mais pas un réseau que tout le monde pouvait partager. Universités, laboratoires gouvernementaux et entreprises construisaient leurs propres systèmes pour des besoins locaux. Chaque réseau fonctionnait, mais ils fonctionnaient rarement ensemble.

Une chronologie rapide (haute niveau)

- Fin des années 1960 : ARPANET prouve l'idée de connecter des ordinateurs distants via un réseau partagé.

- Début des années 1970 : De nouveaux réseaux à paquets apparaissent, construits par des organisations différentes avec des règles et des équipements différents.

- Fin des années 1970–début des années 1980 : Les expérimentations d'internetworking mûrissent en standards partagés que beaucoup de réseaux peuvent adopter.

Pourquoi tant de réseaux séparés

Plusieurs réseaux existaient pour des raisons pratiques, pas parce que les gens appréciaient la fragmentation. Les opérateurs avaient des objectifs différents (recherche, fiabilité militaire, service commercial), des budgets et des contraintes techniques différentes. Les vendeurs de matériel vendaient des systèmes incompatibles. Certains réseaux étaient optimisés pour les liaisons longue distance, d'autres pour les campus, d'autres pour des services spécialisés.

Le résultat fut de nombreuses « îles » de connectivité.

Le vrai problème : interconnexion sans réécriture

Si vous vouliez que deux réseaux communiquent, l'option grossière était de reconstruire un côté pour qu'il corresponde à l'autre. Cela arrive rarement dans la vraie vie : c'est coûteux, lent et politiquement compliqué.

Il fallait une colle commune — un moyen pour des réseaux indépendants de s'interconnecter tout en gardant leurs choix internes. Cela signifiait :

- permettre à des réseaux différents de conserver leur matériel et leurs pratiques d'exploitation ;

- permettre aux messages de traverser plusieurs réseaux comme un seul trajet ;

- éviter un propriétaire unique ou un contrôle central que tout le monde devrait approuver.

Ce défi a préparé le terrain pour les idées d'internetworking défendues par Cerf et d'autres : connecter les réseaux à une couche partagée, afin que l'innovation puisse se produire au‑dessus et que la diversité continue en dessous.

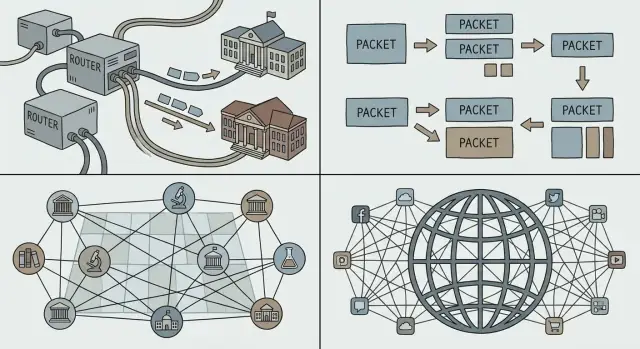

Commutation par paquets : la fondation de tout

Si vous avez déjà passé un appel téléphonique, vous avez ressenti l'intuition derrière la commutation de circuits : une « ligne » dédiée est effectivement réservée de bout en bout pendant l'appel. Cela marche bien pour la voix en temps réel, mais c'est gaspilleur quand la conversation est surtout silence.

La commutation par paquets inverse le modèle. Une analogie courante est le service postal : au lieu de réserver une autoroute privée de votre maison à celle d'un ami, vous mettez votre message dans des enveloppes. Chaque enveloppe (paquet) est étiquetée, acheminée via des routes partagées et réassemblée à destination.

Pourquoi les paquets correspondent aux ordinateurs (et au web)

La plupart du trafic informatique est en rafales. Un courriel, un téléchargement de fichier ou une page web n'est pas un flux continu — c'est une courte rafale de données, puis rien, puis une autre rafale. La commutation par paquets permet à beaucoup de personnes de partager les mêmes liens réseau efficacement, car le réseau transporte les paquets de celui qui a quelque chose à envoyer à l'instant t.

C'est une raison clé pour laquelle l'Internet a pu supporter de nouvelles applications sans renégocier le fonctionnement du réseau sous‑jacent : vous pouvez envoyer un petit message ou une grosse vidéo en utilisant la même méthode de base — le fragmenter en paquets et les envoyer.

Monter en charge sur la distance — et entre organisations

Les paquets scalent aussi socialement, pas seulement techniquement. Différents réseaux (gérés par des universités, des entreprises ou des gouvernements) peuvent s'interconnecter tant qu'ils s'accordent sur la façon de transférer les paquets. Aucun opérateur unique n'a besoin de « posséder » l'intégralité du chemin ; chaque domaine transporte le trafic jusqu'au suivant.

Les compromis : délai, perte et contrôle

Parce que les paquets partagent les liaisons, on peut observer de la mise en file d'attente, du jitter ou même de la perte quand les réseaux sont chargés. Ces inconvénients ont nécessité des mécanismes de contrôle — retransmissions, ordonnancement et contrôle de congestion — pour que la commutation par paquets reste rapide et équitable même sous forte charge.

Internetworking et la séparation TCP/IP : une mise en couches simple et puissante

Le but poursuivi par Cerf et ses collègues n'était pas de « construire un seul réseau ». Il s'agissait d'interconnecter beaucoup de réseaux — universitaires, gouvernementaux, commerciaux — tout en laissant chacun conserver sa technologie, ses opérateurs et ses règles.

Une grande idée : séparer le travail en deux

On décrit souvent TCP/IP comme une « suite », mais le geste de conception pivot est la séparation des responsabilités :

- IP (Internet Protocol) gère l'adressage et le routage : faire aller les paquets d'un réseau à un autre, saut par saut.

- TCP (Transmission Control Protocol) fournit la livraison fiable (lorsque nécessaire) : ordonnancement, retransmission et contrôle de flux pour que les applications puissent voir la connexion comme un tuyau propre.

Cette séparation a permis à « l'internet » d'agir comme un tissu de livraison commun, tandis que la fiabilité devenait un service optionnel superposé.

Pourquoi la mise en couches continue de l'emporter

La mise en couches rend les systèmes plus faciles à faire évoluer parce que vous pouvez mettre à jour une couche sans renégocier tout ce qui se situe au‑dessus. De nouveaux liens physiques (fibre, Wi‑Fi, cellulaire), des stratégies de routage et des mécanismes de sécurité peuvent apparaître au fil du temps — et les applications continuent de parler TCP/IP et de fonctionner.

C'est le même schéma sur lequel s'appuient les équipes plateformes : interfaces stables, internes remplaçables.

Des primitives « assez bonnes » qui créent des applications surprises

IP ne promet pas la perfection ; il fournit des primitives simples et universelles : « voici un paquet » et « voici une adresse ». Cette retenue a permis à des applications inattendues de prospérer — courrier électronique, web, streaming, chat en temps réel — parce que les innovateurs pouvaient construire ce dont ils avaient besoin aux bords sans demander la permission au réseau.

Si vous concevez une plateforme, voici un test utile : proposez‑vous quelques blocs de construction fiables, ou sur‑adaptez‑vous le système au cas d'utilisation du moment ?

IP en meilleur effort : laissez le réseau être simple, laissez les apps innover

La livraison « best‑effort » est une idée simple : IP essayera de déplacer vos paquets vers la destination, mais il ne promet pas qu'ils arriveront, arriveront dans l'ordre ou à temps. Les paquets peuvent être abandonnés quand les liaisons sont occupées, retardés par la congestion ou prendre des routes différentes.

Pourquoi l'absence de garanties a aidé la diffusion d'Internet

Cette simplicité était une caractéristique, pas un défaut. Différentes organisations pouvaient connecter des réseaux très différents — liaisons coûteuses et de haute qualité ici ; liaisons bruyantes et basse bande passante là — sans exiger que tout le monde passe à la même infrastructure haut de gamme.

IP en meilleur effort a abaissé le « prix d'entrée » pour participer. Universités, gouvernements, startups et finalement les foyers ont pu se joindre avec la connectivité qu'ils pouvaient se permettre. Si le protocole central avait exigé des garanties strictes de chaque réseau sur le chemin, l'adoption aurait stagné : le maillon le plus faible aurait bloqué toute la chaîne.

La fiabilité déplacée vers les extrémités

Plutôt que de construire un cœur parfaitement fiable, l'Internet a repoussé la fiabilité vers les hôtes (les dispositifs aux extrémités). Si une application a besoin de correction — transferts de fichiers, paiements ou chargement d'une page — elle peut utiliser des protocoles et de la logique aux bords pour détecter les pertes et récupérer :

- retransmettre les données manquantes ;

- réordonner les paquets ;

- vérifier l'intégrité et l'exhaustivité.

TCP en est l'exemple classique : il transforme un service de paquets non fiable en un flux fiable en faisant le travail difficile aux extrémités.

Pour les équipes plateformes, IP en meilleur effort a créé une base prévisible : partout dans le monde, vous pouvez supposer le même service de base — envoyer des paquets à une adresse, et ils arrivent généralement. Cette constance a rendu possible la construction de plateformes logicielles globales qui se comportent de manière similaire à travers pays, opérateurs et matériels.

Le principe de bout en bout et ses compromis réels

Publiez sur votre domaine

Connectez un domaine personnalisé pour partager un point d'accès propre et stable.

Le principe de bout en bout est une idée trompeusement simple : garder le « cœur » du réseau aussi minimal que possible et placer l'intelligence aux extrémités — sur les appareils et dans les applications.

Pourquoi des « bords intelligents » ont accéléré le logiciel

Pour les développeurs, cette séparation a été une aubaine. Si le réseau n'a pas besoin de comprendre votre application, vous pouvez livrer de nouvelles idées sans négocier de changements avec chaque opérateur réseau.

Cette flexibilité est une des grandes raisons pour lesquelles les plateformes mondiales ont pu itérer vite : courrier, web, voix/vidéo, et plus tard les apps mobiles ont tous circulé sur la même plomberie sous‑jacente.

Les compromis : abus, sécurité et attentes QoS

Un cœur simple signifie aussi que le cœur ne vous « protège » pas par défaut. Si le réseau se contente majoritairement de transférer des paquets, il est plus simple pour des attaquants et des abuseurs d'exploiter cette ouverture pour le spam, le scan, les attaques par déni de service et la fraude.

La qualité de service est une autre tension. Les utilisateurs attendent des appels vidéo fluides et des réponses instantanées, mais la livraison en meilleur effort peut produire du jitter, de la congestion et des performances inconsistantes. L'approche bout en bout pousse beaucoup de correctifs vers le haut : logique de retry, buffering, adaptation de débit et priorisation au niveau de l'application.

Beaucoup de ce que les gens considèrent comme « l'internet » aujourd'hui est une structure ajoutée au noyau minimal : des CDN qui rapprochent le contenu des utilisateurs, le chiffrement (TLS) pour ajouter confidentialité et intégrité, et des protocoles de streaming qui adaptent la qualité aux conditions courantes. Même des capacités « réseau‑like » — protection anti‑bot, atténuation DDoS et accélération de performance — sont souvent fournies comme services de plateforme au bord plutôt que intégrées dans IP lui‑même.

Adressage, routage et DNS : rendre un réseau global utilisable

Un réseau ne devient « global » que lorsque chaque dispositif peut être atteint de manière suffisamment fiable, sans que chaque participant doive connaître tous les autres. C'est le rôle de l'adressage, du routage et du DNS : trois idées qui transforment un tas de réseaux connectés en quelque chose que les humains (et les logiciels) peuvent vraiment utiliser.

Adressage vs routage (version simple)

Une adresse est un identifiant qui indique où se trouve quelque chose. Avec IP, ce « où » s'exprime sous une forme numérique structurée.

Le routage est le processus qui décide comment déplacer les paquets vers cette adresse. Les routeurs n'ont pas besoin d'une carte complète de chaque machine sur Terre ; ils ont seulement besoin d'assez d'informations pour transférer le trafic étape par étape dans la bonne direction.

L'important est que les décisions de transfert peuvent être locales et rapides, tandis que le résultat global ressemble toujours à une atteignabilité mondiale.

Pourquoi la hiérarchie et l'agrégation rendent l'échelle possible

Si chaque adresse de chaque dispositif devait être listée partout, l'Internet s'effondrerait sous sa propre gestion. L'adressage hiérarchique permet de regrouper les adresses (par exemple par réseau ou fournisseur), de sorte que les routeurs peuvent conserver des routes agrégées — une entrée qui représente de nombreuses destinations.

C'est le secret peu glamour de la croissance : des tables de routage plus petites, moins de mises à jour et une coordination simplifiée entre organisations. L'agrégation explique aussi pourquoi les politiques d'allocation d'adresses IP importent : elles influencent directement le coût opérationnel pour garder le système global cohérent.

DNS : convivialité pour les humains, flexibilité pour les plateformes

Les humains ne veulent pas taper des nombres, et les services ne veulent pas être liés en permanence à une seule machine. DNS (Domain Name System) est la couche de nommage qui mappe des noms lisibles (api.example.com) vers des adresses IP.

Pour les équipes plateformes, DNS est plus qu'une commodité :

- Il permet une base d'utilisateurs mondiale en dirigeant les utilisateurs vers des régions proches.

- Il aide les services distribués à bouger et à scaler sans changer la configuration des clients.

- Il active les applications multi‑régions et les stratégies de bascule où le nom reste stable tandis que l'infrastructure change.

En d'autres termes, l'adressage et le routage rendent l'Internet atteignable ; le DNS le rend utilisable — et opérationnellement adaptable — à l'échelle des plateformes.

Standards ouverts et interopérabilité : le volant d'inertie derrière l'adoption

Économisez grâce aux crédits gagnés

Obtenez des crédits en partageant ce que vous avez construit ou en parrainant d'autres développeurs.

Un protocole ne devient « l'Internet » que lorsque beaucoup de réseaux et de produits indépendants peuvent l'utiliser sans demander la permission. L'un des choix les plus intelligents autour de TCP/IP n'était pas seulement technique — il était social : publier les spécifications, inviter la critique et laisser quiconque les implémenter.

RFC : publier la recette

La série Request for Comments (RFC) a transformé des idées réseau en documents partagés et citables. Plutôt que d'avoir un standard boîte noire contrôlé par un seul fournisseur, les RFC rendaient les règles visibles : ce que signifie chaque champ, quoi faire dans les cas limites et comment rester compatible.

Cette ouverture a fait deux choses. D'abord, elle a réduit le risque pour les adopteurs : universités, gouvernements et entreprises pouvaient évaluer la conception et s'y conformer. Ensuite, elle a créé un point de référence commun, si bien que les désaccords pouvaient se régler par des mises à jour du texte plutôt que par des négociations privées.

L'interopérabilité débloque des écosystèmes

L'interopérabilité rend réel le « multi‑vendeur ». Quand différents routeurs, systèmes d'exploitation et applications peuvent échanger du trafic de façon prévisible, les acheteurs ne sont pas piégés. La compétition passe de « à quel réseau pouvez‑vous vous connecter ? » à « quel produit est meilleur ? » — ce qui accélère l'amélioration et réduit les coûts.

La compatibilité crée aussi des effets de réseau : chaque nouvelle implémentation TCP/IP augmente la valeur du réseau, car elle peut parler à tout le reste. Plus d'utilisateurs attirent plus de services ; plus de services attirent plus d'utilisateurs.

Les limites : les standards demandent du travail

Les standards ouverts n'éliminent pas les frictions — ils les redistribuent. Les RFC impliquent débat, coordination et parfois des évolutions lentes, surtout quand des milliards de dispositifs dépendent déjà du comportement actuel. L'avantage est que le changement, lorsqu'il survient, est lisible et largement implémentable — préservant le bénéfice central : tout le monde peut encore se connecter.

Quand on parle de « plateforme », on entend souvent un produit sur lequel d'autres construisent : applications tierces, intégrations et services qui s'exécutent sur des rails partagés. Sur Internet, ces rails ne sont pas le réseau privé d'une seule entreprise — ce sont des protocoles communs que n'importe qui peut implémenter.

TCP/IP n'a pas créé le web, le cloud ou les app stores à lui seul. Il a fourni une fondation stable et universelle où ces choses pouvaient se propager.

Une fois que les réseaux pouvaient s'interconnecter via IP et que les applications pouvaient compter sur TCP pour la livraison, il est devenu pratique de standardiser des briques de plus haut niveau :

- Le web (HTTP + navigateurs) : un client peut atteindre de nombreux serveurs, n'importe où.

- Les API : les services peuvent exposer des fonctions sur le réseau de manière prévisible.

- SaaS et cloud : le logiciel est passé de « installé localement » à « livré sur le réseau », parce que le réseau était suffisamment consistant pour fonder un modèle économique.

- Écosystèmes d'apps et marketplaces : distribution, mises à jour et intégrations sont devenues des attentes normales.

Le cadeau de TCP/IP à l'économie des plateformes fut la prévisibilité : on pouvait construire une fois et atteindre de nombreux réseaux, pays et types d'appareils sans renégocier la connectivité à chaque fois.

Des protocoles stables réduisent le coût du changement

Une plateforme croît plus vite quand utilisateurs et développeurs sentent qu'ils peuvent partir — ou au moins ne sont pas piégés. Les protocoles ouverts et largement implémentés réduisent les coûts de changement parce que :

- Les utilisateurs peuvent changer de fournisseur tout en gardant des outils familiers (le courrier électronique est l'exemple classique).

- Les développeurs peuvent réutiliser compétences et code entre fournisseurs (une requête reste une requête).

- Les nouveaux entrants peuvent interopérer au lieu de repartir de zéro.

Cette interopérabilité « sans permission » explique pourquoi des marchés logiciels mondiaux se sont formés autour de standards partagés plutôt que d'un unique propriétaire de réseau.

Exemples rapides de briques activées par les protocoles

- HTTP a rendu « récupérer une ressource depuis n'importe où » comportement par défaut pour les logiciels.

- TLS a ajouté confidentialité et intégrité, permettant le commerce et l'identité à grande échelle.

- SMTP a transformé le courrier électronique en système inter‑fournisseurs, pas en jardin clos.

Ces protocoles reposent sur TCP/IP, mais tous dépendent de la même idée : si les règles sont stables et publiques, les plateformes peuvent rivaliser sur le produit sans casser la capacité à se connecter.

Réalité de l'échelle : congestion, latence et besoin de résilience

La magie d'Internet est qu'il fonctionne à travers les océans, les réseaux mobiles, les hotspots Wi‑Fi et les routeurs de bureau surchargés. La vérité moins magique : il opère toujours sous contraintes. La bande passante est limitée, la latence varie, des paquets sont perdus ou réordonnés, et la congestion peut apparaître soudainement quand beaucoup de monde partage le même chemin.

Les contraintes auxquelles vous ne pouvez pas échapper

Même si votre service est « cloud », vos utilisateurs l'expérimentent à travers le goulot d'étranglement le plus étroit du chemin vers eux. Un appel vidéo sur fibre et le même appel dans un train bondé ne sont pas le même produit, parce que la latence (délai), le jitter (variation) et la perte façonnent la perception utilisateur.

Le contrôle de congestion, conceptuellement

Quand trop de trafic frappe les mêmes liaisons, des files se forment et des paquets tombent. Si chaque émetteur réagit en envoyant encore plus (ou en réessayant trop agressivement), le réseau peut basculer vers un effondrement par congestion — beaucoup de trafic, peu de livraison utile.

Le contrôle de congestion regroupe les comportements qui gardent le partage équitable et stable : sonder la capacité disponible, ralentir quand la perte/la latence indique une surcharge, puis reprendre prudemment. TCP a popularisé ce rythme « recule, puis récupère » pour que le réseau reste simple pendant que les extrémités s'adaptent.

Parce que les réseaux sont imparfaits, les applications à succès font discrètement du travail supplémentaire :

- Cache pour éviter des allers-retours coûteux (CDN, caches locaux, réponses d'API mémorisées).

- Retries avec timeouts pour récupérer des pertes — mais pas immédiatement et pas indéfiniment.

- Backoff exponentiel pour qu'un service en difficulté ne soit pas frappé plus fort pendant un incident.

Concevez comme si le réseau allait tomber, brièvement et souvent :

- Rendez les opérations idempotentes pour que les retries n'engendrent pas d'achats ou de messages en double.

- Favorisez la dégradation élégante (contenu obsolète, qualité réduite) plutôt que l'échec total.

- Instrumentez les percentiles de latence et les taux d'erreur par région/type de réseau, pas seulement des moyennes.

La résilience n'est pas une fonctionnalité additionnelle — c'est le prix à payer pour opérer à l'échelle d'Internet.

Sécurité et confiance : ce que les hypothèses initiales ont raté

Faites entrer votre équipe

Avancez plus vite ensemble avec des projets partagés et des déploiements reproductibles.

TCP/IP a réussi parce qu'il a rendu facile pour n'importe quel réseau de se connecter à n'importe quel autre. Le coût caché de cette ouverture est que n'importe qui peut aussi vous envoyer du trafic — bon ou mauvais.

La connectivité ouverte facilite aussi les abus

La conception initiale d'Internet présumait une communauté relativement petite et orientée recherche. Quand le réseau est devenu public, la même philosophie « transmettez les paquets » a permis le spam, la fraude, la distribution de malware, les attaques par déni de service et l'usurpation d'identité. IP ne vérifie pas qui vous êtes. Le courrier (SMTP) n'exigeait pas la preuve que vous possédiez l'adresse dans le champ “From”. Et les routeurs n'étaient pas conçus pour juger l'intention.

La sécurité est passée d'optionnelle à fondamentale

À mesure que l'Internet devenait une infrastructure critique, la sécurité a cessé d'être une fonctionnalité qu'on pouvait greffer et est devenue une exigence de conception : identité, confidentialité, intégrité et disponibilité ont besoin de mécanismes explicites. Le réseau est resté majoritairement en meilleur effort et neutre, mais les applications et plateformes ont dû partir du principe que le lien est non fiable.

Atténuations construites au‑dessus (brièvement)

Nous n'avons pas « réparé » IP en le transformant en policier de chaque paquet. À la place, la sécurité moderne est empilée au‑dessus :

- Chiffrement (p.ex. TLS/HTTPS) pour empêcher l'écoute et la falsification ;

- Authentification (certificats, tokens signés, MFA) pour prouver les identités ;

- Zero trust pour éviter la confiance automatique basée sur l'emplacement réseau.

Considérez le réseau comme hostile par défaut. Appliquez le principe du moindre privilège partout : scopes étroits, identifiants courts, et paramètres par défaut sûrs. Vérifiez identités et entrées à chaque frontière, chiffrez en transit et concevez pour les cas d'abus — pas seulement pour les scénarios heureux.

L'Internet n'a pas « gagné » parce que chaque réseau s'est mis d'accord sur le même matériel, le même fournisseur ou l'ensemble de fonctionnalités parfait. Il a perduré parce que des choix de protocole clés ont facilité la connexion d'instances indépendantes, leur amélioration et leur continuité même quand des parties échouent.

Décisions de conception à reproduire

Mise en couches avec des coutures claires. TCP/IP a séparé « déplacer des paquets » et « rendre les applications fiables ». Cette frontière a permis au réseau de rester polyvalent tandis que les apps évoluaient vite.

Simplicité au cœur. La livraison en meilleur effort a signifié que le réseau n'avait pas à comprendre chaque besoin applicatif. L'innovation est venue aux bords, où de nouveaux produits pouvaient être lancés sans négociation centrale.

Interopérabilité d'abord. Des spécifications ouvertes et un comportement prévisible ont permis à différentes organisations de construire des implémentations compatibles — créant une boucle d'adoption qui se renforce.

Traduire cela en stratégie produit

Si vous construisez une plateforme, considérez l'interconnexion comme une fonctionnalité, pas un effet secondaire. Préférez un petit ensemble de primitives que beaucoup d'équipes peuvent composer plutôt qu'un grand nombre de fonctionnalités « intelligentes » qui verrouillent les utilisateurs dans une voie.

Concevez pour l'évolution : supposez que des clients seront anciens, que des serveurs seront nouveaux, et que certaines dépendances seront partiellement indisponibles. Votre plateforme doit se dégrader élégamment et rester utile.

Si vous utilisez un environnement de construction rapide comme Koder.ai, les mêmes principes se manifestent en capacités produit : une étape de planification claire (pour que les interfaces soient explicites), une itération sûre via snapshots/rollback, et un comportement de déploiement/hébergement prévisible qui permet à plusieurs équipes d'avancer vite sans casser les consommateurs.

- APIs : Gardez un noyau stable ; ajoutez des capacités optionnelles sans casser les anciens clients.

- Compatibilité : Versionnez délibérément ; évitez de supprimer des champs/comportements ; documentez les garanties.

- Comportement en cas d'échec : Timeouts, retries avec backoff, clés d'idempotence et codes d'erreur clairs.

- Interopérabilité : Publiez des schémas/spécifications ; fournissez des implémentations de référence et des tests de conformité.

- Observabilité : IDs de corrélation, logs structurés et SLOs qui reflètent l'expérience utilisateur.

- Contrôle des changements : Fenêtres de dépréciation, feature flags et guides de migration.

Lectures suivantes

- /blog/api-design-basics

- /blog/platform-strategy

- /blog/versioning-and-backward-compatibility

- /blog/graceful-degradation-patterns