Ce que signifient vraiment « vibe coding » et « durcir pour la production »

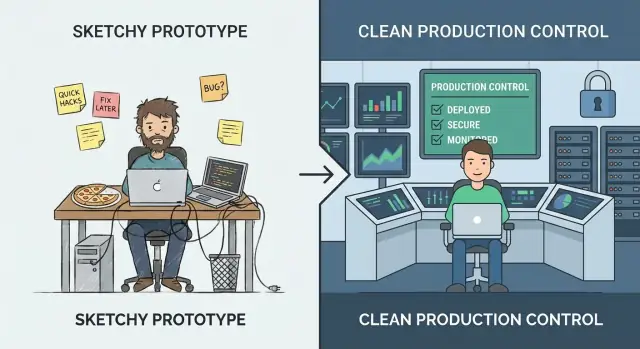

« Vibe coding » est la phase où la vitesse prime sur la précision. Vous expérimentez, apprenez ce que veulent vraiment les utilisateurs et essayez des idées qui pourraient ne pas survivre à la semaine. L'objectif est l'information : valider un flux, prouver une proposition de valeur, ou confirmer que les données dont vous avez besoin existent. Dans ce mode, les bords rugueux sont normaux : étapes manuelles, gestion d'erreurs faible, et code optimisé pour arriver vite à « ça marche ».

« Durcir pour la production » est différent. C'est le travail de rendre le comportement prévisible sous une utilisation réelle : entrées désordonnées, pannes partielles, pics de trafic, et des gens qui font des choses inattendues. Le durcissement consiste moins à ajouter des fonctionnalités qu'à réduire les surprises — pour que le système échoue en sécurité, récupère proprement, et soit compréhensible par la prochaine personne qui doit l'opérer.

Passer trop tôt vs. trop tard

Si vous durcissez trop tôt, vous pouvez ralentir l'apprentissage. Vous pouvez investir dans la scalabilité, l'automatisation, ou une architecture raffinée pour une direction produit qui change la semaine suivante. C'est coûteux, et ça peut bloquer une petite équipe.

Si vous durcissez trop tard, vous créez du risque. Les mêmes raccourcis acceptables pour une démo deviennent des incidents visibles par les clients : incohérences de données, failles de sécurité, et indisponibilités qui nuisent à la confiance.

Vous n'avez pas à choisir l'un pour toujours

Une approche pratique est de continuer à expérimenter tout en durcissant la « thin waist » du système : les quelques chemins clés qui doivent être fiables (inscription, paiements, écritures de données, intégrations critiques). Vous pouvez encore itérer rapidement sur les fonctionnalités périphériques — ne laissez simplement pas les hypothèses du prototype gouverner les parties dont les utilisateurs dépendent quotidiennement.

C'est aussi là que les choix d'outils comptent. Les plateformes conçues pour l'itération rapide peuvent vous aider à rester en mode « vibe » sans perdre la capacité de professionnaliser plus tard. Par exemple, Koder.ai est conçu pour le vibe‑coding via chat pour créer des apps web, backends et mobiles, mais il supporte aussi l'export du code source, le déploiement/hosting, les domaines personnalisés, et les snapshots/rollback — des fonctionnalités qui correspondent directement à l'état d'esprit « thin waist » (ship fast, but protect critical paths and recover quickly).

Un modèle de maturité simple : de la démo au fiable

Le vibe coding brille quand vous cherchez à apprendre rapidement : cette idée peut‑elle fonctionner ? L'erreur est de supposer que les mêmes habitudes tiendront une fois que de vraies personnes (ou de vrais processus métier) dépendront du résultat.

Les étapes par lesquelles la plupart des équipes passent

Une façon utile de décider quoi durcir est de nommer l'étape où vous êtes :

- Idée : exploration de faisabilité ; le code jetable est acceptable.

- Démo : preuve exécutable/cliquer ; le succès est « ça montre le concept ».

- Pilote : petit flux réel ; le succès est « ça aide quelques personnes de façon fiable ».

- Beta : accès plus large ; le succès est « ça marche la plupart du temps, avec support ».

- Production : outil par défaut pour un travail ; le succès est « c'est fiable, sûr et maintenable ».

En avançant vers la droite, la question passe de « Ça marche ? » à « Pouvons‑nous y faire confiance ? » Cela ajoute des attentes comme des performances prévisibles, une gestion d'erreurs claire, une traçabilité, et la capacité à revenir en arrière sur des changements. Cela vous force aussi à définir la responsabilité : qui est en faute quand quelque chose casse ?

La courbe de coût que personne n'aime

Les bugs corrigés pendant l'idée/la démo sont peu coûteux parce que vous changez du code dont personne ne dépend. Après le lancement, le même bug peut déclencher du temps de support, du nettoyage de données, de la perte de clients, ou des délais manqués. Le durcissement n'est pas du perfectionnisme — c'est réduire le rayon d'explosion des erreurs inévitables.

« Production » n'est pas seulement orienté client

Un outil interne qui génère des factures, oriente des leads, ou contrôle l'accès est déjà en production si le business en dépend. Si une panne arrête le travail, expose des données, ou crée un risque financier, traitez‑le comme de la production — même si seulement 20 personnes l'utilisent.

Signaux que vous avez dépassé la phase prototype

Un prototype peut être fragile. Il prouve une idée, débloque une conversation, et vous aide à apprendre vite. Le moment où de vraies personnes s'y fient, le coût des « quick fixes » augmente — et les risques passent d'incommodants à impactant pour le business.

Les signaux les plus clairs à surveiller

Votre audience change. Si le nombre d'utilisateurs augmente régulièrement, que vous avez ajouté des clients payants, ou que vous avez signé quoi que ce soit avec des attentes d'uptime/réponse, vous n'expérimentez plus — vous fournissez un service.

Les données deviennent plus sensibles. Le jour où votre système touche des PII (noms, emails, adresses), des données financières, des identifiants, ou des fichiers privés, il vous faut des contrôles d'accès renforcés, des traces d'audit, et des valeurs par défaut plus sûres. Un prototype peut être « suffisamment sûr pour une démo ». Les données réelles ne le peuvent pas.

L'usage devient routinier ou critique. Quand l'outil fait partie du flux quotidien d'une personne — ou quand les pannes bloquent des commandes, des reportings, l'onboarding, ou le support client — l'indisponibilité et les cas limites bizarres cessent d'être acceptables.

D'autres équipes dépendent de vos sorties. Si des équipes internes construisent des processus autour de vos dashboards, exports, webhooks, ou APIs, chaque changement devient un risque de rupture. Vous subirez la pression de garder le comportement cohérent et de communiquer les changements.

Les pannes se répètent. Un flux constant de messages « ça a planté », de pings Slack, et de tickets support indique fortement que vous passez plus de temps à réagir qu'à apprendre. C'est votre signal pour investir dans la stabilité plutôt que dans de nouvelles fonctionnalités.

Un contrôle rapide intuitif

Si une panne d'une heure serait embarrassante, vous vous approchez de la production. Si elle serait coûteuse — perte de revenus, promesses rompues, ou confiance endommagée — vous y êtes déjà.

Décidez sur la base du risque, pas de l'ambiance

Si vous vous disputez sur la « prêtitude » de l'app, vous posez déjà la mauvaise question. La meilleure question est : quel est le coût d'avoir tort ? Le durcissement pour la production n'est pas un badge d'honneur — c'est une réponse au risque.

Commencez par définir l'« échec » en termes simples

Notez ce à quoi ressemble un échec pour votre système. Catégories communes :

- Indisponibilité : le service ne peut pas être utilisé du tout

- Résultats incorrects : il tourne, mais produit des sorties erronées (souvent pire que l'indisponibilité)

- Réponses lentes : les utilisateurs abandonnent, les automatisations expirent, les tickets support montent

Soyez précis. « La recherche prend 12 secondes pour 20% des utilisateurs en pic » est exploitable ; « problèmes de perf » ne l'est pas.

Estimez l'impact business (même approximativement)

Vous n'avez pas besoin de chiffres parfaits — utilisez des fourchettes.

- Chiffre d'affaires : ventes perdues, renouvellements manqués, pénalités SLA

- Churn et confiance : les utilisateurs ne reviennent pas après une mauvaise expérience

- Perte de productivité : équipes internes bloquées, contournements manuels

- Conformité : constats d'audit, ruptures contractuelles, obligations de reporting

Si l'impact est difficile à quantifier, demandez : Qui est appelé ? Qui s'excuse ? Qui paie ?

Listez les risques principaux que vous portez

La plupart des échecs prototype→production se regroupent en quelques catégories :

- Perte ou corruption de données (pas de backups, migrations dangereuses, contrôles d'accès faibles)

- Failles de sécurité (tokens exposés, permissions trop larges, endpoints exposés)

- Automatisations incorrectes (actions LLM ou scripts qui font la mauvaise modification à grande échelle)

Classez les risques par probabilité × impact. Cela devient votre feuille de route de durcissement.

Choisissez un objectif de fiabilité “suffisant” pour votre stade

Évitez la perfection. Choisissez un objectif correspondant aux enjeux actuels — par ex. « disponibilité heures ouvrables », « 99% de succès pour les workflows critiques », ou « restauration sous 1 heure ». À mesure que l'usage et la dépendance augmentent, montez la barre délibérément plutôt que de réagir dans la panique.

La préparation à la production commence par la responsabilité et le périmètre

Le durcissement échoue souvent pour une raison simple : personne ne peut dire qui est responsable du système de bout en bout, et personne ne peut dire ce que « fait » veut dire.

Avant d'ajouter des limites de débit, des tests de charge, ou une nouvelle pile de logging, verrouillez deux bases : la responsabilité et le périmètre. Elles transforment un projet d'ingénierie ouvert en un ensemble gérable d'engagements.

Nommez un propriétaire (end‑to‑end)

Notez qui possède le système de bout en bout — pas seulement le code. Le propriétaire est responsable de la disponibilité, de la qualité des données, des releases, et de l'impact utilisateur. Cela ne veut pas dire qu'il fait tout ; cela veut dire qu'il prend les décisions, coordonne le travail, et s'assure que quelqu'un est en point quand ça tourne mal.

Si la propriété est partagée, nommez quand même un primaire : une personne/équipe qui peut dire “oui/non” et garder les priorités cohérentes.

Définissez d'abord les chemins critiques

Identifiez les parcours utilisateurs primaires et les chemins critiques. Ce sont les flux où la faille crée un vrai dommage : signup/login, checkout, envoi d'un message, import de données, génération de rapport, etc.

Une fois ces chemins identifiés, vous pouvez durcir sélectivement :

- Fixer des objectifs de fiabilité autour de ces chemins en premier.

- Décider quelles données ne doivent jamais être perdues.

- Choisir quelques métriques qui définissent le « fonctionnement ».

Fixez le périmètre pour éviter un durcissement sans fin

Documentez ce qui est dans le périmètre maintenant vs. plus tard pour éviter une course au durcissement. La préparation production n'est pas « logiciel parfait » ; c'est « assez sûr pour ce public, avec des limites connues ». Soyez explicite sur ce que vous ne supportez pas encore (régions, navigateurs, trafic de pointe, intégrations).

Commencez un squelette de runbook

Créez un squelette de runbook léger : comment déployer, revenir en arrière, déboguer. Gardez‑le court et utilisable à 2h du matin — une checklist, dashboards clés, modes de panne fréquents, et qui contacter. Vous pouvez l'affiner, mais vous ne pouvez pas l'improviser pendant le premier incident.

Fiabilité : rendre le système prévisible sous charge

La fiabilité ne vise pas à rendre les pannes impossibles — elle vise à rendre le comportement prévisible quand ça tourne mal ou que ça s'alourdit. Les prototypes fonctionnent souvent « sur ma machine » parce que le trafic est faible, les entrées sont amicales, et personne n'envoie des requêtes massives au même endpoint.

Mettez des garde‑fous sur chaque requête

Commencez par des défenses ennuyeuses mais efficaces :

- Validation des entrées aux frontières (API, formulaires UI, payloads webhook). Rejetez les mauvaises données tôt avec un message d'erreur clair.

- Timeouts partout où vous appelez quelque chose de lent ou externe (BD, APIs tierces, queues). Un timeout manquant transforme un petit hic en effet boule de neige.

- Réessais, avec précaution : ne réessayez que les opérations sûres, utilisez backoff exponentiel + jitter, et limitez les tentatives. Les réessais aveugles peuvent amplifier les pannes.

- Circuit breakers pour arrêter d'appeler des dépendances en panne et récupérer automatiquement quand elles se stabilisent.

Échouer en sécurité et de façon visible

Quand le système ne peut pas faire le travail complet, il doit faire au moins le travail le plus sûr. Cela peut signifier servir une valeur mise en cache, désactiver une fonctionnalité non critique, ou renvoyer une réponse « réessayez » avec un ID de requête. Préférez la dégradation gracieuse plutôt que des écritures partielles silencieuses ou des erreurs génériques confuses.

Concurrence et idempotence ne sont pas optionnelles

Sous charge, les requêtes dupliquées et les jobs qui se chevauchent arrivent (double‑clics, réessais réseau, redelivery de queue). Conceptez pour cela :

- Rendre les actions clés idempotentes (la même requête traitée deux fois donne le même résultat).

- Utiliser verrous ou concurrence optimiste quand c'est nécessaire pour empêcher les conditions de course.

Protégez l'intégrité des données

La fiabilité inclut « ne pas corrompre les données ». Utilisez transactions pour les écritures multi‑étapes, ajoutez des contraintes (clés uniques, clés étrangères), et pratiquez une discipline de migration (changements rétro‑compatibles, déploiements testés).

Faites respecter des limites de ressources

Fixez des limites sur CPU, mémoire, pools de connexions, tailles de queue, et payloads de requêtes. Sans limites, un tenant bruyant — ou une requête mal formulée — peut asphyxier tout le reste.

Sécurité : le seuil minimum avant les vrais utilisateurs

Le durcissement de la sécurité ne transforme pas votre prototype en forteresse. Il signifie atteindre un standard minimal où une erreur normale — un lien exposé, un token fuit, un utilisateur curieux — ne devient pas un incident impactant pour les clients.

Commencez par la séparation : dev, staging, prod

Si vous avez « un seul environnement », vous avez un seul rayon d'explosion. Créez des setups dev/staging/prod séparés avec le moins de secrets partagés possible. Le staging doit être assez proche de la production pour révéler des problèmes, mais il ne doit pas réutiliser des identifiants de production ni des données sensibles.

Authentification et autorisation (authn/authz)

Beaucoup de prototypes s'arrêtent à « la connexion marche ». La production nécessite le moindre privilège :

- Définir des rôles clairs (par ex. admin, support, utilisateur standard) et faire respecter les limites côté serveur.

- Verrouiller les outils internes et endpoints d'administration.

- Conserver des traces d'audit pour les actions sensibles (connexion, reset de mot de passe, changements de rôle, exports, suppressions). Vous n'avez pas besoin d'analytics parfaits — juste de quoi répondre à « qui a fait quoi, et quand ? »

Gestion des secrets : sortir les clés du code et des logs

Déplacez clés API, mots de passe DB, et secrets de signature dans un gestionnaire de secrets ou des variables d'environnement sécurisées. Puis assurez‑vous qu'ils ne peuvent pas fuir :

- N'imprimez pas de tokens dans les logs d'application.

- Évitez d'envoyer des secrets au code client.

- Faites pivoter tout identifiant jamais committé dans un repo.

Menaces à prioriser tôt

Traitez quelques vecteurs de panne courants pour un meilleur rapport effort/valeur :

- Injection (SQL/commande) : utilisez des requêtes paramétrées et des librairies sûres.

- Contrôle d'accès cassé : vérifiez les permissions sur chaque requête, pas seulement dans l'UI.

- Exposition de données : chiffrez en transit, limitez les données renvoyées par défaut, et évitez des exports trop larges.

Plan de patching pour les dépendances

Décidez qui possède les mises à jour et à quelle fréquence vous patcherez dépendances et images de base. Un plan simple (vérification hebdo + upgrades mensuels, correctifs urgents sous 24–72h) vaut mieux que « on le fera plus tard ».

Tests : attraper les ruptures avant les clients

Les tests transforment « ça marche sur ma machine » en « ça continue de marcher pour les clients ». L'objectif n'est pas une couverture parfaite — c'est la confiance dans les comportements dont la rupture serait la plus coûteuse : facturation, intégrité des données, permissions, workflows clés, et tout ce qui est difficile à déboguer une fois déployé.

Une pyramide de tests qui colle à la réalité

Une pyramide pratique ressemble souvent à :

- Tests unitaires pour la logique pure (rapides, nombreux)

- Tests d'intégration pour les frontières (BD, queues, APIs tierces derrière des mocks)

- Tests E2E pour quelques parcours utilisateurs critiques (lents, garder les scénarios minimaux)

Si votre app est surtout API + base de données, penchez plus sur les tests d'intégration. Si elle est très UI, conservez un petit ensemble d'E2E qui reflètent comment les utilisateurs réussissent (et échouent).

Tests de régression là où ça fait mal

Quand un bug coûte du temps, de l'argent, ou de la confiance, ajoutez un test de régression immédiatement. Priorisez des comportements tels que « un client ne peut pas payer », « un job double facture », ou « une mise à jour corrompt des enregistrements ». Cela crée un filet de sécurité croissant autour des zones à risque élevé plutôt que de disperser des tests partout.

Tests d'intégration répétables avec données seedées

Les tests d'intégration doivent être déterministes. Utilisez fixtures et données seedées pour que les runs de test ne dépendent pas de la BD locale d'un dev. Réinitialisez l'état entre les tests et gardez les jeux de données petits mais représentatifs.

Vous n'avez pas besoin d'un programme complet de load testing encore, mais vous devriez avoir des vérifications de perf rapides pour les endpoints et jobs clés. Un simple test smoke basé sur des seuils (par ex. p95 sous X ms avec petite concurrence) détecte les régressions évidentes tôt.

Automatiser les vérifications dans le CI

Chaque changement doit déclencher des gardes automatiques :

- linting et format

- vérifications de types (si applicable)

- suite unit + integration

- scans de sécurité basiques (dépendances/vulnérabilités)

Si les tests ne s'exécutent pas automatiquement, ils deviennent optionnels — et la production finira par le prouver.

Observabilité : savoir ce qui se passe sans deviner

Quand un prototype casse, vous pouvez souvent « réessayer ». En production, ce tâtonnement devient indisponibilité, churn, et nuits blanches. L'observabilité raccourcit le temps entre « quelque chose cloche » et « voilà exactement ce qui a changé, où, et qui est impacté ».

Commencez par des logs qui répondent aux vraies questions

Loggez ce qui compte, pas tout. Vous voulez assez de contexte pour reproduire un problème sans déverser des données sensibles.

- Incluez un request ID sur chaque requête et transmettez‑le dans le système.

- Ajoutez des identifiants utilisateur/session en sécurité (hachés ou IDs internes ; jamais mots de passe ou données de paiement en clair).

- Enregistrez les résultats : succès/échec, codes de statut, et raisons d'erreur significatives.

Une bonne règle : chaque log d'erreur doit rendre évident ce qui a échoué et quoi vérifier ensuite.

Mesurez les “golden signals”

Les métriques donnent le pouls en direct. Au minimum, suivez les golden signals :

- Latence (à quel point c'est lent)

- Erreurs (à quel point c'est cassé)

- Trafic (combien)

- Saturation (à quel point c'est proche de la capacité)

Ces métriques vous aident à distinguer « plus d'utilisateurs » de « quelque chose cloche ».

Ajoutez du tracing quand les requêtes traversent des limites

Si une action utilisateur déclenche plusieurs services, queues, ou appels tiers, le tracing transforme un mystère en chronologie. Même un tracing distribué basique montre où le temps est passé et quelle dépendance échoue.

Les alertes doivent être actionnables, pas bruyantes

Le spam d'alertes habitue les gens à les ignorer. Définissez :

- Quelles conditions méritent un paging (impact visible utilisateur)

- Qui est en on‑call et les temps de réponse attendus

- À quoi ressemble le « bon » (seuils liés aux SLAs/SLOs)

Un dashboard qui répond aux trois grandes questions

Construisez un dashboard simple qui répond instantanément : Ça tombe ? C'est lent ? Pourquoi ? S'il ne peut pas répondre à ça, c'est de la décoration — pas des opérations.

Release et opérations : déployer sans drame

Le durcissement n'est pas que de la qualité de code — c'est aussi comment vous changez le système une fois que des gens dépendent de lui. Les prototypes tolèrent « push to main et croiser les doigts ». La production non. Les pratiques de release et d'opérations transforment le shipping en activité routinière plutôt qu'en événement à hauts risques.

Standardisez builds et déploiements (CI/CD)

Rendez les builds et déploiements répétables, scriptés, et ennuyeux. Un pipeline CI/CD simple doit : exécuter des vérifs, construire l'artifact de la même manière à chaque fois, déployer vers un environnement connu, et enregistrer exactement ce qui a changé.

Le gain est la consistance : vous pouvez reproduire une release, comparer deux versions, et éviter les surprises « marche sur ma machine ».

Utilisez des feature flags pour déployer en sécurité

Les feature flags vous permettent de séparer déploiement (mettre le code en production) de release (l'activer pour les utilisateurs). Ainsi vous pouvez livrer des petits changements fréquemment, les activer graduellement, et les couper vite si ça tourne mal.

Gardez la discipline : nommez clairement les flags, définissez des propriétaires, et supprimez‑les quand l'expérimentation est terminée. Les « flags mystères » permanents deviennent un risque opérationnel.

Définir le rollback — et s'entraîner

Une stratégie de rollback n'est réelle que si vous l'avez testée. Décidez ce que « rollback » signifie pour votre système :

- Redeployer la version précédente ?

- Désactiver un feature flag ?

- Avancer avec un correctif ?

- Restaurer les données depuis des backups (lent, risqué, parfois nécessaire) ?

Ensuite répétez en environnement sûr. Chronométrez la durée et documentez les étapes exactes. Si le rollback nécessite un expert en vacances, ce n'est pas une stratégie.

Si vous utilisez une plateforme qui supporte déjà la réversion sûre, profitez‑en. Par exemple, les snapshots et le workflow de rollback de Koder.ai peuvent faire du « arrêter l'hémorragie » une action reproductible de premier ordre tout en gardant l'itération rapide.

Versionnez les APIs et consignez les changements de schéma

Quand d'autres systèmes ou clients dépendent de vos interfaces, les changements ont besoin de garde‑fous.

Pour les APIs : introduisez un versioning (même simple /v1) et publiez un changelog pour que les consommateurs sachent ce qui change et quand.

Pour les changements de données/schéma : traitez‑les comme des releases à part entière. Privilégiez des migrations rétro‑compatibles (ajouter des champs avant d'en retirer), et documentez‑les aux côtés des releases applicatives.

Bases de capacité : quotas, limites, seuils de scaling

« Tout marchait hier » casse souvent parce que le trafic, les jobs batch, ou l'usage client ont augmenté.

Mettez en place des protections et attentes basiques :

- Quotas et limits pour empêcher un tenant/utilisateur d'étrangler le système

- Seuils de scaling clairs (CPU, profondeur de queue, latence) qui déclenchent une action

- Un plan léger pour ce qu'on fait en atteignant les limites (throttle, shed load, ou scale)

Bien fait, la discipline release/ops rend le shipping sûr — même quand vous allez vite.

Incidents : préparez le premier mauvais jour

Les incidents sont inévitables dès que des utilisateurs réels dépendent de votre système. La différence entre « une mauvaise journée » et « une journée mettant l'entreprise en péril » est de savoir — avant — qui fait quoi, comment vous communiquez, et comment vous apprenez.

Une checklist d'incident légère

Gardez ceci en doc courte que tout le monde peut trouver (pin Slack, README, ou /runbooks). Une checklist pratique couvre généralement :

- Identifier : confirmer l'impact, heure de début, utilisateurs affectés, et symptômes actuels.

- Mitiger : arrêter l'hémorragie d'abord (rollback, désactiver un flag, scale up, basculer).

- Communiquer : un propriétaire poste des mises à jour à cadence fixe (par ex. toutes les 15–30 min) aux parties prenantes et, si besoin, aux clients.

- Apprendre : capturer ce qui s'est passé tant que c'est frais ; planifier un postmortem.

Postmortems sans blâme

Rédigez des postmortems qui se concentrent sur les corrections, pas la faute. Les bons postmortems produisent des actions concrètes : alerte manquante → ajouter une alerte ; propriété peu claire → assigner un on‑call ; déploiement risqué → ajouter une étape canary. Gardez le ton factuel et facilitez la contribution.

Suivez explicitement les répétitions : le même timeout chaque semaine n'est pas « pas de bol », c'est un élément du backlog. Maintenez une liste de problèmes récurrents et transformez les pires en travaux planifiés avec propriétaires et échéances.

Prudence avec les SLA/SLO

Définissez des SLA/SLO seulement quand vous êtes prêts à les mesurer et les maintenir. Si vous n'avez pas de monitoring cohérent et quelqu'un responsable de la réponse, commencez par des objectifs internes et de l'alerting basique, puis formalisez les promesses plus tard.

Une checklist décisionnelle pratique et prochaines étapes

Vous n'avez pas à durcir tout en même temps. Il faut durcir les parties qui peuvent nuire aux utilisateurs, à l'argent, ou à la réputation — et garder le reste flexible pour continuer d'apprendre.

À durcir maintenant (chemins critiques)

Si l'un de ces éléments fait partie du parcours utilisateur, traitez‑le comme un « chemin de production » et durcissez‑le avant d'étendre l'accès :

- Auth & permissions : connexion, reset mot de passe, vérifications de rôle, suppression de compte.

- Argent & engagements : facturation, remboursements, changements de plan, checkout, factures.

- Intégrité des données : écritures sur les enregistrements primaires, idempotence, migrations, backups/restore.

- Fiabilité orientée utilisateur : timeouts, réessais, limits de débit, dégradation gracieuse.

- Bases sécurité : gestion des secrets, moindre privilège, validation d'entrée, audit des actions sensibles.

- Bases opérationnelles : monitoring des SLIs clés (taux d'erreur, latence, saturation), alertes qui page une personne, runbooks pour modes de panne principaux.

Peut rester vibey (pour l'instant)

Gardez ceux‑ci plus légers tant que vous cherchez l'adéquation produit‑marché :

- Outils internes utilisés par une petite équipe formée.

- Expériences et prototypes jetables derrière des feature flags.

- Polish UI qui ne change pas les workflows cœur.

- Automatisations non critiques avec contournements manuels faciles.

Lancez un sprint de durcissement limité dans le temps

Essayez 1–2 semaines focalisées uniquement sur le chemin critique. Les critères de sortie doivent être concrets :

- Les parcours utilisateurs principaux ont des tests basiques et un run de test répétable.

- Dashboards + alerts existent pour les flux importants.

- Rollback ou déploiement sûr prouvé (même manuel).

- Risques connus sont écrits avec un propriétaire et un plan d'atténuation.

Portes simples go/no‑go

- Gate de lancement (accès limité) : « Nous pouvons détecter rapidement les pannes, arrêter l'hémorragie, et protéger les données. »

- Gate d'expansion (plus d'utilisateurs/trafic) : « Nous pouvons gérer des augmentations de charge prévisibles et récupérer d'un mauvais déploiement sans exploits héroïques. »

Un rythme soutenable

Pour éviter d'osciller entre chaos et suringénierie, alternez :

- Semaines d'expérimentation : livrez des changements pour apprendre rapidement.

- Semaines de stabilisation : résolvez les lacunes de fiabilité/sécurité/tests découvertes pendant les expérimentations.

Si vous voulez une version d'une page de ceci, transformez les bullets ci‑dessus en checklist et révisez‑la à chaque lancement ou expansion d'accès.