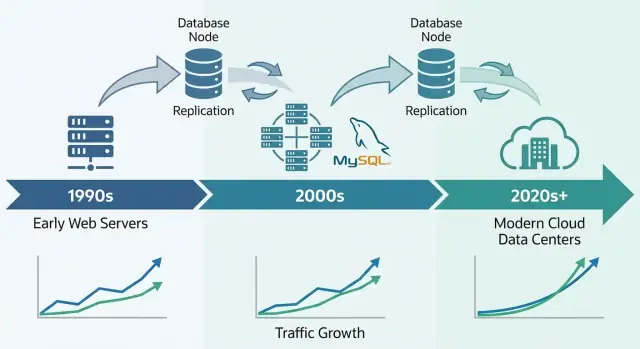

Pourquoi MySQL est devenu une base pour le web précoce

MySQL est devenu la base de données de référence du web précoce pour une raison simple : il correspondait aux besoins des sites à l'époque — stocker et récupérer des données structurées rapidement, tourner sur du matériel modeste et rester facile à exploiter pour de petites équipes.

Il était abordable. On pouvait l'installer rapidement, se connecter depuis des langages courants et faire fonctionner un site sans recruter un administrateur de base de données dédié. Ce mélange de « performance suffisante » et de faible coût opérationnel en a fait un choix par défaut pour les startups, les projets personnels et les entreprises en croissance.

Ce que « monter en charge » signifie ici

Quand on dit que MySQL a « scalé », on parle généralement d'un mélange de :

- Croissance du trafic : plus d'utilisateurs concurrents et plus de requêtes par seconde.

- Croissance des données : des tables passant de milliers de lignes à des millions ou milliards.

- Attentes de fiabilité : rester en ligne malgré les crashs, les déploiements et les pannes matérielles.

- Contraintes de coût : atteindre tout cela sans budgets réservés aux solutions d'entreprise.

Les premières entreprises web n'avaient pas besoin seulement de vitesse ; elles voulaient des performances et une disponibilité prévisibles tout en contrôlant les dépenses d'infrastructure.

Les leviers principaux que nous reverrons

L'histoire de la montée en charge de MySQL est surtout une histoire d'arbitrages pratiques et de schémas reproductibles :

- Conception du schéma et des requêtes (quoi stocker, comment joindre, ce qu'il faut éviter)

- Index (la différence entre « ça marche en dev » et « ça marche en production »)

- Mise en cache (ne pas interroger la base à chaque affichage de page)

- Réplication et réplicas de lecture (répartir la charge de lecture)

- Sharding/partitionnement (séparer les données quand une seule base ne suffit plus)

Portée de cet article

Ceci est un tour d'horizon des schémas que les équipes ont utilisés pour garder MySQL performant sous un vrai trafic web — pas un manuel complet sur MySQL. L'objectif est d'expliquer comment la base s'adaptait aux besoins du web et pourquoi ces mêmes idées réapparaissent encore dans des systèmes de production massifs aujourd'hui.

Le décollage de MySQL est intimement lié à l'essor de l'hébergement mutualisé et des petites équipes construisant des applications web rapidement. Ce n'était pas seulement que MySQL était « assez bon » — il correspondait à la façon dont le web était déployé, géré et payé.

Pourquoi LAMP correspondait à l'hébergement précoce

LAMP (Linux, Apache, MySQL, PHP/Perl/Python) fonctionnait parce qu'il s'alignait sur le serveur par défaut que beaucoup pouvaient s'offrir : une seule machine Linux exécutant un serveur web et une base de données côte à côte.

Les hébergeurs pouvaient template-r ce setup, automatiser les installations et l'offrir à bas coût. Les développeurs pouvaient supposer le même environnement de base presque partout, ce qui réduisait les surprises en passant du local à la production.

La simplicité comme stratégie de diffusion

MySQL était simple à installer, démarrer et connecter. Il parlait SQL familier, disposait d'un client en ligne de commande simple et s'intégrait proprement aux langages et frameworks populaires de l'époque.

Tout aussi important, le modèle opérationnel était accessible : un processus principal, quelques fichiers de configuration et des modes de panne clairs. Cela rendait réaliste pour des administrateurs systèmes généralistes (et souvent des développeurs) d'exploiter une base sans formation spécialisée.

Coût, accessibilité et dynamique communautaire

L'open source supprimait la friction des licences initiales. Un projet étudiant, un forum hobby et un petit site commercial pouvaient tous utiliser le même moteur que des entreprises plus grandes.

La documentation, les mailing lists et, plus tard, les tutoriels en ligne ont créé un momentum : plus d'utilisateurs signifiaient plus d'exemples, d'outils et des temps de résolution plus rapides.

Les charges précoces bien adaptées à MySQL

La plupart des premiers sites étaient orientés lecture et assez simples : forums, blogs, pages gérées par CMS et petits catalogues e‑commerce. Ces applis avaient typiquement besoin de recherches rapides par ID, des posts récents, des comptes utilisateurs et un filtrage basique — exactement le type de charge que MySQL pouvait gérer efficacement sur du matériel modeste.

Les premières pressions de montée en charge : plus d'utilisateurs, plus de lectures, plus d'écritures

Les déploiements MySQL commençaient souvent par « un serveur, une base, une appli ». Ça fonctionnait pour un forum hobby ou un petit site — jusqu'à ce que l'appli devienne populaire. Les vues se sont multipliées, les sessions sont devenues constantes, et la base n'était plus un composant discret.

Pourquoi les lectures dominent souvent

La plupart des applis web sont (et restent) orientées lecture. Une page d'accueil, une liste de produits ou une page profil peut être vue des milliers de fois pour une seule mise à jour. Ce déséquilibre a guidé les décisions de montée en charge : si vous pouvez accélérer les lectures — ou éviter d'interroger la base pour les lectures — vous pouvez servir beaucoup plus d'utilisateurs sans tout réécrire.

Le piège : même les applis très orientées lecture ont des écritures critiques. Inscription, achats, commentaires et mises à jour admin ne peuvent pas échouer. À mesure que le trafic augmente, le système doit gérer à la fois un flot de lectures et des écritures « qui doivent réussir ».

Les premières douleurs ressenties par les équipes

À trafic plus élevé, les problèmes se voyaient simplement :

- Requêtes lentes : une page qui chargeait instantanément se mettait à « bloquer » quand une requête type rapport balayait trop de lignes.

- Verrouillage des tables : avec certaines configurations anciennes, les écritures pouvaient bloquer les lectures (et inversement), créant des embouteillages.

- RAM limitée : les index et les données chaudes ne tenaient pas en mémoire, donc le serveur accédait plus souvent au disque — bien plus lent que la RAM.

Séparer les responsabilités tôt

Les équipes ont appris à répartir les responsabilités : l'appli gère la logique métier, un cache absorbe les lectures répétées, et la base se concentre sur le stockage fiable et les requêtes essentielles. Ce modèle mental a préparé les étapes suivantes : tuning des requêtes, meilleurs index et montée en charge avec des réplicas.

Moteurs de stockage : le grand tournant pour la fiabilité

Particularité de MySQL : ce n'est pas un seul « moteur » sous le capot. C'est un serveur qui peut utiliser différents moteurs de stockage pour persister les données.

Qu'est-ce qu'un moteur de stockage

À haut niveau, un moteur de stockage décide comment les lignes sont écrites sur disque, comment les index sont maintenus, comment les verrous sont gérés et ce qui se passe après un crash. Votre SQL peut rester identique, mais le moteur détermine si la base se comporte plutôt comme un carnet rapide ou comme un grand livre bancaire.

MyISAM vs InnoDB (différences en clair)

Pendant longtemps, beaucoup de setups MySQL utilisaient MyISAM. Simple et souvent rapide pour les sites orientés lecture, il avait cependant des inconvénients :

- Verrouillage : MyISAM utilise souvent des verrous au niveau table. Une écriture peut bloquer d'autres lectures/écritures de façon importante.

- Crashes : après un arrêt non propre, les tables MyISAM pouvaient nécessiter une réparation et perdre des modifications récentes.

- Transactions : MyISAM ne supporte pas les transactions, donc on ne peut pas garantir « tout réussit ou tout échoue » pour des mises à jour en plusieurs étapes.

InnoDB inverse ces hypothèses :

- Verrouillage : verrouillage au niveau ligne réduit les blocages lorsque de nombreux utilisateurs mettent à jour des lignes différentes.

- Récupération après crash : meilleure durabilité et récupération automatique.

- Transactions : support complet des transactions, rendant le comportement applicatif bien plus prévisible.

Pourquoi InnoDB est devenu le choix par défaut en production

À mesure que les applis web sont passées de simples pages lues à des logins, paniers, paiements et messageries, la correction et la récupération ont pris autant d'importance que la vitesse. InnoDB a rendu possible la montée en charge sans craindre qu'un redémarrage ou un pic de trafic corrompe les données ou bloque une table entière.

En pratique : le choix du moteur affecte performance et sécurité. Ce n'est pas un simple paramètre — votre modèle de verrouillage, le comportement en cas de panne et les garanties applicatives en dépendent.

Avant le sharding, les réplicas de lecture ou les caches élaborés, beaucoup de gains MySQL venaient d'un changement constant : rendre les requêtes prévisibles. Index et conception de requêtes ont été le premier « multiplicateur » parce qu'ils réduisent la quantité de données touchées par requête.

Index B-tree : recherches rapides vs scans complets

La plupart des index MySQL sont basés sur des B-tree. Pensez-y comme un annuaire ordonné : MySQL peut sauter à la bonne position et lire une petite tranche de données contiguës. Sans l'index adéquat, le serveur retombe souvent sur un scan ligne par ligne. À faible trafic c'est seulement lent ; à grande échelle ça amplifie le trafic — plus de CPU, plus d'I/O disque, plus de temps de verrou et plus de latence pour tout le reste.

Anti-patterns de requêtes qui pénalisent à grande échelle

Quelques patterns causaient régulièrement des échecs « ça marchait en staging » :

SELECT * : récupère des colonnes inutiles, augmente l'I/O et peut annuler les bénéfices d'un index couvrant.- Wildcard en tête :

WHERE name LIKE '%shoe' ne peut pas utiliser efficacement un index B-tree.

- Fonctions sur colonnes indexées :

WHERE DATE(created_at) = '2025-01-01' empêche souvent l'utilisation de l'index ; préférez des filtres par plage comme created_at >= ... AND created_at < ....

Faire de EXPLAIN et des slow logs des outils quotidiens

Deux habitudes ont mieux scalé que n'importe quel truc malin :

- Exécuter

EXPLAIN pour vérifier que vous utilisez l'index prévu et que vous n'effectuez pas de scan.

- Surveiller le slow query log pour attraper les régressions au fur et à mesure des déploiements.

Les index doivent correspondre aux fonctionnalités réelles

Concevez les index autour du comportement du produit :

- Recherche : envisagez du full-text ou des stratégies de préfixe plutôt que des scans wildcard.

- Flux (feeds) : des index composites comme

(user_id, created_at) rendent « derniers éléments » rapides.

- Flux de paiement : des index uniques sur identifiants de commande/paiement empêchent les doublons et accélèrent les recherches.

Un bon index n'est pas « plus d'indexes », c'est les quelques bons qui couvrent les chemins lecture/écriture critiques.

Scaling vertical vs horizontal : ce qui change et pourquoi

Gagnez des crédits en partageant

Créez du contenu ou parrainez des coéquipiers et gagnez des crédits pour continuer à construire sur Koder.ai.

Quand un produit soutenu par MySQL commence à ralentir, la première grosse décision est : augmenter la taille de la machine (vertical) ou ajouter des machines (horizontal). Ils résolvent des problèmes différents — et changent profondément votre vie opérationnelle.

Scaling vertical : le mouvement « plus grosse boîte »

La montée verticale signifie donner plus de ressources à MySQL sur une machine : CPU plus rapide, plus de RAM, meilleur stockage.

Cela marche souvent étonnamment bien parce que beaucoup de goulets sont locaux :

- CPU : requêtes complexes, tris, jointures et WHERE inefficaces peuvent saturer les cœurs.

- I/O : disques lents et lectures/écritures aléatoires dominent quand les données ne tiennent pas en mémoire.

- Pool de mémoire : avec InnoDB, plus de RAM permet de garder les données et index chauds en cache.

- Limites de connexions : trop de connexions concurrentes peuvent épuiser threads, mémoire et provoquer du contexte switching.

Le scaling vertical est souvent le gain le plus rapide : moins de pièces mobiles, modes de panne plus simples et moins de changements applicatifs. L'inconvénient : il y a toujours un plafond (et les montées ultérieures peuvent nécessiter des downtime ou des migrations risquées).

Scaling horizontal : « plus de machines », plus de coordination

Le scaling horizontal ajoute des machines. Pour MySQL, cela signifie typiquement :

- Répartir les lectures sur des réplicas

- Répartir les écritures en divisant les données (sharding) ou en restructurant les workflows

C'est plus difficile car cela introduit des problèmes de coordination : lag de réplication, comportement de basculement, compromis de cohérence, et plus d'outils opérationnels. L'application doit aussi savoir quel serveur contacter (ou vous devez ajouter une couche de proxy).

Mettre des attentes : ne pas sauter directement au sharding

La plupart des équipes n'ont pas besoin du sharding comme première étape. Commencez par confirmer où se situe le temps passé (CPU vs I/O vs contention), corrigez les requêtes lentes et les index, et ajustez la mémoire et le stockage. Le scaling horizontal paye quand une seule machine ne peut plus satisfaire votre débit d'écriture, la taille de stockage ou les exigences de disponibilité — même après un bon tuning.

Réplication et réplicas de lecture : scaler les lectures de manière pratique

La réplication est l'une des méthodes les plus pratiques qu'ont utilisées les systèmes MySQL pour absorber la croissance : au lieu de faire tout sur une seule base, on copie les données sur d'autres serveurs et on répartit la charge.

La réplication en termes simples : un primaire et des réplicas

Pensez au primaire (ou « master ») comme la base qui accepte les changements — INSERT, UPDATE, DELETE. Un ou plusieurs réplicas (anciennement « slaves ») récupèrent ces changements et les appliquent en continu, gardant une copie quasi temps réel.

Votre application peut alors :

- Envoyer les écritures au primaire

- Envoyer de nombreuses lectures aux réplicas

Ce pattern est devenu courant parce que le trafic web augmente souvent en lectures plus rapidement qu'en écritures.

À quoi servent concrètement les réplicas

Les réplicas servent à plus que l'accélération de pages :

- Scalabilité en lecture : pages produits, feeds, résultats de recherche

- Analytique et reporting : exécuter des longues requêtes sur un replica plutôt que bloquer le primaire

- Sauvegardes : faire des dumps logiques ou exécuter des outils de sauvegarde sur un replica pour réduire l'impact sur la production

Les compromis à accepter

La réplication n'est pas gratuite. Le problème le plus courant est le lag de réplication : les réplicas peuvent avoir quelques secondes (ou plus) de retard pendant les pics.

Cela soulève la question applicative clé : cohérence lire-après-écrire. Si un utilisateur met à jour son profil puis que vous lisez immédiatement depuis un replica, il peut voir l'ancienne version. Beaucoup d'équipes contournent cela en lisant depuis le primaire pour les vues « fraîches », ou en appliquant une courte fenêtre « lire depuis le primaire après écriture ».

Réplication ≠ basculement automatique

La réplication copie les données ; elle ne vous rend pas automatiquement tolérant aux pannes. Le basculement — promotion d'un replica, redirection du trafic et reconnexion sécurisée de l'app — est une capacité distincte qui nécessite des outils, des tests et des procédures opérationnelles claires.

Bases de la haute disponibilité : rester en ligne malgré les pannes

Exportez le code source à tout moment

Démarrez rapidement via le chat, puis exportez le code quand vous souhaitez avoir le contrôle total.

La haute disponibilité (HA) regroupe les pratiques qui maintiennent votre appli en fonctionnement quand un serveur de base de données plante, qu'un lien réseau tombe ou lors d'une maintenance planifiée. Les objectifs : réduire le downtime, rendre la maintenance sûre et garantir une récupération prévisible.

Patterns HA les plus courants

Les premiers déploiements MySQL commençaient souvent avec un primaire. L'HA ajoutait typiquement une seconde machine pour que la panne n'entraîne pas une longue indisponibilité.

- Primary–standby (actif–passif) : un serveur gère le trafic ; un standby est prêt à prendre le relais.

- Clusters multi-nœuds : plusieurs nœuds coopèrent pour maintenir le service disponible, souvent avec des règles plus strictes pour les écritures.

- Basculement automatisé : la surveillance détecte la panne du primaire et promeut un standby, en mettant à jour la cible de connexion de l'appli.

L'automatisation aide, mais elle augmente aussi les exigences : l'équipe doit faire confiance à la logique de détection et éviter le « split brain » (deux serveurs pensant être primaires).

RPO et RTO en langage clair

Deux métriques rendent les décisions HA moins émotionnelles :

- RPO (Recovery Point Objective) : combien de données vous pouvez vous permettre de perdre. Si un replica a 10 secondes de retard, votre RPO peut être d'environ 10 secondes.

- RTO (Recovery Time Objective) : combien de temps vous pouvez rester hors service. Cela inclut la détection, la promotion et le temps de reconnexion de l'app.

Les bases opérationnelles qui rendent l'HA réelle

L'HA n'est pas qu'une topologie — c'est de la pratique. Les sauvegardes doivent être routinières, mais la clé est de tester les restaurations : pouvez-vous réellement restaurer sur un nouveau serveur rapidement ?

Les changements de schéma comptent aussi. Les grosses altérations de table peuvent verrouiller les écritures ou ralentir les requêtes. Approches plus sûres : exécuter les changements en périodes de faible trafic, utiliser des outils de modification en ligne et toujours avoir un plan de rollback.

Bien fait, l'HA transforme les pannes en événements planifiés et répétés plutôt qu'en urgences improvisées.

Stratégies de cache qui ont gardé MySQL rapide sous trafic web

Le caching était l'un des moyens les plus simples pour les équipes web de garder MySQL réactif quand le trafic augmentait. L'idée est simple : servir les requêtes répétées depuis quelque chose de plus rapide que la base, et n'interroger MySQL que quand c'est nécessaire. Bien géré, le cache réduit fortement la charge de lecture et transforme les pics en montées douces.

Les couches de cache courantes

Cache d'application/objet stocke des « morceaux » de données demandés fréquemment — profils, détails produits, vérifications d'autorisation. Au lieu d'exécuter le même SELECT des centaines de fois par minute, l'app lit un objet précalculé par clé.

Cache de page ou fragment stocke du HTML rendu (pages complètes ou fragments comme une barre latérale). Très efficace pour les sites de contenu où plusieurs visiteurs voient les mêmes pages.

Cache de résultats de requête conserve le résultat d'une requête spécifique (ou une version normalisée). Même sans cache SQL natif, vous pouvez mettre en cache « le résultat de cet endpoint » avec une clé représentant la requête.

On utilise des magasins clé/val en mémoire, des caches HTTP ou le caching intégré des frameworks. L'outil exact importe moins que des clés cohérentes, des TTL et une responsabilité claire.

La partie difficile : l'invalidation du cache

Le cache échange fraîcheur contre vitesse. Certaines données peuvent être légèrement obsolètes (pages d'actualité, compteurs de vues). D'autres ne le peuvent pas (totaux de commande, permissions). Les choix :

- Expiration temporelle (simple, tolère une petite obsolescence)

- Invalidation événementielle (plus précise, plus sujette aux erreurs)

Si l'invalidation échoue, les utilisateurs voient du contenu obsolète. Si elle est trop agressive, on perd l'effet du cache et MySQL est de nouveau surchargé.

Pourquoi le cache lisse les pics

Quand le trafic explose, les caches absorbent les lectures répétées pendant que MySQL se concentre sur le « vrai travail » (écritures, misses, requêtes complexes). Cela réduit l'attente, empêche les ralentissements en cascade et vous donne du temps pour scaler en sécurité.

Sharding et partitionnement : quand une base ne suffit plus

Il arrive un point où la « plus grosse machine » et le tuning n'achètent plus de marge. Si un seul serveur MySQL ne peut plus suivre le débit d'écriture, la taille des données ou les fenêtres de maintenance, on commence à découper les données.

Partitionnement vs sharding (et pourquoi c'est différent)

Partitionnement découpe une table en morceaux à l'intérieur de la même instance MySQL (par ex. par date). Ça peut accélérer les suppressions, l'archivage et certaines requêtes, mais on reste limité par le CPU/RAM/I/O de cette instance.

Sharding répartit les données sur plusieurs serveurs MySQL. Chaque shard contient un sous-ensemble de lignes, et votre application (ou une couche de routage) décide où envoyer chaque requête.

Quand le sharding devient nécessaire

Le sharding apparaît généralement quand :

- Les écritures saturent un primaire malgré index, cache et optimisations

- La croissance du stockage rend sauvegardes/restaurations et changements de schéma trop lents

- Des charges « bruyantes » créent de la latence imprévisible pour les autres

Clés de sharding courantes

Une bonne clé répartit la charge et garde la plupart des requêtes sur un seul shard :

- user_id : courant pour les applis grand public ; rassemble les données d'un utilisateur

- tenant_id : idéal pour le SaaS ; forte isolation entre clients

- géographie : utile pour la latence et la résidence des données, mais peut créer des hotspots

Les coûts réels

Le sharding échange simplicité contre capacité :

- Requêtes cross-shard plus complexes (souvent fan-out + agrégation)

- Transactions inter-shard limitées ; beaucoup d'équipes adoptent la cohérence éventuelle

- Migrations et rebalancements opérationnellement lourds

Une approche progressive (avant de s'engager)

Commencez par cache et réplicas de lecture. Ensuite, isolez les tables ou workloads les plus lourds. Ce n'est qu'après, et idéalement en ajoutant progressivement des shards, que vous passez à un sharding complet.

Opérations à grande échelle : monitoring, maintenance et incidents

Testez les scénarios de montée en charge dès le départ

Demandez à Koder.ai de modéliser le trafic, les besoins en cohérence et le comportement en cas de panne avant le lancement.

Faire tourner MySQL pour un produit chargé, c'est moins une histoire de fonctionnalités brillantes que de discipline opérationnelle. La plupart des incidents ne commencent pas par une grosse panne, mais par de petits signaux non reliés à temps.

Ce que les équipes surveillent réellement

À grande échelle, quatre signaux prédisent souvent les problèmes :

- Latence des requêtes (p50/p95/p99) : la hausse de la queue tail compte plus que la moyenne

- Verrous et attentes de verrou : les pics indiquent des lignes chaudes, des index manquants ou des transactions longues

- Lag de réplication : il transforme les réplicas en lectures obsolètes et complique les basculements

- Croissance du disque et pression I/O : le disque se remplit, mais la saturation I/O frappe souvent en premier

De bons dashboards ajoutent du contexte : trafic, taux d'erreur, nombre de connexions, hit rate du buffer pool et top requêtes. L'objectif : repérer le changement, pas mémoriser un « normal ».

Pourquoi les requêtes lentes n'apparaissent qu'en charge réelle

Beaucoup de requêtes semblent correctes en staging et même en production la nuit. Sous charge, la base se comporte différemment : les caches cessent d'aider, les requêtes concurrentes amplifient la contention et une requête légèrement inefficace peut déclencher plus de lectures, plus de tables temporaires ou des tris plus gros.

C'est pourquoi les équipes s'appuient sur le slow query log, des digests de requêtes et des histogrammes en production plutôt que sur des benchmarks isolés.

Maintenance sans surprises

Les pratiques sûres sont volontairement ennuyeuses : exécuter les migrations par petits lots, ajouter des index en limitant les verrous quand c'est possible, vérifier les plans avec EXPLAIN et garder des rollbacks réalistes (parfois le rollback consiste à arrêter le déploiement et basculer). Les changements doivent être mesurables : latence avant/après, temps d'attente de verrous et lag de réplication.

Incidents : diagnostiquer, atténuer, prévenir

Pendant un incident : confirmer l'impact, identifier le principal coupable (requête, hôte, table), puis atténuer — limiter le trafic, tuer des requêtes runaway, ajouter un index temporaire ou rediriger les lectures/écritures.

Après : documenter l'incident, ajouter des alertes pour les signaux précoces et rendre la correction répétable pour éviter que la même panne ne revienne.

Pourquoi MySQL reste pertinent aujourd'hui

MySQL est encore un choix par défaut parce qu'il correspond souvent aux besoins quotidiens : transactions solides, modèle relationnel, outillage mature et vivier de recrutement. Voilà ce qu'on retrouve dans les déploiements modernes :

- InnoDB comme moteur standard, avec une bonne récupération et des garanties transactionnelles

- Fonctionnalités de performance améliorées (optimiseurs, options de réplication plus rapides, comportement concurrentiel plus prévisible)

- Observabilité facilités : slow query logs, performance schema, exporters et dashboards qui mettent en évidence les goulets

- Automatisation autour des changements de schéma, des sauvegardes et du basculement — la montée en charge dépend moins d'interventions héroïques

Les services managés réduisent la charge opérationnelle

Beaucoup d'entreprises utilisent aujourd'hui MySQL via des services managés, où le fournisseur gère patching, sauvegardes automatisées, chiffrement, recovery point-in-time et étapes de scaling courantes (instances plus grandes, réplicas, croissance de stockage). Vous conservez la responsabilité du schéma, des requêtes et des patterns d'accès aux données, mais vous passez moins de temps sur les fenêtres de maintenance et les exercices de récupération.

Intégrer ces patterns dans la livraison d'applications moderne

La « playbook » de scaling MySQL reste pertinent parce que ce n'est pas seulement un problème de base : c'est un problème d'architecture applicative. Des choix comme la séparation lecture/écriture, les clés et l'invalidation du cache, les migrations sûres et les plans de rollback fonctionnent mieux quand ils sont conçus avec le produit, pas ajoutés en urgence.

Si vous construisez de nouveaux services et voulez encoder ces décisions tôt, un flux de travail vibe-coding peut aider. Par exemple, Koder.ai peut prendre un cahier des charges en langage naturel (entités, attentes de trafic, besoins de cohérence) et aider à générer un squelette d'application — typiquement React côté web et services Go — tout en vous laissant maîtriser la conception de la couche données. Son Planning Mode, ses snapshots et son rollback sont particulièrement utiles pour itérer sur les schémas et les déploiements sans transformer chaque migration en opération à risque.

Si vous souhaitez explorer les offres Koder.ai (Free, Pro, Business, Enterprise), voir /pricing.

Choisir MySQL aujourd'hui (checklist axée sur les exigences)

Choisissez MySQL quand vous avez besoin : de transactions solides, d'un modèle relationnel, d'un outillage mature, de performances prévisibles et d'un grand vivier de compétences.

Envisagez d'autres solutions quand vous avez besoin : d'un fan-out d'écritures massif avec schémas flexibles (certains systèmes NoSQL), d'écritures multi-régions fortement cohérentes (bases distribuées spécialisées) ou de traitements analytiques intensifs (entrepôts en colonnes).

Conclusion pratique : partez des exigences (latence, cohérence, modèle de données, taux de croissance, compétences de l'équipe), puis choisissez le système le plus simple qui les satisfait — et MySQL remplit souvent ce rôle.