Por qué los clientes se confunden con los límites

Los límites de tasa y las cuotas suenan similar, así que la gente a menudo los trata como lo mismo. Un rate limit es qué tan rápido puedes llamar a una API (peticiones por segundo o por minuto). Una cuota es cuánto puedes usar en un periodo más largo (por día, por mes o por ciclo de facturación). Ambos son normales, pero parecen aleatorios cuando las reglas no son visibles.

La queja clásica es: “funcionó ayer”. El uso rara vez es constante. Un pico corto puede colocar a alguien por encima del umbral incluso si su total diario parece estar bien. Imagina un cliente que ejecuta un informe una vez al día, pero hoy el trabajo reintenta después de un timeout y hace 10× más llamadas en 2 minutos. La API lo bloquea, y todo lo que ven es una falla repentina.

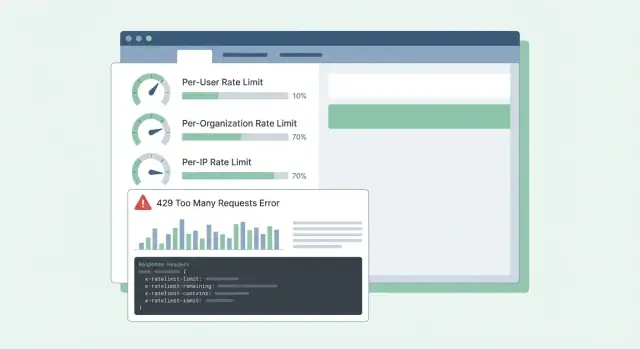

La confusión empeora cuando los errores son vagos. Si la API devuelve 500 o un mensaje genérico, los clientes suponen que tu servicio está caído, no que alcanzaron un límite. Abren tickets urgentes, crean soluciones alternativas o cambian de proveedor. Incluso un 429 Too Many Requests puede ser frustrante si no indica qué hacer a continuación.

La mayoría de las APIs SaaS limitan el tráfico por dos razones distintas:

- Detener el abuso: proteger el sistema de scraping, fuerza bruta o scripts fuera de control.

- Modelar el uso normal: mantener el rendimiento estable para todos, especialmente en horas pico.

Mezclar estos objetivos lleva a diseños malos. Los controles de abuso suelen ser por IP o por token y pueden ser estrictos. El modelado del uso normal suele ser por usuario o por organización y debería venir con orientación clara: qué límite se alcanzó, cuándo se reinicia y cómo evitar volver a alcanzarlo.

Cuando los clientes pueden predecir los límites, planifican en función de ellos. Cuando no pueden, cada pico se siente como una API rota.

Decide qué estás protegiendo

Los rate limits no son solo un freno. Son un sistema de seguridad. Antes de elegir números, ten claro qué intentas proteger, porque cada objetivo lleva a límites y expectativas distintos.

La disponibilidad suele ser la primera. Si unos pocos clientes pueden generar picos y empujar tu API a timeouts, todos sufren. Los límites aquí deben mantener los servidores responsivos durante ráfagas y fallar rápido en lugar de dejar que las peticiones se acumulen.

El coste es el motor silencioso detrás de muchas APIs. Algunas peticiones son baratas, otras son caras (llamadas a modelos LLM, procesamiento de archivos, escrituras en almacenamiento, consultas a terceros de pago). Por ejemplo, en una plataforma como Koder.ai, un solo usuario puede disparar muchas llamadas a modelos mediante generación de apps basada en chat. Los límites que siguen acciones costosas pueden evitar facturas sorpresa.

El abuso se ve distinto al uso legítimo elevado. Relleno de credenciales, adivinación de tokens y scraping suelen aparecer como muchas peticiones pequeñas desde un conjunto estrecho de IPs o cuentas. Aquí quieres límites estrictos y bloqueo rápido.

La equidad importa en sistemas multi‑tenant. Un cliente ruidoso no debería degradar a los demás. En la práctica, eso suele significar controles por capas: un guardia de ráfagas para mantener la salud minuto a minuto, un guardia de coste para endpoints o acciones caras, un guardia de abuso centrado en autenticación y patrones sospechosos, y un guardia de equidad para que una org no pueda dejar fuera a las demás.

Una prueba simple ayuda: elige un endpoint y pregúntate, “Si esta petición aumenta 10×, ¿qué se rompe primero?” La respuesta te indica qué objetivo de protección priorizar y qué dimensión (usuario, org, IP) debe llevar el límite.

Elige las dimensiones de limitación correctas

La mayoría de equipos empiezan con un límite y luego descubren que perjudica a las personas equivocadas. El objetivo es elegir dimensiones que coincidan con el uso real: quién llama, quién paga y qué parece abuso.

Las dimensiones comunes en SaaS se ven así:

- Por usuario: evita que un usuario final pesado ralentice a todos los demás en la misma cuenta.

- Por org/workspace: pone un techo claro al uso total de un tenant (a menudo lo que realmente venden los planes de facturación).

- Por IP: detecta bots, relleno de credenciales y clientes mal configurados que golpean desde una sola dirección.

- Por API key/token: útil para partners e integraciones donde “usuario” no tiene sentido o se comparte.

Los límites por usuario buscan la equidad dentro de un tenant. Si una persona hace una exportación grande, ella debería sentir la ralentización más que el resto del equipo.

Los límites por org van sobre presupuesto y capacidad. Incluso si diez usuarios lanzan trabajos a la vez, la org no debería dispararse a un nivel que rompa tu servicio o tus suposiciones de precio.

Los límites por IP mejor trátalos como una red de seguridad, no como herramienta de facturación. Las IPs pueden estar compartidas (NAT de oficina, carriers móviles), así que mantén esos límites generosos y confía en ellos principalmente para detener abusos evidentes.

Cuando combines dimensiones, decide cuál “gana” cuando aplican varios límites. Una regla práctica: rechaza la petición si cualquier límite relevante se supera, y devuelve la razón más accionable. Si un workspace excede su cuota org, no culpes al usuario o a la IP.

Ejemplo: un workspace de Koder.ai en un plan Pro podría permitir un flujo constante de solicitudes de build por org, mientras también limita a un solo usuario para que no dispare cientos de peticiones en un minuto. Si una integración partner usa un token compartido, un límite por token puede impedir que ahogue a los usuarios interactivos.

Algoritmos que funcionan en producción

La mayoría de problemas de rate limiting no son de matemáticas. Son de elegir un comportamiento que coincida con cómo los clientes llaman a tu API y mantenerlo predecible bajo carga.

Token bucket es un valor por defecto común porque permite ráfagas cortas mientras hace cumplir un promedio a largo plazo. Un usuario que refresca un dashboard puede disparar 10 peticiones rápidas. Token bucket permite eso si ha acumulado tokens, y luego lo ralentiza.

Leaky bucket es más estricto. Suaviza el tráfico en un flujo constante, lo que ayuda cuando tu backend no puede manejar picos (por ejemplo, generación de informes costosos). La contrapartida es que los clientes lo sentirán antes, porque las ráfagas se convierten en encolado o rechazo.

Los contadores basados en ventanas son sencillos, pero los detalles importan. Las ventanas fijas crean bordes afilados en la frontera (un usuario puede hacer un pico a las 12:00:59 y otra vez a las 12:01:00). Las ventanas deslizantes se sienten más justas y reducen picos en los límites, pero necesitan más estado o estructuras de datos mejores.

Una clase aparte de límite es la concurrencia (peticiones en vuelo). Esto te protege de conexiones cliente lentas y endpoints de larga duración. Un cliente puede mantenerse dentro de 60 peticiones por minuto pero aún así sobrecargarte manteniendo 200 peticiones abiertas al mismo tiempo.

En sistemas reales, los equipos suelen combinar un pequeño conjunto de controles: un token bucket para la tasa general, un tope de concurrencia para endpoints lentos o pesados, y presupuestos separados por grupos de endpoints (lecturas baratas vs exportaciones costosas). Si solo limitas por recuento de peticiones, un endpoint costoso puede desplazar todo lo demás y hacer que la API parezca aleatoriamente rota.

Diseñar cuotas que coincidan con precios y uso

Soporta overrides de límites por tenant

Define valores por defecto por plan y añade overrides por workspace sin escribir todo a mano.

Las buenas cuotas se sienten justas y predecibles. Los clientes no deberían descubrir las reglas solo después de ser bloqueados.

Mantén la separación clara:

- Límites de corto plazo (como 10 peticiones/segundo) protegen tu servicio de ráfagas.

- Cuotas a más largo plazo (diarias/mensuales) protegen costes y mantienen comparables los niveles de precio.

Muchos equipos usan ambos: un límite corto para detener ráfagas más una cuota mensual ligada al precio.

Límites duros vs blandos es principalmente una elección de soporte. Un límite duro bloquea inmediatamente. Un límite blando avisa primero y luego bloquea. Los límites blandos reducen tickets enfadados porque la gente tiene la oportunidad de arreglar un bug o actualizar antes de que una integración falle.

Cuando alguien sobrepasa, el comportamiento debería coincidir con lo que estás protegiendo. Bloquear funciona cuando el sobreuso puede dañar a otros tenants o explotar costes. Degradar (procesamiento más lento o prioridad menor) funciona cuando prefieres que las cosas sigan moviéndose. “Facturar después” puede funcionar cuando el uso es predecible y ya tienes un flujo de facturación.

Los límites por niveles funcionan mejor cuando cada nivel tiene una “forma de uso esperada” clara. Un plan gratuito puede permitir pequeñas cuotas mensuales y bajas tasas de ráfaga, mientras que los planes Business y Enterprise obtienen cuotas más altas y más margen de ráfaga para que los jobs en segundo plano terminen rápido. Eso es similar a cómo los niveles Free, Pro, Business y Enterprise de Koder.ai establecen diferentes expectativas sobre cuánto puedes hacer antes de subir.

Los límites personalizados valen la pena desde temprano, especialmente para enterprise. Un enfoque limpio es “valores por defecto por plan, overrides por cliente”. Almacena un override establecido por un admin por org (y a veces por endpoint) y asegúrate de que sobreviva a cambios de plan. También decide quién puede pedir cambios y con qué rapidez entran en efecto.

Ejemplo: un cliente importa 50.000 registros el último día del mes. Si su cuota mensual está casi usada, una advertencia suave al 80–90% les da tiempo para pausar. Un límite por segundo corto evita que la importación inunde la API. Un override aprobado para la org (temporal o permanente) mantiene el negocio en marcha.

Paso a paso: implementar límites en una API SaaS

Empieza por escribir qué vas a contar y a quién pertenece. La mayoría de equipos acaban con tres identidades: el usuario autenticado, la org cliente (o workspace) y la IP del cliente.

Un plan práctico:

- Define reglas de identidad: user ID desde auth, org ID desde el token o la API key, IP desde el primer hop de proxy de confianza (sé explícito sobre qué encabezado confías).

- Agrupa endpoints por coste: lecturas, escrituras, exportaciones pesadas, flujos de auth. Da a cada grupo límites distintos para que un endpoint caro no drene todo el presupuesto.

- Elige dónde viven los contadores: en memoria para una sola instancia, Redis para límites compartidos entre muchos servidores, y una base de datos solo para cuotas de auditoría más lentas. Usa TTLs que coincidan con la ventana (por ejemplo, 60 segundos para límites por minuto).

- Aplica consistentemente: haz un bloqueo grueso en el borde (gateway/CDN) para oleadas por IP, y luego comprobaciones más finas por usuario/org en middleware de la app donde puedas ver la ruta y el tenant.

- Instrumenta todo: rastrea tasa de bloqueos (429s), latencia añadida por el limitador y las claves más bloqueadas. Alerta cuando los bloqueos suben o cuando errores de Redis fuerzan comportamiento “fail open/closed”.

Cuando defines límites, piensa en niveles y grupos de endpoints, no en un solo número global. Un fallo común es depender de contadores en memoria entre varios servidores de aplicación. Los contadores discrepan y los usuarios ven 429s “aleatorios”. Un store compartido como Redis mantiene los límites estables entre instancias, y los TTLs mantienen los datos pequeños.

El despliegue importa. Empieza en modo “solo reportar” (registra lo que se habría bloqueado), luego aplica a un grupo de endpoints, y después expande. Así evitas despertarte con una avalancha de tickets de soporte.

Haz los límites comprensibles con respuestas y encabezados

Cuando un cliente alcanza un límite, el peor resultado es la confusión: “¿Está vuestra API caída o hice algo mal?” Respuestas claras y coherentes reducen tickets de soporte y ayudan a la gente a arreglar el comportamiento del cliente.

Usa HTTP 429 Too Many Requests cuando estés bloqueando activamente llamadas. Mantén el cuerpo de la respuesta predecible para que SDKs y dashboards puedan leerlo.

Aquí hay una forma JSON simple que funciona bien para límites por usuario, por org y por IP:

{

"error": {

"code": "rate_limit_exceeded",

"message": "Rate limit exceeded for org. Try again later.",

"limit_scope": "org",

"reset_at": "2026-01-17T12:34:56Z",

"request_id": "req_01H..."

}

}

Los encabezados deberían explicar la ventana actual y qué puede hacer el cliente a continuación. Si solo añades unos pocos, empieza por estos: RateLimit-Limit, RateLimit-Remaining, RateLimit-Reset, Retry-After y X-Request-Id.

Ejemplo: el cron de un cliente corre cada minuto y de repente empieza a fallar. Con 429 más RateLimit-Remaining: 0 y Retry-After: 20, saben inmediatamente que es un límite, no una caída, y pueden retrasar reintentos 20 segundos. Si comparten X-Request-Id con soporte, puedes encontrar el evento rápido.

Un detalle más: devuelve los mismos encabezados también en respuestas exitosas. Los clientes pueden ver que se acercan al límite antes de que lo alcancen.

Comportamiento del cliente: reintentos, backoff y escrituras seguras

Mantén control con exportación de código

Construye en Koder.ai y luego exporta el código fuente cuando estés listo.

Los buenos clientes hacen que los límites se sientan justos. Los clientes malos convierten un límite temporal en una caída al golpear más fuerte.

Cuando recibes un 429, trátalo como una señal para reducir la velocidad. Si la respuesta te dice cuándo reintentar (por ejemplo, vía Retry-After), espera al menos ese tiempo. Si no lo indica, usa backoff exponencial y añade jitter (aleatoriedad) para que miles de clientes no reintenten al mismo momento.

Mantén los reintentos acotados: limita el retraso entre intentos (por ejemplo, 30–60 segundos) y el tiempo total de reintentos (por ejemplo, detenerse después de 2 minutos y mostrar un error). También registra el evento con detalles del límite para que los desarrolladores puedan afinar más tarde.

No reintentes todo. Muchos errores no van a tener éxito sin un cambio o acción del usuario: 400 validación, 401/403 auth, 404 no encontrado y 409 conflictos que reflejan una regla de negocio real.

Los reintentos son peligrosos en endpoints de escritura (crear, cobrar, enviar correo). Si hay un timeout y el cliente reintenta, puedes crear duplicados. Usa claves de idempotencia: el cliente envía una clave única por acción lógica, y el servidor devuelve el mismo resultado para repeticiones de esa clave.

Los SDKs buenos pueden facilitar esto mostrando lo que los desarrolladores realmente necesitan: estado (429), cuánto esperar, si la petición es segura de reintentar y un mensaje como “Rate limit exceeded for org. Retry after 8s or reduce concurrency.”

Errores comunes que generan tickets furiosos

La mayoría de tickets de soporte sobre límites no tratan del límite en sí. Tratan de sorpresas. Si los usuarios no pueden predecir qué pasará después, asumen que la API está rota o es injusta.

Usar solo límites por IP es un error frecuente. Muchos equipos están detrás de una IP pública (Wi‑Fi de oficina, carriers móviles, NAT de nube). Si pones un tope por IP, un cliente ocupado puede bloquear a todos los demás en la misma red. Prefiere límites por usuario y por org, y usa por IP principalmente como red de seguridad.

Otro problema es tratar todos los endpoints por igual. Un GET barato y un job de exportación pesado no deberían compartir el mismo presupuesto. Si no, los clientes consumen su cuota navegando y luego se bloquean al intentar una tarea real. Separa cubos por grupo de endpoints o pondera peticiones por coste.

El tiempo de reinicio también debe ser explícito. “Se reinicia diariamente” no es suficiente. ¿En qué zona horaria? ¿Ventana rodante o reinicio a medianoche? Si haces reinicios calendario, di la zona horaria. Si haces ventanas rodantes, di la longitud de la ventana.

Finalmente, los errores vagos crean caos. Devolver 500 o JSON genérico hace que la gente intente más veces. Usa 429 e incluye encabezados RateLimit para que los clientes puedan reducir la velocidad inteligentemente.

Ejemplo: si un equipo crea una integración de Koder.ai desde una red corporativa compartida, un tope solo por IP puede bloquear a toda su org y parecer fallos aleatorios. Dimensiones claras y respuestas 429 coherentes evitan eso.

Checklist rápido antes de lanzar

Prototipa throttling por capas

Esboza un guardia IP en el edge más comprobaciones por org y usuario a nivel de aplicación que estén sincronizadas entre servidores.

Antes de activar límites para todos, haz una pasada final centrada en la predictibilidad:

- Define límites por nivel de precio y grupo de endpoints (auth, lecturas, escrituras, exportaciones). Mantén un pequeño buffer de seguridad para esenciales como login y refresh de token.

- Haz las reglas de identidad deterministas y documentadas. Decide exactamente cómo cuentas (usuario, org, API key, IP) y qué tiene precedencia.

- Haz que las respuestas 429 se expliquen por sí mismas. Incluye Retry-After más encabezados RateLimit (Limit, Remaining, Reset). En el cuerpo JSON, incluye un mensaje corto, qué límite se alcanzó y cuándo reintentar.

- Monitoriza tanto picos como falsos positivos. Rastrea la tasa de 429 por grupo de endpoints, los principales llamantes y caídas súbitas en peticiones exitosas. Alerta cuando los bloqueos suben.

- Ten un plan de excepciones: listas blancas, aumentos temporales, overrides de emergencia y quién puede aprobarlos.

Una comprobación de sentido común: si tu producto tiene niveles como Free, Pro, Business y Enterprise (como Koder.ai), deberías poder explicar en lenguaje sencillo qué puede hacer un cliente normal por minuto y por día, y qué endpoints se tratan diferente.

Si no puedes explicar un 429 claramente, los clientes asumirán que la API está rota y no que protege el servicio.

Plan de despliegue de ejemplo y siguientes pasos

Imagina un SaaS B2B donde la gente trabaja dentro de un workspace (org). Unos pocos power users ejecutan exportaciones pesadas y muchos empleados están detrás de una IP pública compartida. Si limitas solo por IP, bloqueas compañías enteras. Si solo limitas por usuario, un script puede seguir dañando al workspace.

Una mezcla práctica es:

- Límite de ráfaga por usuario para picos cortos.

- Límite sostenido por org para mantener el workspace justo a lo largo del tiempo.

- Guardián por IP para detectar tokens filtrados, bots y redes compartidas ruidosas.

Cuando alguien alcanza un límite, tu mensaje debe decir qué pasó, qué hacer a continuación y cuándo reintentar. El soporte debería poder respaldar un texto como:

“Request rate exceeded for workspace ACME. You can retry after 23 seconds. If you are running an export, reduce concurrency to 2 or schedule it off-peak. If this blocks normal use, reply with your workspace ID and timestamp and we can review your quota.”

Acompaña ese mensaje con Retry-After y encabezados RateLimit consistentes para que los clientes no tengan que adivinar.

Un despliegue que evita sorpresas: primero solo observación, luego advertencia (encabezados y avisos suaves), luego aplicación (429s con tiempo claro de reintento), luego ajuste de umbrales por nivel, y finalmente revisión después de lanzamientos grandes y onboardings de clientes.

Si quieres una forma rápida de convertir estas ideas en código funcional, una plataforma de vibe-coding como Koder.ai (koder.ai) puede ayudarte a redactar una especificación corta de rate limit y generar middleware en Go que la haga cumplir de forma coherente entre servicios.