15 dic 2025·8 min

James Gosling, Java y el auge de “Escribe una vez, ejecuta en cualquier lugar”

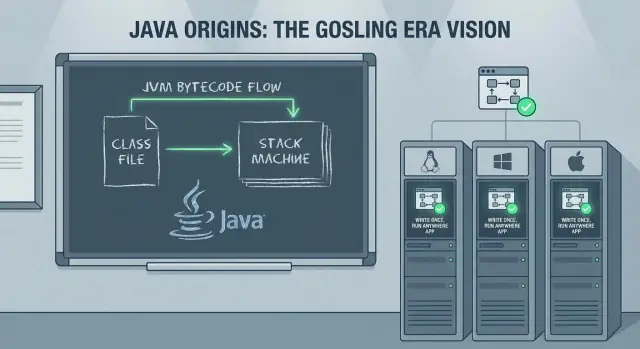

Cómo Java de James Gosling y la promesa “Escribe una vez, ejecuta en cualquier lugar” influyeron en sistemas empresariales, herramientas y prácticas backend actuales —desde la JVM hasta la nube.

Qué cubre esta entrada (y por qué sigue importando)

La promesa más famosa de Java —“Escribe una vez, ejecuta en cualquier lugar” (WORA)— no fue solo un eslogan de marketing para equipos de backend. Fue una apuesta práctica: podías construir un sistema serio una vez, desplegarlo en distintos sistemas operativos y hardware, y mantenerlo mientras la empresa crecía.

Esta entrada explica cómo funcionó esa apuesta, por qué las empresas adoptaron Java con tanta rapidez y cómo las decisiones tomadas en los años 90 siguen moldeando el desarrollo backend moderno: frameworks, herramientas de construcción, patrones de despliegue y los sistemas de larga vida que muchos equipos aún operan.

Qué obtendrás de esta historia

Empezaremos con los objetivos originales de James Gosling para Java y cómo el lenguaje y el runtime se diseñaron para reducir los dolores de la portabilidad sin sacrificar demasiado el rendimiento.

Luego seguiremos la historia empresarial: por qué Java se convirtió en una apuesta segura para grandes organizaciones, cómo surgieron servidores de aplicaciones y estándares empresariales, y por qué las herramientas (IDE, automatización de builds, testing) se volvieron un multiplicador de fuerza.

Finalmente, conectaremos el mundo "clásico" de Java con las realidades actuales: el ascenso de Spring, despliegues en la nube, contenedores, Kubernetes y lo que realmente significa “ejecutar en cualquier lugar” cuando tu runtime incluye docenas de servicios y dependencias de terceros.

Términos clave (usados a lo largo del post)

Portabilidad: la capacidad de ejecutar el mismo programa en diferentes entornos (Windows/Linux/macOS, distintos tipos de CPU) con cambios mínimos o nulos.

JVM (Java Virtual Machine): el runtime que ejecuta programas Java. En lugar de compilar directamente a código máquina específico, Java apunta a la JVM.

Bytecode: el formato intermedio producido por el compilador de Java. El bytecode es lo que ejecuta la JVM y es el mecanismo central detrás de WORA.

WORA sigue importando porque muchos equipos de backend afrontan hoy los mismos trade-offs: runtimes estables, despliegues previsibles, productividad del equipo y sistemas que deben sobrevivir una década o más.

James Gosling y los objetivos originales de Java

Java se asocia estrechamente con James Gosling, pero nunca fue un esfuerzo en solitario. En Sun Microsystems a principios de los 90, Gosling trabajó con un pequeño equipo (a menudo referido como el proyecto “Green”) cuyo objetivo era construir un lenguaje y un runtime que pudieran moverse entre dispositivos y sistemas operativos sin reescribirse cada vez.

El resultado no fue solo una nueva sintaxis: fue una idea de “plataforma” completa: un lenguaje, un compilador y una máquina virtual diseñados juntos para que el software se pudiera distribuir con menos sorpresas.

Los objetivos: seguridad, portabilidad, productividad

Unos objetivos prácticos moldearon Java desde el día uno:

- Seguridad y fiabilidad: Java eliminó o restringió fuentes comunes de fallos vistas en C/C++ —notablemente la manipulación directa de punteros— y añadió comprobaciones en tiempo de ejecución que preferían fallos previsibles antes que corrupciones silenciosas.

- Portabilidad: En lugar de compilar al código máquina de una CPU, Java compila a bytecode que puede ejecutarse en una JVM compatible. Esa decisión convirtió “multiplataforma” en algo menos sobre compilaciones condicionales y más sobre un contrato de runtime consistente.

- Productividad del desarrollador: Java buscó hacer la programación diaria más rápida y con menos errores mediante una biblioteca estándar, expectativas de herramientas consistentes y gestión automática de memoria.

Esos no eran objetivos académicos; respondían a costes reales: depurar problemas de memoria, mantener múltiples builds específicos por plataforma y formar a equipos en bases de código complejas.

Qué significaba (y no significaba) “Escribe una vez, ejecuta en cualquier lugar”

En la práctica, WORA significaba:

- Si apuntas a la JVM, normalmente puedes enviar el mismo bytecode a diferentes sistemas operativos.

- Aún tienes que gestionar diferencias de entorno: rutas de archivos, comportamiento de locales, peculiaridades de red, características nativas y empaquetado para despliegue.

Así que el eslogan no era “portabilidad mágica”. Fue un cambio en dónde se hace el trabajo de portabilidad: lejos de reescrituras por plataforma y hacia un runtime y bibliotecas estandarizadas.

Cómo funciona WORA: bytecode y la JVM

WORA es un modelo de compilación y runtime que separa la construcción del software de su ejecución.

Código fuente → bytecode → ejecución en la JVM

Los archivos fuente de Java (.java) se compilan con javac a bytecode (.class). El bytecode es un conjunto de instrucciones compacto y estandarizado que es igual se compile en Windows, Linux o macOS.

En tiempo de ejecución, la JVM carga ese bytecode, lo verifica y lo ejecuta. La ejecución puede ser interpretada, compilada sobre la marcha o una mezcla de ambas, según la JVM y la carga de trabajo.

La JVM como “adaptador” entre SO/CPU

En lugar de generar código máquina para cada CPU y sistema operativo en tiempo de compilación, Java apunta a la JVM. Cada plataforma ofrece su propia implementación de JVM que sabe cómo:

- traducir bytecode a instrucciones nativas para la CPU local

- interactuar con el sistema operativo local (archivos, red, hilos)

Esa abstracción es el trade-off central: tu aplicación habla con un runtime consistente, y el runtime habla con la máquina.

Comprobaciones en tiempo de ejecución y gestión de memoria

La portabilidad también depende de garantías aplicadas en tiempo de ejecución. La JVM realiza verificación de bytecode y otras comprobaciones que ayudan a prevenir operaciones inseguras.

Y en lugar de exigir a los desarrolladores asignar y liberar memoria manualmente, la JVM proporciona gestión automática de memoria (recolección de basura), reduciendo toda una categoría de fallos específicos de plataforma y errores del tipo “funciona en mi máquina”.

Por qué esto simplificó el despliegue en flotas

Para empresas que ejecutaban hardware y sistemas operativos mixtos, el beneficio fue operativo: enviar los mismos artefactos (JARs/WARs) a distintos servidores, estandarizar en una versión de JVM y esperar un comportamiento ampliamente consistente. WORA no eliminó todos los problemas de portabilidad, pero los redujo—haciendo que los despliegues a gran escala fueran más fáciles de automatizar y mantener.

Por qué las empresas adoptaron Java tan rápido

A finales de los 90 y a principios de los 2000, las empresas tenían una lista de deseos muy concreta: sistemas que pudieran funcionar durante años, sobrevivir a rotación de personal y desplegarse en una mezcla caótica de máquinas UNIX, servidores Windows y el hardware que la compra había negociado ese trimestre.

Java llegó con una historia inusualmente amigable para empresas: los equipos podían construir una vez y esperar un comportamiento consistente en entornos heterogéneos, sin mantener bases de código separadas por sistema operativo.

Menos reescrituras, menos trabajo de QA

Antes de Java, mover una aplicación entre plataformas a menudo implicaba reescribir partes específicas (hilos, red, rutas de archivos, toolkits de UI y diferencias entre compiladores). Cada reescritura multiplicaba el esfuerzo de testing—y las pruebas empresariales son caras porque incluyen suites de regresión, comprobaciones de cumplimiento y la cautela de “no puede romper la nómina”.

Java redujo esa carga. En lugar de validar múltiples builds nativos, muchas organizaciones pudieron estandarizar en un único artefacto de build y un runtime consistente, reduciendo costes de QA y haciendo más realista la planificación de ciclos largos de vida.

Una biblioteca estándar que se comportaba igual

La portabilidad no solo trata de ejecutar el mismo código; también trata de confiar en el mismo comportamiento. Las bibliotecas estándar de Java ofrecieron una base consistente para necesidades centrales como:

- Redes y protocolos web

- Conectividad a bases de datos (vía JDBC y drivers de proveedores)

- Primitivas de seguridad

- Bloques para concurrencia y threading

Esa consistencia facilitó formar prácticas compartidas entre equipos, incorporar desarrolladores y adoptar librerías de terceros con menos sorpresas.

Dónde la portabilidad todavía fallaba

La historia de “escribe una vez” no fue perfecta. La portabilidad podía romperse cuando los equipos dependían de:

- Librerías nativas (JNI) para integración hardware o código legado

- Peculiaridades del sistema de archivos, fuentes o comportamiento de locales

- Funcionalidades específicas de un proveedor en bases de datos o servidores de aplicaciones

Aun así, Java a menudo reducía el problema a un borde pequeño y bien definido, en lugar de volver toda la aplicación dependiente de la plataforma.

Plataformas empresariales: servidores de aplicaciones y Jakarta EE

A medida que Java pasó del escritorio a los centros de datos corporativos, los equipos necesitaron más que un lenguaje y una JVM: necesitaban una forma predecible de desplegar y operar capacidades compartidas de backend. Esa demanda ayudó a impulsar el auge de servidores de aplicaciones como WebLogic, WebSphere y JBoss (y, en el extremo más ligero, contenedores de servlets como Tomcat).

Despliegue estandarizado (WAR/EAR)

Una razón por la que los servidores de aplicaciones se difundieron rápidamente fue la promesa de empaquetado y despliegue estandarizados. En lugar de repartir scripts de instalación personalizados para cada entorno, los equipos podían agrupar una aplicación como WAR (web archive) o EAR (enterprise archive) y desplegarla en un servidor con un modelo de runtime consistente.

Ese modelo importaba a las empresas porque separaba preocupaciones: los desarrolladores se centraban en el código de negocio, mientras operaciones confiaba en el servidor de aplicaciones para configuración, integración de seguridad y gestión del ciclo de vida.

Patrones empresariales que todos necesitaban

Los servidores de aplicaciones popularizaron un conjunto de patrones que aparecen en casi todos los sistemas serios:

- Transacciones: coordinar operaciones de varios pasos (a menudo entre bases de datos y servicios) para que las fallas no dejen datos a medias.

- Mensajería: trabajo asíncrono mediante colas y topics, suavizando picos de tráfico y desacoplando sistemas.

- Pooling de conexiones: reutilizar conexiones a base de datos costosas en lugar de abrir una por petición.

Estos no eran “lujos”, sino la plomería requerida para flujos de pagos fiables, procesamiento de pedidos, actualizaciones de inventario y flujos internos.

De servlets/JSP a backends web modernos

La era de servlets/JSP fue un puente importante. Los servlets establecieron un modelo estándar de request/response, mientras que JSP hizo la generación de HTML del lado del servidor más accesible.

Aunque la industria luego se movió hacia APIs y frameworks de frontend, los servlets sentaron las bases para los backends web actuales: ruteo, filtros, sesiones y despliegue consistente.

Jakarta EE como esfuerzo de estandarización

Con el tiempo, estas capacidades se formalizaron como J2EE, luego Java EE, y ahora Jakarta EE: una colección de especificaciones para APIs de Java empresarial. El valor de Jakarta EE está en estandarizar interfaces y comportamientos entre implementaciones, de modo que los equipos puedan desarrollar contra contratos conocidos en lugar de la pila propietaria de un único proveedor.

Rendimiento: JIT, GC y el coste de la portabilidad

Diseña antes de construir

Usa Planning Mode para mapear endpoints, datos y tareas antes de generar el código.

La portabilidad de Java planteó una pregunta obvia: si el mismo programa puede ejecutarse en máquinas muy diferentes, ¿cómo puede además ser rápido? La respuesta está en un conjunto de tecnologías de runtime que hicieron la portabilidad práctica para cargas reales—especialmente en servidores.

Recolección de basura: menos tiempo gestionando memoria, menos bugs en producción

La recolección de basura (GC) importó porque las grandes aplicaciones de servidor crean y desechan enormes cantidades de objetos: peticiones, sesiones, cachés, payloads parseados y más. En lenguajes donde los equipos gestionan memoria manualmente, estos patrones suelen llevar a fugas, crashes o corrupciones difíciles de depurar.

Con GC, los equipos pueden centrarse en la lógica de negocio en lugar de “quién libera qué y cuándo”. Para muchas empresas, esa ventaja en fiabilidad compensó micro-optimizaciones.

Compilación JIT: el puente de rendimiento para la portabilidad

Java ejecuta bytecode en la JVM, y la JVM usa compilación Just-In-Time (JIT) para traducir las partes calientes de tu programa en código máquina optimizado para la CPU actual.

Ese es el puente: tu código sigue siendo portable, mientras el runtime se adapta al entorno en el que realmente corre—a menudo mejorando el rendimiento con el tiempo a medida que aprende qué métodos se usan más.

Los trade-offs: warm-up, tuning y sensibilidad a la latencia

Estas inteligencias del runtime no son gratis. JIT introduce tiempo de calentamiento, donde el rendimiento puede ser más lento hasta que la JVM observe suficiente tráfico para optimizar.

La GC también puede introducir pausas. Los recolectores modernos las reducen drásticamente, pero los sistemas sensibles a la latencia aún requieren elecciones y ajustes cuidadosos (tamaño de heap, selección de recolector, patrones de asignación).

Perfilado como parte normal del trabajo en Java

Porque gran parte del rendimiento depende del comportamiento en tiempo de ejecución, el perfilado se volvió rutinario. Los equipos Java suelen medir CPU, tasas de asignación y actividad de GC para encontrar cuellos de botella—tratando la JVM como algo a observar y afinar, no como una caja negra.

Herramientas que cambiaron la productividad del equipo

Java no conquistó equipos solo por la portabilidad. También trajo una historia de herramientas que hicieron manejables las grandes bases de código—y que hicieron al desarrollo a escala empresarial sentirse menos como una apuesta.

IDEs: de editar ficheros a entender sistemas

Los IDEs modernos para Java (y las características del lenguaje que aprovecharon) cambiaron el trabajo diario: navegación precisa entre paquetes, refactorizaciones seguras y análisis estático siempre activo.

Renombrar un método, extraer una interfaz o mover una clase entre módulos—y que las importaciones, puntos de llamada y tests se actualicen automáticamente. Para los equipos, eso significó menos zonas tabú, revisiones de código más rápidas y estructura más coherente a medida que los proyectos crecían.

Builds y dependencias: Ant → Maven/Gradle

Los builds Java tempranos a menudo usaban Ant: flexible, pero fácil de convertir en un script personalizado que solo una persona entendía. Maven impulsó un enfoque por convención con un layout de proyecto estándar y un modelo de dependencias reproducible en cualquier máquina. Gradle trajo luego builds más expresivos y una iteración más rápida manteniendo la gestión de dependencias en el centro.

El gran cambio fue la repetibilidad: el mismo comando, el mismo resultado, en laptops de desarrolladores y en CI.

Por qué las herramientas estándar ayudaron a escalar equipos

Estructuras de proyecto estándar, coordenadas de dependencias y pasos de build previsibles redujeron el conocimiento tribal. La incorporación fue más sencilla, los lanzamientos menos manuales y fue práctico aplicar reglas de calidad compartidas (formato, checks, puertas de test) en muchos servicios.

Lista de comprobación práctica para un proyecto Java moderno

- Usa un JDK LTS actual (y fíjalo en CI).

- Elige Maven o Gradle; mantén el build mínimo y documentado.

- Centraliza versiones de dependencias (BOM o catálogo de versiones).

- Añade formateo + checks estáticos (p. ej., Checkstyle/SpotBugs) como pasos de build.

- Exige pruebas unitarias y genera reportes de cobertura.

- Usa una pipeline CI reproducible que ejecute build + tests en cada cambio.

- Documenta “cómo ejecutar localmente” en un README corto.

Testing y entrega: de JUnit a CI/CD

Controla tu código

Mantén el control con la exportación del código fuente que puedes ejecutar en tu propia canalización.

Los equipos Java no solo obtuvieron un runtime portable—sino un cambio cultural: testing y entrega se convirtieron en algo estandarizable, automatizable y repetible.

Cómo JUnit normalizó las pruebas unitarias

Antes de JUnit, las pruebas solían ser ad-hoc (o manuales) y vivían fuera del ciclo principal de desarrollo. JUnit cambió eso al hacer que las pruebas se sintieran como código de primera clase: escribe una pequeña clase de test, ejecútala en tu IDE y obtén feedback inmediato.

Ese bucle corto importó para sistemas empresariales donde las regresiones son caras. Con el tiempo, “sin tests” dejó de ser una excepción curiosa y empezó a verse como un riesgo.

Beneficios de CI: un build, muchos entornos

Una gran ventaja de la entrega Java es que los builds suelen ser impulsados por los mismos comandos en todas partes—laptop del desarrollador, agentes de build, servidores Linux, runners Windows—porque la JVM y las herramientas de construcción se comportan de manera consistente.

En la práctica, esa consistencia redujo el clásico problema de “funciona en mi máquina”. Si tu servidor CI puede ejecutar mvn test o gradle test, la mayoría de las veces obtendrás los mismos resultados que ve todo el equipo.

Herramientas de calidad que encajan en la pipeline

El ecosistema Java hizo que las “puertas de calidad” fueran sencillas de automatizar:

- Formateo: Spotless o una configuración de formato compartida para mantener diffs limpios

- Linting/análisis estático: Checkstyle, PMD, SpotBugs para errores comunes

- Escaneos de seguridad: OWASP Dependency-Check (o herramientas hospedadas como Snyk) para detectar librerías vulnerables

Estas herramientas funcionan mejor cuando son predecibles: mismas reglas para cada repo, aplicadas en CI y con mensajes de fallo claros.

Una pipeline CI sencilla para un servicio Java

Manténla aburrida y repetible:

- Checkout + fijar versión de Java (fija tu JDK)

- Build + tests unitarios (

mvn test/gradle test) - Checks estáticos (formato, lint, escaneo de seguridad)

- Empaquetar artefacto (JAR) y guardarlo

- Tests de integración (opcional, pero valiosos)

- Desplegar a staging y luego producción con aprobaciones

Esa estructura escala de un servicio a muchos—y reitera el mismo tema: un runtime consistente y pasos consistentes hacen a los equipos más rápidos.

Spring y el giro hacia el desarrollo backend moderno

Java se ganó la confianza de las empresas temprano, pero construir aplicaciones reales a menudo significaba lidiar con servidores de aplicaciones pesados, XML verboso y convenciones específicas. Spring cambió la experiencia diaria al poner Java “plano” en el centro del desarrollo backend.

Inversión de control: por qué encajó en necesidades empresariales

Spring popularizó la inversión de control (IoC): en lugar de que tu código cree y cablee todo manualmente, el framework ensambla la aplicación a partir de componentes reutilizables.

Con inyección de dependencias (DI), las clases declaran lo que necesitan y Spring lo proporciona. Esto mejora la testabilidad y facilita que los equipos cambien implementaciones (por ejemplo, un gateway de pagos real vs. un stub en tests) sin reescribir la lógica de negocio.

Configuración e integración simplificadas

Spring redujo fricción estandarizando integraciones comunes: plantillas JDBC, soporte ORM, transacciones declarativas, scheduling y seguridad. La configuración pasó de XML largo y frágil a anotaciones y propiedades externalizadas.

Ese cambio también se alineó con la entrega moderna: el mismo build puede ejecutarse localmente, en staging o en producción cambiando configuración por entorno en lugar de código.

WORA, portabilidad y patrones de servicio modernos

Los servicios basados en Spring mantuvieron práctica la promesa de “ejecutar en cualquier lugar”: una API REST creada con Spring puede ejecutarse sin cambios en una laptop, en una VM o en un contenedor—porque el bytecode apunta a la JVM y el framework abstrae muchos detalles de plataforma.

Los patrones comunes de hoy—endpoints REST, inyección de dependencias y configuración vía properties/vars de entorno—son esencialmente el modelo mental por defecto de Spring para el desarrollo backend. Para más sobre realidades de despliegue, véase /blog/java-in-the-cloud-containers-kubernetes-and-reality.

Java en la nube: contenedores, Kubernetes y la realidad

Java no necesitó una “reescritura para la nube” para ejecutarse en contenedores. Un servicio Java típico sigue empaquetado como un JAR (o WAR), lanzado con java -jar y colocado en una imagen de contenedor. Kubernetes entonces programa ese contenedor como cualquier otro proceso: iniciarlo, vigilarlo, reiniciarlo y escalarlo.

Qué cambia en contenedores (incluso si tu código no cambia)

El gran cambio es el entorno alrededor de la JVM. Los contenedores introducen límites de recursos más estrictos y eventos de ciclo de vida más rápidos que los servidores tradicionales.

Los límites de memoria son el primer problema práctico. En Kubernetes defines un límite de memoria y la JVM debe respetarlo—o el pod será eliminado. Las JVM modernas son conscientes de contenedores, pero los equipos aún ajustan el tamaño del heap para dejar espacio a metaspace, hilos y memoria nativa. Un servicio que “funciona en una VM” puede aún morir en un contenedor si el heap está sobredimensionado.

El tiempo de arranque también importa más. Los orquestadores escalan arriba/abajo con frecuencia, y los cold starts lentos afectan el autoscaling, los rollouts y la recuperación de incidentes. El tamaño de la imagen genera fricción operativa: imágenes más grandes tardan más en descargarse, extienden tiempos de despliegue y consumen ancho de banda de registro.

Hacer que Java encaje mejor: más pequeño, más rápido, más predecible

Varias aproximaciones ayudaron a que Java se sintiera más natural en despliegues en la nube:

- Runtimes más ligeros: imágenes base reducidas y recortar runtime con herramientas como

jlinkcuando es práctico para reducir tamaño de imagen. - Arranque más rápido: compartir datos de clases (CDS) y buena higiene de dependencias para reducir overhead de cold-start.

- Empaquetado alternativo: compilación ahead-of-time (cuando aplica) puede mejorar dramáticamente arranque y perfil de memoria, a costa de otros trade-offs de build/debug.

Para un recorrido práctico sobre ajuste de comportamiento de la JVM y comprender trade-offs de rendimiento, véase /blog/java-performance-basics.

Compatibilidad hacia atrás y sistemas de larga vida

Lanza herramientas complementarias

Crea un panel o una app de ayuda para migraciones que encaje con tus sistemas Java existentes.

Una razón por la que Java ganó la confianza en empresas es simple: el código suele sobrevivir a equipos, proveedores e incluso estrategias de negocio. La cultura de estabilidad de APIs y compatibilidad hacia atrás de Java hizo que una aplicación escrita años atrás pudiera seguir funcionando tras upgrades de SO, renovaciones de hardware y nuevas versiones de Java—sin una reescritura total.

Por qué las APIs estables importan en empresas

Las empresas optimizan para la previsibilidad. Cuando las APIs centrales permanecen compatibles, el coste del cambio baja: materiales de formación siguen siendo relevantes, runbooks operativos no necesitan reescrituras constantes y los sistemas críticos pueden mejorarse en pasos pequeños en lugar de migraciones totales.

Esa estabilidad también condicionó elecciones arquitectónicas. Los equipos se sentían cómodos construyendo plataformas compartidas y librerías internas porque esperaban que siguieran funcionando durante largo tiempo.

Librerías, mantenimiento y la expectativa de “para siempre”

El ecosistema de librerías Java (desde logging hasta acceso a bases de datos y frameworks web) reforzó la idea de que las dependencias son compromisos a largo plazo. La contrapartida es el mantenimiento: los sistemas de larga vida acumulan versiones viejas, dependencias transitivas y “parches temporales” que se vuelven permanentes.

Las actualizaciones de seguridad e higiene de dependencias son trabajo continuo, no un proyecto puntal. Parchear regularmente el JDK, actualizar librerías y rastrear CVEs reduce el riesgo sin desestabilizar producción—especialmente cuando las actualizaciones son incrementales.

Actualizar aplicaciones Java antiguas de forma segura

Un enfoque práctico es tratar las actualizaciones como trabajo de producto:

- Comienza añadiendo o mejorando tests automatizados alrededor de flujos críticos.

- Actualiza en saltos pequeños (p. ej., una línea LTS a la vez) y mide rendimiento y memoria, no solo compilación.

- Ejecuta versiones vieja y nueva en paralelo en staging y mantén planes de rollback explícitos.

- Haz inventario de dependencias temprano; muchas “actualizaciones de Java” fallan porque una librería clave está abandonada.

La compatibilidad hacia atrás no garantiza que todo sea indoloro—pero es una base que hace posible modernizar con cuidado y bajo riesgo.

Lecciones clave para equipos de backend hoy

Qué entregó realmente WORA (y qué no)

WORA funcionó mejor en el nivel que Java prometía: el mismo bytecode compilado podía ejecutarse en cualquier plataforma con una JVM compatible. Eso facilitó mucho los despliegues multiplataforma en servidores y empaquetado neutral frente a proveedores.

Donde fue insuficiente fue en todo lo que ocurre en el borde de la JVM. Diferencias en sistemas operativos, sistemas de archivos, valores por defecto de red, arquitecturas CPU, flags de JVM y dependencias nativas aún importan. Y la portabilidad de rendimiento nunca fue automática—puedes ejecutar en cualquier lugar, pero aún tienes que observar y afinar cómo se ejecuta.

Conclusiones prácticas para equipos que eligen Java hoy

La mayor ventaja de Java no es una sola característica; es la combinación de runtimes estables, herramientas maduras y una enorme bolsa de talento.

Algunas lecciones a nivel de equipo para llevar adelante:

- Trata la JVM como una plataforma: elige una distribución de JDK soportada, estandariza versiones y actualiza deliberadamente.

- Prefiere defaults aburridos: mantén builds, logging, métricas y gestión de dependencias consistentes entre servicios.

- Diseña para operabilidad: invierte temprano en monitorización, configuración segura y comportamiento de memoria/GC predecible.

- Apóyate en el ecosistema: frameworks y librerías ahorran tiempo, pero audita la proliferación de dependencias y actualizaciones de seguridad.

Factores de decisión: cuándo Java es la opción correcta

Elige Java cuando tu equipo valore mantenimiento a largo plazo, soporte maduro de librerías y operaciones de producción predecibles.

Puntos a comprobar:

- Habilidades del equipo: ¿ya tienen experiencia en Java/Spring o habrá que formar desde cero?

- Restricciones de runtime: ¿el tiempo de inicio y huella de memoria son críticos (algunas cargas prefieren Go/Node), o la prioridad es throughput y estabilidad?

- Necesidades del ecosistema: ¿requieres mensajería madura, drivers de base de datos, observabilidad o integraciones empresariales?

- Longevidad: ¿vivirá este sistema años con pocas reescrituras?

Próximos pasos

Si evalúas Java para un backend nuevo o un esfuerzo de modernización, comienza con un servicio piloto pequeño, define una política de upgrades/parches y acuerda una baseline de frameworks. Si quieres ayuda para acotar esas decisiones, contáctanos vía /contact.

Si además experimentas con formas rápidas de levantar “servicios sidecar” o herramientas internas alrededor de un parque Java existente, plataformas como Koder.ai pueden ayudarte a pasar de una idea a una app web/servidor/móvil funcional mediante chat—útil para prototipar servicios complementarios, dashboards o utilidades de migración. Koder.ai soporta exportación de código, despliegue/hosting, dominios personalizados y snapshots/rollback, lo que encaja bien con la misma mentalidad operativa que los equipos Java valoran: builds repetibles, entornos previsibles e iteración segura.