Was Khosla mit „KI wird Ärzte ersetzen“ meinte

Wenn Vinod Khosla sagt „KI wird Ärzte ersetzen“, beschreibt er in der Regel kein Science‑Fiction‑Krankenhaus ohne Menschen. Er macht eine präzisere, operative Aussage: Viele Aufgaben, die heute Zeit von Ärzt:innen fressen — besonders informationsreiche Tätigkeiten — können von Software übernommen werden, die schneller, günstiger und zunehmend genauer ist.

Der Umfang: Ersatz von Aufgaben, nicht von Mitgefühl

In Khoslas Deutung bedeutet „ersetzen“ oft das Substituieren eines großen Teils dessen, was Ärzt:innen tagtäglich tun, nicht das Auslöschen des Berufs. Denken Sie an die repetitiven Teile der Versorgung: Symptome erfassen, Leitlinien prüfen, wahrscheinliche Diagnosen einordnen, nächste Tests empfehlen, chronische Erkrankungen überwachen und Risiken früh markieren.

Deshalb ist die Idee eher „pro‑Automatisierung“ als „anti‑Arzt“. Die zugrunde liegende Wette lautet, dass Health‑Care voll von Mustern ist — und Mustererkennung in großem Maßstab ist genau das, worin KI häufig stark ist.

Erwartungen für diesen Text

Dieser Beitrag behandelt die Aussage als Hypothese, die geprüft werden soll, nicht als Slogan, den man bejubeln oder verwerfen muss. Wir betrachten die Argumentation dahinter, welche Arten von Gesundheitsprodukten dazu passen und welche realen Einschränkungen bestehen: Regulierung, Sicherheit, Haftung und die menschliche Seite der Medizin.

Wichtige Begriffe, die wir verwenden

- Ersetzen: KI führt eine Aufgabe Ende‑zu‑Ende aus mit minimaler Beteiligung von Kliniker:innen.

- Ergänzen: KI unterstützt, aber eine Klinikerin/ein Kliniker bleibt Entscheidungsträger:in.

- Kliniker: Eine approbierte Fachkraft (Arzt/Ärztin, Nurse Practitioner, Physician Assistant), die Patienten betreut.

- Diagnose: Nicht nur eine Krankheitsbezeichnung, sondern das Formulieren einer wahrscheinlichkeit-weighteten Erklärung und das Festlegen nächster Schritte (Tests, Behandlung, Nachsorge).

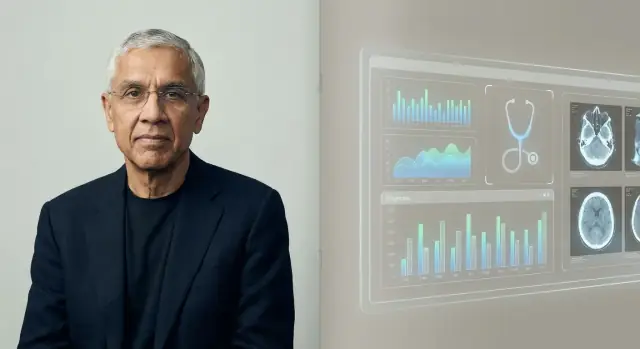

Wer ist Vinod Khosla und warum seine Sicht zählt

Ein kurzer, faktischer Hintergrund

Vinod Khosla ist ein Silicon‑Valley‑Unternehmer und Investor, bekannt als Mitbegründer von Sun Microsystems in den 1980er Jahren und später langjähriger Risikokapitalgeber. Nach Stationen bei Kleiner Perkins gründete er 2004 Khosla Ventures.

Diese Kombination aus praktischer Erfahrung und Jahrzehnten als Investor erklärt, warum seine Aussagen über KI und Gesundheit weit über die Tech‑Blase hinaus Beachtung finden.

Der „Stil“ von Khosla Ventures in einfachen Worten

Khosla Ventures hat den Ruf, große, hoch‑konviktive Wetten zu unterstützen, die zunächst unvernünftig wirken können. Die Firma tendiert zu:

- konträren Thesen (Ideen, die viele Expert:innen anfangs ablehnen)

- Plattformwechseln (Technologien, die mehrere Branchen neu gestalten)

- langen Zeithorizonten (Bereitschaft, auf Regulierung, Adoption oder Infrastruktur zu warten)

Das ist wichtig, weil Prognosen wie „KI wird Ärzte ersetzen“ nicht nur Rhetorik sind — sie beeinflussen, welche Startups gefördert werden, welche Produkte gebaut werden und welche Erzählungen Führungsgremien ernst nehmen.

Warum Healthcare ein großes Ziel für KI‑Wetten wurde

Das Gesundheitswesen ist einer der größten, kostenintensivsten Bereiche der Wirtschaft und zugleich voll mit Signalen, aus denen KI lernen kann: Bilder, Laborwerte, Notizen, Sensordaten und Outcomes. Selbst moderate Verbesserungen bei Genauigkeit, Tempo oder Kosten können bedeutende Einsparungen und besseren Zugang bedeuten.

Khosla und sein Fonds argumentieren wiederholt, dass die Medizin reif ist für softwaregetriebene Veränderungen — besonders in Bereichen wie Triage, Diagnostikunterstützung und Workflow‑Automatisierung. Ob man nun der „Ersatz‑Frame“ zustimmt oder nicht: Seine Sicht spiegelt wider, wie ein großer Teil des Risikokapitals die Zukunft der Medizin bewertet — und wohin Kapital fließt.

Die Logik hinter der Vorhersage

Khoslas Vorhersage beruht auf einer einfachen Aussage: Ein großer Teil der Medizin — vor allem Primärversorgung und frühe Triage — ist Mustererkennung unter Unsicherheit. Wenn Diagnose und Therapieauswahl oft bedeuten „dieses Beschwerdebild passt am ehesten zu X“, dann sollte Software, die aus Millionen Beispielen lernt, irgendwann besser abschneiden als einzelne Clinician, die nur Tausende Fälle sehen.

Mustererkennung in großem Maßstab

Menschen sind exzellent darin, Muster zu erkennen, aber begrenzt durch Gedächtnis, Aufmerksamkeit und Erfahrung. Ein KI‑System kann weit mehr Fälle, Leitlinien und Outcomes konsumieren als jede einzelne Person und dieses gelernte Muster konsistent anwenden. In Khoslas Sicht, sobald die Fehlerquote des Systems unter dem Durchschnitt der Kliniker:innen liegt, ist die rationale Wahl für Patient:innen und Kostenträger, Routineentscheidungen über die Maschine zu leiten.

Kosten, Zugang und Konsistenz

Ökonomik ist der zweite Treiber. Primärversorgung ist durch Zeit, Geografie und Personalmangel begrenzt; Termine sind oft teuer, kurz und variabel in der Qualität. Ein KI‑Dienst kann 24/7 verfügbar sein, in unterversorgte Regionen skalieren und einheitlichere Entscheidungen liefern — das reduziert das Problem „es kommt darauf an, wen Sie gesehen haben“.

Warum es möglich wurde

Frühere Expertensysteme scheiterten, weil sie auf manuell kodierten Regeln und engen Datensätzen beruhten. Die Machbarkeit stieg, als medizinische Daten digitalisiert wurden (EHRs, Bildgebung, Labore, Wearables) und Rechenleistung das Training großer Modelle und kontinuierliche Updates erlaubte.

Automatisierung vs. menschliche Pflege

Selbst in dieser Logik wird die „Ersatz“‑Linie meist um Routine‑Diagnosen und protokollgesteuerte Betreuung gezogen — nicht um die Teile der Medizin, die auf Vertrauen, komplexen Abwägungen oder Begleitung in existenziellen Entscheidungen basieren.

Kernaussagen und Zitate (mit Kontext)

Khoslas Formulierung „KI wird Ärzte ersetzen“ ist oft als provokative Prognose gedacht, nicht als wörtliches Versprechen, dass Krankenhäuser menschenleer werden. Ein wiederkehrendes Thema: Vieles in der Medizin, besonders Diagnostik und Routine‑Therapiewahl, folgt Mustern, die Software lernen, messen und verbessern kann.

Argument 1: Mustererkennung skaliert schneller als menschliche Ausbildung

Er sieht klinisches Denken als Form von Musterabgleich über Symptome, Anamnesen, Bilder, Laborwerte und Outcomes. Sobald ein KI‑Modell eine bestimmte Qualitätsgrenze erreicht, kann es breit ausgerollt und kontinuierlich aktualisiert werden — während die Ausbildung von Clinician langsam, teuer und regional ungleich ist.

Argument 2: Besserer Durchschnitt, weniger „schlechte Tage"

Ein zentraler Punkt ist die Variabilität: Clinician können exzellent, aber inkonsistent sein — etwa durch Ermüdung oder begrenzte Fallzahlen bei seltenen Erkrankungen. KI kann beständigere Leistung bieten und potenziell geringere Fehlerquoten erreichen, sofern sie getestet, überwacht und nachtrainiert wird.

Argument 3: Zweitmeinungen werden zum Standard

Anstatt KI als einmaligen „Ersatz“ zu sehen, liest seine stärkste Version eher so: Die meisten Patient:innen konsultieren zuerst eine KI, und menschliche Clinician agieren zunehmend als Reviewer bei komplexen Fällen, Randbedingungen und risikoreichen Entscheidungen.

Wichtiger Kontext: eine strittige Prognose, kein fertiger Fakt

Befürworter interpretieren seine Haltung als Anstoß zu messbaren Outcome‑Verbesserungen und besserem Zugang. Kritiker weisen darauf hin, dass reale Medizin Ambiguität, Ethik und Verantwortlichkeit enthält — und dass „Ersatz“ ebenso sehr von Regulierung, Workflow und Vertrauen abhängt wie von Modellgenauigkeit.

Die Wetten im Gesundheitswesen, die zur These passen

Khoslas Satz passt zu den Startups, die VCs gerne finanzieren: Firmen, die schnell skalieren, unordentliche klinische Arbeit standardisieren und Expertenurteil in Software abbilden.

Die wichtigsten Investment‑Kategorien

Viele dieser Wetten gruppieren sich um wiederkehrende Themen:

- Diagnostik und Früherkennung: Tools, die Krankheiten früher erkennen als Routineversorgung, oft durch Kombination von Laboren, Symptomen, Anamnesen und Vorbefunden zu einem Risiko‑Score.

- Triage und Routing: KI‑“Frontdoors”, die entscheiden, wer dringend versorgt werden muss, wer sich selbst behandeln kann und welcher Facharzt nötig ist.

- Bildgebung und Signalinterpretation: Radiologie, Pathologie, Dermatoskopie‑Bilder, EKGs — Bereiche, in denen Mustererkennung zentral und die Leistung messbar ist.

- Workflow‑Automatisierung: Aktenzusammenfassungen, Dokumentation, Prior‑Auth‑Support, Kodierung und Inbox‑Management — weniger spektakulär, aber direkt am Zeitaufwand der Clinician angesetzt.

Warum diese Wetten zu VC‑Anreizen passen

Das Ersetzen (oder Reduzieren) des Clinician‑Bedarfs ist ein riesiger Markt: Gesundheitsausgaben sind enorm und Personal ist ein zentraler Kostenfaktor. Das erzeugt Anreize für kühne Zeitlinien — weil Fundraising eine klare, hoch‑wertige Story belohnt, selbst wenn klinische Adoption und Regulierung langsamer laufen als Software.

Eine Punktlösung erledigt eine Aufgabe sehr gut (z. B. Thorax‑Röntgen lesen). Eine Plattform will über viele Workflows sitzen — Triage, Diagnostikunterstützung, Nachverfolgung, Abrechnung — und gemeinsame Datenpipelines und Modelle nutzen.

Die „Ärzte ersetzen“‑Erzählung hängt mehr von Plattformen ab: Wenn KI nur in einer engen Aufgabe gewinnt, passen Clinician sich an; koordiniert sie aber viele Aufgaben Ende‑zu‑Ende, verschiebt sich die Rolle der Clinician hin zu Aufsicht, Ausnahmenmanagement und Verantwortlichkeit.

Für Gründer, die Plattformideen verfolgen, zählt frühe Geschwindigkeit: Meist braucht man Prototypen für Intake‑Flows, Clinician‑Dashboards und Audit‑Trails, bevor man Workflows testen kann. Tools wie Koder.ai helfen Teams, interne Web‑Apps (häufig React im Frontend, Go + PostgreSQL im Backend) aus einer Chatoberfläche zu bauen, dann Quellcode zu exportieren und schnell zu iterieren. Alles, was klinische Entscheidungen berührt, braucht weiterhin Validierung, Security‑Review und eine Regulierungsstrategie — aber Rapid‑Prototyping kann den Weg zu realistischen Piloten verkürzen.

Wo KI realistisch Clinician einholen oder übertreffen kann

Sichere Iterationsschleifen hinzufügen

Nutzen Sie Snapshots und Rollbacks, um Änderungen zu testen, ohne eine funktionierende Version zu verlieren.

KI übertrifft Menschen bereits in spezifischen, engen Bereichen klinischer Arbeit — besonders wenn die Aufgabe hauptsächlich Mustererkennung, Tempo und Konsistenz erfordert. Das heißt nicht „KI‑Arzt“ im umfassenden Sinn, aber KI kann eine sehr starke Komponente der Versorgung sein.

Aufgaben, in denen KI wirklich stark ist

KI punktet dort, wo viel repetitive Information und klare Feedback‑Schleifen existieren:

- Zusammenfassungen: Lange Akten in eine klare Zeitlinie (Medikationen, Laborwerte, Vorbefunde) verwandeln oder Besuchsnotizen aus Transkripten entwerfen.

- Triage: Symptome und Risikofaktoren in Dringlichkeitskategorien sortieren, besonders bei hohem Volumen.

- Mustererkennung: Subtile Signale in Bildern und Wellenformen (Radiologie, Dermatoskopie, EKG) entdecken und Kombinationen von Labortrends erkennen, die Menschen bei Ermüdung übersehen.

In diesen Bereichen bedeutet „besser“ oft weniger übersehene Befunde, standardisiertere Entscheidungen und schnellere Durchlaufzeiten.

Klinische Entscheidungsunterstützung vs. autonome Diagnose

Die meisten realen Erfolge heute kommen von klinischer Entscheidungsunterstützung (CDS): KI schlägt wahrscheinliche Diagnosen vor, markiert gefährliche Alternativen, empfiehlt nächste Tests oder prüft Leitlinien‑Adhärenz — während eine Clinician die Verantwortung trägt.

Autonome Diagnose (KI entscheidet Ende‑zu‑Ende) ist in begrenzten, streng definierten Kontexten möglich — etwa Screening‑Workflows mit klaren Protokollen — aber nicht der Standard bei komplexen, multimorbiden Patient:innen.

Der Haken: Datenqualität und Repräsentativität

Die Genauigkeit von KI hängt stark von Trainingsdaten ab, die zur Patientenpopulation und zum Versorgungssetting passen. Modelle „driften“, wenn:

- das Krankenhaus andere Geräte oder Dokumentationsstile nutzt,

- die Patientenmischung sich unterscheidet (Alter, Ethnie, Komorbiditäten), oder

- die „Ground‑Truth“‑Labels inkonsistent sind.

Warum menschliche Aufsicht weiterhin wichtig ist

In risikoreichen Settings ist Aufsicht kein „Nice‑to‑have“ — sie ist die Sicherheitsschicht für Randfälle, ungewöhnliche Präsentationen und wertbasierte Entscheidungen (was eine Patientin bereit ist zu tun, zu tolerieren oder zu priorisieren). KI kann hervorragend im Sehen sein, aber Clinician müssen entscheiden, was das heute für diese Person bedeutet.

Wo KI noch scheitert

KI beeindruckt bei Musterabgleich, Aktenzusammenfassung und Diagnosevorschlägen. Medizin ist aber nicht nur ein Vorhersageproblem. Die schwierigsten Teile treten auf, wenn die „richtige“ Antwort unklar ist, Patientenwünsche Leitlinienkonflikte erzeugen oder das Versorgungssystem selbst unordentlich ist.

Vertrauen, Gesprächsführung und geteilte Entscheidungen

Menschen wollen nicht nur ein Ergebnis — sie wollen sich gehört, ernstgenommen und sicher fühlen. Eine Clinician kann Angst, Scham, Verwirrung oder häusliche Risiken bemerken und das Gespräch sowie den Plan entsprechend anpassen. Shared Decision‑Making erfordert Verhandeln von Kompromissen (Nebenwirkungen, Kosten, Lebensstil, familiäre Unterstützung), was über Zeit Vertrauen schafft.

Ambiguität, Multimorbidität und seltene Fälle

Reale Patient:innen haben oft mehrere Erkrankungen, unvollständige Vorgeschichten und Symptome, die nicht ins saubere Template passen. Seltene Krankheiten und atypische Präsentationen sehen zunächst wie häufige Probleme aus — bis klar wird, dass sie es nicht sind. KI kann plausible Vorschläge liefern, aber „plausibel“ ist nicht automatisch „klinisch bewiesen“, besonders wenn subtiler Kontext zählt (kürzliche Reisen, neue Medikamente, soziale Faktoren, „irgendetwas fühlt sich anders an").

Verantwortlichkeit, wenn die KI falsch liegt

Auch ein sehr genaues Modell wird gelegentlich versagen. Die schwierige Frage ist: Wer trägt die Verantwortung — die Clinician, die das Tool befolgt hat, das Krankenhaus, das es eingesetzt hat, oder der Anbieter, der es gebaut hat? Klare Haftungsregeln beeinflussen, wie konservativ Teams vorgehen müssen und wie Patient:innen Regressmöglichkeiten haben.

Operative Realität: Integration in Kliniken und EHRs

Versorgung findet in Workflows statt. Wenn ein KI‑Tool sich nicht nahtlos in EHRs, Bestellsysteme, Dokumentation und Abrechnung einfügt — oder zusätzliche Klicks und Unsicherheit verursacht — werden überlastete Teams es nicht nutzen, egal wie überzeugend die Demo ist.

Regulierung, Ethik und Sicherheit in medizinischer KI

Während des Lernens Credits verdienen

Erhalten Sie Credits, indem Sie Ihren Build teilen oder Teammitglieder an Koder.ai verweisen.

Medizinische KI ist kein rein technisches Problem, sondern eine Sicherheitsfrage. Sobald Software Diagnose oder Behandlung beeinflusst, behandeln Regulierungsbehörden sie eher wie ein Medizinprodukt als eine gewöhnliche App.

FDA‑ und CE‑Aufsicht: das Grundsätzliche

In den USA reguliert die FDA viele „Software als Medizinprodukt“‑Tools, insbesondere solche, die diagnostizieren, Behandlungsentscheidungen empfehlen oder direkt die Versorgung beeinflussen. In der EU spielt die CE‑Kennzeichnung unter der MDR eine ähnliche Rolle.

Diese Rahmen verlangen Evidenz für Sicherheit und Wirksamkeit, Klarheit über den vorgesehenen Gebrauch und kontinuierliches Monitoring nach dem Einsatz. Die Regeln sind wichtig, weil ein Modell, das in Demos überzeugt, in realen Kliniken mit echten Patient:innen scheitern kann.

Ein großes ethisches Risiko ist ungleichmäßige Genauigkeit über Populationen hinweg (z. B. Alter, Hautfarbe, Sprache, Komorbiditäten). Wenn Trainingsdaten bestimmte Gruppen unterrepräsentieren, kann das System Diagnosen systematisch übersehen oder überintervenieren. Fairness‑Tests, Subgruppen‑Reporting und sorgfältiges Dataset‑Design sind keine optionalen Extras, sondern grundlegende Sicherheitsmaßnahmen.

Datenschutz, Einwilligung und Patientendaten

Zum Trainieren und Verbessern von Modellen werden häufig große Mengen sensibler Gesundheitsdaten benötigt. Das wirft Fragen zu Einwilligung, Sekundärnutzung, De‑Identifikation und wer finanziell profitiert, auf. Gute Governance umfasst klare Patientenhinweise, strikte Zugriffskontrollen und Richtlinien zu Datenaufbewahrung und Modellupdates.

„Human‑in‑the‑loop“ als Sicherheitsmuster

Viele klinische KI‑Tools sind so konzipiert, dass sie assistieren, statt zu ersetzen, und dabei eine Clinician für die finale Entscheidung belassen. Dieses „Human‑in‑the‑loop“‑Muster fängt Fehler ab, liefert Kontext, den das Modell nicht hat, und schafft Verantwortlichkeit — vorausgesetzt, Workflows und Anreize verhindern blindes Vertrauen in die Automatik.

Was das für Ärzt:innen und Jobs im Gesundheitswesen bedeutet

Khoslas Aussage wird oft als „Ärzte werden überflüssig“ verstanden. Nützlicher ist es, Ersetzen (die KI führt eine Aufgabe Ende‑zu‑Ende) vom Umverteilen (Menschen behalten Outcomes‑Verantwortung, die Arbeit verschiebt sich zu Aufsicht, Empathie und Koordination) zu unterscheiden.

Ersetzen vs. Umverteilen

In vielen Settings wird KI wahrscheinlich zuerst Teile klinischer Arbeit ersetzen: Notizen erstellen, Differenzialdiagnosen vorschlagen, Leitlinien‑Checks und Anamnesezusammenfassungen. Die Aufgabe der Clinician verschiebt sich dahin, diese Ergebnisse zu prüfen, kontextualisieren und zu kommunizieren.

Welche Rollen sich zuerst ändern

Primärversorgung wird den Wandel als „Frontdoor“‑Verbesserung spüren: Symptomchecker und ambient‑dokumentation reduzieren Routinebesuche, während komplexe Fälle und beziehungsbasierte Versorgung menschlich bleiben.

Radiologie und Pathologie könnten stärkere direkte Aufgabenverlagerungen sehen, weil die Arbeit bereits digital und musterbasiert ist. Das bedeutet eher höhere Durchsatzraten, neue Qualitätsworkflows und Druck auf Vergütungsmodelle als einen plötzlichen Abbau von Spezialist:innen.

Pflegende bleiben stark bei kontinuierlicher Einschätzung, Education und Koordination. KI kann administrativen Aufwand reduzieren, aber die Pflege am Bett und Eskalationsentscheidungen bleiben menschenzentriert.

Neue Jobs, die entstehen

Erwarten Sie Wachstum in Rollen wie KI‑Supervisor (Monitoring der Modellleistung), klinische Informatik (Workflow‑ und Datenverantwortung) und Care Coordinator (Schließen von Lücken, die das Modell aufzeigt). Diese Funktionen können in bestehenden Teams entstehen statt als komplett neue Hierarchien.

Ausbildung und Zulassung

Medizinische Ausbildung könnte KI‑Literacy integrieren: Wie man Outputs validiert, Reliance dokumentiert und Failure‑Modes erkennt. Die Zulassungspraxis könnte sich zu „Human‑in‑the‑loop“‑Standards entwickeln — wer welche Tools nutzen darf, unter welcher Aufsicht und wie Verantwortlichkeit zugewiesen wird, wenn KI falsch liegt.

Die stärksten Gegenargumente gegen Khoslas Sicht

Khoslas Behauptung provoziert, weil sie „Arzt“ hauptsächlich als Diagnosemaschine betrachtet. Die stärkste Gegenposition argumentiert, dass selbst bei paritätischer Mustererkennung das gesamte Arzt‑Sein eine andere Aufgabe ist.

Medizin ist mehr als Diagnose

Ein großer Teil des klinischen Werts liegt im Framings des Problems, nicht nur in der Antwort. Ärzt:innen übersetzen unordentliche Geschichten in handhabbare Optionen, verhandeln Kompromisse (Risiko, Kosten, Zeit, Werte) und koordinieren Versorgung über Fachgrenzen hinweg. Sie managen Einwilligung, Unsicherheit und „watchful waiting“ — Bereiche, in denen Vertrauen und Verantwortlichkeit genauso zählen wie Genauigkeit.

Evidenzlücken: Studien, Outcomes und Generalisierung

Viele KI‑Systeme wirken in retrospektiven Studien beeindruckend, aber das beweist nicht automatisch bessere reale Outcomes. Der schwierigste Beweis sind prospektive Studien: Verbessert KI die Erkennungsrate, verringert Komplikationen oder überflüssige Tests in verschiedenen Krankenhäusern, Patientengruppen und Workflows?

Generalisierung ist ein weiterer Schwachpunkt. Modelle können abbauen, wenn sich Populationen ändern, Geräte variieren oder Dokumentationsgewohnheiten sich verschieben. Ein System, das an einem Standort gut funktioniert, kann anderswo scheitern — besonders bei seltenen Erkrankungen.

Automationsbias und Überverlassenheit

Selbst starke Werkzeuge schaffen neue Fehlerquellen. Clinician könnten dem Modell zu sehr vertrauen, wenn es falsch liegt (Automationsbias), oder verlieren die Routine, die zweite Frage zu stellen, die Randfälle fängt. Langfristig kann so Kompetenz erodieren, was das Eingreifen gegen fehlerhafte KI erschwert.

Adoption hinkt hinter der Technik her

Gesundheitsversorgung ist kein reiner Technologiemarkt. Haftung, Erstattung, Beschaffungszyklen, EHR‑Integration und Clinician‑Training verlangsamen die Einführung. Patient:innen und Regulierer verlangen möglicherweise weiterhin menschliche Entscheider bei risikoreichen Fällen — sodass „KI überall“ lange Zeit eher wie „KI unter Aufsicht von Ärzt:innen“ aussehen könnte.

Praktische Hinweise für Patient:innen

Kliniker-Dashboard bereitstellen

Erzeugen Sie eine React-Weboberfläche und ein Go-Backend aus einem einzigen Gespräch.

KI ist bereits dezent in der Versorgung präsent — Risikowerte in Ihrer Akte, automatisierte Scan‑Befunde, Symptomchecker und Tools zur Priorisierung. Ziel für Patient:innen ist nicht blinder Vertrauen oder kategorische Ablehnung, sondern zu wissen, was zu erwarten ist und wie man Kontrolle behält.

Was Sie erwarten können (Gutes und Weniger‑Gutes)

Sie werden wahrscheinlich mehr Screening (Nachrichten, Fragebögen, Wearable‑Daten) und schnellere Triage sehen — besonders in vollen Praxen und Notaufnahmen. Das kann schnellere Antworten bei häufigen Problemen und frühere Erkennung mancher Erkrankungen bedeuten.

Die Qualität wird heterogen sein. Manche Tools sind in engen Aufgaben hervorragend; andere versagen bei Alter, Hauttyp, seltenen Erkrankungen oder unordentlichen Real‑World‑Daten. Betrachten Sie KI als Helfer, nicht als endgültiges Urteil.

Fragen, die Sie stellen sollten, wenn KI involviert ist

- Wurde KI für Diagnose, Bildbefundung, Triage oder Therapieempfehlungen genutzt?

- Welche Daten hat die KI verwendet (meine Vorgeschichte, Laborwerte, Bilder, Wearables)?

- Wurde das System an Patient:innen wie mir validiert (Alter, Geschlecht, Ethnie, Vorerkrankungen)?

- Wer ist verantwortlich für die endgültige Entscheidung — meine Clinician oder die Software?

- Kann ich die Begründung oder Evidenz hinter der Empfehlung sehen?

Wie Sie KI‑Ergebnisse interpretieren

Viele KI‑Ausgaben sind Wahrscheinlichkeiten („20 % Risiko“) statt Gewissheiten. Fragen Sie, was die Zahl für Sie bedeutet: Was passiert bei verschiedenen Risikoniveaus, und wie hoch ist die Fehlalarmrate?

Bei Entscheidungen mit hohem Risiko (Operation, Chemo, Absetzen eines Medikaments) holen Sie eine Zweitmeinung — menschlich und/oder ein anderes Tool. Es ist vernünftig zu fragen: „Was würden Sie tun, wenn dieses KI‑Ergebnis nicht existierte?“

Sie sollten informiert werden, wenn Software Ihre Versorgung wesentlich beeinflusst. Wenn Sie sich unwohl fühlen, fragen Sie nach Alternativen, wie Ihre Daten gespeichert werden und ob ein Opt‑out Ihren Zugang beeinträchtigt.

Praktische Hinweise für Kliniken und Teams

KI lässt sich am besten einführen, wenn man sie wie jedes andere klinische Werkzeug behandelt: Use Case definieren, testen, überwachen und Verantwortlichkeiten klären.

Beginnen Sie dort, wo das Risiko gering und das Volumen hoch ist

Bevor Sie KI für Diagnosen nutzen, entfernen Sie Alltagsfriktionen. Sichere frühe Erfolge sind Workflows, die Durchsatz verbessern ohne medizinische Entscheidungen zu übernehmen:

- Dokumentationsunterstützung (Besuchsnotizen, Nachsorge‑Zusammenfassungen)

- Terminplanung, Überweisungen, Prior‑Auth‑Entwürfe

- Patientenkommunikations‑Triage und Routing

Diese Bereiche liefern oft messbare Zeitersparnis und helfen Teams, Veränderungsmanagement zu üben.

Wenn Ihr Team leichte interne Tools zur Unterstützung solcher Workflows braucht — Intake‑Formulare, Routing‑Dashboards, Audit‑Logs, teaminterne Wissensdatenbanken — kann schnelles App‑Bauen genauso viel wert sein wie Modellqualität. Plattformen wie Koder.ai sind für „vibe‑coding“‑Teams gedacht: Sie beschreiben die App im Chat, iterieren schnell und exportieren den Source‑Code, wenn Sie bereit sind, ihn für Produktion zu härten. Für klinische Kontexte behandlen Sie das als Beschleuniger für Operations‑Software und Piloten — bei gleichzeitig erforderlicher Security, Compliance und Validierung.