Warum Kunden bei Limits verwirrt sind

Ratenlimits und Kontingente klingen ähnlich, deshalb behandeln viele Leute sie gleich. Ein Ratenlimit bestimmt, wie schnell Sie eine API aufrufen können (Anfragen pro Sekunde oder pro Minute). Ein Kontingent sagt, wie viel Sie über einen längeren Zeitraum nutzen dürfen (pro Tag, pro Monat oder pro Abrechnungszyklus). Beides ist normal, aber es wirkt willkürlich, wenn die Regeln nicht sichtbar sind.

Die klassische Beschwerde lautet: „Gestern ging es noch.“ Nutzung ist selten konstant. Ein kurzer Spike kann jemanden über die Grenze drücken, selbst wenn die Tagesgesamtmenge in Ordnung aussieht. Stellen Sie sich einen Kunden vor, der einmal am Tag einen Bericht ausführt – heute versucht der Job nach einem Timeout neu und macht in 2 Minuten zehnmal so viele Aufrufe. Die API blockiert ihn, und er sieht nur einen plötzlichen Fehler.

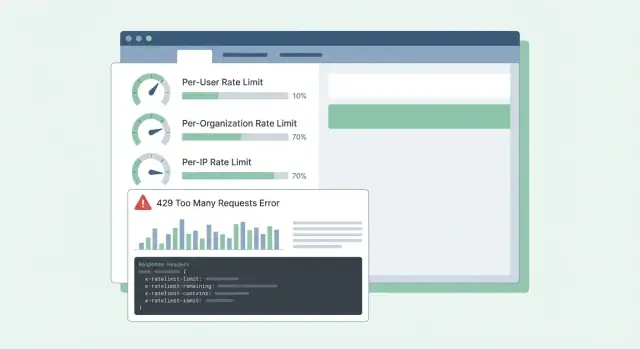

Die Verwirrung wird schlimmer, wenn Fehler vage sind. Wenn die API 500 zurückgibt oder eine generische Nachricht, nimmt der Kunde an, Ihr Dienst sei ausgefallen, nicht, dass ein Limit erreicht wurde. Sie eröffnen dringende Tickets, bauen Workarounds oder wechseln den Anbieter. Selbst 429 Too Many Requests kann frustrierend sein, wenn nicht erklärt wird, wie es weitergeht.

Die meisten SaaS‑APIs begrenzen Traffic aus zwei unterschiedlichen Gründen:

- Missbrauch stoppen: das System vor Scraping, Brute‑Force oder ausufernden Skripten schützen.

- Normales Nutzungsverhalten formen: die Performance für alle stabil halten, besonders in Spitzenzeiten.

Wenn man diese Ziele vermischt, entstehen schlechte Designs. Abuse‑Kontrollen sind oft per‑IP oder per‑Token und können streng sein. Normales Usage‑Shaping ist üblicherweise pro‑Benutzer oder pro‑Organisation und sollte mit klarer Anleitung kommen: welches Limit wurde erreicht, wann setzt es zurück und wie vermeide ich es künftig?

Wenn Kunden Limits vorhersagen können, planen sie darum herum. Können sie es nicht, fühlt sich jeder Spike wie eine kaputte API an.

Entscheiden Sie, was Sie schützen

Ratenlimits sind nicht nur ein Drosselmechanismus. Sie sind ein Sicherheitssystem. Bevor Sie Zahlen wählen, sei klar, was Sie schützen wollen, denn jedes Ziel führt zu anderen Limits und anderen Erwartungen.

Verfügbarkeit steht meist an erster Stelle. Wenn ein paar Clients Traffic spike und Ihre API in Timeouts treiben, leiden alle. Limits hier sollten Server während Bursts reaktionsfähig halten und schnell fehlschlagen, statt Anfragen aufstauen zu lassen.

Kosten sind der stille Treiber vieler APIs. Manche Anfragen sind günstig, andere teuer (LLM‑Calls, Datei‑Verarbeitung, Speicher‑Writes, bezahlte Drittanbieter‑Abfragen). Auf Plattformen wie Koder.ai kann ein einzelner Nutzer viele Modellaufrufe auslösen. Limits, die teure Aktionen nachverfolgen, verhindern Überraschungsrechnungen.

Missbrauch sieht anders aus als legitime hohe Nutzung. Credential‑Stuffing, Token‑Erraten und Scraping zeigen sich oft als viele kleine Anfragen von einem engen Satz an IPs oder Konten. Hier wollen Sie strikte Limits und schnelles Blockieren.

Fairness zählt in Multi‑Tenant‑Systemen. Ein lauter Kunde darf nicht alle anderen beeinträchtigen. In der Praxis bedeutet das oft geschichtete Kontrollen: ein Burst‑Guard für Minute‑zu‑Minute‑Gesundheit, ein Kosten‑Guard für teure Endpunkte oder Aktionen, ein Abuse‑Guard fokussiert auf Auth und verdächtige Muster und ein Fairness‑Guard, damit eine Organisation andere nicht ausstößt.

Ein einfacher Test hilft: Wählen Sie einen Endpunkt und fragen Sie: „Wenn diese Anfrage 10× wird, was bricht zuerst?“ Die Antwort sagt, welches Schutzziel zu priorisieren ist und welche Dimension (User, Org, IP) das Limit tragen sollte.

Wählen Sie die richtigen Limit‑Dimensionen

Die meisten Teams starten mit einem Limit und merken später, dass es die falschen Leute trifft. Ziel ist es, Dimensionen zu wählen, die zur realen Nutzung passen: wer ruft an, wer zahlt und was nach Missbrauch aussieht.

Gängige Dimensionen in SaaS sind:

- Pro Benutzer: verhindert, dass ein schwerer Endnutzer alle anderen im selben Account ausbremst.

- Pro Organisation/Workspace: setzt eine klare Obergrenze für die Nutzung eines Tenants (oft das, was Tarife tatsächlich verkaufen).

- Pro IP: fängt Bots, Credential‑Stuffing und falsch konfigurierte Clients ein, die von einer Adresse hämmern.

- Pro API‑Key/Token: nützlich für Partner und Integrationen, wo „Benutzer“ nicht sinnvoll ist oder geteilt wird.

Per‑User‑Limits sorgen für Fairness innerhalb eines Tenants. Führt eine Person einen großen Export aus, sollte sie die Verlangsamung stärker spüren als der Rest des Teams.

Per‑Org‑Limits betreffen Budget und Kapazität. Selbst wenn zehn Nutzer Jobs gleichzeitig ausführen, sollte die Organisation nicht auf ein Niveau spiken, das Ihren Dienst oder Ihre Preisannahmen bricht.

Per‑IP‑Limits sind am besten als Sicherheitsnetz zu behandeln, nicht als Abrechnungstool. IPs können geteilt sein (Office‑NAT, Mobilfunkanbieter), halten Sie diese Limits also großzügig und nutzen Sie sie hauptsächlich, um offensichtlichen Missbrauch zu stoppen.

Wenn Sie Dimensionen kombinieren, entscheiden Sie, welche „gewinnt“, wenn mehrere Limits greifen. Eine praktische Regel: lehnen Sie die Anfrage ab, wenn ein relevantes Limit überschritten ist, und geben Sie den am besten handlungsfähigen Grund zurück. Wenn ein Workspace sein Organisationskontingent überschreitet, geben Sie nicht dem Benutzer oder der IP die Schuld.

Beispiel: Ein Koder.ai‑Workspace im Pro‑Plan könnte einen stetigen Fluss von Build‑Anfragen pro Organisation erlauben und gleichzeitig einen einzelnen Benutzer daran hindern, hunderte Anfragen pro Minute abzusetzen. Nutzt eine Partner‑Integration einen gemeinsamen Token, kann ein per‑Token‑Limit verhindern, dass sie interaktive Nutzer verdrängt.

Algorithmen, die in Produktion funktionieren

Die meisten Rate‑Limiting‑Probleme sind keine Mathematik‑Aufgaben. Es geht darum, ein Verhalten zu wählen, das zur Art passt, wie Kunden Ihre API aufrufen, und es unter Last vorhersehbar zu halten.

Token‑Bucket ist ein üblicher Default, weil er kurze Bursts erlaubt und gleichzeitig einen langfristigen Durchschnitt durchsetzt. Ein Nutzer, der ein Dashboard aktualisiert, kann 10 schnelle Anfragen auslösen. Token‑Bucket erlaubt das, wenn Token angespart wurden, und drosselt danach.

Leaky‑Bucket ist strenger. Es glättet Traffic zu einem konstanten Ausfluss, was hilft, wenn Ihr Backend Spikes nicht verarbeiten kann (z. B. teure Berichtserstellung). Der Nachteil: Kunden spüren es früher, weil Bursts in Queueing oder Ablehnung übergehen.

Window‑basierte Zähler sind einfach, aber Details zählen. Feste Fenster erzeugen scharfe Kanten an Grenzen (ein Nutzer kann bei 12:00:59 einen Burst haben und wieder bei 12:01:00). Sliding Windows wirken fairer und reduzieren Boundary‑Spikes, brauchen aber mehr State oder bessere Datenstrukturen.

Eine eigene Klasse von Limits sind Concurrency‑Limits (in‑flight requests). Das schützt vor langsamen Client‑Verbindungen und lang laufenden Endpunkten. Ein Kunde kann innerhalb von 60 Anfragen/Minute bleiben und trotzdem 200 offene Requests haben, die Ihr System belasten.

In echten Systemen kombinieren Teams oft eine kleine Menge an Kontrollen: ein Token‑Bucket für die allgemeine Anfrage‑Rate, eine Concurrency‑Begrenzung für langsame oder schwere Endpunkte und separate Budgets für Endpoint‑Gruppen (günstige Reads vs. teure Exporte). Wenn Sie nur nach Anfrageanzahl limitieren, kann ein teurer Endpunkt alles verdrängen und die API zufällig fehlerhaft wirken lassen.

Kontingente entwerfen, die zu Preisen und Nutzung passen

Erstellen Sie eine Rollout‑Checkliste

Erstellen Sie einen gestuften Rollout‑Plan: nur Bericht, warnen, durchsetzen, dann nach Tarif feinabstimmen.

Gute Kontingente wirken fair und vorhersehbar. Kunden sollten die Regeln nicht erst entdecken, nachdem sie blockiert wurden.

Halten Sie die Trennung klar:

- Kurzfristige Ratenlimits (z. B. 10 Anfragen/Sekunde) schützen Ihren Dienst vor Bursts.

- Langfristige Kontingente (täglich/monatlich) schützen vor Kosten und halten Tarifstufen vergleichbar.

Viele SaaS‑Teams nutzen beides: ein kurzes Ratenlimit gegen Bursts plus ein monatliches Kontingent, das an die Preisgestaltung gebunden ist.

Harte vs. weiche Limits sind meist eine Support‑Entscheidung. Ein hartes Limit blockiert sofort. Ein weiches Limit warnt zuerst und blockiert später. Weiche Limits reduzieren wütende Tickets, weil Leute Zeit haben, einen Fehler zu beheben oder upzugraden.

Wenn jemand darüber hinausgeht, sollte das Verhalten zum Schutzziel passen. Blockieren ist sinnvoll, wenn Übernutzung andere Mieter schädigt oder Kosten explodieren. Degradieren (langsamere Verarbeitung oder niedrigere Priorität) ist sinnvoll, wenn Sie lieber alles am Laufen halten. „Später abrechnen“ kann funktionieren, wenn Nutzung vorhersehbar ist und Sie bereits einen Billing‑Flow haben.

Tarifbasierte Limits funktionieren am besten, wenn jede Stufe eine klare „erwartete Nutzung“ hat. Ein Free‑Tier erlaubt kleine Monatskontingente und niedrige Burst‑Raten, während Business‑ und Enterprise‑Tiers höhere Kontingente und höhere Burst‑Limits bekommen, damit Hintergrundjobs schnell fertig werden. Das ist ähnlich zu den Free/Pro/Business/Enterprise‑Stufen bei Koder.ai.

Frühe Unterstützung für kundenspezifische Limits lohnt sich, besonders für Enterprise. Ein sauberes Vorgehen ist „Defaults per Plan, Overrides per Customer“. Speichern Sie ein Admin‑Override pro Organisation (und manchmal pro Endpunkt) und stellen Sie sicher, dass es Planwechsel überlebt. Entscheiden Sie auch, wer Änderungen anfordern kann und wie schnell sie wirksam werden.

Beispiel: Ein Kunde importiert 50.000 Datensätze am letzten Tag des Monats. Wenn sein Monatskontingent fast verbraucht ist, gibt eine weiche Warnung bei 80–90 % Zeit zum Pausieren. Ein kurzes Per‑Second‑Limit verhindert, dass der Import die API flutet. Ein genehmigtes Org‑Override (temporär oder dauerhaft) hält das Geschäft am Laufen.

Schritt für Schritt: Limits in einer SaaS‑API implementieren

Beginnen Sie damit, schriftlich festzulegen, was Sie zählen und wem es gehört. Die meisten Teams landen bei drei Identitäten: der angemeldete Benutzer, die Kunden‑Organisation (oder Workspace) und die Client‑IP.

Ein praktischer Plan:

- Definieren Sie Identity‑Regeln: User‑ID aus Auth, Org‑ID aus dem Token oder API‑Key, IP aus dem ersten vertrauenswürdigen Proxy‑Hop (seien Sie explizit, welchen Header Sie vertrauen).

- Gruppieren Sie Endpunkte nach Kosten: Reads, Writes, schwere Exporte, Auth‑Flows. Geben Sie jeder Gruppe unterschiedliche Limits, damit ein teurer Endpunkt nicht das ganze Budget entleert.

- Wählen Sie, wo Zähler leben: In‑Memory für eine einzelne Instanz, Redis für geteilte Limits über viele Server, und eine Datenbank nur für langsamere Audit‑Kontingente. Nutzen Sie TTLs passend zum Fenster (z. B. 60 Sekunden für Minutenlimits).

- Erzwingen Sie konsistent: grobe Blockade am Edge (Gateway/CDN) für IP‑Floods, dann feinere per‑User/Org‑Checks in der App‑Middleware, wo Route und Tenant sichtbar sind.

- Instrumentieren Sie alles: tracken Sie Block‑Rate (429s), Latenz, die der Limiter hinzufügt, und Top‑Keys, die geblockt werden. Alerten Sie bei Block‑Spikes oder wenn Redis‑Fehler zum „fail open/closed“ zwingen.

Wenn Sie Limits setzen, denken Sie in Tarifen und Endpoint‑Gruppen, nicht in einer globalen Zahl. Ein häufiger Fehler ist, sich auf In‑Memory‑Zähler auf mehreren App‑Servern zu verlassen. Zähler geraten außer Einklang und Nutzer sehen „zufällige“ 429s. Ein geteilter Store wie Redis hält Limits über Instanzen stabil und TTLs halten Daten klein.

Der Rollout zählt. Starten Sie im „nur Bericht“‑Modus (loggen, was geblockt würde), dann erzwingen Sie eine Endpoint‑Gruppe, dann erweitern. So vermeiden Sie, morgens von Support‑Tickets überrannt zu werden.

Wenn ein Kunde ein Limit trifft, ist das Schlimmste Verwirrung: „Ist eure API down, oder habe ich etwas falsch gemacht?“ Klare, konsistente Antworten reduzieren Support‑Tickets und helfen, Client‑Verhalten zu korrigieren.

Nutzen Sie HTTP 429 Too Many Requests, wenn Sie aktiv blocken. Halten Sie den Antwortkörper vorhersehbar, damit SDKs und Dashboards ihn auslesen können.

Hier ist eine einfache JSON‑Form, die für per‑User, per‑Org und per‑IP‑Limits gut funktioniert:

{

"error": {

"code": "rate_limit_exceeded",

"message": "Rate limit exceeded for org. Try again later.",

"limit_scope": "org",

"reset_at": "2026-01-17T12:34:56Z",

"request_id": "req_01H..."

}

}

Header sollten das aktuelle Fenster und die nächsten Schritte erklären. Wenn Sie nur ein paar hinzufügen, beginnen Sie mit: RateLimit-Limit, RateLimit-Remaining, RateLimit-Reset, Retry-After und X-Request-Id.

Beispiel: Ein Cron‑Job läuft jede Minute und fängt plötzlich an zu fehlschlagen. Mit 429 plus RateLimit‑Remaining: 0 und Retry‑After: 20 weiß der Kunde sofort, dass es ein Limit ist und kein Ausfall, und kann Retries um 20 Sekunden verzögern. Teilt er X‑Request‑Id mit dem Support, finden Sie das Ereignis schnell.

Noch ein Detail: Geben Sie die gleichen Header auch bei erfolgreichen Antworten zurück. Kunden sehen so, dass sie sich der Grenze nähern, bevor sie sie erreichen.

Client‑Verhalten: Retries, Backoff und sichere Writes

Entwerfen Sie Ihr Ratenlimit‑Spec

Beschreiben Sie Ihre API und Ihre Tarife – Koder.ai hilft beim Entwurf von Limits, Headern und Reset-Regeln.

Gute Clients lassen Limits fair wirken. Schlechte Clients verwandeln ein temporäres Limit in einen Ausfall, indem sie härter nachhämmern.

Bei 429 behandeln Sie die Antwort als Signal zu verlangsamen. Wenn die Antwort angibt, wann erneut versucht werden soll (z. B. via Retry‑After), warten Sie mindestens so lange. Wenn nicht, nutzen Sie exponentielles Backoff und fügen Jitter hinzu, damit nicht tausend Clients gleichzeitig retryen.

Begrenzen Sie Retries: cappen Sie die Verzögerung zwischen Versuchen (z. B. 30–60 Sekunden) und die gesamte Retry‑Zeit (z. B. nach 2 Minuten abbrechen und einen Fehler anzeigen). Loggen Sie das Ereignis mit Limit‑Details, damit Entwickler später nachsteuern können.

Versuchen Sie nicht alles erneut. Viele Fehler lassen sich ohne Änderung nicht beheben: 400 Validierungsfehler, 401/403 Auth‑Fehler, 404 Not Found und 409 Konflikte, die eine Geschäftsregel widerspiegeln.

Retries sind riskant bei Schreibendpunkten (create, charge, send email). Tritt ein Timeout auf und der Client versucht erneut, können Duplikate entstehen. Nutzen Sie Idempotency‑Keys: Der Client sendet pro logischer Aktion einen eindeutigen Key, und der Server liefert bei Wiederholungen dasselbe Ergebnis.

Gute SDKs machen das einfacher, indem sie Entwicklern genau das zeigen, was sie brauchen: Status (429), wie lange zu warten ist, ob die Anfrage sicher erneut versucht werden kann, und eine klare Nachricht wie „Rate limit exceeded for org. Retry after 8s or reduce concurrency.".

Häufige Fehler, die wütende Tickets erzeugen

Die meisten Support‑Tickets zu Limits drehen sich nicht ums Limit selbst, sondern um Überraschungen. Wenn Nutzer nicht vorhersagen können, was passiert, denken sie, die API sei kaputt oder unfair.

Nur IP‑basierte Limits zu verwenden, ist ein häufiger Fehler. Viele Teams stehen hinter einer öffentlichen IP (Office‑WLAN, Mobilfunk, Cloud‑NAT). Wenn Sie nach IP caps setzen, kann ein beschäftigter Kunde alle anderen im selben Netzwerk blockieren. Bevorzugen Sie per‑User und per‑Org Limits und nutzen Sie per‑IP nur als Abuse‑Netz.

Ein weiteres Problem ist, alle Endpunkte gleich zu behandeln. Ein günstiger GET und ein schwerer Export sollten nicht dasselbe Budget teilen. Andernfalls verbrauchen Kunden ihr Kontingent beim normalen Surfen und werden blockiert, wenn sie eine ernsthafte Aufgabe starten. Trennen Sie Buckets nach Endpoint‑Gruppen oder gewichten Sie Anfragen nach Kosten.

Auch die Reset‑Timing muss explizit sein. „Resettet täglich“ reicht nicht. Welche Zeitzone? Rolling Window oder Mitternachts‑Reset? Bei Kalender‑Resets nennen Sie die Zeitzone. Bei Rolling‑Windows geben Sie die Fensterlänge an.

Vage Fehler schaffen Chaos. 500 oder generische JSON‑Fehler regen zum verstärkten Retry an. Nutzen Sie 429 und fügen Sie RateLimit‑Header hinzu, damit Clients intelligent drosseln.

Beispiel: Wenn ein Team eine Koder.ai‑Integration aus einem gemeinsamen Firmen‑Netzwerk baut, kann ein reines IP‑Cap ihre ganze Organisation blockieren und wie zufällige Ausfälle wirken. Klare Dimensionen und klare 429‑Antworten verhindern das.

Schnelle Checkliste vor dem Rollout

Schreibvorgänge retry‑sicher machen

Generieren Sie Idempotency‑Key‑Handling, damit Retries keine doppelten Abbuchungen oder Schreibvorgänge erzeugen.

Bevor Sie Limits für alle einschalten, machen Sie eine finale Runde mit Fokus auf Vorhersehbarkeit:

- Definieren Sie Limits nach Tarifstufe und Endpoint‑Gruppe (Auth, Reads, Writes, Exports). Lassen Sie einen kleinen Sicherheits‑Puffer für Essenzielles wie Login und Token‑Refresh.

- Machen Sie Identity‑Regeln deterministisch und dokumentiert. Entscheiden Sie genau, wie Sie zählen (User, Org, API‑Key, IP) und was Vorrang hat.

- Machen Sie 429‑Antworten selbsterklärend. Fügen Sie Retry‑After plus RateLimit‑Header (Limit, Remaining, Reset) hinzu. Im JSON‑Body eine kurze Nachricht, welches Limit getroffen wurde und wann retry möglich ist.

- Überwachen Sie sowohl Spikes als auch False‑Positives. Tracken Sie 429‑Raten nach Endpoint‑Gruppe, Top‑Caller und plötzliche Einbrüche erfolgreicher Anfragen. Alerten Sie bei Block‑Spitzen.

- Haben Sie einen Ausnahmetopf: Whitelists, temporäre Erhöhungen, Notfall‑Overrides und wer sie genehmigen kann.

Ein Bauchgefühl‑Check: Wenn Ihr Produkt Tarife wie Free, Pro, Business und Enterprise hat (wie Koder.ai), sollten Sie in einfachen Worten erklären können, was ein normaler Kunde pro Minute und pro Tag tun kann und welche Endpunkte anders behandelt werden.

Wenn Sie ein 429 nicht klar erklären können, nehmen Kunden an, die API sei kaputt, nicht, dass sie den Dienst schützt.

Beispiel‑Rolloutplan und nächste Schritte

Stellen Sie sich ein B2B‑SaaS vor, in dem Menschen innerhalb eines Workspaces (Org) arbeiten. Einige Power‑User führen schwere Exporte durch, und viele Mitarbeiter sitzen hinter einer gemeinsamen Büro‑IP. Limitieren Sie nur nach IP, blockieren Sie ganze Firmen. Limitieren Sie nur nach User, kann ein einzelnes Script trotzdem den Workspace schädigen.

Eine praktikable Mischung ist:

- Per‑User‑Burst‑Limit für kurze Spitzen.

- Per‑Org‑Sustained‑Limit, damit der Workspace über die Zeit fair bleibt.

- Per‑IP‑Abuse‑Guard, um geleakte Tokens, Bots und laute geteilte Netze zu erkennen.

Wenn jemand ein Limit trifft, sollte Ihre Nachricht erklären, was passiert ist, was zu tun ist und wann ein Retry sinnvoll ist. Der Support sollte hinter Formulierungen stehen wie:

„Request rate exceeded for workspace ACME. You can retry after 23 seconds. If you are running an export, reduce concurrency to 2 or schedule it off‑peak. If this blocks normal use, reply with your workspace ID and timestamp and we can review your quota."

Koppeln Sie diese Nachricht mit Retry-After und konsistenten RateLimit‑Headern, damit Kunden nicht raten müssen.

Ein Rollout, der Überraschungen vermeidet: zuerst nur beobachten, dann warnen (Header und Soft‑Warnings), dann durchsetzen (429s mit klarer Retry‑Zeit), dann Schwellen nach Tarif abstimmen und nach großen Releases und Kunden‑Onboardings überprüfen.

Wenn Sie schnell diese Ideen in lauffähigen Code verwandeln wollen, kann eine Vibe‑Coding‑Plattform wie Koder.ai (koder.ai) Ihnen helfen, ein kurzes Rate‑Limit‑Spec zu entwerfen und Go‑Middleware zu generieren, die es konsistent über Services hinweg durchsetzt.