Warum Kurzweils AGI‑Vorhersagen wichtig sind

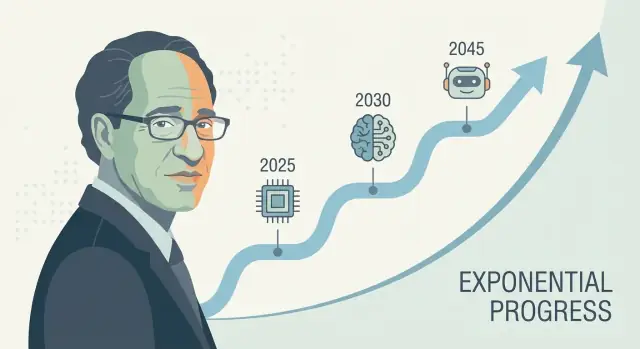

Ray Kurzweil ist eine der bekanntesten Stimmen in der langfristigen Technologie‑Prognose—insbesondere im Bereich künstliche Intelligenz und technologische Singularität. Wenn er eine konkrete AGI‑Vorhersage macht (oft als Datum formuliert, nicht als vages „irgendwann“), hat das Wirkung: Investoren zitieren sie, Journalisten debattieren, und Forschende werden gebeten, Stellung zu nehmen.

Warum seinen Vorhersagen Aufmerksamkeit geschenkt wird

Kurzweils Einfluss beruht nicht nur auf Optimismus. Er bietet eine wiederholbare Erzählung dafür, warum Fortschritt sich beschleunigen sollte—häufig verknüpft mit exponentiellem Wachstum der Rechenleistung und der Idee, dass jede Generation von Werkzeugen die nächste erleichtert. Ob man zustimmt oder nicht: Er liefert eine strukturierte Möglichkeit, über eine Zeitachse für künstliche allgemeine Intelligenz zu sprechen, statt sie als reine Science‑Fiction abzutun.

Was „Jahrzehnte im Voraus vorhersagen“ wirklich bedeutet

Eine Jahrzehnte‑Vorhersage ist weniger ein Kalenderraten als das Weiterprojizieren eines Bündels von Trends: Rechenleistung, Kosten, Daten, Algorithmen und die praktische Fähigkeit, generalisierende Systeme zu bauen. Die Wette lautet, dass sich diese Kurven weiterbewegen—und dass heutige „fehlende Teile“ lösbare Engineering‑Probleme sind, die mit besseren Inputs schrumpfen.

Was Sie in diesem Artikel lernen werden

Dieser Beitrag zerlegt:

- die Methode hinter Kurzweils Technologie‑Prognosen (was er misst und extrapoliert),

- welche Daten die Sicht stützen, dass KI‑Fortschritt sich beschleunigt—und wo die Daten dünn sind,

- die stärksten Kritiken an Prognosen, die exponentielles Wachstum linear fortschreiben,

- praktische Erkenntnisse, wie man Prognosen als Planungsinstrument nutzt, ohne sie als Gewissheit zu nehmen.

Ein kurzer Hinweis zur Unsicherheit

Sogar unter seriösen Expert*innen variieren AGI‑Zeitachsen stark, weil sie von Annahmen abhängen: was „AGI“ bedeutet, welche Engpässe am wichtigsten sind und wie schnell Durchbrüche in verlässliche Produkte übersetzt werden. Kurzweils Zeitachsen sind einflussreich nicht, weil sie garantiert sind, sondern weil sie spezifisch genug sind, um getestet zu werden—und schwer zu ignorieren.

Wer ist Ray Kurzweil?

Ray Kurzweil ist ein US‑Erfinder, Autor und Futurist, bekannt dafür, langfristige Technologie‑Prognosen zu machen—und diese mit Diagrammen, historischen Daten und kühnen Fristen zu untermauern.

Erfinder, Unternehmer und „Musterdetektor"

Kurzweil wurde zunächst durch praktische Erfindungen bekannt, besonders in Sprach‑ und Texttechnologien. Er gründete Firmen im Bereich optische Zeichenerkennung (OCR), Text‑to‑Speech und Musiktools und stand jahrzehntelang nahe an realen Produktgrenzen: Datenqualität, Hardwarekosten und Nutzerakzeptanz. Diese Macher‑Perspektive prägt seine Prognosen—er neigt dazu, Fortschritt als etwas zu sehen, das konstruiert und skaliert werden kann.

Er arbeitete außerdem in großen Tech‑Organisationen (u. a. Google), was seine Ansicht stärkte, dass große Sprünge oft aus anhaltenden Investitionen, besseren Werkzeugen und aufsummierenden Verbesserungen entstehen—nicht nur aus isolierten Durchbrüchen.

Schlüsselbücher und Ideen, die die AGI‑Debatte prägen

Kurzweils AGI‑Zeitachse wird meist durch seine populären Bücher diskutiert, insbesondere The Age of Spiritual Machines (1999) und The Singularity Is Near (2005). Diese Arbeiten argumentieren, dass Informationstechnologien sich in beschleunigender, aufsummierender Weise verbessern—und dass diese Beschleunigung schließlich Maschinen mit menschenähnlichen (und darüber hinausgehenden) Fähigkeiten hervorbringt.

Ob man zustimmt oder nicht: Seine Schriften halfen, die öffentliche Diskussion zu prägen: KI‑Fortschritt als messbar, trendgesteuert und (zumindest prinzipiell) prognostizierbar.

Kurze Definitionen (damit wir dasselbe meinen)

AGI (Artificial General Intelligence): ein KI‑System, das eine breite Palette von Aufgaben auf ungefähr menschlichem Niveau lernen und ausführen kann und sich an neue Probleme anpasst, ohne eng spezialisiert zu sein.

Singularität: Kurzweils Begriff für eine Periode, in der technologischer Fortschritt so schnell wird (und KI so leistungsfähig), dass er die Gesellschaft auf nicht vorhersagbare, schwer modellierbare Weise verändert.

Zeitachse: eine Prognose mit Daten und Meilensteinen (z. B. „menschenähnliche KI bis Jahr X“), nicht nur die allgemeine Behauptung, dass Fortschritt weitergeht.

Kurzweils Kernthesen zu AGI‑Zeitachsen

Kurzweil hat wiederholt argumentiert, dass menschenähnliche AGI wahrscheinlich innerhalb der ersten Hälfte des 21. Jahrhunderts liegt—am bekanntesten sind Hinweise auf die späten 2020er bis 2030er Jahre in öffentlichen Vorträgen und Büchern. Er nennt nicht unbedingt immer ein einzelnes Jahr, aber die zentrale Behauptung ist konsistent: Sobald Rechenleistung, Daten und Algorithmen bestimmte Schwellen überschreiten, werden Systeme die Breite und Anpassungsfähigkeit menschlicher Kognition erreichen.

Wie AGI mit der „Singularität“ verknüpft ist

In Kurzweils Deutung ist AGI nicht das Endziel—sondern ein Auslöser. Sobald Maschinen menschenähnliche (und dann übermenschliche) allgemeine Intelligenz erreichen, akkumuliert Fortschritt: intelligentere Systeme helfen, noch intelligentere Systeme zu entwerfen, was wissenschaftliche Entdeckungen, Automatisierung und Mensch‑Maschine‑Integration beschleunigt. Diese aufsummierende Dynamik verbindet er mit der weiter gefassten Idee der „technologischen Singularität“: eine Periode, in der Veränderungen so rasch erfolgen, dass Alltagsintuition als verlässlicher Leitfaden versagt.

AGI vs. heutige KI‑Systeme

Ein wichtiger Unterschied in seinen Zeitangaben liegt in der Definition von AGI. Heutige Top‑Modelle sind in vielen Aufgaben beeindruckend, bleiben aber häufig:

- außerhalb der Trainingsmuster brüchig,

- schwach bei langfristiger Planung und realer Verankerung,

- abhängig von menschenkuratieren Zielen und Bewertungen.

Kurzweils „AGI“ impliziert ein System, das Lernen über Domänen hinweg übertragen kann, Ziele in neuen Situationen bildet und verfolgt und zuverlässig mit der offenen Vielfalt der realen Welt umgeht—nicht bloß in Benchmarks brilliert.

Warum Meilensteine besser sind als ein Einzeljahr

Eine Kalenderprognose ist leicht zu diskutieren und schwer zu nutzen. Meilensteine sind praktischer: anhaltendes autonomes Lernen, verlässliche Werkzeugnutzung und Planung, starke Leistung in unordentlichen realen Umgebungen und klare wirtschaftliche Substitution über viele Jobtypen hinweg. Auch wenn Sie mit seiner genauen Zeitplanung nicht übereinstimmen, machen diese Prüfpunkte die Prognose testbar—und nützlicher als auf ein Schlagwortjahr zu wetten.

Bilanz: Treffer, Fehlschläge und was diskutierbar ist

Kurzweil wird oft als „serieller Prophet“ beschrieben, und dieses Image trägt dazu bei, dass seine AGI‑Zeitachse viel Beachtung findet. Sein Trefferverhältnis ist gemischt und lehrreich: Einige Aussagen waren spezifisch und messbar, andere richtungsweisend, aber unscharf, und manche unterschätzten wichtige Einschränkungen.

Nennenswerte Vorhersagen, die oft mit Kurzweil verknüpft werden

In Büchern und Vorträgen wird er mit Prognosen wie diesen assoziiert:

- Computer verbessern sich stetig in Kosten/Leistung (als Fortsetzung von Moores‑Gesetz‑ähnlichen Trends),

- Spracherkennung wird für Verbraucher breit nutzbar,

- mobiles, immer verbundenes Rechnen wird Standard,

- KI übertrifft Menschen in engen Aufgaben (Spiele, Mustererkennung),

- zunehmende „Mensch–Maschine“‑Integration (Wearables, Implantate, Assistenztechnologie).

Klare, überprüfbare vs. vage Vorhersagen

Klare, überprüfbare Vorhersagen sind an ein Datum und ein messbares Ergebnis gebunden: „bis Jahr X wird Technologie Y Leistung Z erreichen“ oder „die Mehrheit der Geräte hat Feature F.“ Diese lassen sich gegen Benchmarks (Genauigkeitsraten, Verkaufs‑/Adoptionsdaten, Rechenkosten) prüfen.

Vage Vorhersagen klingen plausibel, sind aber schwer zu widerlegen, z. B. „Computer werden überall sein“, „KI wird die Gesellschaft transformieren“ oder „Menschen verschmelzen mit Technologie“. Diese Aussagen mögen wahr erscheinen, auch wenn Details, Timing oder Mechanismus abweichen.

Wie man „richtig“, „teilweise richtig“ und „falsch“ beurteilt (ohne Punkte zu vergeben)

Ein praktischer Weg, einen Prognostiker zu bewerten, ist, Richtung, Timing und Spezifizität zu trennen.

- Richtig: Das Ergebnis stimmt mit der Behauptung überein und das Timing ist nah genug, dass es Erwartungen deutlich gelenkt hat.

- Teilweise richtig: Die Richtung stimmt, aber das Timing verschiebt sich, die Adoption ist langsamer oder das Ergebnis tritt in anderer Form auf (z. B. „funktioniert in Demos“ vs. „funktioniert für die meisten Menschen, die meiste Zeit“).

- Falsch: Wichtige Einschränkungen wurden unterschätzt—Datenlimitationen, Regulierung, Nutzerverhalten, Kosten oder die Lücke zwischen Laborleistung und realer Zuverlässigkeit.

Der Punkt ist nicht, Prognosen als „gut“ oder „schlecht“ zu brandmarken, sondern zu erkennen, wie datenbasierte Aussagen dennoch auf versteckten Annahmen beruhen—insbesondere wenn soziale Adoption ins Spiel kommt, nicht nur bessere Hardware oder Algorithmen.

Das „Gesetz der beschleunigten Erträge“ einfach erklärt

Kurzweils „Law of Accelerating Returns“ besagt, dass sich eine Technologie oft schneller verbessert, weil Verbesserungen selbst das weitere Verbessern erleichtern. Das erzeugt eine Rückkopplung, in der Fortschritt mit der Zeit beschleunigt.

Exponentielle Trends ohne Mathematik

Eine lineare (geradlinige) Entwicklung ist wie jedes Jahr denselben Betrag addieren: 1, 2, 3, 4.

Ein exponentieller Verlauf ist wie multiplizieren: 1, 2, 4, 8. Anfangs wirkt es langsam—dann scheint plötzlich alles gleichzeitig zu passieren. Kurzweil argumentiert, dass viele Technologien (insbesondere Informationstechnologien) diesem Muster folgen, weil jede Werkzeuggeneration die nächste erleichtert.

Warum Kosten/Leistungs‑Kurven für seine Zeitachsen wichtig sind

Kurzweil fragt nicht nur „Können wir X?“ sondern „Wie günstig können wir X tun?“ Ein typisches Muster in der Informatik: Leistung steigt, während Kosten sinken. Wenn die Kosten für das Betreiben eines nützlichen Modells fallen, können mehr Menschen experimentieren, Produkte ausrollen und die nächste Welle finanzieren—das beschleunigt Fortschritt.

Deshalb achtet er auf langfristige Kurven wie „Rechenoperationen pro Dollar“, nicht nur auf spektakuläre Demos.

Wo Moores Gesetz hineinpasst—und wo nicht

Moores Gesetz ist das klassische Beispiel: Jahrzehnte lang hat sich die Transistoranzahl auf Chips in regelmäßigen Abständen ungefähr verdoppelt, wodurch Computer schneller und günstiger wurden.

Kurzweils Argument lautet nicht „Moores Gesetz hält ewig“. Es ist breiter: Selbst wenn ein Hardware‑Ansatz langsamer wird, können andere Methoden (bessere Chips, GPUs/TPUs, Parallelität, neue Architekturen, Software‑Effizienz) den Gesamtkost/Leistungs‑Trend weiter verbessern.

Warum geradliniges Denken in die Irre führt

Menschen sagen oft die Zukunft voraus, indem sie jüngste Änderungen mit derselben Geschwindigkeit fortschreiben. Das übersieht Aufsummierung. Es lässt frühen Fortschritt unbedeutend erscheinen—und späteren Fortschritt „plötzlich“, obwohl er Jahre lang vorhersehbar auf einer Kurve aufgebaut wurde.

Welche Daten diese Prognosen stützen (und begrenzen)

Baue das nächste Experiment

Erstelle eine Web‑App aus dem Chat und passe sie an, wenn sich Annahmen ändern.

Prognosen wie die von Kurzweil beginnen meist mit messbaren Trends—Dingen, die man in ein Diagramm setzen kann. Das ist eine Stärke: Man kann die Eingaben debattieren, statt nur intuitiv zu streiten. Genau hier treten aber auch die größten Grenzen zutage.

Die „leicht messbaren“ Kurven: Rechenleistung, Speicher, Bandbreite, Kosten

Technologie‑Prognostiker verfolgen häufig:

- Rechenleistung (wie viele Operationen man pro Dollar kaufen kann),

- Speicher (wie viel Daten man pro Dollar speichern kann),

- Bandbreite (wie schnell man Daten zu welchem Preis bewegen kann),

- Kostenrückgänge (für Chips, Cloud‑Instanzen, Trainingsläufe und Energie pro Arbeitseinheit).

Diese Kurven sind überzeugend, weil sie langlaufend und regelmäßig aktualisiert werden. Wenn Ihre Sicht auf AGI lautet „genug Hardware plus richtige Software“, fühlen sich diese Datensätze wie solides Fundament an.

Hardware‑Fortschritt ist nicht gleich Fähigkeitsfortschritt

Die Hauptlücke: mehr Hardware macht Systeme nicht automatisch klüger. KI‑Fähigkeit hängt von Algorithmen, Datenqualität, Trainingsrezepten, Tooling und menschlichem Feedback ab—nicht nur von FLOPs.

Ein nützlicher Denkansatz: Hardware ist ein Budget, Fähigkeit ist das Resultat. Die Beziehung ist real, aber nicht fest. Manchmal öffnet eine kleine algorithmische Änderung große Sprünge; manchmal trifft Skalierung auf abnehmende Erträge.

Warum Benchmarks und reale Nutzung wichtig sind

Um „Inputs“ (Rechenleistung, Geld) mit „Outputs“ (was Modelle tatsächlich können) zu verbinden, brauchen Prognostiker:

- Benchmarks, die Schlussfolgern, Planen und Generalisieren messen—nicht nur Mustererkennung,

- reale Leistung in unordentlichen Umgebungen: Zuverlässigkeit, Sicherheit, langfristige Aufgaben und Anpassungsfähigkeit.

Benchmarks lassen sich manipulieren; die überzeugendsten Signale kombinieren Testergebnisse mit Belegen für dauerhaften Nutzen.

Häufige Fallstricke: saubere Diagramme, verborgene Engpässe

Zwei häufige Fehler sind Cherry‑Picking von Kurven (Zeiträume wählen, die exponentiell wirken) und Ignorieren von Engpässen wie Energie, Datengrenzen, Latenz, Regulierung oder der Schwierigkeit, enge Kompetenz in allgemeine Kompetenz zu verwandeln. Diese Faktoren beenden Vorhersagen nicht unbedingt—sie vergrößern aber die Fehlerbalken.

Zentrale Annahmen hinter Jahrzehnte‑weiten Prognosen

Langfristige AGI‑Zeitachsen—auch Kurzweils—hängen weniger von einem einzelnen „Durchbruch“ ab als von einem Stapel von Annahmen, die gleichzeitig zutreffen müssen. Schwächt sich eine Schicht ab, kann das Datum verschieben, obwohl Fortschritt weiterläuft.

1) Rechenleistung, Algorithmen und Daten wachsen weiter aufaddiert

Die meisten Jahrzehnte‑Vorhersagen setzen voraus, dass drei Kurven gemeinsam steigen:

- Rechen‑Skalierung wird weiterhin günstiger und einfacher einsetzbar (mehr Chips, größere Cluster, bessere Ausnutzung).

- Algorithmischer Fortschritt liefert weiter große Effizienzgewinne—jede Recheneinheit bringt dann mehr Fähigkeit.

- Datenverfügbarkeit bleibt ausreichend, sei es durch neue Quellen (multimodale Daten), synthetische Daten, bessere Labeling‑Tools oder verbesserte Selbstüberwachung.

Eine versteckte Annahme: Diese drei Treiber substituieren sich nicht perfekt. Wenn die Datenqualität stagniert, liefert „einfach mehr Rechenleistung“ geringere Erträge.

2) Physische und industrielle Beschränkungen schlagen nicht zu stark zu

Prognosen behandeln Rechenleistung oft als glatte Kurve, doch die Realität läuft über Fabriken und Stromnetze. Energiepreise, Chipfertigungskapazität, Exportkontrollen, Speicher‑Bandbreite, Netzwerkgeräte und Lieferketten‑Schocks können das Training und den Rollout bremsen. Selbst wenn die Theorie „10× mehr Rechenleistung“ sagt, kann der Weg dorthin holprig und teuer sein.

3) Menschliche Systeme erlauben schnelle Bereitstellung

Langfristprognosen gehen auch davon aus, dass die Gesellschaft die Einführung nicht zu stark verlangsamt:

Regulierung, Haftung, öffentliches Vertrauen, Arbeitsplatzintegration und Rendite beeinflussen, ob fortgeschrittene Systeme trainiert und breit eingesetzt werden—oder in engen, hoch‑Reibungs‑Umgebungen verbleiben.

4) Fähigkeitszuwächse führen zur Generalität

Vielleicht die größte Annahme: Fähigkeitsverbesserungen durch Skalierung konvergieren naturgemäß zur allgemeinen Intelligenz. „Mehr Rechenleistung“ kann Modelle flüssiger und nützlicher machen, aber nicht automatisch generaler im Sinne zuverlässiger Domänenübertragung, langfristiger Autonomie oder stabiler Ziele. Langfristprojektionsszenarien nehmen oft an, dass diese Lücken Engineering‑Probleme sind—keine fundamentalen Barrieren.

Was AGI verzögern könnte (auch wenn Trends weiterlaufen)

Bauen und Credits verdienen

Erhalte Credits, indem du teilst, was du gebaut hast, oder andere einlädst, Koder.ai zu testen.

Selbst wenn Rechenleistung und Modellgrößen weiter steigen, kann AGI später eintreten als prognostiziert, weil Engpässe kaum mit reiner Geschwindigkeit zu tun haben. Einige Bottlenecks betreffen was wir bauen und wie wir seine Funktionsfähigkeit verifizieren.

1) Die Zielsetzung kann weiter unscharf bleiben

„AGI“ ist kein einzelnes Merkmal, das man einschalten kann. Eine nützliche Definition impliziert in der Regel einen Agenten, der neue Aufgaben schnell lernt, Fähigkeiten über Domänen transferiert, langfristig plant und messbar zuverlässig mit wechselnden Zielen umgeht.

Wenn das Ziel ständig wandert—plaudernder Assistent vs. autonomer Arbeiter vs. Wissenschaftler‑Level—dann kann Fortschritt beeindruckend wirken, ohne Schlüsselkompetenzen wie Langzeitgedächtnis, kausales Denken oder konsistente Entscheidungsfindung zu erreichen.

2) AGI messbar zu machen ist schwieriger als GPUs zu zählen

Benchmarks lassen sich überlisten, überanpassen oder sie veralten. Kritiker*innen verlangen typischerweise Belege dafür, dass eine KI unbekannte Aufgaben meistert, unter neuen Einschränkungen besteht, mit niedrigen Fehlerraten und wiederholbaren Ergebnissen. Gelingt es der Feld nicht, Tests zu vereinbaren, die „exzellente Mustervervollständigung“ von „genereller Kompetenz“ trennen, werden Zeitlinien spekulativ—und Vorsicht kann den Rollout verlangsamen.

3) Alignment und Sicherheit können der Taktgeber werden

Fähigkeiten können schneller wachsen als Kontrollierbarkeit. Werden Systeme agentischer, steigt die Messlatte, um Täuschung, Zielabdrift und schädliche Nebeneffekte zu verhindern.

Regeln, Audits und Safety‑Engineering können Zeit kosten—insbesondere bei Einsatzfällen mit hohen Risiken.

4) Embodiment und reale Interaktion bleiben offene Fragen

Viele AGI‑Definitionen setzen implizit Kompetenz in der physischen Welt voraus: Objekte manipulieren, Experimente durchführen, Werkzeuge bedienen und sich an Echtzeit‑Feedback anpassen.

Bleibt reales Lernen datenhungrig, langsam oder riskant, kann AGI auf „brillant auf dem Bildschirm“ verharren—praktische Generalität wiederum wartet auf bessere Robotik, Simulationen und sichere Trainingsmethoden.

Hauptkritiken an Kurzweils Ansatz

Kurzweils Prognosen sind einflussreich, weil sie klar und quantitativ sind—aber genau diese Klarheit lädt zu scharfer Kritik ein.

Ein häufiger Einwand lautet, Kurzweil stütze sich stark darauf, historische Kurven (Rechenleistung, Speicher, Bandbreite) in die Zukunft zu verlängern. Kritiker meinen, Technologie skaliere nicht immer glatt: Chipfortschritt kann langsamer werden, Energiekosten können treffen und wirtschaftliche Anreize sich verschieben. Selbst wenn die Langfrist‑Richtung steigend bleibt, kann die Rate sich so ändern, dass spezifische Daten unzuverlässig werden.

2) Komplexe Systeme liefern Durchbrüche nicht planbar

AGI ist nicht nur eine Angelegenheit schnellerer Hardware. Es ist ein Problem komplexer Systeme mit Algorithmen, Daten, Trainingsmethoden, Evaluation, Sicherheitsauflagen und menschlicher Adoption. Durchbrüche können durch eine einzige fehlende Idee blockiert werden—etwas, das sich nicht zuverlässig „kalendern“ lässt. Skeptiker verweisen darauf, dass Wissenschaft oft durch ungleichmäßige Schritte voranschreitet: lange Plateaus, gefolgt von plötzlichen Sprüngen.

3) Selektions‑Effekte lassen kühne Vorhersagen besser aussehen

Eine psychologische Kritik besagt: man erinnert sich eher an dramatische richtige Vorhersagen als an die stillen Fehlschläge. Wenn jemand viele starke Prognosen macht, dominieren einige erinnerungswürdige Treffer die Wahrnehmung. Das heißt nicht, dass der Prognostiker grundsätzlich „falsch“ ist, aber es kann die Verlässlichkeit von Zeitangaben überschätzen.

4) Warum kluge Leute bei Zeitachsen uneins sind

Selbst Expert*innen, die schnellen KI‑Fortschritt akzeptieren, unterscheiden sich darin, was als AGI gilt, welche Fähigkeiten generalisieren müssen und wie man sie misst. Kleine Definitionsunterschiede (Aufgabenspektrum, Autonomie, Zuverlässigkeit, reales Lernen) können Zeitachsen um Jahrzehnte verschieben—ohne dass jemand seine Sicht auf den aktuellen Fortschritt ändert.

Wie andere Expert*innen AGI‑Zeitachsen prognostizieren

Kurzweil ist eine laute Stimme, aber AGI‑Zeitlinien sind ein dichtes Streitfeld. Eine nützliche Unterscheidung ist das Nahfrist‑Lager (AGI innerhalb einiger Jahre bis ein bis zwei Jahrzehnte) versus das Langfrist‑Lager (mehrere Jahrzehnte oder „nicht in diesem Jahrhundert“). Beide betrachten oft dieselben Trends, sind sich aber uneins, was noch fehlt: Nahfrist‑Denker betonen schnelles Skalieren und emergente Fähigkeiten; Langfrist‑Denker heben ungelöste Probleme wie verlässliches Schließen, Autonomie und reale Robustheit hervor.

Expertenumfragen sammeln Meinungen von Forschenden und Praktiker*innen (z. B. Umfragen, die nach der 50‑%‑Wahrscheinlichkeit für „menschenähnliche KI“ fragen). Sie zeigen Stimmungsänderungen über die Zeit, spiegeln aber wider, wer befragt wurde und wie Fragen formuliert sind.

Szenarioplanung vermeidet ein Einzeljahr. Stattdessen skizziert sie mehrere plausible Zukünfte (schneller Fortschritt, langsamer Fortschritt, regulatorische Engpässe, Hardware‑Limitierungen) und fragt, welche Signale für welchen Pfad sprechen.

Benchmark‑ und Fähigkeitsbasierte Prognosen verfolgen konkrete Meilensteine (Programmieren, wissenschaftliches Schließen, Agentzuverlässigkeit) und schätzen, welche Verbesserungsraten nötig wären, um breitere Kompetenz zu erreichen.

Definitionen verändern das Datum

„AGI“ kann bedeuten, eine breite Test‑Suite zu bestehen, die meisten Jobs zu übernehmen, als autonomer Agent zu handeln oder Menschen über Domänen mit minimaler Beaufsichtigung zu erreichen. Strengere Definitionen verschieben Zeitachsen meist nach hinten; dieser Meinungsunterschied erklärt einen Großteil der Spannweite.

Das nächste an Konsens: Unsicherheit

Selbst optimistische und skeptische Expert*innen stimmen in einem Punkt oft überein: Zeitachsen sind hochgradig unsicher, und Prognosen sollten als Bereiche mit Annahmen betrachtet werden—nicht als feste Kalendereinträge.

Signale, auf die man in den nächsten 5–10 Jahren achten sollte

Experimentieren, ohne etwas kaputt zu machen

Probiere mutige Änderungen und sichere Fortschritte mit Snapshots und Rollbacks.

Prognosen über AGI können abstrakt wirken; deshalb hilft es, konkrete Signale zu verfolgen, die sich vor einem „großen Moment“ bewegen sollten. Wenn Kurzweils Ansatz grob stimmt, sollte das nächste Jahrzehnt stetige Verbesserungen bei Fähigkeiten, Zuverlässigkeit, Ökonomie und Governance zeigen.

1) Fähigkeitsindikatoren (was Systeme tatsächlich können)

Achten Sie auf Modelle, die zuverlässig über viele Schritte planen, sich anpassen, wenn Pläne scheitern, und Werkzeuge (Code, Browser, Daten‑Apps) ohne ständige Handführung nutzen. Das bedeutendste Zeichen ist kein spektakuläres Demo—sondern Autonomie mit klaren Grenzen: Agenten, die mehrstündige Aufgaben abschließen, klärende Fragen stellen und Arbeit sicher übergeben, wenn Unsicherheit besteht.

2) Zuverlässigkeitsindikatoren (wie oft sie falsch liegen)

Fortschritt äußert sich durch niedrigere Fehlerraten in realistischen Workflows, nicht nur höhere Benchmark‑Scores. Beobachten Sie, ob „Halluzinationen“ abnehmen, wenn Systeme Quellen zitieren, Prüfungen ausführen oder sich selbst verifizieren. Ein Schlüsselmeilenstein: starke Leistung unter Auditbedingungen—gleiche Aufgabe, mehrere Durchläufe, konsistente Resultate.

3) Ökonomische Indikatoren (wo Wert sichtbar wird)

Suchen Sie nach messbaren Produktivitätsgewinnen in konkreten Rollen (Support, Analyse, Software, Betrieb) sowie nach neuen Jobkategorien, die sich um die Beaufsichtigung und Integration von KI bilden. Auch Kosten sind wichtig: wenn hochwertige Outputs pro Aufgabe/Stunde billiger werden, beschleunigt das die Adoption—besonders bei kleinen Teams.

4) Governance‑Indikatoren (wie die Gesellschaft reagiert)

Wenn Fähigkeiten steigen, sollte sich Governance von Prinzipien zu Praxis bewegen: Standards, Dritt‑Audits, Vorfallmeldung und Regulierung, die Haftung klärt. Achten Sie auch auf Regeln zur Compute‑Überwachung und Reporting—Signale, dass Regierungen und Industrie Skalierung als steuerbaren Hebel betrachten.

Wenn Sie diese Signale nutzen wollen, ohne auf Schlagzeilen zu überreagieren, siehe /blog/ai-progress-indicators.

Praktische Schlussfolgerungen: Prognosen nutzen ohne ihnen zu übertrusten

AGI‑Zeitachsen sind am besten wie Wettervorhersagen für ein fernes Datum: nützlich zur Planung, unzuverlässig als Versprechen. Kurzweil‑artige Prognosen helfen, langfristige Trends zu bemerken und Entscheidungen zu hinterfragen, sollten aber nicht der einzige Risikopunkt Ihrer Strategie sein.

Wie man AGI‑Vorhersagen liest (ohne sie als Garantien zu nehmen)

Verwenden Sie Prognosen, um Bereiche und Szenarien zu erforschen, nicht ein einzelnes Jahr. Wenn jemand sagt „AGI bis 203X“, übersetzen Sie das in: „Welche Veränderungen müssten eintreten, damit das wahr ist—und was, wenn nicht?“ Planen Sie für mehrere Ergebnisse.

Fragen, die Sie jeder Prognose stellen sollten

- Definition: Was meinen sie mit „AGI“? Menschenniveau bei Tests, breite Arbeitsplatz‑Nützlichkeit oder „kann alles lernen“? Unterschiedliche Definitionen führen zu unterschiedlichen Zeiträumen.

- Daten: Welche Indikatoren nutzen sie—Rechenleistung, Trainingseffizienz, Benchmarks, Rollout‑Raten—und was wird ignoriert?

- Annahmen: Gehen sie davon aus, dass Algorithmen, Datenverfügbarkeit, Energie, Chips und Governance glatt weiterlaufen?

- Anreize: Verkaufen sie ein Produkt, sammeln sie Kapital oder treiben sie Politik voran? Interessen können Sicherheit und Zeitrahmen beeinflussen.

Praktische Planung: Fähigkeiten, Strategie und Risiko‑Bewusstsein

Für Einzelpersonen: bauen Sie tragfähige Kompetenzen auf (Problembeschreibung, Domänenwissen, Kommunikation) und pflegen Sie die Gewohnheit, neue Tools zu lernen.

Für Unternehmen: investieren Sie in KI‑Literacy, Datenqualität und Pilotprojekte mit klarem ROI—und behalten Sie einen „no regrets“‑Plan, der auch funktioniert, wenn AGI später kommt.

Eine pragmatische Vorgehensweise ist, Build‑Zyklen zu verkürzen: Prototypen für Workflows, Testen der Zuverlässigkeit und Quantifizieren von Produktivitätsgewinnen, bevor große Wetten eingegangen werden. Plattformen wie Koder.ai passen hierzu, indem sie Teams erlauben, Web‑, Backend‑ und Mobile‑Apps per Chat‑Interface zu erstellen (mit Planungsmodus, Snapshots und Rollback), sodass Agent‑unterstützte Prozesse schnell getestet, Quellcode exportiert und Strategien nicht an eine einzige Prognose gebunden werden.

Eine ausgewogene Schlussfolgerung: Zeitachsen können Vorbereitung steuern, aber keine Gewissheit liefern. Nutzen Sie sie, um Experimente zu priorisieren und blinde Flecken zu reduzieren—und überprüfen Sie Ihre Annahmen regelmäßig, wenn neue Evidenz eintrifft.