Was es bedeutet, wenn Daten auf die physische Ökonomie treffen

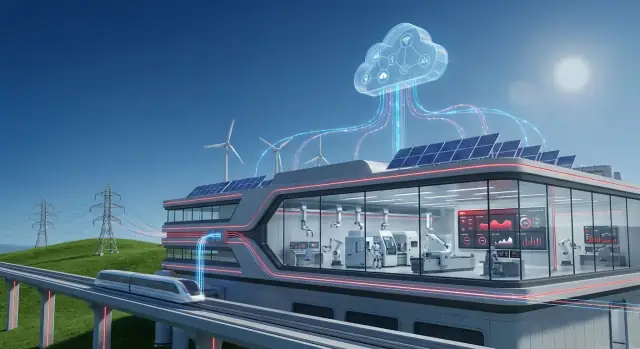

Die „physische Ökonomie“ ist jener Teil der Wirtschaft, der Atome bewegt, nicht nur Informationen. Es ist das Kraftwerk, das Angebot und Nachfrage ausgleicht, das Schienennetz, das Züge pünktlich hält, die Fabrik, die Rohmaterialien in fertige Güter verwandelt, und der Wasserversorger, der Druck und Qualität in einer Stadt sichert.

In diesen Umgebungen misst Software nicht nur Klicks oder Conversions – sie beeinflusst reale Anlagen, reale Menschen und reale Kosten. Eine verspätete Wartungsentscheidung kann zum Ausfall werden. Eine geringe Prozessabweichung kann zu Ausschuss, Stillstand oder einem Sicherheitsvorfall führen.

Deshalb haben Daten hier eine andere Bedeutung: sie müssen zeitgerecht, vertrauenswürdig und an das vor Ort Geschehen gebunden sein.

Warum Daten anders sind, wenn Sie Assets betreiben

Wenn Ihr „Produkt“ Verfügbarkeit, Durchsatz und Zuverlässigkeit ist, wird Datenverwendung praktisch:

- Um zu sehen, was tatsächlich passiert (Vibration, Temperatur, Energieverbrauch, Zykluszeiten)

- Um vorherzusagen, was wahrscheinlich als Nächstes passiert (Frühe Ausfallanzeichen, sich bildende Engpässe)

- Um die beste Maßnahme zu wählen (Techniker schicken, Linie drosseln, Strom umleiten, Teile nachbestellen)

Aber es gibt echte Kompromisse. Sie können eine Fabrik nicht einfach anhalten, um „später zu aktualisieren“. Sensoren sind manchmal verrauscht. Connectivity ist nicht garantiert. Und Entscheidungen müssen oft für Bediener, Ingenieure und Aufsichtsbehörden erklärbar sein.

OT + IT: zwei Welten, die zusammenarbeiten müssen

Hier beginnt die Bedeutung der OT-IT-Konvergenz.

- OT (Operational Technology) ist die Welt der Maschinen: Steuerungssysteme, SPS/PLCs, SCADA, Messtechnik und die Sicherheits- und Zuverlässigkeitspraktiken, die den Betrieb stabil halten.

- IT (Information Technology) ist die Welt der Geschäftssysteme: ERP, Asset-Register, Service-Management, Analytik, Identitäts- und Zugriffsverwaltung sowie Unternehmenssicherheit.

Wenn OT und IT zusammenarbeiten, können operative Signale Geschäfts-Workflows auslösen – etwa das Anlegen eines Arbeitsscheins, Bestandsprüfungen, Einsatzplanung und Ergebnisverfolgung.

Was Sie von diesem Leitfaden erwarten können

Sie erfahren, wo typischerweise Wert entsteht (Verfügbarkeit, Wartung, Energieeffizienz), welche architektonischen Voraussetzungen nötig sind (Edge-to-Cloud-Muster) und worauf Sie achten sollten (Sicherheit, Governance, Change Management). Ziel ist ein klares, realistisches Bild davon, wie industrielle Daten zu besseren Entscheidungen werden – nicht nur zu mehr Dashboards.

Hitachi im Kontext: Industrie-Know-how plus Softwarefähigkeiten

Hitachi steht an einer Schnittstelle, die für moderne Organisationen immer wichtiger wird: Systeme, die physische Abläufe betreiben (Züge, Stromnetze, Fabriken, Wasserwerke) und die Software, die plant, misst und die Leistung dieser Abläufe verbessert.

Diese Herkunft ist wichtig, weil industrielle Umgebungen erfahrungsgemäß bewährte Ingenieurskunst, lange Asset-Lebenszyklen und stetige inkrementelle Verbesserungen belohnen – nicht schnelle Plattformwechsel.

Was „Industrietechnologie" umfasst

Wenn von „Industrietechnologie“ die Rede ist, meint man meist den Stack, der reale Prozesse stabil und sicher hält:

- Ausrüstung und Assets: Motoren, Antriebe, Waggons, Transformatoren, Pumpen, Turbinen und andere langlebige Maschinen.

- Steuerung und Automation: Sensoren, SPS/PLCs-ähnliche Steuerung, Sicherheitssysteme und die Instrumentierung, die Bedienern zeigt, was passiert.

- Engineering- und Betriebspraktiken: Wartungsroutinen, Zuverlässigkeitsmethoden, Inbetriebnahme und die Standards, die Verfügbarkeit und Sicherheit regeln.

Dieser Bereich dreht sich um Physik, Beschränkungen und Betriebsbedingungen – Hitze, Vibration, Last, Verschleiß und die Realitäten der Feldarbeit.

Was „Unternehmenssoftware" umfasst

„Unternehmenssoftware" sind die Systeme, die Betrieb in koordinierte Entscheidungen und prüfbare Aktionen über Teams hinweg verwandeln:

- Planung und Finanzen (ERP): Budgets, Einkauf, Bestand und Kostentransparenz.

- Asset- und Wartungsmanagement (EAM/CMMS): Arbeitsscheine, Ersatzteile, Inspektionen und Lebenszyklushistorie.

- Analytik und Reporting: Dashboards, KPIs und Trendanalysen.

- Workflows und Zusammenarbeit: Genehmigungen, Vorfallverfolgung und abteilungsübergreifende Koordination.

Die Geschichte von Hitachi ist relevant, weil sie einen breiteren Wandel widerspiegelt: Industrieunternehmen wollen operative Daten in Geschäfts-Workflows fließen sehen, ohne Kontext oder Kontrolle zu verlieren. Ziel ist nicht „mehr Daten“ um der Daten willen, sondern engere Abstimmung zwischen dem, was vor Ort geschieht, und der Art, wie die Organisation ihre Assets plant, wartet und verbessert.

Von Maschinen zu Erkenntnissen: die Reise der operativen Daten

Industriestandorte sind voll mit Signalen, die beschreiben, was gerade passiert: Temperaturen, die sich verändern, steigende Vibration, schwankende Netzqualität, verlangsamter Durchsatz, Alarme, die aufpoppen. Fabriken, Schienennetze, Bergwerke und Versorger erzeugen diese Signale kontinuierlich, weil physische Anlagen überwacht werden müssen, um sicher, effizient und konform zu bleiben.

Die Herausforderung ist nicht mehr Daten zu erhalten, sondern rohe Messwerte in Entscheidungen zu verwandeln, denen Menschen vertrauen.

Woher die Daten tatsächlich kommen

Die meisten Betriebe ziehen aus einer Mischung von Echtzeit-Steuerungssystemen und Geschäftsdaten:

- Sensoren und Zähler an Pumpen, Turbinen, Motoren, Leitungen und Umspannwerken (Druck, Durchfluss, Strom, Vibration usw.)

- SPS/PLC- und SCADA-Systeme, die Prozesse steuern und beaufsichtigen, oft mit Daten in einem Historian

- Wartungsprotokolle und Arbeitsscheine aus EAM/CMMS-Tools (was ausgefallen ist, was ersetzt wurde, wie lange es dauerte)

- ERP-Daten wie Produktionsaufträge, Bestand, Beschaffung und Kostenstellen – nützlich, um Leistung mit Geld zu verknüpfen

Jede Quelle für sich erzählt nur einen Teil der Geschichte. Zusammengenommen können sie erklären, warum sich Leistung ändert und was als Nächstes zu tun ist.

Was auf dem Weg zur „Erkenntnis“ schiefgeht

Operative Daten sind aus vorhersehbaren Gründen unordentlich. Sensoren werden ersetzt, Tags umbenannt und Netzwerke verlieren Pakete. Häufige Probleme sind:

- Fehlende oder duplizierte Werte (Lücken während Ausfällen, wiederholte Samples nach Wiederverbindung)

- Inkonsistente Tags und Einheiten ("Temp_1" vs "TMP-01", °C vs °F, kW vs MW)

- Zeit-Synchronisationsprobleme zwischen Geräten und Systemen (eine fünfminütige Uhrdrift kann Ursache-Wirkung-Analysen zunichtemachen)

Wenn Sie sich jemals gefragt haben, warum Dashboards widersprüchlich sind: oft stimmen Zeitstempel, Benennung oder Einheiten nicht überein.

Warum Kontext mehr zählt als Volumen

Eine Messung wird nur dann sinnvoll, wenn Sie beantworten können: Welchem Asset gehört das, wo befindet es sich und in welchem Zustand war es?

„Vibration = 8 mm/s“ ist viel handlungsfähiger, wenn es mit Pumpe P-204, in Leitung 3, bei 80% Last, nach einem Lagersatzwechsel letzten Monat, während eines bestimmten Produktlaufs verknüpft ist.

Dieser Kontext – Asset-Hierarchie, Standort, Betriebsmodus und Wartungshistorie – erlaubt es der Analytik, normale Schwankungen von frühen Warnzeichen zu trennen.

Die Reise der operativen Daten ist im Kern ein Übergang von Signalen → saubere Zeitreihen → kontextualisierte Ereignisse → Entscheidungen, damit Teams vom Reagieren auf Alarme zum gezielten Leistungsmanagement übergehen können.

OT–IT-Konvergenz: zwei Welten verbinden, ohne eine zu zerstören

Operational Technology (OT) ist das, was den physischen Betrieb antreibt: Maschinen, Sensoren, Steuerungssysteme und Prozeduren, die eine Anlage, ein Schienennetz oder eine Umspannstation sicher funktionieren lassen.

Information Technology (IT) ist das, was das Geschäft steuert: ERP, Finanzen, HR, Beschaffung, Kundensysteme sowie Netzwerke und Apps, die Mitarbeiter täglich nutzen.

OT–IT-Konvergenz heißt schlicht, diese beiden Welten dazu zu bringen, zur richtigen Zeit die richtigen Daten zu teilen – ohne Produktion, Sicherheit oder Compliance zu gefährden.

Wo Reibung typischerweise auftritt

Die meisten Probleme sind zuerst nicht technisch, sondern organisatorisch.

- Verantwortung und Anreize: OT-Teams werden an Verfügbarkeit und Sicherheit gemessen. IT-Teams an Standardisierung, Kostenkontrolle und Cybersecurity.

- Änderungssteuerung: In OT kann ein „kleines Update“ eine Linie stilllegen. In IT sind häufige Patches normal.

- Verfügbarkeitsanforderungen: OT-Systeme laufen oft jahrelang mit minimalen Ausfallzeiten; Wartungsfenster sind selten und eng geplant.

- Unterschiedliche Sprachen: OT spricht in Alarmen, SPS und Sollwerten; IT spricht in Tickets, APIs und Identitätsverwaltung.

Was Integration praktisch braucht

Für praktische Konvergenz benötigen Sie typischerweise einige Bausteine:

- Connectoren und Protokolle, die OT-Signale sicher lesen können (oft via Gateways) und in IT-freundliche Formate abbilden.

- APIs, um Daten in Unternehmensanwendungen (Wartung, Bestand, Finanzen) zu bewegen und zurück.

- Ereignisströme für „etwas ist gerade passiert“-Momente – z. B. ein Schwingungsspitze, die einen Arbeitsschein auslöst.

- Master-Data-Angleichung, damit alle dieselbe Definition von „Asset“, „Standort“ oder „Arbeitsschein“ über Systeme hinweg nutzen.

Ein sicherer Weg: klein anfangen, Wert nachweisen, dann skalieren

Ein praktischer Ansatz ist, einen hochprioritären Use Case zu wählen (z. B. vorausschauende Wartung an einem kritischen Asset), einen begrenzten Datensatz anzubinden und klare Erfolgskriterien zu vereinbaren.

Ist der Workflow stabil – Datenqualität, Alerts, Genehmigungen und Sicherheit – erweitern Sie auf mehr Assets und dann auf weitere Standorte. So bleibt OT mit Zuverlässigkeit und Änderungssteuerung komfortabel, während IT die Standards und Sichtbarkeit bekommt, die für Skalierung nötig sind.

Edge-to-Cloud-Architektur in einfachen Worten

Industrielle Systeme erzeugen wertvolle Signale – Temperaturen, Vibration, Energieverbrauch, Durchsatz – aber nicht alles gehört an denselben Ort. „Edge-to-Cloud“ bedeutet, die Arbeit zwischen Rechnern nahe der Ausrüstung (Edge) und zentralen Plattformen (Cloud oder Rechenzentrum) zu verteilen, je nach Bedarf des Betriebs.

Warum manche Verarbeitung nahe der Anlage bleibt

Bestimmte Entscheidungen müssen in Millisekunden oder Sekunden getroffen werden. Wenn ein Motor überhitzt oder eine Sicherheitsverriegelung anspricht, kann man nicht auf eine Runde zu einem fernen Server warten.

Edge-Verarbeitung hilft bei:

- Niedriger Latenz für Kontrolle und Alerts: schnelle Reaktionen auf Alarme, Qualitätsprüfungen und lokale Optimierung.

- Zuverlässigkeit bei Netzwerkproblemen: die Anlage läuft weiter, auch wenn die Konnektivität abbricht.

- Bandbreiteneinsparung: hochfrequente Sensordaten filtern und komprimieren, bevor Zusammenfassungen nach oben gesendet werden.

Zentrale Plattformen sind dann sinnvoll, wenn der Nutzen aus der Kombination von Daten über Linien, Werke oder Regionen entsteht.

Typische Cloud-Seiten-Aufgaben:

- Analysen über Standorte hinweg: Leistung zwischen Anlagen vergleichen, Best Practices identifizieren.

- Flottenmodelle: vorausschauende Modelle verbessern, indem sie von vielen ähnlichen Assets lernen.

- Berichterstattung und Compliance: standardisierte Dashboards für Führungskräfte, Prüfer und Nachhaltigkeitsteams.

Ein einfacher Referenzfluss (sammeln → bereinigen → analysieren → handeln)

- Sammeln: Sensoren/PLCs/SCADA senden Daten an ein Edge-Gateway.

- Bereinigen: Am Edge werden Einheiten, Zeitstempel und Tags normalisiert; offensichtliches Rauschen kann entfernt werden.

- Analysieren: Schnellregeln oder Modelle laufen lokal; aufwendigere Analysen laufen zentral, wo mehr Rechenkapazität und Historie vorhanden sind.

- Handeln: Aktionen kommen als Alerts, Arbeitsscheine oder Sollwertempfehlungen zurück – oft integriert in Wartungs- und Enterprise-Tools (zum Beispiel via /blog/ot-it-convergence).

Governance-Grundlagen: wer welche Daten und warum sehen darf

Architektur ist auch Vertrauen. Gute Governance definiert:

- Rollen und Berechtigungen: Bediener sehen Live-Prozessdaten; Zuverlässigkeitsingenieure sehen Asset-Gesundheit; Führungskräfte sehen KPIs.

- Datenverantwortung: Wer genehmigt das Teilen von Daten zwischen Standorten oder mit Dienstleistern.

- Auditierbarkeit: Protokolle, wer Daten abgerufen oder was verändert hat.

Wenn Edge und Cloud zusammen entworfen werden, erhalten Sie Geschwindigkeit auf der Werksebene und Konsistenz auf der Unternehmensebene – ohne jede Entscheidung an einen Ort zu zwingen.

Industrielle Software erzeugt den sichtbarsten geschäftlichen Wert, wenn sie das Verhalten von Assets mit der Art, wie die Organisation reagiert, verbindet. Es geht nicht nur darum zu wissen, dass eine Pumpe verschleißt – es geht darum sicherzustellen, dass die richtige Arbeit geplant, genehmigt, ausgeführt und dokumentiert wird.

APM vs. EAM (und warum beides wichtig ist)

Asset Performance Management (APM) fokussiert auf Zuverlässigkeit: Zustandsüberwachung, Anomalieerkennung, Risikoabschätzung und Handlungsempfehlungen, die Ausfälle reduzieren.

Enterprise Asset Management (EAM) ist das Register und die Ausführungsplattform für Wartung: Asset-Hierarchien, Arbeitsscheine, Personal, Genehmigungen, Ersatzteile und Compliance-Historie.

Zusammen kann APM die richtigen Eingriffe priorisieren, während EAM sicherstellt, dass diese Eingriffe mit den nötigen Kontrollen ausgeführt werden – zur Unterstützung von Zuverlässigkeit und Kostendisziplin.

Vorausschauende Wartung, die in der Bilanz sichtbar wird

Vorausschauende Wartung wird bedeutsam, wenn sie messbare Ergebnisse liefert wie:

- Weniger ungeplante Ausfälle (weniger Linienstopps, weniger Notrufe)

- Niedrigere Ersatzteilkosten (weniger Sicherheitsbestände, weniger Eilbestellungen)

- Sichererer Betrieb (frühere Erkennung reduziert katastrophale Ausfälle und risikobehaftete Reaktivarbeit)

- Bessere Anlagenutzung (Wartung nach Zustand statt nach Schätzwert)

Was Sie für den Erfolg brauchen

Erfolgreiche Programme beginnen oft mit Grundlagen:

- Eine klare Liste von Ausfallarten für kritische Assets (was bricht und wie)

- Baseline-Daten zur Leistung und Wartungshistorie (damit Verbesserungen nachweisbar sind)

- Definierte Arbeitsprozesse, die Alerts mit Aktionen verbinden (Triage, Genehmigung, Planung, Abschluss)

- Zuständigkeiten: Wer bewertet Insights, wer entscheidet und wer führt aus

Die „Nur-AI“-Falle vermeiden

Analytik ohne Umsetzung wird zu einem Dashboard, dem niemand vertraut. Wenn ein Modell Lagerungsschäden anzeigt, aber niemand einen Arbeitsschein erstellt, Teile reserviert oder Erkenntnisse nach der Reparatur erfasst, kann das System nicht lernen – und das Geschäft spürt keinen Nutzen.